SparkUI是spark展示任务运行状况、资源状态和监控指标的前端,可以根据SparkUI的展示来了解在运行时Spark任务执行情况,也可以帮助学习Spark,本文档基于spark3.0.0

SparkUI启动不用单独安装,执行Spark期间,可以直接使用浏览器访问:localhost:4040即可,localhost也可以是服务器IP地址

job页

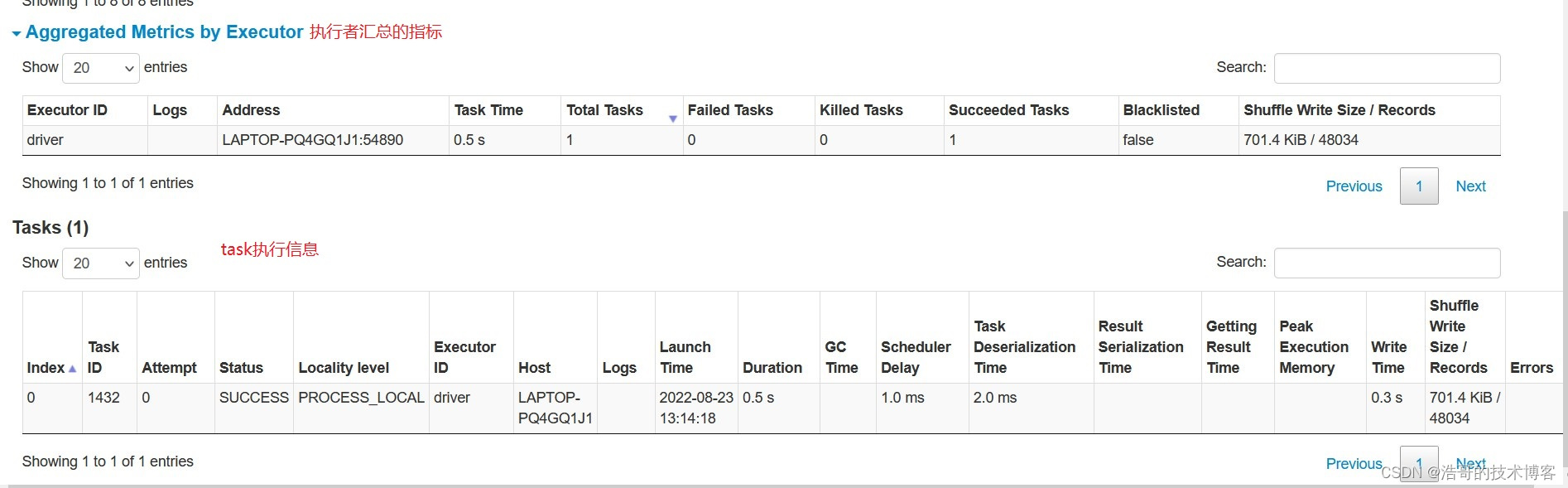

1:job级别的任务执行记录,可看到具体的executor和task执行时间

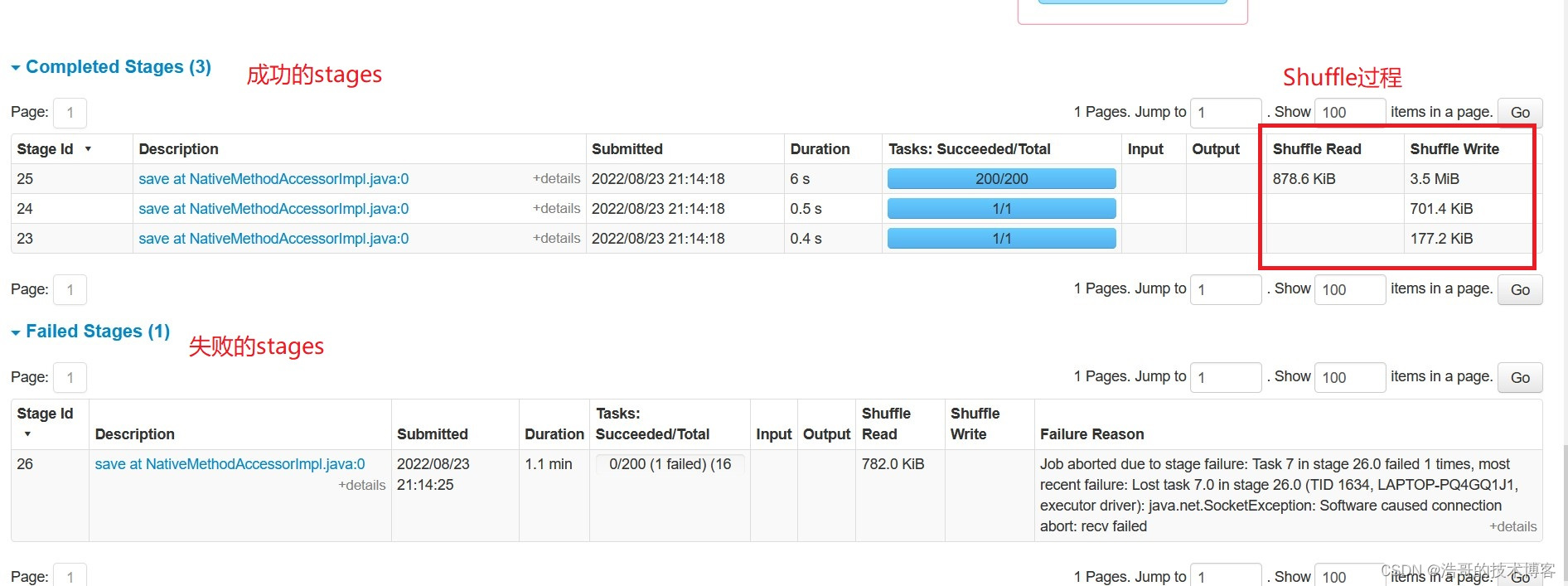

2:所有stage,stage是按照宽依赖来区分的,因此粒度上要比job更细一些

3 :storage页面,我们所做的cache persist等操作,都会在这里看到,可以看出来应用目前使用了多少缓存

4: 代表environment页面,里面展示了当前spark所依赖的环境,比如jdk,lib等等

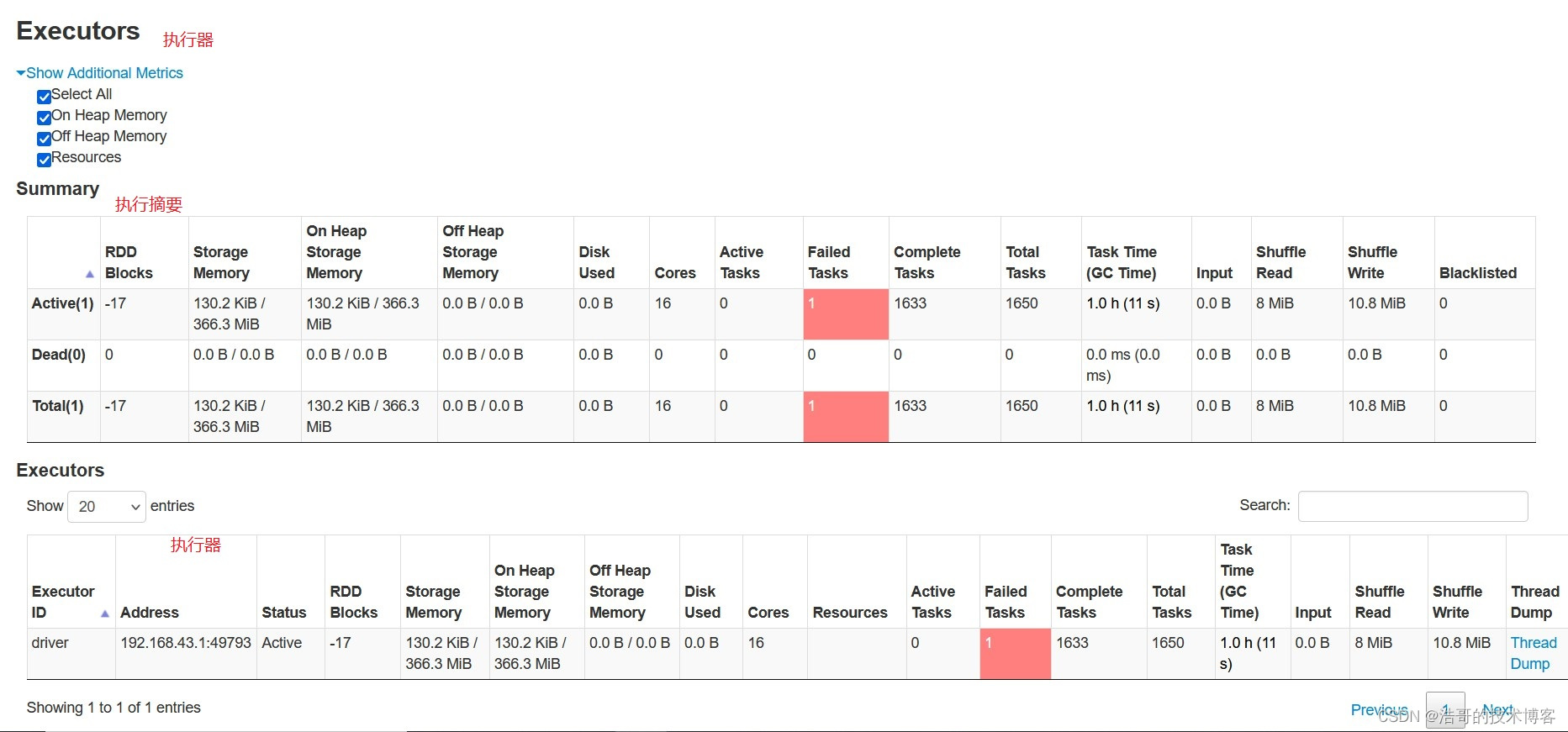

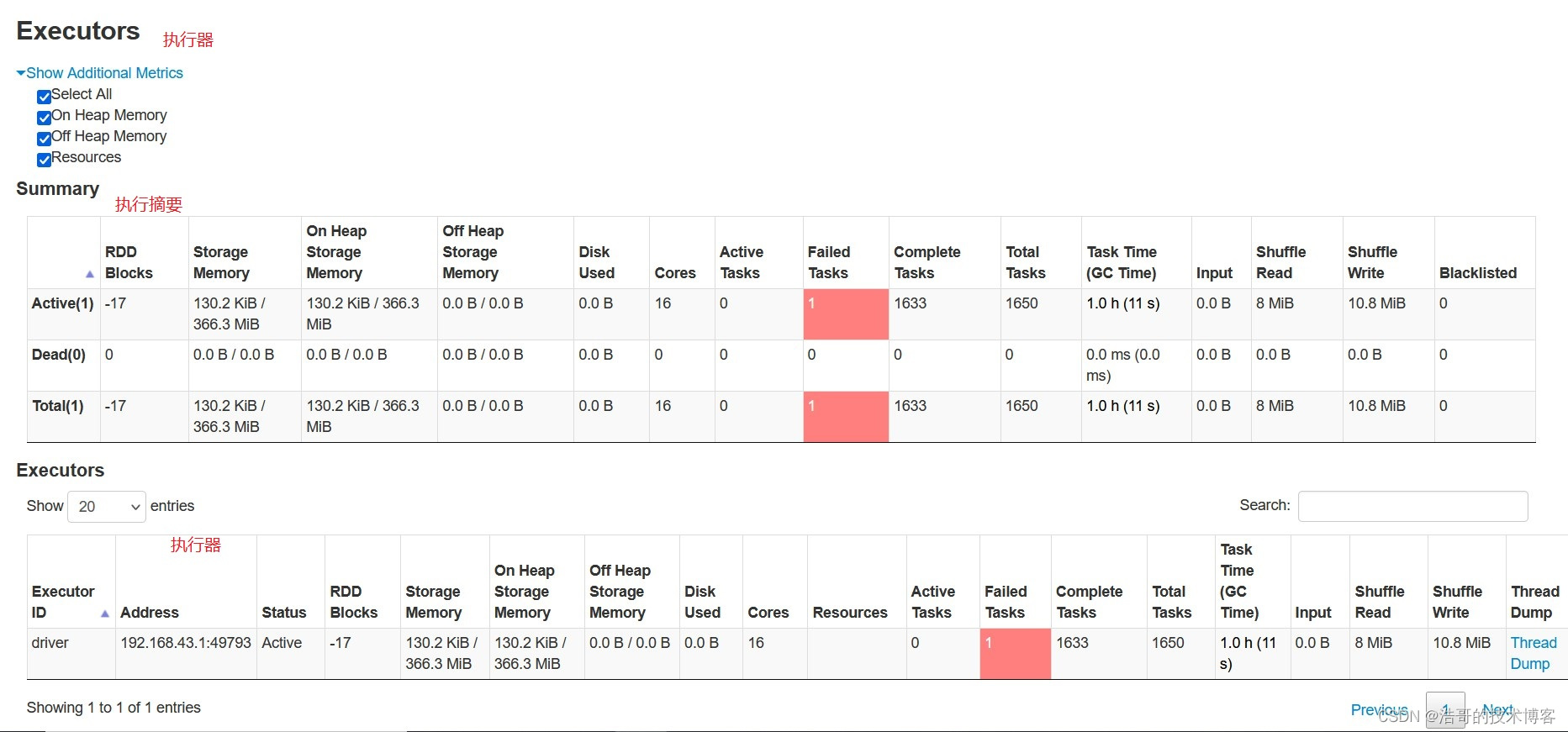

5 :代表executors页面,这里可以看到执行者申请使用的内存以及shuffle中input和output等数据

6 : 代表Spark SQL的页面,可以在这里看到执行的查询

job详情页

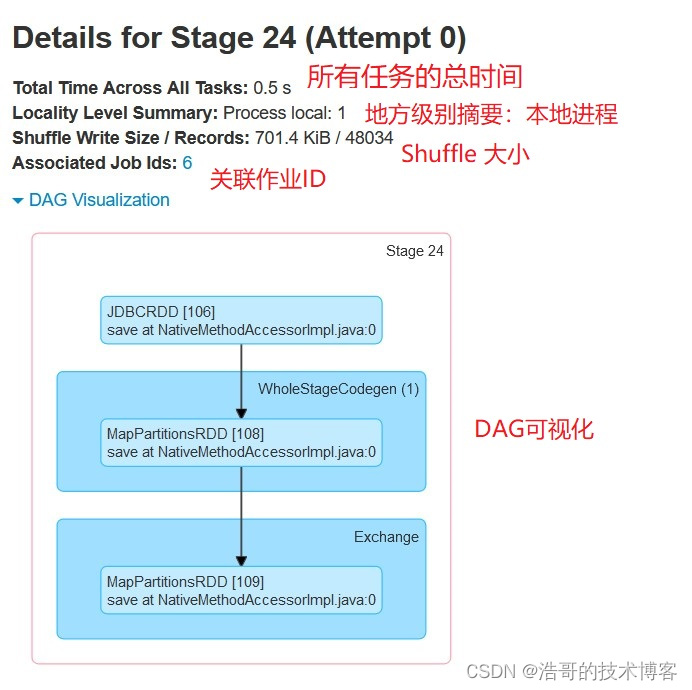

点击一个job后,会进入对应job的详情页面,包含事件执行时间线,DAG图,执行的Stages,和失败的Stages(关键词如果不明白的可以对照另外一个文档看:20天学习Spark(0)之最简单版Spark入门)

前面展示的和job页差不多,这里主要展示DAG图

stage页面

点击其中一个任务后,可以进入stage详情信息

这里是所有job相关页面,在菜单栏上点击stages可以来到stage列表页面,没有什么内容,这里就不写了

storage页面存储缓存相关内容,这里没有展示‘

Executors页面

点击Executors可以看到关于Executor可视化界面

关于Executor可视化界面