原创 | 文 BFT机器人

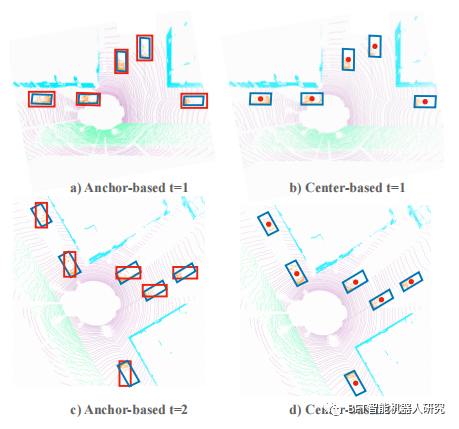

CenterPoint与传统基于框的3D物体检测器和跟踪器不同之处在于,它将3D物体表示、检测和跟踪为点,而不是使用边界框。这种方法具有几个优点,包括减少物体检测器的搜索空间,简化下游任务(如跟踪),并使设计比以前的方法快得多的有效的两阶段细化模块成为可能。此外,CenterPoint允许骨干网络学习物体的旋转不变性和它们相对旋转的旋转等变性。检测是一种简单的经过细化的局部峰提取,跟踪是一种最近距离匹配。

基于中心的框架的检测和跟踪对象

本文主要描述了一种名为CenterPoint的新框架,该框架将3D物体表示、检测和跟踪为点,而不是使用边界框。该方法简化了检测和跟踪过程并在基准数据集上实现了最先进的性能。本文的作者还介绍了一种新的中心点检测头,但依赖于现有的3D骨干网络(如VoxelNet或PointPillars)。

我们的方法克服了传统基于框的检测器的挑战,并简化了3D对象跟踪。在前期准备工作中,我们首先回顾了当前3D对象检测和跟踪领域的最新方法,包括基于框、基于锚点和基于点的方法。我们还讨论了这个领域中使用的流行数据集和评估指标。然后,我们介绍了我们的方法的主要思想和贡献,并详细描述了我们的CenterPoint框架的设计和实现。最后,我们在几个基准数据集上进行了实验,并展示了我们的方法的优越性能。

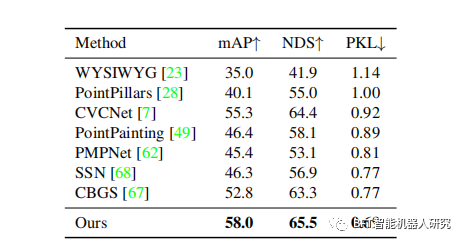

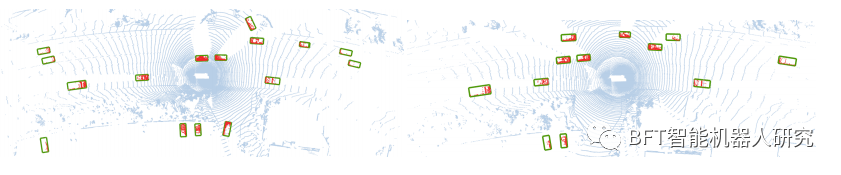

CenterPoint首先使用关键点检测器检测对象的中心,并回归到其他属性,包括3D大小、3D方向和速度。在第二阶段,它使用对象上的附加点特征来细化这些估计值。由此产生的检测和跟踪算法简单、高效、有效。CenterPoint在nuScenes基准测试中取得了最先进的3D检测和跟踪性能,单模型的NDS为65.5,AMOTA为63.8。在Waymo开放数据集上,CenterPoint的性能大大优于所有先前的单模型方法,并在所有仅使用激光雷达的方法中排名前列。

对中心点框架的概述

文中描述到使用一个标准的基于激光雷达的骨干网络如VoxelNet或PointPillars来构建输入点云的表示。然后,它将这个表示展平成一个俯视图,并使用一个标准的基于图像的关键点检测器来找到物体的中心。对于每个检测到的中心,它从中心位置的点特征回归到所有其他物体属性,例如3D大小、方向和速度。此外,我们使用一个轻量级的第二阶段来优化物体位置。这个第二阶段在估计的物体3D边界框的每个面的3D中心提取点特征。它恢复了由于步幅和有限的感受视野而丢失的局部几何信息,并带来了较小的成本和相当大的性能提升。

01

实验结果

本文首先在Waymo和nuScenes的测试集上展示了我们的三维检测结果。这两个结果都使用了一个单一的中心点-体素模型。在Waymo测试集上,我们的模型对车辆检测达到71.8级2级mAPH,对行人检测达到66.4级2级mAPH,超过了之前的方法达到7.1%的车辆mAPH,行人达到10.6%的mAPH。在nuScenes上,我们的模型在多尺度输入和多模型集成方面比去年的挑战赢家CBGS要好5.2%的mAP和2.2%的NDS。

文中我们的模型在神经平面度量(PKL)下显著优于所有其他提交,这是组织者在提交排行榜后评估的隐藏度量。这突出了我们的框架的泛化能力。

对于3D跟踪来说,中心点在Waymo测试集上的跟踪性能,我们的跟踪不需要一个单独的运动模型,并且运行的时间可以忽略不计,在检测之上为1ms。

在我们文中的两阶段中心点模型中,只使用了二维CNN特征图中的特征。但是以往的方法也提出利用体素特征进行第二阶段的细化。

中心点对Waymo验证的定性结果

02

结论

本文提出了一个基于中心的框架,同时用于三维目标检测和跟踪激光雷达点云。主要是使用一个标准的3D点云编码器,在头部有几个卷积层,以产生一个鸟视图热图和其他密集的回归输出。中心点简单、接近实时性,并在Waymo和nuScenes基准上进行了多次测试实现了最先进的性能。

作者 | 张哲宇

排版 | 小河

审核 | 橙橙

若您对该文章内容有任何疑问,请与我们联系,我们将及时回应。如果想要了解更多的前沿资讯,记得点赞关注哦~