随着秋招走向尾声,这边总结一下当时记录的部分企业的面试过程吧。

我学习期间的研究方向是深度强化学习,所以项目经历都与强化学习相关,面试官问项目时也会往这方向考察。

鉴智机器人

面试岗位:决策规划岗位

笔试

笔试出的是力扣原题。2道中等难度+1道困难题。

一面

- DDPG,TD3算法流程,区别

- 路径规划算法了解的讲一下

- 强化学习落地难,你的看法

- 控制就业方向窄,建议转决策

二面

- A星算法介绍以及实际应用的优缺点,如何解决。在搜索的时候有什么技巧?

- SAC的梯度传递方式

- 参数正则化trick

- 强化学习落地难的看法

- 模仿学习了解

- 控制障碍函数的使用与势场法有什么区别

- 混合A星

- Lattice规划

总结

当时鉴智机器人是最早面试的几个公司之一,所以体验并非很好,不出意外在二面阶段就挂了。

暴露出的问题:对基础掌握不扎实,底层不够了解,优缺点也不够了解。

亿嘉和

岗位:机器人规划控制岗位

一面

- MPC和LQR比较

- 优化算法

- C++容器

- ROS基础

- ROS话题并行串行

- Node间的通信有哪几种

- 感知定位

- 了解什么自动驾驶开源方案

- 强化学习落地很难,目前只有在四足机器人上的效果比得上传统控制,那你觉得强化学习有什么优势?

总结

亿嘉和的面试非常简单,无笔试环节,仅一面就hr面了。面试官问的重点偏向编写语言知识方面,没有询问项目。

科大讯飞

岗位:自然语言处理——智能语音方向

笔试

科大讯飞的笔试还是不简单的,选择题+3道编程题。

编程题出了一道实现K-means算法的题。

一面

- 问项目

- 问强化学习知识点

- 各种常用的强化学习算法的原理

- 机器学习过拟合、欠拟合知识点

二面

- 主要问项目

总结

科大讯飞原本报的岗位是决策规划岗位,后来被转到了智能语言方向进行面试。科大讯飞的面试相对来说还是非常简单的,单纯的询问项目和一些知识点问答。不过二面时面试官问我期望薪资多少,我当时并不知道他们能开的是多少,所以随意说了一个较高的数字,然后就没下文了。。

地平线

一面

2022.8.19

-

问项目

-

做一道数学题:给一个多项式式子,化成二次型表示

f ( x 1 , x 2 , x 3 ) = ( x 1 − 1 ) 2 + ( x 2 − 2 ) 2 + ( x 3 − 3 ) 2 + ( x 1 − x 2 ) 2 + ( x 2 − x 3 ) 2 x 1 , x 2 , x 3 ∈ R f\left(x_1, x_2, x_3\right)=\left(x_1-1\right)^2+\left(x_2-2\right)^2+\left(x_3-3\right)^2+\left(x_1-x_2\right)^2+\left(x_2-x_3\right)^2\\ x_1, x_2, x_3 \in \mathbf{R} f(x1,x2,x3)=(x1−1)2+(x2−2)2+(x3−3)2+(x1−x2)2+(x2−x3)2x1,x2,x3∈R- 将该函数写成矩阵和向量的二次型形式。

- 该函数取最小值的充分必要条件是?

-

coding环节:已知一条线段两端点坐标A,B以及一点C,求点C到线段AB的投影点坐标。

-

意向地

-

职业规划

二面

2022.8.26

总结

地平线是比较可惜的,二面一开始先做题目,由于我当时没写出来,所以面试官直接通知很遗憾了。。

蔚来

岗位:自动驾驶规划控制岗位

笔试

笔试比较简单,选择题+3道编程题,编程题是力扣题目。

一面

问答

- 介绍自己。

- 介绍强化学习怎么用的。

- 强化学习用作参数拟合做过吗?

- 说一些自动驾驶的强化学习的应用

- 强化学习与经典方法的优劣

- PID算法阐述

- 积分饱和现象怎么解决

- LQR原理

- PID与LQR的区别

- MPC原理

- MPC与LQR区别

- QP的原理

- 模型的参数辨识有了解过吗

- 汽车动力学模型知识点–车轮的侧偏力

- MPC或LQR在动力学模型上应用有熟悉吗?

- 无人机项目相关

- 强化学习与经典方法哪种方式比较好

- 目前为什么使用MPC在汽车上的比较少?

- 最优控制与强化学习的联系与区别

手撕代码题

- C++实现PID类,需要包含积分饱和的处理。

二面

主要问我的项目。

- 无人车项目经历

- 修正的过程?

- 二次规划目标函数?

- 与传统控制方法的对比有吗?

- 结果对比

- 飞机失控研究项目

- 效果怎么样

- 输入输出?

- 神经网络输入输出

- Q函数是拟合出来的吗

- MBRL

- MPC怎么使用的

- 为什么要使用RL?这样建模很多是无法保证的

- 做飞行器和汽车而言,主要差别在哪里?如果要进入这个行业,要从哪几个方面补课呢?

- 每年新兴的算法都很多,工业界用的算法都很保守,你觉得原因是什么?

- 自动驾驶决策难点在哪里?

- 无人机决策难点在哪里?控制频率和通信频率

总结

蔚来也是面的较早的一批,大概8月份左右,当时做的准备不够充足,二面半小时就结束了。非常可惜。。。

文远

岗位:自动驾驶决策规划岗位

一面

2022.9.13

项目

- 安全强化学习运动规划

- 使用普通规划方法与CBF结合不行吗

- 如果在无干扰和延时的情况下是可以的,但是面对工况比较复杂时,RL的优势就体现出来了。

- 使用普通规划方法与CBF结合不行吗

- 融合物理对称性的MBRL

- 对称性含义

coding

- 求平方根

- 牛顿法的复杂度

- 求矩阵的最长递增路径长度

- dfs

- dp搜索方向

总结

文远的一面手撕代码只写出来一道,第二道题没写出来,所以没了。。所以题还是得多练,一般手撕题都是力扣原题或者类似的题。

滴滴

岗位:自动驾驶决策规划岗位

提前批无笔试。

滴滴提前批一面(40分钟)

20220826

-

自我介绍

-

项目:飞机失控和安全强化学习

- reward怎么设计的

- 稳定性哟普理论证明嘛

- 对比传统方法优点

-

项目:安全强化学习

- 怎么保证安全的

- CBF硬约束还是软约束?

- CBF如何加入到RL训练中的

- 怎么通过二次规划

- 约束怎么给,怎么保证是凸约束

- 求解失败怎么办,如何提高算法求解成功率

- 怎么调整安全阈值的

-

手撕代码:找到 K 个最接近的元素

滴滴提前批二面(40分钟)

20220826

- 面试官介绍

- 行为规划

- 逻辑回归

- rule-based 使用率:70-80%

- 优化 使用率:10-20%

- 数据驱动:10-20%

- 控制、规划、交互决策

- 项目:安全强化学习

- 控制障碍函数形式

- 如何结合

- 控制障碍函数的输入

- 二次规划目标函数和约束是什么

- collision cone

- vector

- vector底层

- push_back实现原理

- 原生数组有什么缺点

- size()和capacity()区别

- public,protected,private

- 手撕:实现push_back函数

滴滴提前批三面(50分钟)

20220901

- 问项目(30多分钟)

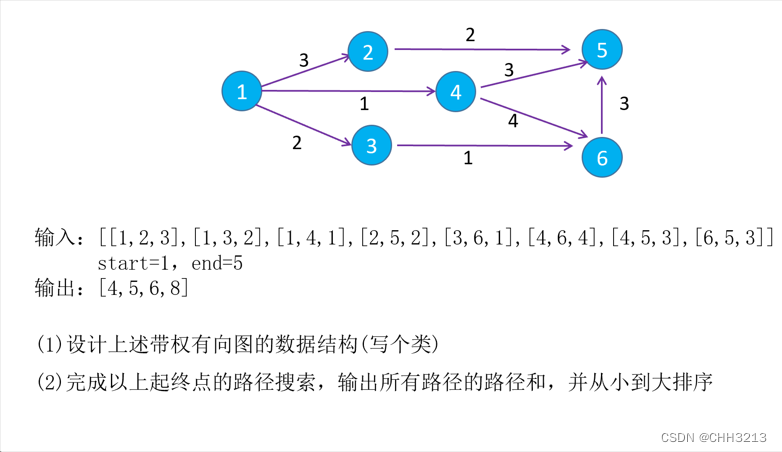

- 做题:给了一道寻找起点到终点的所有路径的编程题

滴滴提前批四面(30分钟)

20220909

- 单纯问项目

总结

滴滴大概是我最遗憾的,一路走到了四面,应该是sp了,前面三面面试都挺顺利,可惜最后一面答得不是很好,然后就泡池子无下文了。

以上是当时有记录的一些企业,另外还有面的其它企业当时忘记记录了,现在也已经想不起来当时面试内容是什么。这次秋招总体来看对于我而言是失败的秋招,想去的企业都没有通过,最后接了点击就送的BYD,目前来看算是躺平了,相比其他人来说薪资水平已经远远不在一个起跑线上,只希望自己在入职之后能够生活得很好吧。

最后,附上我当时投递的公司列表: