一、个性化联邦-迁移学习

全局模型个性化:

特征空间:图片或图片本身提取到的特征,即图片的像素特征或用深度网络提取的图片特征,如GoogleNet提取为1024维;

语义空间:更利于人类理解的样本描述,如是否有水,是否是黑色,是否是白色;

标签空间:是否为斑马。

特征空间:最为直观,可以是像素级的,也可以是多个像素的组合,利于计算机的直接表达;

语义空间:是对特征空间的进一步抽象,有利于人类的认知;

标签空间:最为抽象,更接近人类的理解

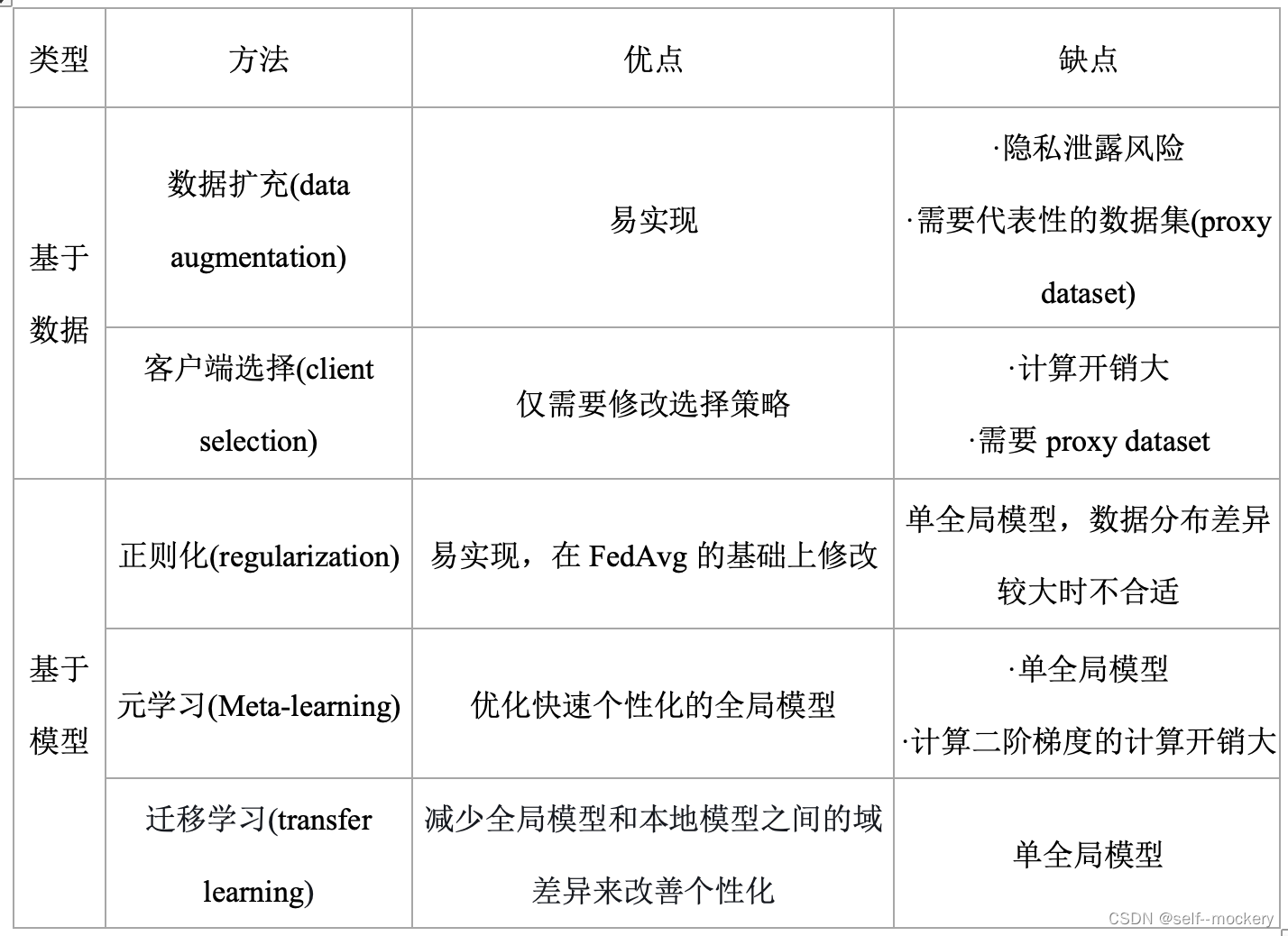

一、正则化:

MOON--旨在减小局部模型学习到的表示Z与全局模型学习到的表示Zglob之间的距离,增大局部模型学习到的表示Z与之前局部模型学习到的表示Zprev之间的距离

二、迁移学习:

1、FedSteg+FedHealth:卷积层和最大池化层旨在学习图像的一般特征,因此在训练过程中不更新参数。然而,全连接层侧重于学习任务和用户特定的特征,因此我们更新这个参数。

2、FedMD:每一方训练fk(私有模型)在公共数据集D0上收敛,然后在其私有数据集Dk上收敛;先在公共数据集上训练直至收敛,其次每个参与者在自己的小型私有数据集上训练直至收敛。

3、迁移学习两种实现方法:

-微调网络:更改最后一层全连接,然后微调网络 训练全部的网络参数

-前边的层看成特征提取器,冻结全部层,只训练最后一层,快

4、训练时候所用的模型可选择合适的(可改动)

5、域适应下的迁移学习

旨在为含有标记的源域数据与不含标记的目标域数据学习得到良好的分类模型,解决具有不同数据分布的域间知识迁移问题

-对抗域适应:GAN中 的真实样本与随机噪声对应于迁移学习中的源域以及目标域,而生成器与判别器则分 别对应于迁移学习中的特征提取器以及各种分布度量函数。

-注意力机制:特征分布对齐,有益于任务完成的 单位可以分配得到较多的资源,相反,不益于任务完成的单位分配较少资源,将该思 想应用于图像分类领域,注意力机制旨在对分类有益的图像特征分配较大的权重,同 时减小其余图像特征的权重。

6、基于标注的迁移学习分类:推导迁移学习,转导迁移学习、无监督迁移学习

①推导迁移学习:在源任务不等于目标任务时,推导迁移学习使用源域和源任务中的知识提升或优化目标域中目标预测函数的学习效果

②转导迁移学习:在源任务=目标任务且源域不等于目标域时,转导迁移学习使用源域和源任务中的知识 提升或优化 目标领域中目标预测函数的学习效果。

-源域和目标域特征空间不同,对应 域适应domain adaption

-特征空间相同,但边缘概率不同,对应 协变量偏移covariate shift

③无监督迁移学习 在源任务=目标任务且标签空间ys和yt不可观测时,无监督迁移学习使用源领域和源任务中的知识提升或优化目标领域中目标预测函数的学习效果。

特征对齐是迁移学习中的一个关键步骤,它旨在使得源域和目标域在共享特征空间中的特征表示更加一致,从而有利于将源域上学到的知识迁移到目标域中。特征对齐可以通过以下几种方法来实现:

-

领域自适应方法: 领域自适应方法是一种常见的特征对齐技术。它通过对目标域数据进行调整,使其特征分布更接近于源域的特征分布。这可以通过在目标域上进行域自适应训练来实现,例如在深度学习中,使用对抗训练或领域分类器来实现特征对齐。

-

分布匹配方法: 分布匹配方法旨在通过找到源域和目标域数据之间的最佳映射,将其特征分布进行匹配。这可以通过最小化源域和目标域之间的差异来实现,例如使用最大均值差异(Maximum Mean Discrepancy,MMD)或核匹配方法。

-

自适应权重调整: 在迁移学习中,自适应权重调整是一种有效的特征对齐方法。它通过在源域和目标域样本之间引入动态权重,调整它们的贡献,从而实现特征对齐。这可以通过自适应学习方法来实现,例如自适应权重迁移学习(Adaptive Weights Transfer Learning)。

-

进阶特征对齐模型: 有些研究工作提出了进阶的特征对齐模型,例如联合特征对齐(Joint Feature Alignment)或深度对齐网络(Deep Alignment Network)。这些模型尝试在多个层次上对齐特征,以获得更好的迁移效果。

如何使用梯度下降等优化算法来实现最大化MMD

-

定义模型: 定义一个神经网络或其他机器学习模型,该模型将输入的特征 X_s 和 X_t 映射到一个共享的特征空间。

-

优化过程: 通过梯度下降等优化算法来最大化MMD。优化的目标是最大化MMD损失函数,使得源域和目标域在特征空间中的特征更加一致。

在训练过程中,计算MMD损失函数的梯度,然后根据梯度方向来更新模型的参数,使得MMD损失函数逐渐增大。具体来说,可以使用随机梯度下降(Stochastic Gradient Descent,SGD)或其他优化算法,例如Adam、RMSProp等,来更新模型的参数。

- 与目标任务一起训练: 特征对齐通常是迁移学习中的一部分,我们通常希望将特征对齐与目标任务一起训练。因此,在实际应用中,可以将MMD作为一个正则化项添加到目标任务的损失函数中,同时优化特征对齐和目标任务。

需要注意的是,特征对齐是迁移学习中的一种技术手段,最终目标是提高目标任务的性能。因此,在实际应用中,除了特征对齐外,还需要结合其他的迁移学习方法和技术来进一步优化模型和提高性能。

参考资料:

1、迁移学习一、基本使用_迁移学习过程_开始写博客的博客-CSDN博客

带了一点实验实现