观看B站课程视频所作笔记

预存问题:

1、非线性变换(激活函数),怎么变换的

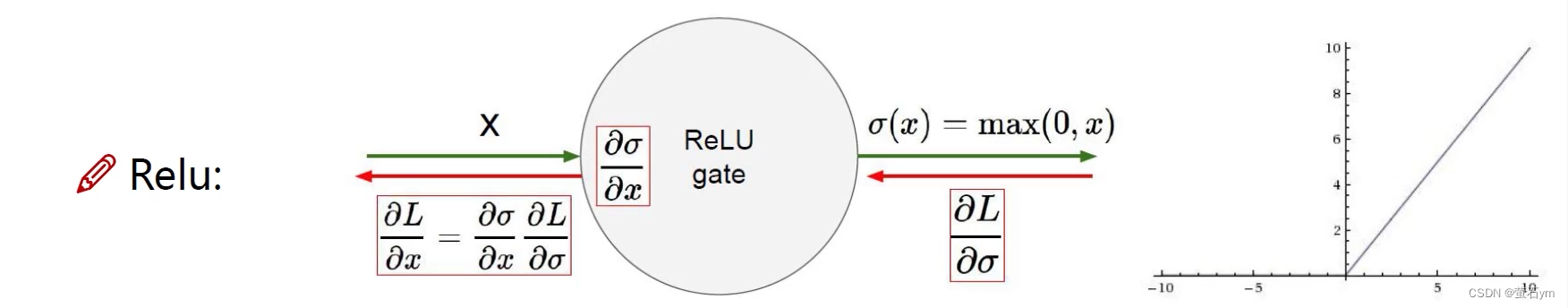

输入的X,经过一个非线性函数,输出值再作为下一层的输入,使用非线性函数做一个映射

2、到全连接层 怎么操作的权重

将卷积输出的二维特征图转化成一维的一个向量

输出特征*权重矩阵(n*1的)得到全连接之后的一个值

3、FC层怎么就输出分类结果了

4、反向传播具体详细过程

一、损失函数

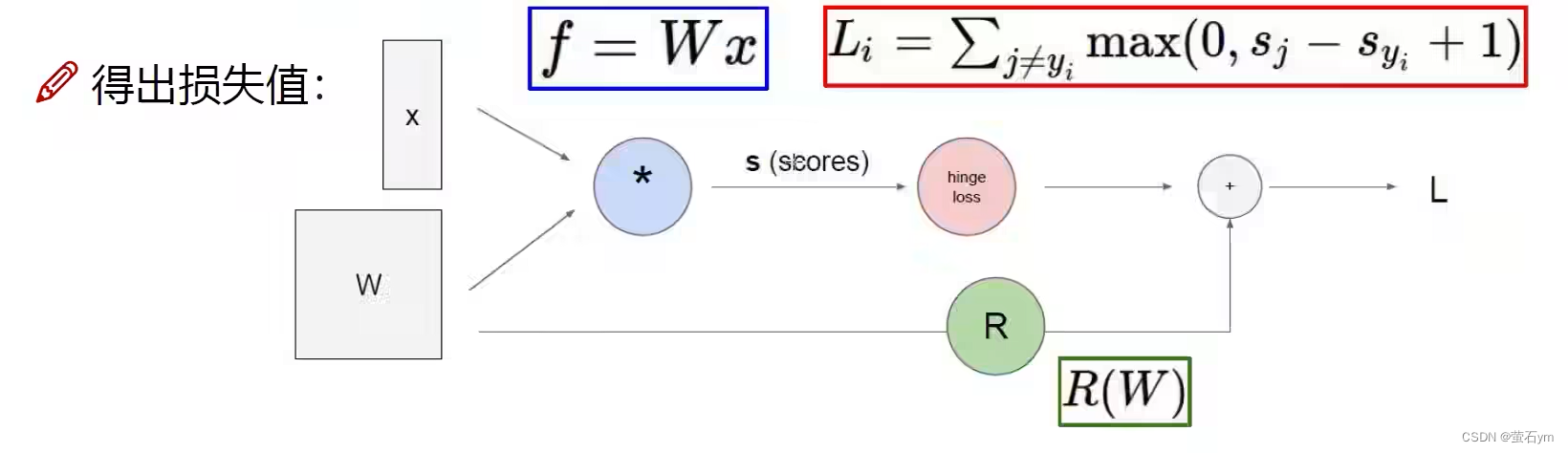

1、损失得分值

f是得分函数;Sj其他类别得分,Syi正确类别得分,作差+1,1是一个偏置值为容忍度;再加一个RW是正则化惩罚项,防止过拟合;

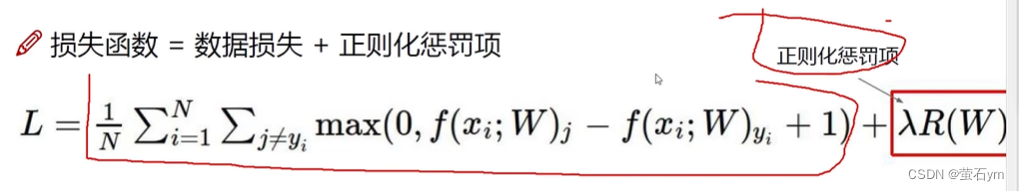

损失函数=数据损失+正则化惩罚项

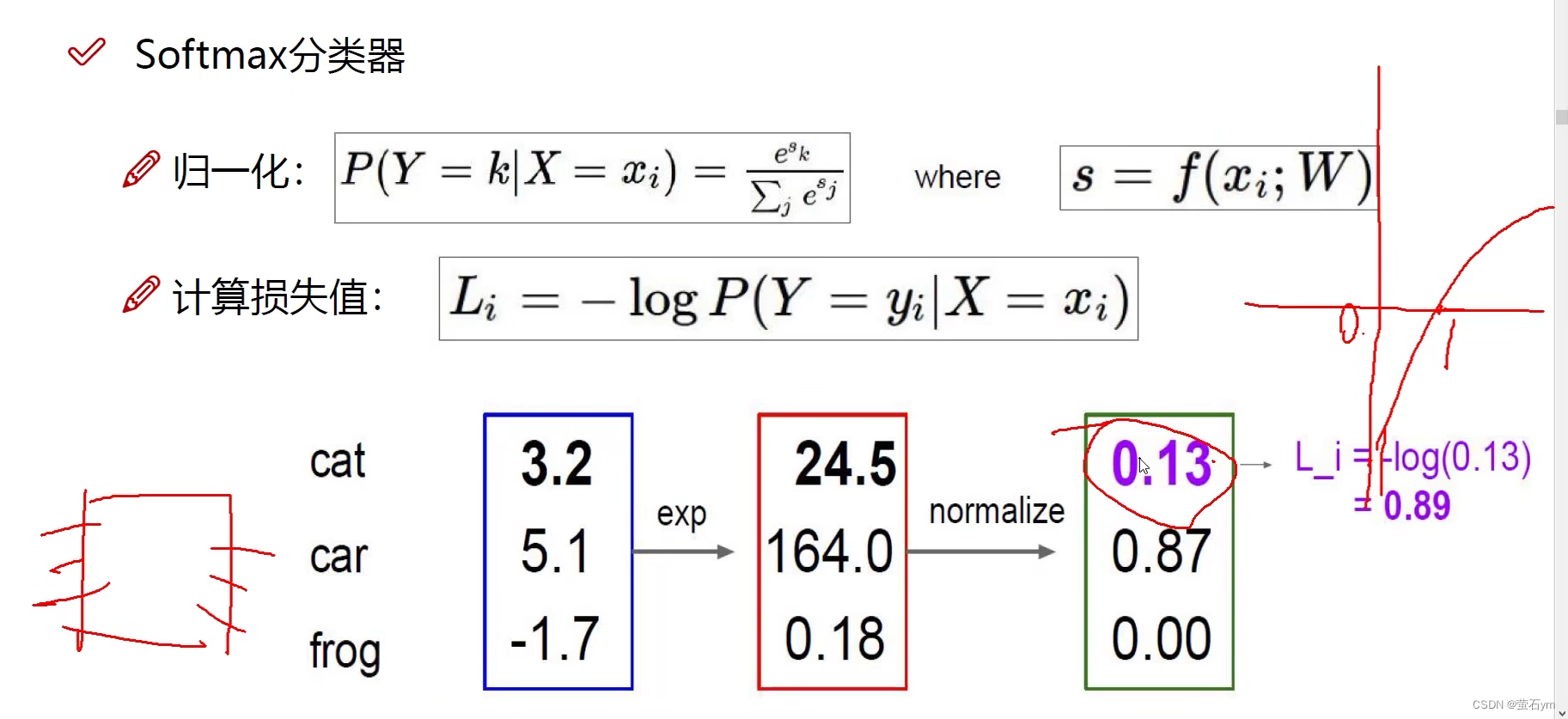

2、归一 得概率值 Softmax分类器

把得分值转换为概率值,

使用exp放大差异,求得概率值,损失情况使用-log放到0-1之间,正确类别概率值越靠近1,损失越小

输入x和W一步步得出损失值L:称为前向传播

3、反向传播 梯度下降 偏导值

反向传播的是每一层经过的权重W,该W是由求偏导梯度下降计算出来的

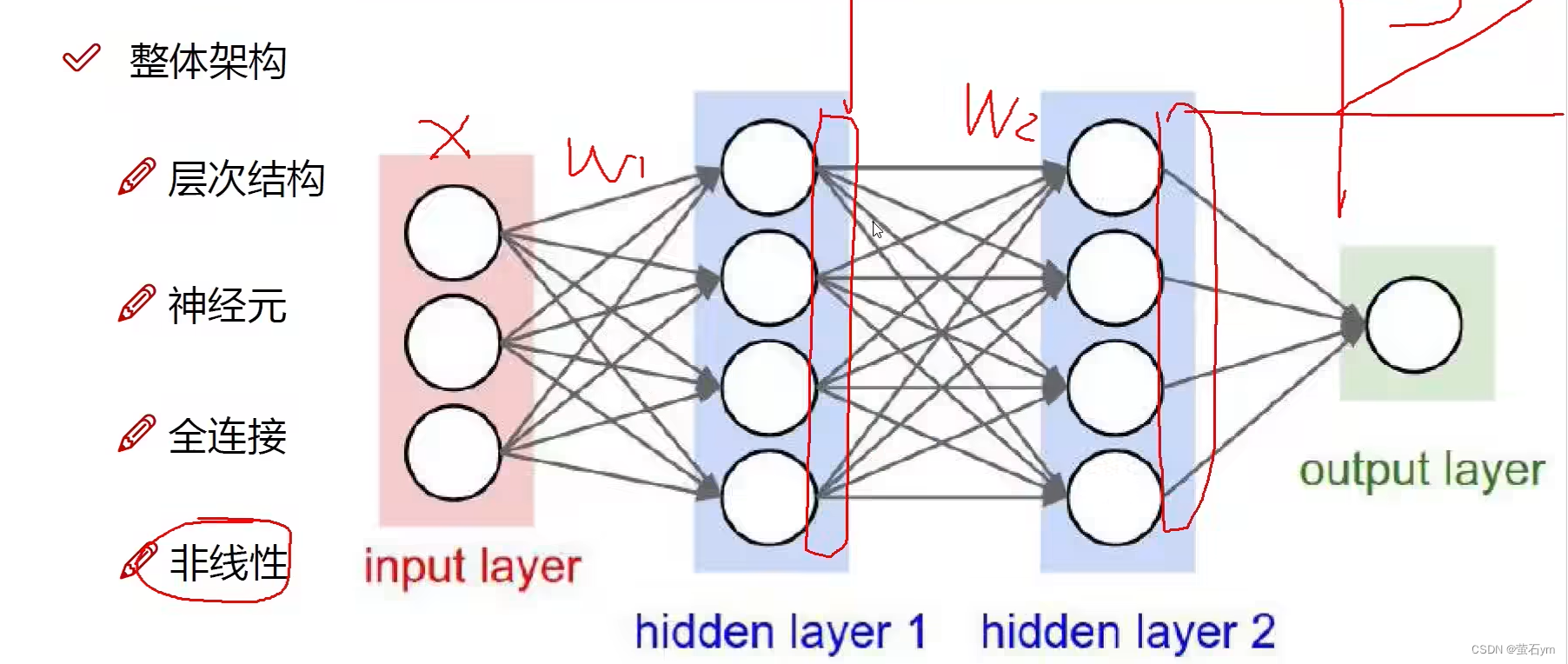

二、神经网络整体基础结构

1、整体架构

在每一层权重调整后会进行一下非线性变换(图中红色竖方形位置),非线性变换是由激活函数完成的

2、输入层 输入数据特征 x

2.1 数据预处理

标准化操作:减均值,除以方差

2.2 参数初始化

随机策略,针对权重参数,

输入层和隐藏层之间通过权重参数连接的

经过好多层,每一层都进行的特征提取

经过多层权值处理,最终得到输出值

3、激活函数

3.1 Sigmoid函数:

在数值较大或较小时,进行求导效果不好,发生梯度消失现象

3.2 Relu 函数

4、损失

得到损失,再反向传播,对每一层的参数W进行求偏导,更新其值

整个神经网络目的就是,找到每一层的权重W,能够更适合于当前的任务

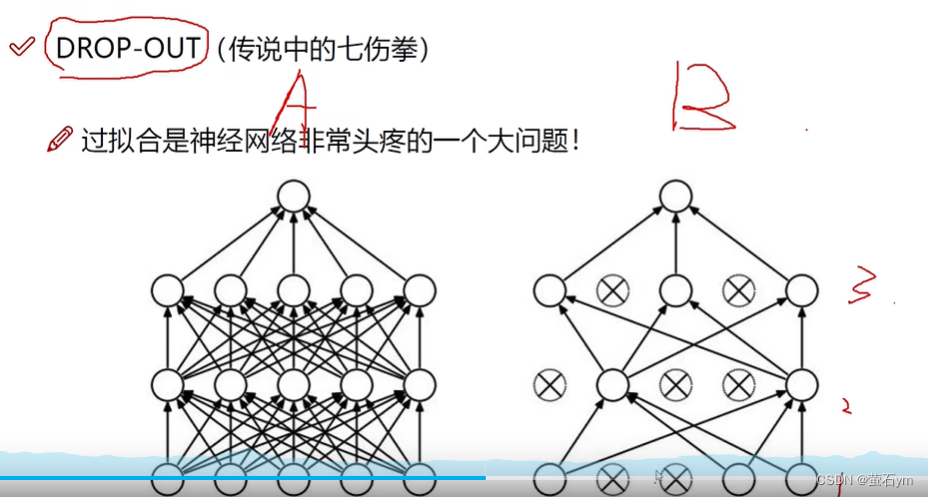

5、过拟合解决方法:

5.1 正则化惩罚值:

5.2 DROP-OUT

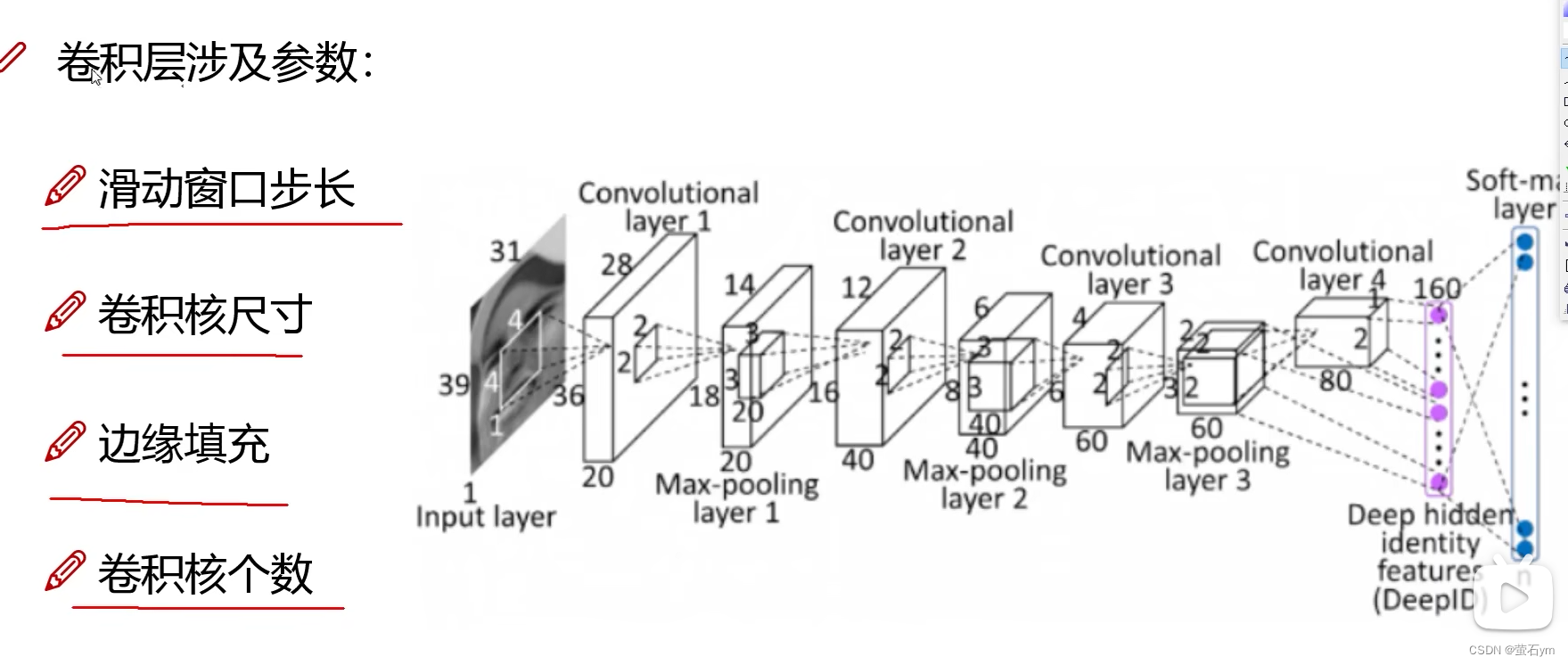

三、卷积神经网络

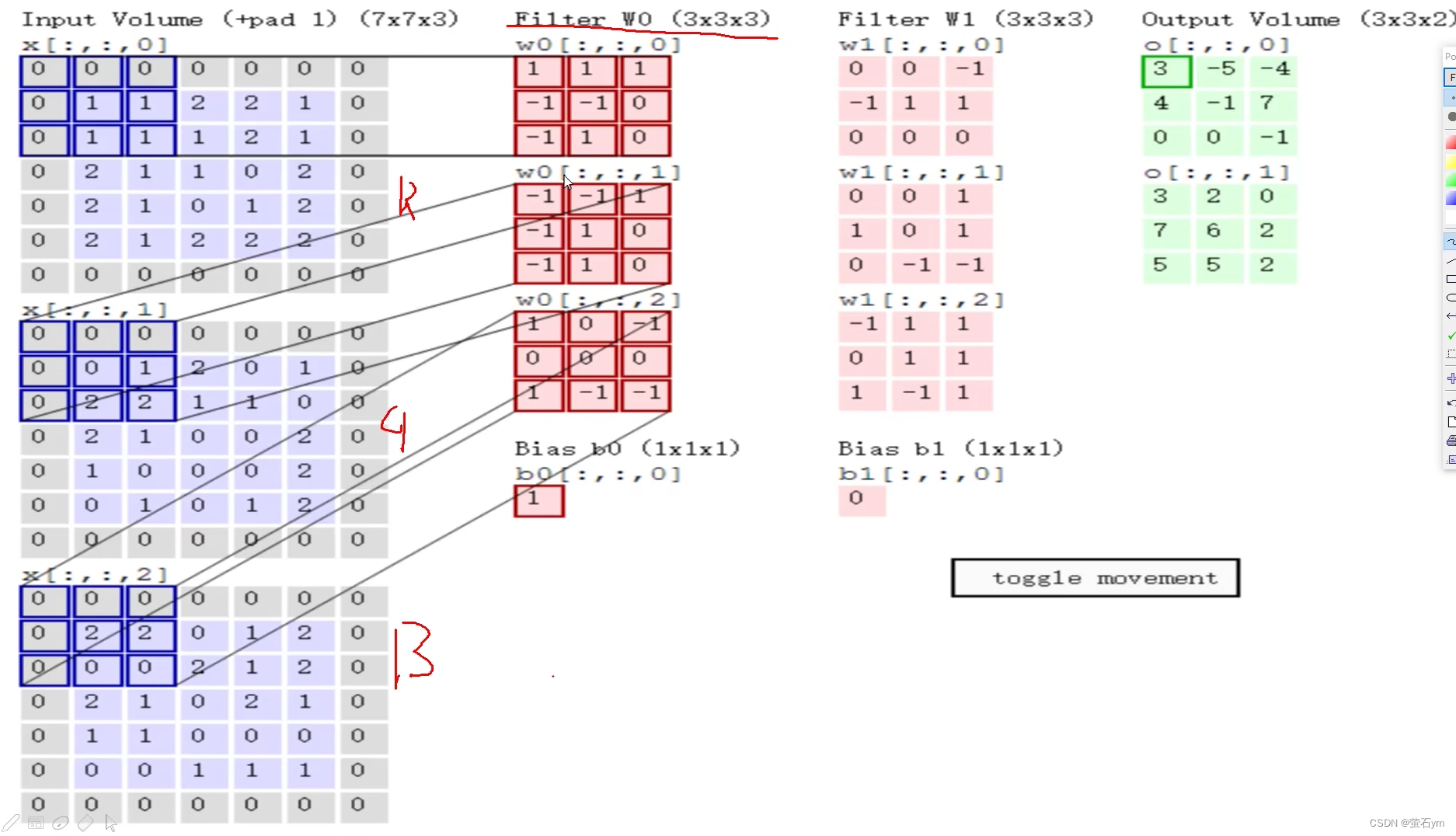

1、卷积层

输入为图片的特征值,中间Filter过滤器权值,是卷积核,取与卷积核同样大小的特征一块一块的作内积(对应位置相乘 所有结果加一起),得到这一块的特征值(是一个数),图中所示的部分左上角块RGB分别内积w0再相加得值为3(右边绿色框)。

经过一个Filter得到一个特征图,n个Filter得到n个特征图,堆叠起来,深度就是Filter的层数

一个卷积层可能有多个卷积核,多个Filter,经过一个卷积层得到n层的的特征图

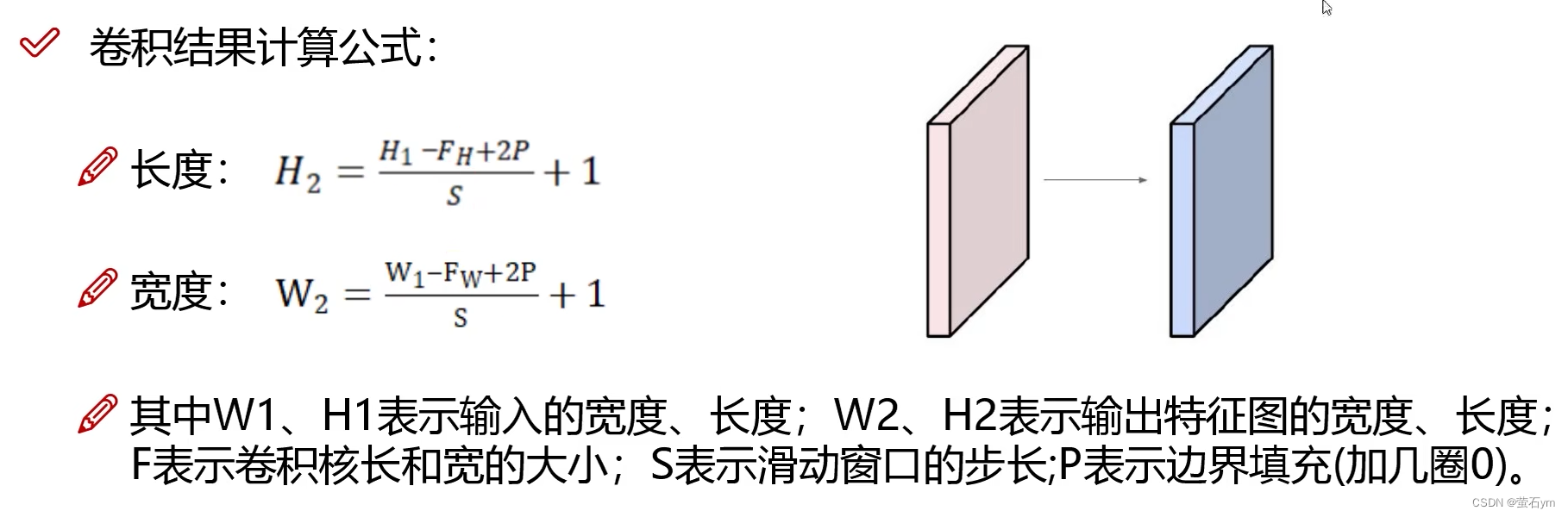

卷积结果 特征图的尺寸:

2、池化层

做压缩,下采样,

MAX POOLING :最大池化,选出每个框框里边的最大值

每个卷积层都要跟一个RELU激活层,再加池化层

池化层只会使长宽变小,特征层数不变

3、全连接层FC

将池化层得到的多层特征图拉长,变成一个个的特征值(向量),几分类任务,得到分类结果

带有权重参数计算的才算层数(CONV,FC是;激活层和池化层不算层数)

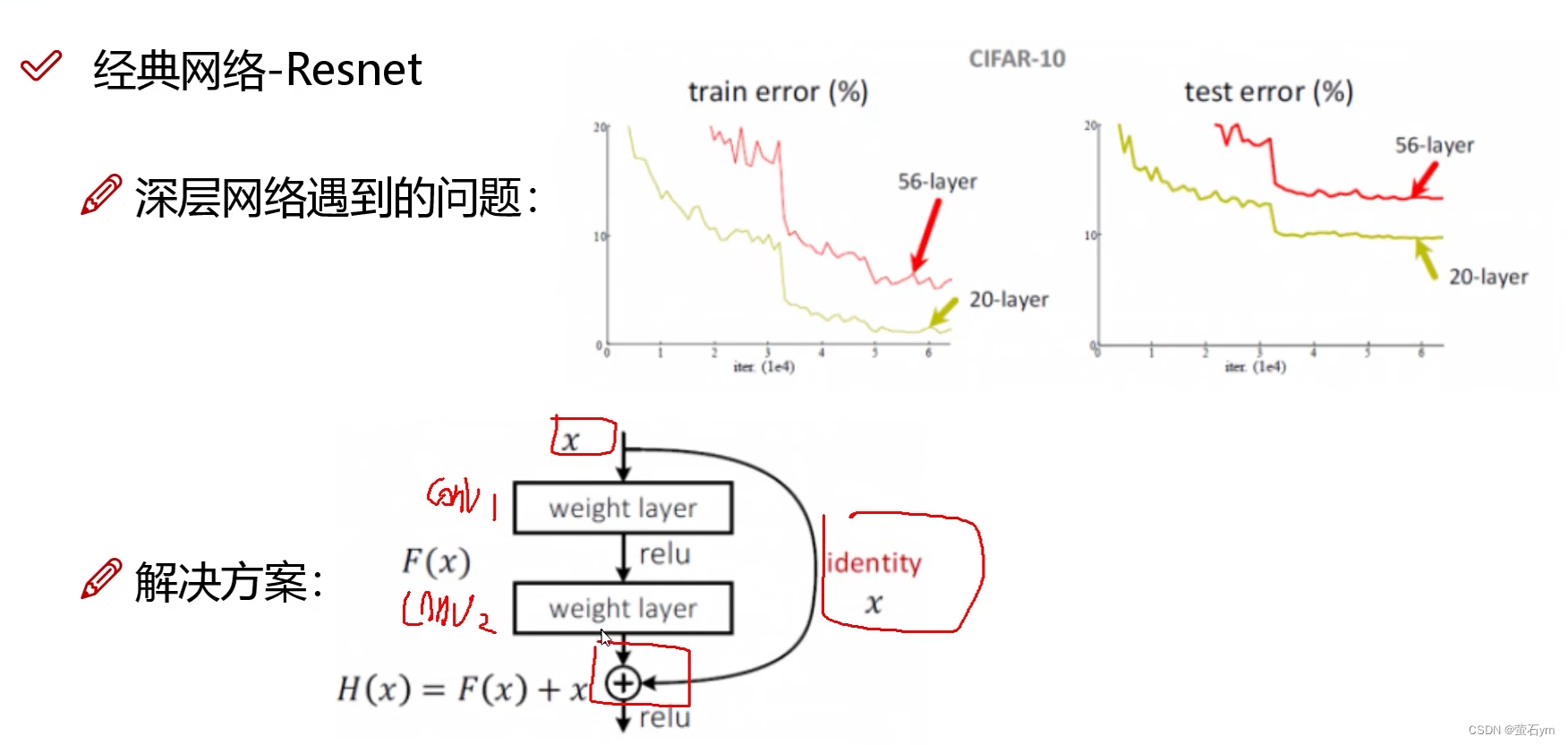

4、残差网络Resnet

处理在一直堆叠卷积层之后出现的效果反而下降问题