小土堆视频:P4. PyCharm及Jupyter使用及对比_哔哩哔哩_bilibili

pytorch官网讲解了详细的知识点PyTorch documentation — PyTorch 2.0 documentation

1、细节知识

shift+enter进入下一行的首处

ctrl+P提示输入的参数

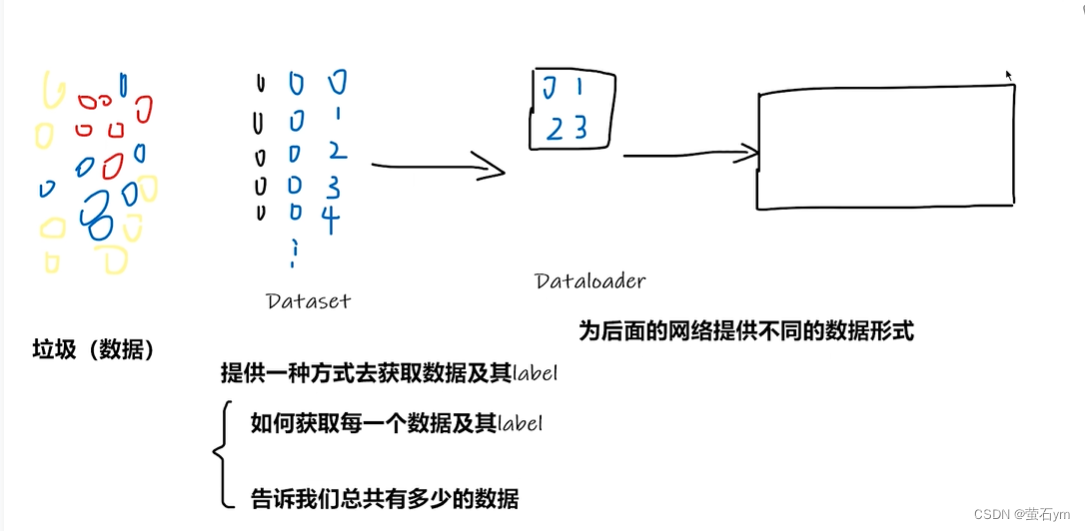

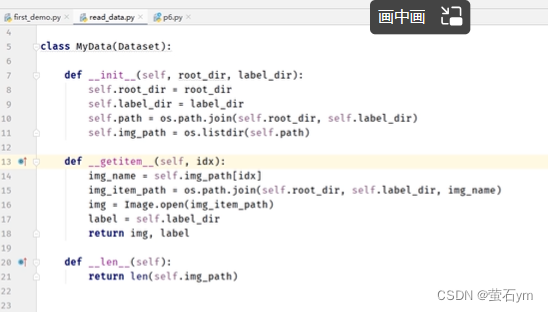

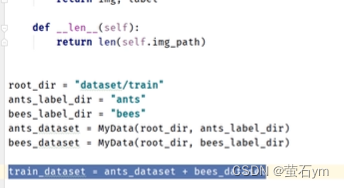

2、pytorch加载数据:dataset和Dataloader

dataset只是提供这个数据集(一副扑克牌)

dataloader相当于一个手 每次去dataset中怎么取牌 拿几张怎么拿

3、Tensorboard

可以用图像形式 来展示训练的结果情况

4、transforms 对图片进行变换

ToTensor:将图片转换为张量

5、卷积

in_channels和out_channels为输入输出的通道数

图片输入是三通道RGB,三个通道分别的颜色 组成了一张图片

batch_size:表示单次传递给程序用以训练的数据(样本)个数。比如我们的训练集有1000个数据。这是如果我们设置batch_size=100,那么程序首先会用数据集中的前100个参数,即第1-100个数据来训练模型。当训练完成后更新权重,再使用第101-200的个数据训练,直至第十次使用完训练集中的1000个数据后停止

6、池化

dilation:空洞卷积,卷积核中间是隔着来的

floor和ceil模式:往下取小还是往上取大,ceil是保留

用池化核取这一块中最大的值

torch.Resize(20,100,30,30):bitchsize、channels、高、宽

7、非线性层激活函数

跟在卷积之后

8、线形层 Linear

把一个5*5的图片展成一行25个的,再变成一行3个的(此处最后的3是因为要分成三个类别)

总共是两个线性层

最后输出是10,代表是10分类

9、损失:分类的交叉熵损失函数

比如10分类问题,最后神经网络的输出是10个数代表每一类的概率值

对这个概率值和target进行代入计算损失值

10、反向传播

使用backward可以计算出每个需要调节的参数W的梯度值grad,

11、优化器optimizer根据这个梯度进行更新

定义优化器、学习率lr

optim.step进行优化

12、区分

定义Softmax回归是逻辑回归的一种形式,它可以将输入值归一化为值的向量,该向量遵循概率分布,其总和为1