文章目录

2023

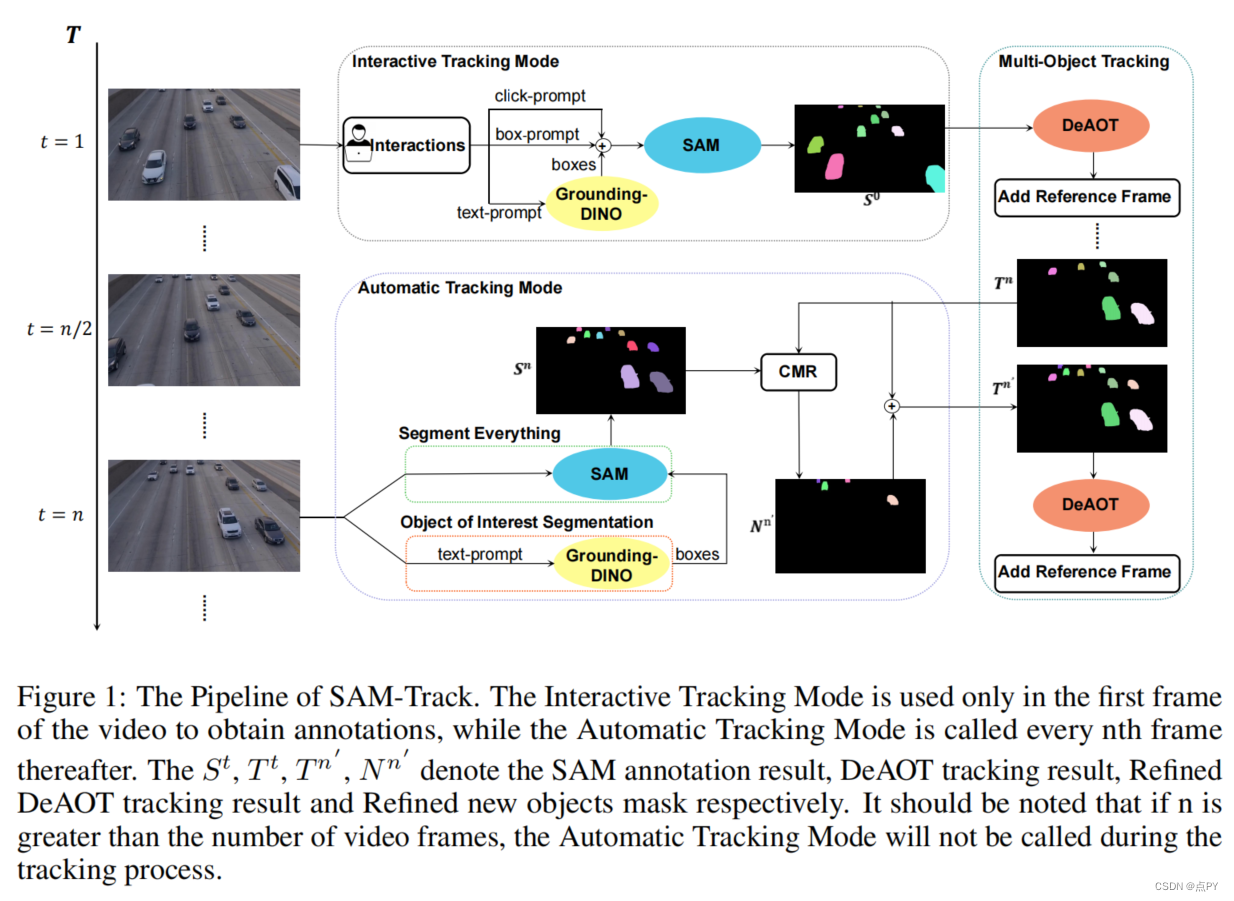

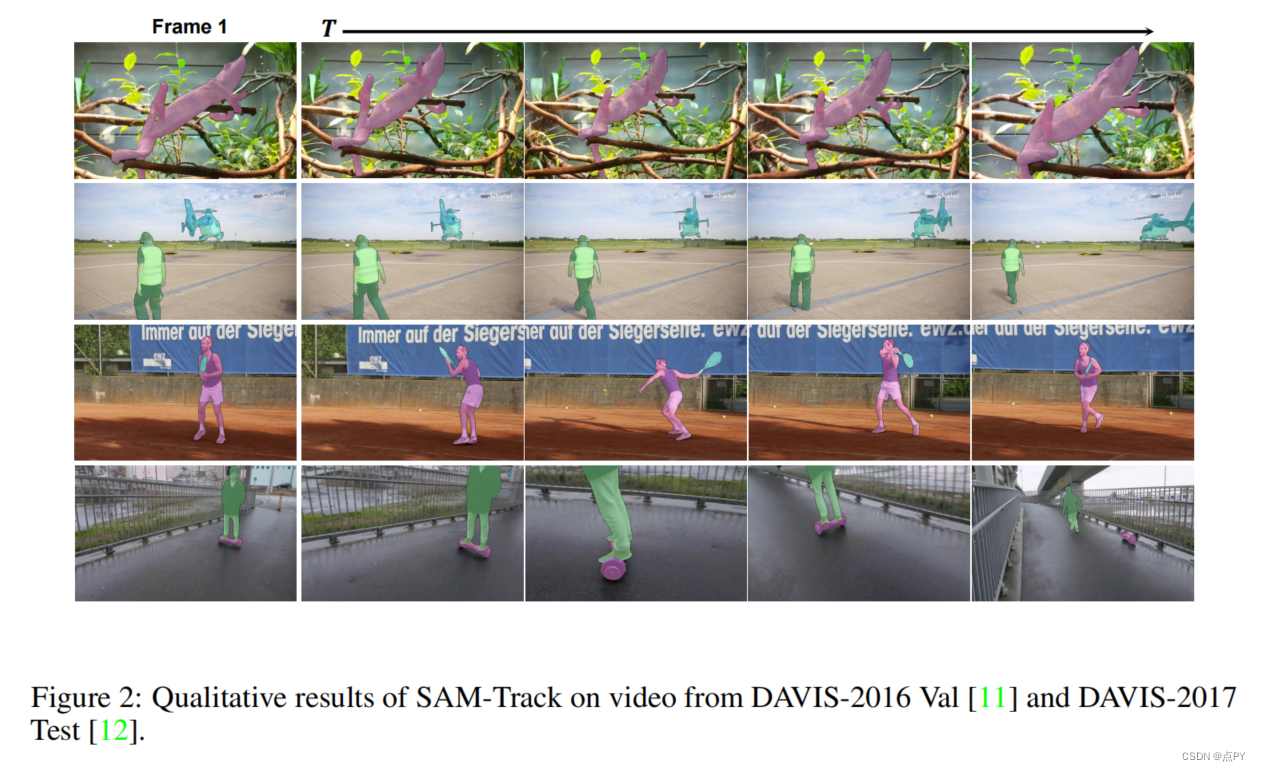

Segment and Track Anything

code:https://github.com/z-x-yang/Segment-and-Track-Anything

摘要:该报告提供了一个名为分割和跟踪任何东西(SAMTrack)的框架,它允许用户精确和有效地分割和跟踪视频中的任何对象。此外,SAM-Track采用了多模态交互方法,使用户能够在视频中选择多个对象进行跟踪,并对应于他们的特定需求。这些交互方法包括点击、笔划和文本,每一种都具有独特的好处,并能够结合使用。因此,SAM-Track可以应用于一系列领域,从无人机技术、自动驾驶、医学成像、增强现实技术到生物分析。SAM-Track将交互式关键帧分割模型(SAM)与我们提出的基于AOT的跟踪模型(DeAOT)合并,该模型在VOT 2022挑战的四个轨道中获得了第一名,以促进视频中的目标跟踪。此外,SAM-Track集成了Grounding-dino,这使框架能够支持基于文本的交互。我们已经展示了SAM-Track在DAVIS-2016 Val(92.0%)、DAVIS-2017测试(79.2%)上的显著能力,以及它在各种应用中的实用性。

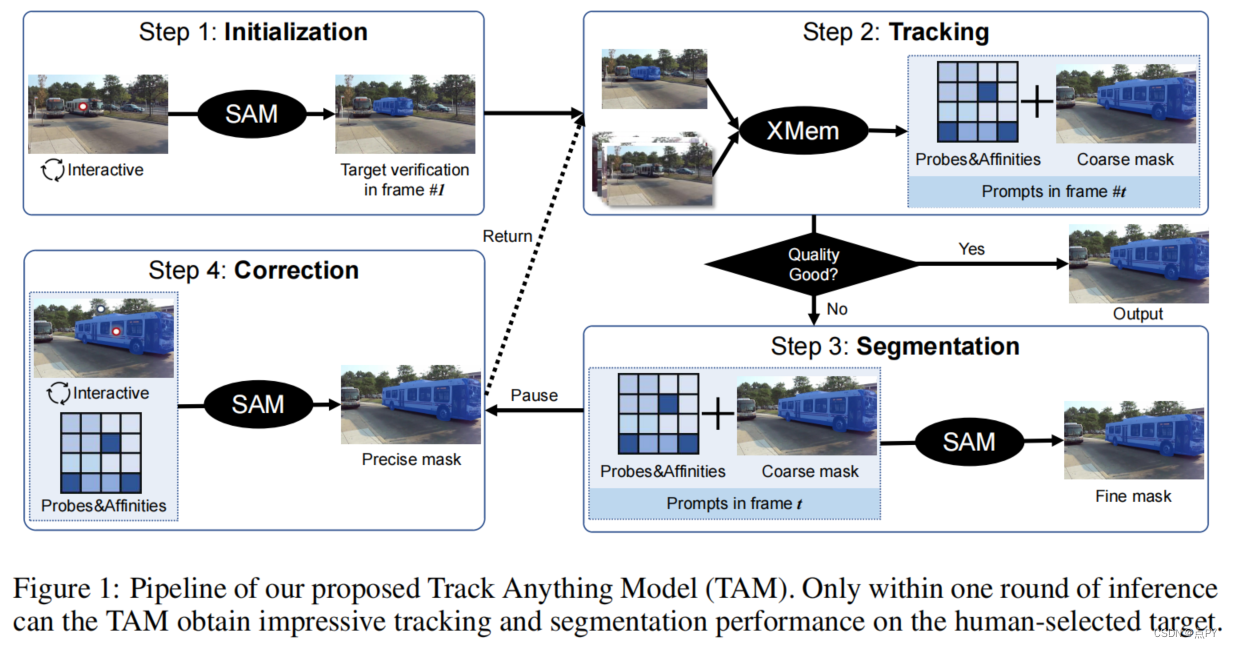

Track Anything: Segment Anything Meets Videos

code: https://github.com/gaomingqi/Track-Anything

摘要: 近年来,分割任意模型(SAM)因其对图像分割性能而迅速获得了广泛的关注。由于其较强的图像分割能力和不同提示的高交互性,我们发现其在视频一致性分割效果较差。因此,在本报告中,我们提出了跟踪任何事物模型(TAM),它可以在视频中实现高性能的交互式跟踪和分割。详细地说,给定一个视频序列,只有很少的人类参与,也就是说,几次点击,人们可以跟踪任何他们感兴趣的东西,并在本体推理中得到令人满意的结果。没有额外的训练,这种交互式设计执行的视频对象跟踪和分割令人印象深刻。

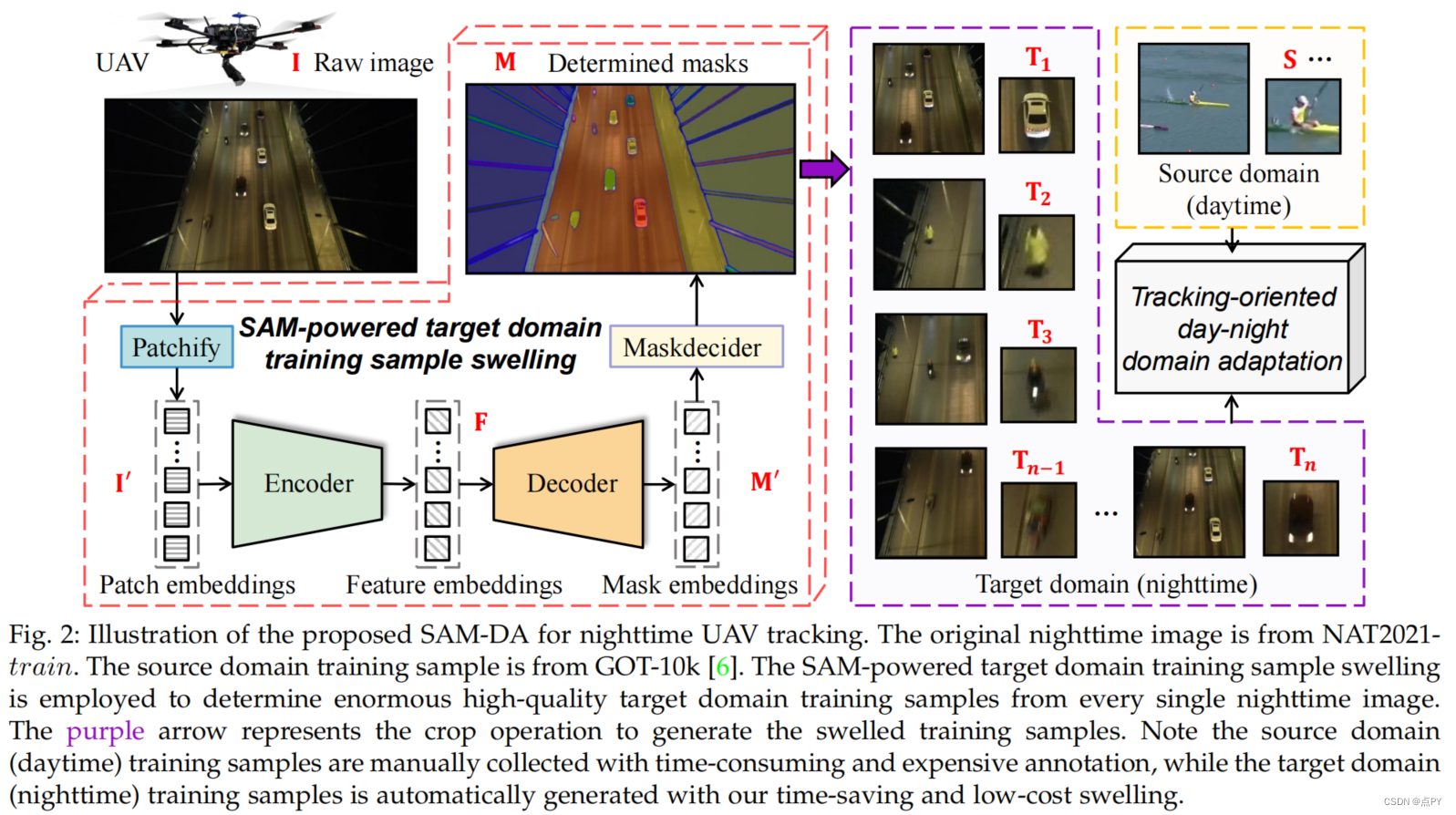

SAM-DA: UAV Tracks Anything at Night with SAM-Powered Domain Adaptation

code: https://github.com/vision4robotics/sam-da

摘要: 领域自适应(DA)在实时夜间无人机(UAV)跟踪方面显示出了巨大的前景。然而,最先进的(SOTA)DA仍然缺乏具有精确的像素级位置和边界的潜在对象来生成高质量的目标域训练样本。这一关键问题限制了实时夜间SOTA跟踪器的迁移学习,以挑战夜间无人机跟踪。最近,著名的片段任意事物模型(SAM)由于其巨大的数据驱动的训练方法,在发现大量的潜在目标方面取得了显著的零镜头泛化能力。为了解决上述问题,本工作提出了一种新的sam驱动的实时夜间无人机跟踪DA框架,即SAM-DA。具体来说,设计了一种创新的sam驱动的目标域训练样本膨胀,从每一幅原始夜间图像中确定巨大的高质量的目标域训练样本。这种新的一对一多方法显著扩展了DA的高质量目标域训练样本。对大量夜间无人机视频的综合实验证明了SAM-DA对夜间无人机跟踪的鲁棒性和领域适应性。特别是,与SOTA DA相比,SAM-DA可以用更少的夜间原始图像获得更好的性能,即更少-更好的训练。