LLM探索:GPT类模型的几个常用参数 Top-k, Top-p, Temperature:

总结:

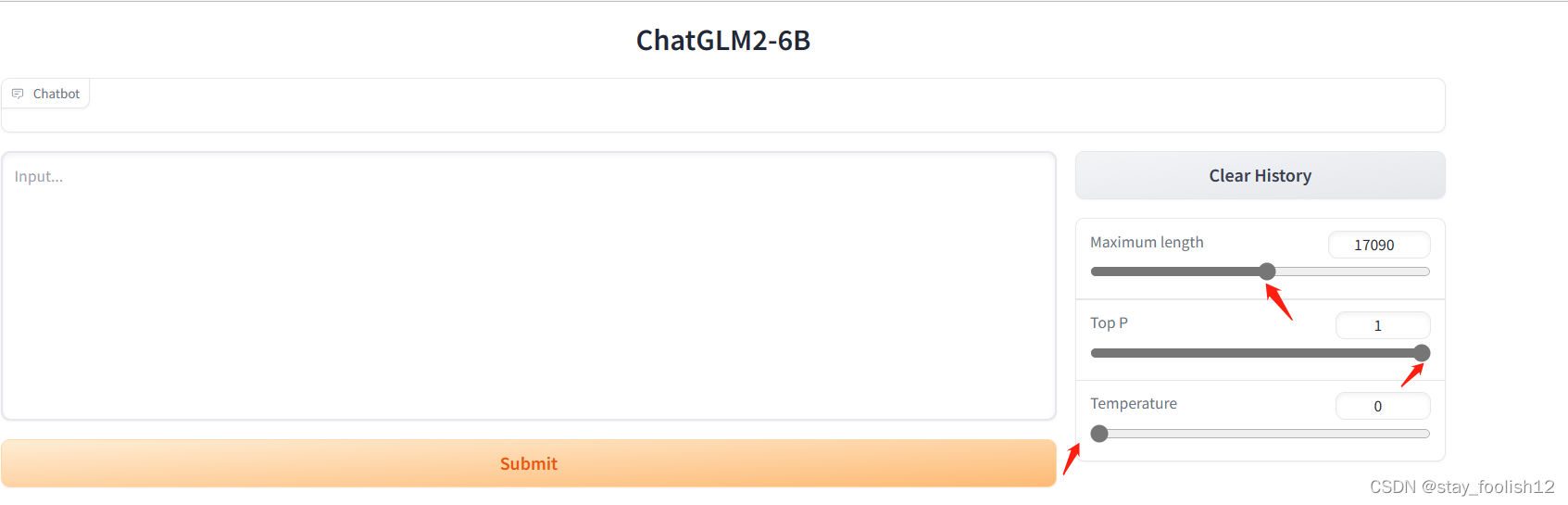

1.Temperature

用于调整随机从生成模型中抽样的程度,因此每次点击“生成”时,相同的提示可能会产生不同的输出。温度为 0 将始终产生相同的输出。温度越高随机性越大!

2.Top p

动态设置tokens候选列表的大小。 将可能性之和不超过特定值的top tokens列入候选名单。

Top p 通常设置为较高的值(如 0.75),目的是限制可能被采样的低概率 token 的长度。

拓展.Top k

允许其他高分tokens有机会被选中。 这种采样引入的随机性有助于在很多情况下生成的质量。 top-k 参数设置为 3意味着选择前三个tokens。

将如果 k 和 p 都启用,则 p 在 k 之后起作用。