前言

机器学习主要分为三类:有监督学习、无监督学习和强化学习。在本文中,我们将介绍强化学习(Reinforcement Learning)的原理、常见算法和应用领域。

文章目录

一、原理

强化学习(Reinforcement Learning)是机器学习中一种重要的学习范式,其目标是通过与环境的交互来学习如何做出最优的决策。 强化学习不同于监督学习和无监督学习,它通过试错的方式来学习,不需要标记好的训练数据或者环境的先验知识。

强化学习的核心思想是通过与环境的交互来学习如何做出最优的决策。

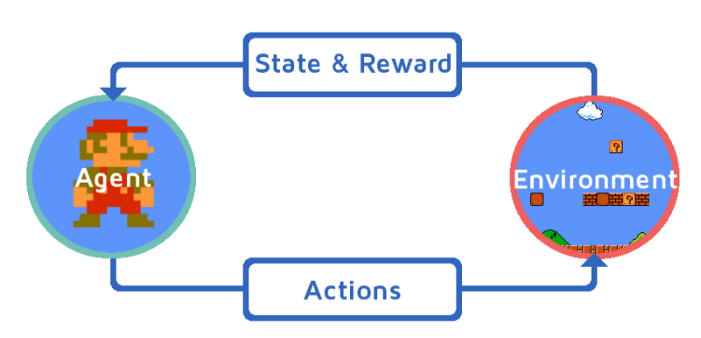

在强化学习中,有一个智能体(Agent)和一个环境(Environment)。智能体通过观察环境的状态(State),选择一个动作(Action),然后环境根据智能体的动作给予一个奖励(Reward)和新的状态。智能体根据奖励来调整自己的策略,以获得更高的累积奖励。

强化学习的目标是找到一个最优的策略(Policy),使得智能体在与环境的交互过程中获得最大的累积奖励。 这个过程可以用马尔可夫决策过程(Markov Decision Process,MDP)来建模。MDP由五个要素组成:状态空间(State Space)、动作空间(Action Space)、状态转移概率(State Transition Probability)、奖励函数(Reward Function)和折扣因子(Discount Factor)。

二、算法

强化学习中有许多经典的算法,下面介绍其中一些常见的算法:

1️⃣Q学习

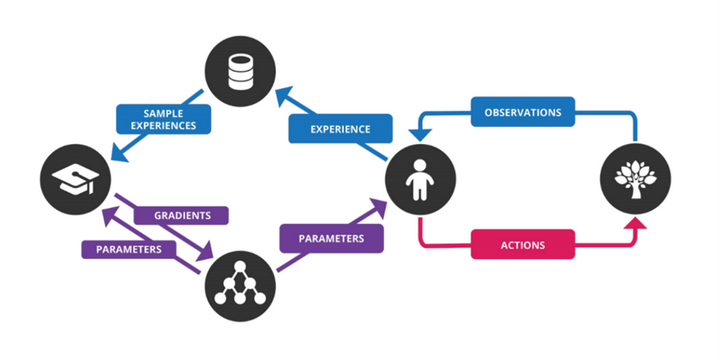

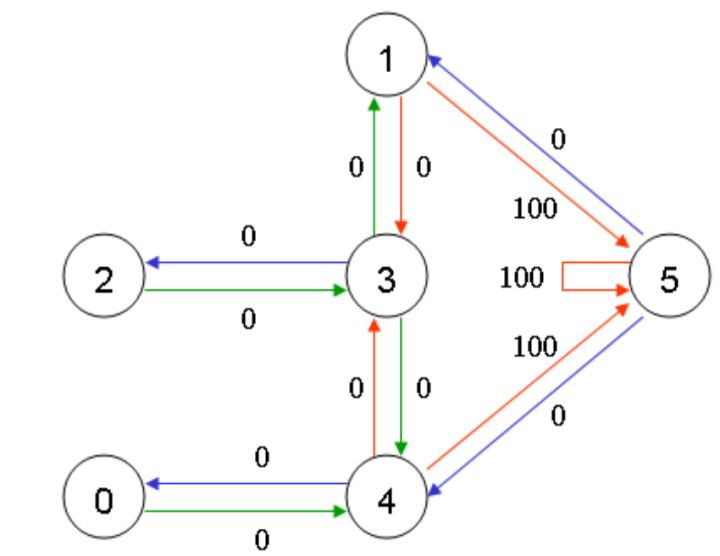

Q学习是一种基于值函数的强化学习算法。它通过迭代更新一个动作值函数(Q函数),来学习最优的策略。Q学习的核心思想是使用贝尔曼方程(Bellman Equation)来更新Q函数的值,以使其逼近最优的Q函数。

2️⃣SARSA

SARSA是一种基于值函数和策略的强化学习算法。它与Q学习类似,但在更新Q函数时使用了当前策略下的下一个动作值。SARSA的核心思想是通过不断与环境交互,更新Q函数和策略,以获得最优的决策策略。

3️⃣深度强化学习

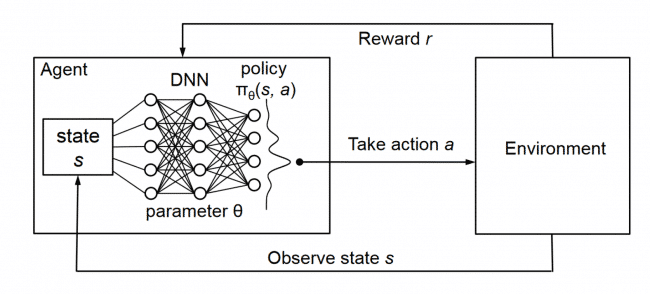

深度强化学习是将深度学习和强化学习相结合的一种方法。它使用深度神经网络来近似值函数或策略函数,以解决高维状态空间和动作空间的问题。深度强化学习的代表性算法包括Deep Q-Network(DQN)、Proximal Policy Optimization(PPO)等。

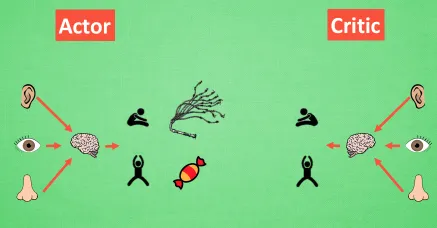

4️⃣Actor-Critic

Actor-Critic是一种结合了策略梯度和值函数的强化学习算法。它同时学习一个策略函数(Actor)和一个值函数(Critic),通过策略梯度方法和值函数的估计来更新参数。Actor-Critic算法能够更好地处理连续动作空间和高维状态空间的问题。

三、应用领域

强化学习在各个领域都有广泛的应用,下面介绍其中一些常见的应用领域:

1️⃣游戏

在游戏领域,强化学习被用于训练智能体玩各种类型的游戏。例如,AlphaGo通过强化学习在围棋上战胜了人类世界冠军。强化学习也被用于训练玩电子游戏的智能体,如Atari游戏。

2️⃣机器人控制

在机器人控制领域,强化学习被用于训练机器人学习如何在复杂环境中进行导航和操作。通过与环境的交互,机器人可以学习如何避开障碍物、抓取物体等技能。

3️⃣自动驾驶

在自动驾驶领域,强化学习被用于训练自动驾驶车辆学习如何做出最优的决策。通过与环境的交互,自动驾驶车辆可以学习如何遵守交通规则、安全驾驶等。

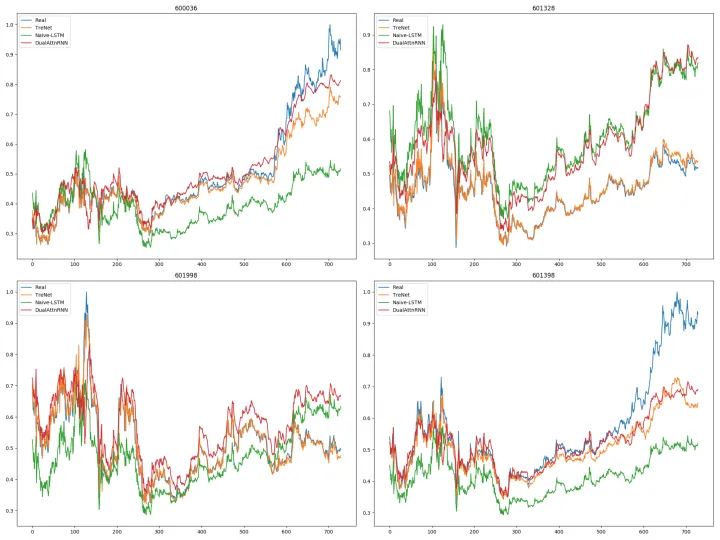

4️⃣金融交易

在金融交易领域,强化学习被用于训练智能体学习如何做出最优的交易决策。通过与市场的交互,智能体可以学习如何预测市场趋势、优化交易策略等。

四、总结

强化学习(Reinforcement Learning)的目标是通过与环境的交互来学习如何做出最优的决策。随着深度学习和强化学习的结合,强化学习在解决复杂问题上的能力将不断提升,为人工智能的发展带来更多的可能性。