今天来介绍一些工具,写网络爬虫也跟其他工作有相似之处,那就是需要工具,今天说的工具不是电脑哈,也不是IDE ,是一些常用的解析工具,我先大概介绍一下我常用的 :

1 xpath 2 BeautifulSoup 3 正则表达式 。

当然了 还有一些 像jsonpath,pyquery等用的稍微少一点我就不介绍了

为什么要用这些解析工具? 怎么使用?(下节开始我们开始带一些小案列))

为什么要用解析工具:做爬虫还有对前端了解一些,比如 css js ajax 等,因为数据我们前边说了是嵌在html 代码里面的,我们需要提取出来,试想一下化学中的提取某种东西 是不是需要各种器材,爬虫提取数据亦是如此,这些解析工具能帮助我们轻易的获取我们想要的数据。

怎么使用:每个工具啊都有自己的使用方法,和规则,只要我们按照规则就可以

xpath

xpath 是一门在xml文档中查找信息的语言。可以用来在xml文档中对元素和属性进行遍历

前人种树 后人乘凉,有很多优秀的平台已经把他的使用方式介绍的很清楚了,我在复制也没什么意思,我推荐

菜鸟教程 :点击打开链接 介绍的很详细,看完可以找一段简单的网页试下,chrom浏览器还有一些页面的解析工具,很方便

BeautifulSoup

python3.x 版本 print(xxxx) python2.x版本 print xxxx

# from bs4 import BeautifulSoup

soup = BeautifulSoup('<a onclick="xx" href="xx">xx</a>', 'html.parser')

a = soup.select('a')[0]

onclick = a.get('onclick')

print(onclick) #xx

获得一个元素后,使用get('attr')可以得到value

string 方法,输出结果与当前唯一子节点的 .string 结果相同。

通俗点说就是:如果一个标签里面没有标签了,那么 .string 就会返回标签里面的内容。

如果标签里面只有唯一的一个标签了,那么 .string 也会返回最里面的内容。

如果超过一个标签的话,那么就会返回None

print soup.head.string

#The Dormouse's story

print soup.title.string

#The Dormouse's story

print soup.html.string

# None

#***find_all( name , attrs , recursive , text , **kwargs )***********!!!!!!!!!!!!!!

find_all() 方法搜索当前tag的所有tag子节点,并判断是否符合过滤器的条件

1 name 参数

name 参数可以查找所有名字为 name 的tag,字符串对象会被自动忽略掉

#第一个参数为Tag的名称

tag.find_all(‘title’)

#得到”<title>&%^&*</title>”,结果为一个列表

#第二个参数为匹配的属性

tag.find_all(“title”,class=”sister”)

#得到如”<title class = “sister”>%^*&</title>

# 第二个参数也可以为字符串,得到字符串匹配的结果

tag.find_all(“title”,”sister”)

#得到如”<title class = “sister”>%^*&</title>

A下面的例子用于查找文档中所有的<b>标签

soup.find_all('b')

# [<b>The Dormouse's story</b>]

B.传正则表达式

如果传入正则表达式作为参数,Beautiful Soup会通过正则表达式的 match() 来匹配内容.下面例子中找出所有以b开头的标签,

这表示<body>和<b>标签都应该被找到

import re

for tag in soup.find_all(re.compile("^b")):

print(tag.name)

# body

# b

C.传列表

如果传入列表参数,Beautiful Soup会将与列表中任一元素匹配的内容返回.下面代码找到文档中所有<a>标签和<b>标签

soup.find_all(["a", "b"])

# [<b>The Dormouse's story</b>,

# <a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>,

# <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>,

# <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

D.传 True

True 可以匹配任何值,下面代码查找到所有的tag,但是不会返回字符串节点

E.传方法

2)keyword 参数

注意:如果一个指定名字的参数不是搜索内置的参数名,搜索时会把该参数当作指定名字tag的属性来搜索,

如果包含一个名字为 id 的参数,Beautiful Soup会搜索每个tag的”id”属性

soup.find_all(id='link2')

# [<a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>]

如果传入 href 参数,Beautiful Soup会搜索每个tag的”href”属性

soup.find_all(href=re.compile("elsie"))

# [<a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>]

使用多个指定名字的参数可以同时过滤tag的多个属性

soup.find_all(href=re.compile("elsie"), id='link1')

# [<a class="sister" href="http://example.com/elsie" id="link1">three</a>]

在这里我们想用 class 过滤,不过 class 是 python 的关键词,这怎么办?加个下划线就可以

soup.find_all("a", class_="sister")

# [<a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>,

# <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>,

# <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

可以通过 find_all() 方法的 attrs 参数定义一个字典参数来搜索包含特殊属性的tag

data_soup.find_all(attrs={"data-foo": "value"})

# [<div data-foo="value">foo!</div>]

4)limit 参数

soup.find_all("a", limit=2)

# [<a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>,

# <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>]

CSS选择器 用到的方法是 soup.select(),返回类型是 list 在写 CSS 时,标签名不加任何修饰,类名前加点 . id名前加 #

(1)通过标签名查找

rint soup.select('title')

#[<title>The Dormouse's story</title>]

(2)通过类名查找

print soup.select('.sister')

(3)通过 id 名查找

print soup.select('#link1')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>]

(4)组合查找 查找 p 标签中,id 等于 link1的内容,二者需要用空格分开

print soup.select('p #link1')

直接子标签查找

print soup.select("head > title")

#[<title>The Dormouse's story</title>]

(5)属性查找

查找时还可以加入属性元素,属性需要用中括号括起来,注意属性和标签属于同一节点,所以中间不能加空格,否则会无法匹配到

print soup.select('a[class="sister"]')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>,

print soup.select('a[href="http://example.com/elsie"]')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>]

上的 select 方法返回的结果都是列表形式,可以遍历形式输出,然后用 get_text() 方法来获取它的内容

soup = BeautifulSoup(html, 'lxml')

print type(soup.select('title'))

print soup.select('title')[0].get_text()

for title in soup.select('title'):

print title.get_text()

例如 item['home_page'] = cpy1.find(class_="link-line").find_all('a')[-1].get_text().strip()

#---------------------------------------------------------------------------------------------

字典中的get()方法取不到会返回None, 直接用键名取的话 取不到就报错。 json.loads可以吧str 转换成字典格式, 把json格式数据转换成python对象字典中的get()方法取不到会返回None, 直接用键名取的话 取不到就报错。 json.loads可以吧str 转换成字典格式, 吧json格式数据转换成python对象

我看了下其他博主的 介绍 也是非常的详细,希望大家广取经我介绍的比较简单

# --------------------------------------------------------------------------------------------------------------------------

正则表达式

正则表达式是处理字符串的强大工具,拥有独特的语法和独立的处理引擎。

我们在大文本中匹配字符串时,有些情况用str自带的函数(比如find, in)可能可以完成,有些情况会稍稍复杂一些(比如说找出所有“像邮箱”的字符串,所有和julyedu相关的句子),这个时候我们需要一个某种模式的工具,这个时候正则表达式就派上用场了。

说起来正则表达式效率上可能不如str自带的方法,但匹配功能实在强大太多。对啦,正则表达式不是Python独有的,如果已经在其他语言里使用过正则表达式,这里的说明只需要简单看一看就可以上手啦。

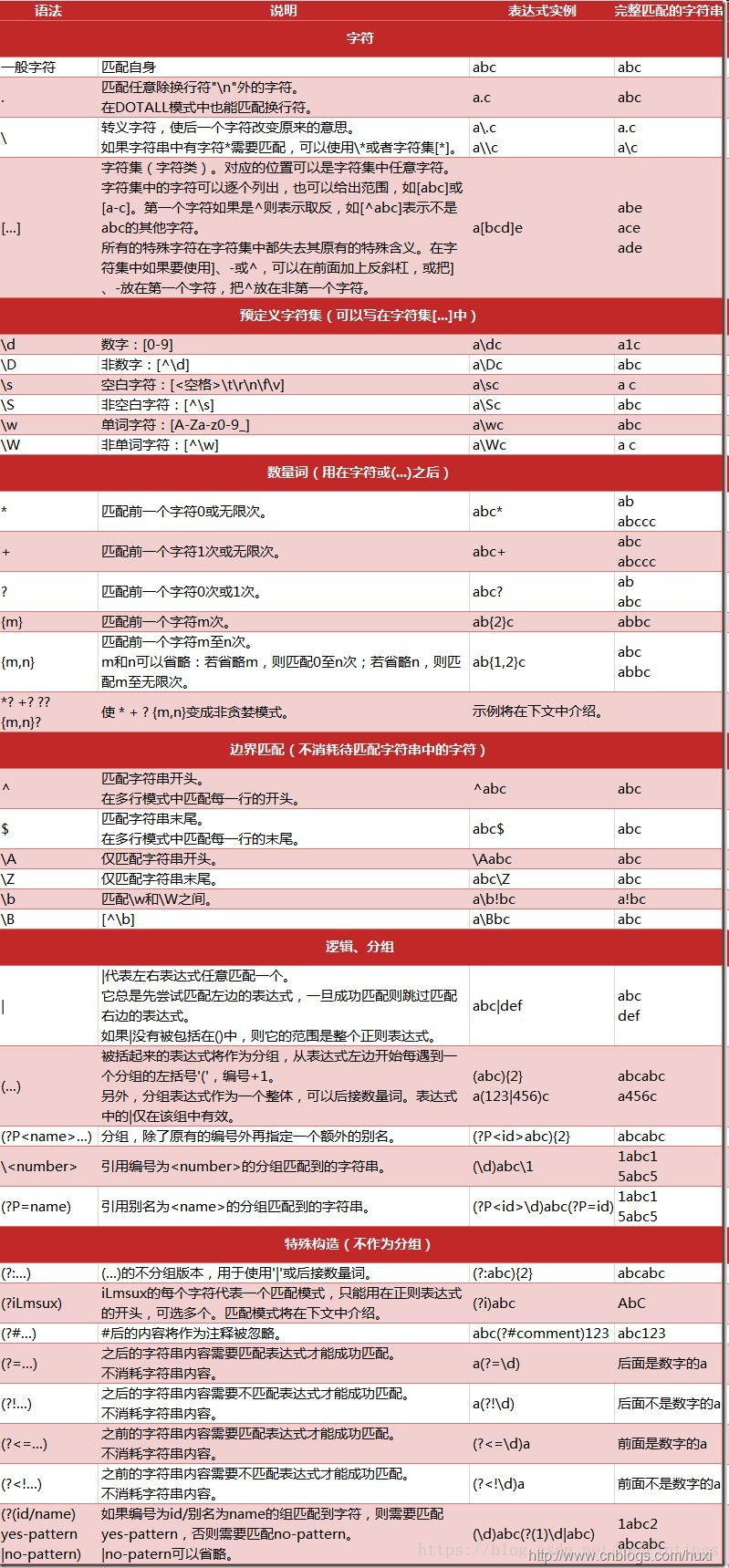

1.语法

废话少说,直接上技能

下面是一张有些同学比较熟的图,我们俗称python正则表达式小抄,把写正则表达式当做一个开卷考试,显然容易得多。

当你要匹配 一个/多个/任意个 数字/字母/非数字/非字母/某几个字符/任意字符,想要 贪婪/非贪婪 匹配,想要捕获匹配出来的 第一个/所有 内容的时候,记得这里有个小手册供你

# encoding: UTF-8

import re

# 将正则表达式编译成Pattern对象

pattern = re.compile(r'hello.*\!')

# 使用Pattern匹配文本,获得匹配结果,无法匹配时将返回None

match = pattern.match('hello, yangshilong! How are you?')

if match:

# 使用Match获得分组信息

print match.group()

hello, yangshilong!

re.compile(strPattern[, flag]):

这个方法是Pattern类的工厂方法,用于将字符串形式的正则表达式编译为Pattern对象。

第二个参数flag是匹配模式,取值可以使用按位或运算符'|'表示同时生效,比如re.I | re.M。

当然,你也可以在regex字符串中指定模式,比如re.compile('pattern', re.I | re.M)等价于re.compile('(?im)pattern')

flag可选值有:

- re.I(re.IGNORECASE): 忽略大小写(括号内是完整写法,下同)

- re.M(MULTILINE): 多行模式,改变'^'和'$'的行为(参见上图)

- re.S(DOTALL): 点任意匹配模式,改变'.'的行为

- re.L(LOCALE): 使预定字符类 \w \W \b \B \s \S 取决于当前区域设定

- re.U(UNICODE): 使预定字符类 \w \W \b \B \s \S \d \D 取决于unicode定义的字符属性

- re.X(VERBOSE): 详细模式。这个模式下正则表达式可以是多行,忽略空白字符,并可以加入注释。以下两个正则表达式是等价的:

regex_1 = re.compile(r"""\d + # 数字部分

\. # 小数点部分

\d * # 小数的数字部分""", re.X)

regex_2 = re.compile(r"\d+\.\d*")

Match

Match对象是一次匹配的结果,包含了很多关于此次匹配的信息,可以使用Match提供的可读属性或方法来获取这些信息。

match属性:

- string: 匹配时使用的文本。

- re: 匹配时使用的Pattern对象。

- pos: 文本中正则表达式开始搜索的索引。值与Pattern.match()和Pattern.seach()方法的同名参数相同。

- endpos: 文本中正则表达式结束搜索的索引。值与Pattern.match()和Pattern.seach()方法的同名参数相同。

- lastindex: 最后一个被捕获的分组在文本中的索引。如果没有被捕获的分组,将为None。

- lastgroup: 最后一个被捕获的分组的别名。如果这个分组没有别名或者没有被捕获的分组,将为None。

方法:

- group([group1, …]):

获得一个或多个分组截获的字符串;指定多个参数时将以元组形式返回。group1可以使用编号也可以使用别名;编号0代表整个匹配的子串;不填写参数时,返回group(0);没有截获字符串的组返回None;截获了多次的组返回最后一次截获的子串。 - groups([default]):

以元组形式返回全部分组截获的字符串。相当于调用group(1,2,…last)。default表示没有截获字符串的组以这个值替代,默认为None。 - groupdict([default]):

返回以有别名的组的别名为键、以该组截获的子串为值的字典,没有别名的组不包含在内。default含义同上。 - start([group]):

返回指定的组截获的子串在string中的起始索引(子串第一个字符的索引)。group默认值为0。 - end([group]):

返回指定的组截获的子串在string中的结束索引(子串最后一个字符的索引+1)。group默认值为0。 - span([group]):

返回(start(group), end(group))。 - expand(template):

将匹配到的分组代入template中然后返回。template中可以使用\id或\g、\g引用分组,但不能使用编号0。\id与\g是等价的;但\10将被认为是第10个分组,如果你想表达\1之后是字符'0',只能使用\g<1>0。

import re m = re.match(r'(\w+) (\w+)(?P<sign>.*)', 'hello hanxiaoyang!') print "m.string:", m.string print "m.re:", m.re print "m.pos:", m.pos print "m.endpos:", m.endpos print "m.lastindex:", m.lastindex print "m.lastgroup:", m.lastgroup print "m.group(1,2):", m.group(1, 2) print "m.groups():", m.groups() print "m.groupdict():", m.groupdict() print "m.start(2):", m.start(2) print "m.end(2):", m.end(2) print "m.span(2):", m.span(2) print r"m.expand(r'\2 \1\3'):", m.expand(r'\2 \1\3')

m.string: hello hanxiaoyang!

m.re: <_sre.SRE_Pattern object at 0x10b111be0>

m.pos: 0

m.endpos: 18

m.lastindex: 3

m.lastgroup: sign

m.group(1,2): ('hello', 'hanxiaoyang')

m.groups(): ('hello', 'hanxiaoyang', '!')

m.groupdict(): {'sign': '!'}

m.start(2): 6

m.end(2): 17

m.span(2): (6, 17)

m.expand(r'\2 \1\3'): hanxiaoyang hello!

Pattern

Pattern对象是一个编译好的正则表达式,通过Pattern提供的一系列方法可以对文本进行匹配查找。

Pattern不能直接实例化,必须使用re.compile()进行构造。

Pattern提供了几个可读属性用于获取表达式的相关信息:

- pattern: 编译时用的表达式字符串。

- flags: 编译时用的匹配模式。数字形式。

- groups: 表达式中分组的数量。

- groupindex: 以表达式中有别名的组的别名为键、以该组对应的编号为值的字典,没有别名的组不包含在内。

import re p = re.compile(r'(\w+) (\w+)(?P<sign>.*)', re.DOTALL) print "p.pattern:", p.pattern print "p.flags:", p.flags print "p.groups:", p.groups print "p.groupindex:", p.groupindex

p.pattern: (\w+) (\w+)(?P<sign>.*)

p.flags: 16

p.groups: 3

p.groupindex: {'sign': 3}

使用pattern

- match(string[, pos[, endpos]]) | re.match(pattern, string[, flags]):

这个方法将从string的pos下标处起尝试匹配pattern:- 如果pattern结束时仍可匹配,则返回一个Match对象

- 如果匹配过程中pattern无法匹配,或者匹配未结束就已到达endpos,则返回None。

- pos和endpos的默认值分别为0和len(string)。

注意:这个方法并不是完全匹配。当pattern结束时若string还有剩余字符,仍然视为成功。想要完全匹配,可以在表达式末尾加上边界匹配符'$'。

- search(string[, pos[, endpos]]) | re.search(pattern, string[, flags]):

这个方法从string的pos下标处起尝试匹配pattern- 如果pattern结束时仍可匹配,则返回一个Match对象

- 若无法匹配,则将pos加1后重新尝试匹配,直到pos=endpos时仍无法匹配则返回None。

- pos和endpos的默认值分别为0和len(string)

# encoding: UTF-8 import re # 将正则表达式编译成Pattern对象 pattern = re.compile(r'H.*g') # 使用search()查找匹配的子串,不存在能匹配的子串时将返回None # 这个例子中使用match()无法成功匹配 match = pattern.search('hello Hanxiaoyang!') if match: # 使用Match获得分组信息 print match.group()

- split(string[, maxsplit]) | re.split(pattern, string[, maxsplit]):

- 按照能够匹配的子串将string分割后返回列表。

- maxsplit用于指定最大分割次数,不指定将全部分割。

import re p = re.compile(r'\d+') print p.split('one1two2three3four4')

- findall(string[, pos[, endpos]]) | re.findall(pattern, string[, flags]):

import re p = re.compile(r'\d+') print p.findall('one1two2three3four4')

- finditer(string[, pos[, endpos]]) | re.finditer(pattern, string[, flags]):

- 搜索string,返回一个顺序访问每一个匹配结果(Match对象)的迭代器。

import re p = re.compile(r'\d+') for m in p.finditer('one1two2three3four4'): print m.group()

- sub(repl, string[, count]) | re.sub(pattern, repl, string[, count]):

- 使用repl替换string中每一个匹配的子串后返回替换后的字符串。

- 当repl是一个字符串时,可以使用\id或\g、\g引用分组,但不能使用编号0。

- 当repl是一个方法时,这个方法应当只接受一个参数(Match对象),并返回一个字符串用于替换(返回的字符串中不能再引用分组)。 count用于指定最多替换次数,不指定时全部替换。

- 使用repl替换string中每一个匹配的子串后返回替换后的字符串。

import re p = re.compile(r'(\w+) (\w+)') s = 'i say, hello hanxiaoyang!' print p.sub(r'\2 \1', s) def func(m): return m.group(1).title() + ' ' + m.group(2).title() print p.sub(func, s)

- subn(repl, string[, count]) |re.sub(pattern, repl, string[, count]):

- 返回 (sub(repl, string[, count]), 替换次数)。

import re p = re.compile(r'(\w+) (\w+)') s = 'i say, hello hanxiaoyang!' print p.subn(r'\2 \1', s) def func(m): return m.group(1).title() + ' ' + m.group(2).title() print p.subn(func, s)

('say i, hanxiaoyang hello!', 2)

('I Say, Hello Hanxiaoyang!', 2)