第二节课 我们来,开始讲解 requests ,一个灰常牛逼的库,至于urllib2 我门在这里就不讲了,感兴趣的小伙伴可以自找资料

Request 自称是 HTTP for Humans ,这就说明了哈 ,他是非常的方便。

Request 其实底层就是封装的urllib3,它的文档非常的完备,完全可以支持现在的网络需要,可以在python3完运行

Request中文文档 API : 点击打开链接

安装

pip install requests # 好好利用百度,有问题百度

liunx

基本GET请求(headers参数 和 parmas参数)

1. 最基本的GET请求可以直接用get方法

response = requests.get("http://www.baidu.com/")

# 也可以这么写

# response = requests.request("get", "http://www.baidu.com/")

2. 添加 headers 和 查询参数

如果想添加 headers,可以传入headers参数来增加请求头中的headers信息。如果要将参数放在url中传递,可以利用 params 参数

import requests

kw = {'wd':'北京'}

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/54.0.2840.99 Safari/537.36"}

# params 接收一个字典或者字符串的查询参数,字典类型自动转换为url编码,

response = requests.get("http://www.baidu.com/?", params = kw, headers = headers)

# 查看响应内容,response.text 返回的是Unicode格式的数据

print (response.text)

# 查看响应内容,response.content返回的字节流数据

# print (respones.content)

# 查看完整url地址

print(response.url)

# 查看响应头部字符编码

print(response.encoding)

# 查看响应码

print(response.status_code)

第一行代码使我们引入这个类库,你可能会问 kw 和headers 是什么?为什么叫这个? 它是我们访问服务器需要携带的一些参数,就像你向一个朋友发消息问问题。你带着你的问题,说明你是谁,让你朋友知道你想要干什么的。所以我们将这些参数放到我们的请求参数里面去,requests.get()就是指的我们发送的是get请求 ,上节课讲过了呀。外边的名字,至于名字你爱叫什么叫什么,不过是传参数到requests.get(params=xx, header=xx)里面去的时候,你要按照人家的规则来,这也是最基本的哈。至于返回时候response.text 和response.content 有什么区别,简单说,取文本可以用text 取图片视频等我们用content字节流数据

运行结果:

...... ...... 'http://www.baidu.com/s?wd=%E9%95%BF%E5%9F%8E' 'utf-8' 200

基本POST请求(data参数)

2. 传入data数据

对于 POST 请求来说,我们一般需要为它增加一些参数。那么最基本的传参方法可以利用 data 这个参数。

import requests

formdata = {

"type":"AUTO",

"i":"i love python",

"doctype":"json",

"xmlVersion":"1.8",

"keyfrom":"fanyi.web",

"ue":"UTF-8",

"action":"FY_BY_ENTER",

"typoResult":"true"

}

url = "http://fanyi.youdao.com/translate?smartresult=dict&smartresult=rule&smartresult=ugc&sessionFrom=null"

headers={ "User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.103 Safari/537.36"}

response = requests.post(url, data = formdata, headers = headers)

print (response.text)

是不是非常的简单。

代理(proxies参数)

如果需要使用代理,你可以通过为任意请求方法提供 proxies 参数来配置单个请求:

import requests

# 根据协议类型,选择不同的代理

proxies = {"http": "http://xx.xx.xx.xx:1234"}

response = requests.get("http://www.baidu.com", proxies = proxies)

print (response.text)

你可能又要问了,代理ip有什卵用?爬虫是一般是网站最烦的东西了,凭什么你可以随便拿我的数据,对我的服务器增加负载,爬取次数过于频繁的话 对服务器正常运转早成影响。啧啧 这就涉及到了反爬虫,,网站管理人员可能就封你的id禁止你的访问权限,你会说了 老子是爬虫不怕,老哥你还真以为你是爸爸,其实你是粑粑?封了你的ip你就GG,所切换代理或者是使用代理是以中分比较安全的方式,当然了在以后你牛逼了,爬取的数据量上升到几万甚至百万甚至更多的的时候,你可能就用代理IP池。有关于反爬虫的一些常见的反爬虫措施 我们后边的课程中会给大家讲解。 莫妖惊慌。。

私密代理验证

私密代理的使用方法(携带用户名字和密码 )import requests

# 如果代理需要使用HTTP Basic Auth,可以使用下面这种格式:

proxy = { "http": "xxxx:[email protected]:2345" }

response = requests.get("http://www.baidu.com", proxies = proxy)

print (response.text)

Cookies 和 Session

关于cookies 和session 我建议大家去了解一下, 我们只讲解我们能遇到的

cookie是我们访问服务器的时候, 服务器暂时存在我们浏览器的小数据,他可以记录我们的登录状态,请求是否来自于同一个浏览器等

如果一个请求中包含了cookies的话 我们可以这样拿到

import requests

response = requests.get("http://www.baidu.com/")

# 7. 返回CookieJar对象:

cookiejar = response.cookies

# 8. 将CookieJar转为字典:

cookiedict = requests.utils.dict_from_cookiejar(cookiejar)

print (cookiejar)

print (cookiedic)在 requests 里,session对象是一个非常常用的对象,这个对象代表一次用户会话:从客户端浏览器连接服务器开始,到客户端浏览器与服务器断开。会话能让我们在跨请求时候保持某些参数,比如在同一个 Session 实例发出的所有请求之间保持 cookie 。

import requests

# 1. 创建session对象,可以保存Cookie值

ssion = requests.session()

# 2. 处理 headers

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/54.0.2840.99 Safari/537.36"}

# 3. 需要登录的用户名和密码

data = {"email":"[email protected]", "password":"xxxx"}

# 4. 发送附带用户名和密码的请求,并获取登录后的Cookie值,保存在ssion里

ssion.post("http://www.renren.com/PLogin.do", data = data)

# 5. ssion包含用户登录后的Cookie值,可以直接访问那些登录后才可以访问的页面

response = ssion.get("http://www.renren.com/410043129/profile")

# 6. 打印响应内容

print (response.text)

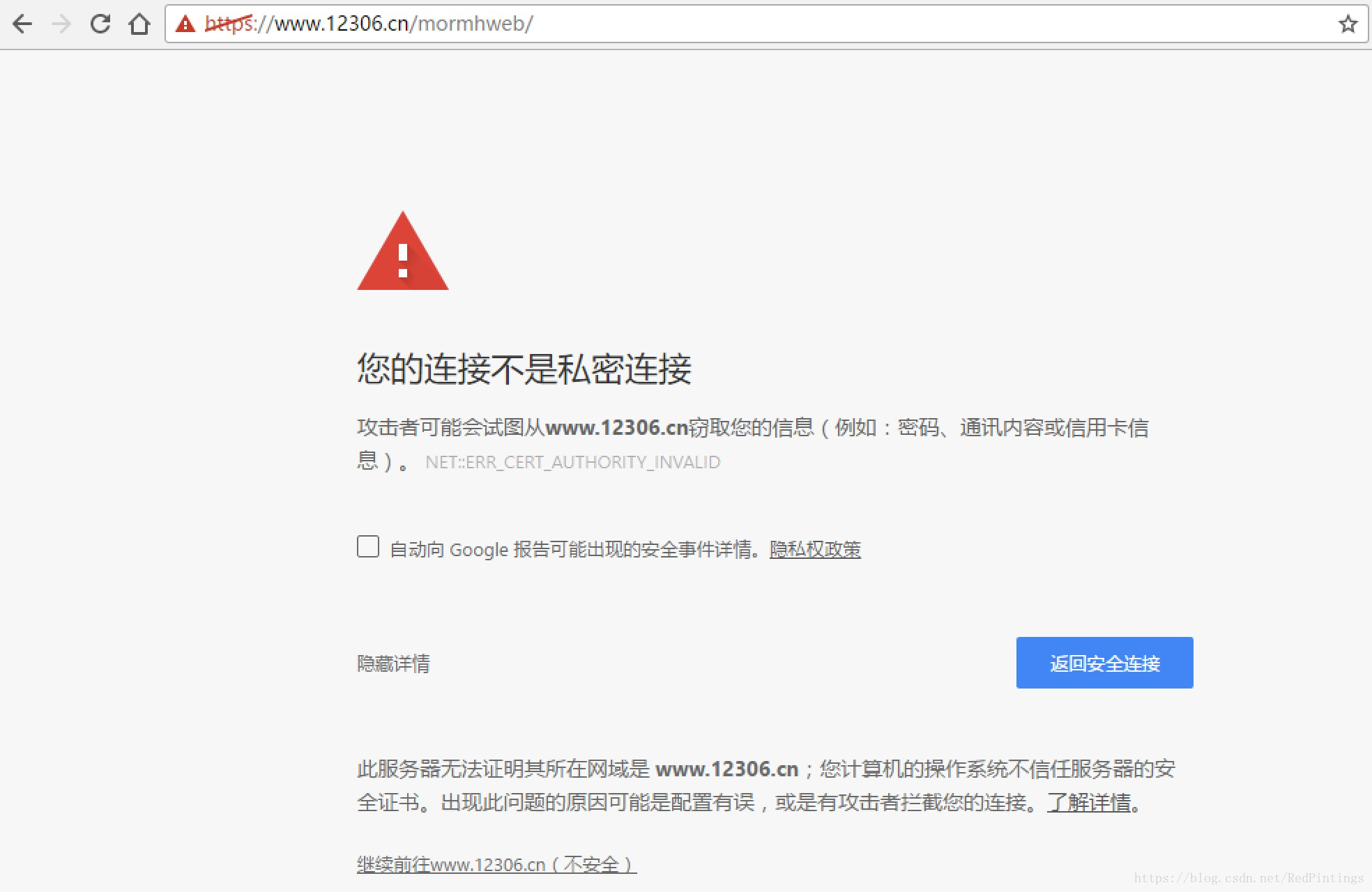

处理HTTPS请求 SSL证书验证

Requests也可以为HTTPS请求验证SSL证书

import requests

response = requests.get("https://www.baidu.com/", verify=True)

# 也可以省略不写

# response = requests.get("https://www.baidu.com/")

print (r.text)

如果SSL证书验证不通过,或者不信任服务器的安全证书,则会报出SSLError

我们来测试一下

import requests

response = requests.get("https://www.12306.cn/mormhweb/")

print (response.text)

SSLError: ("bad handshake: Error([('SSL routines', 'ssl3_get_server_certificate', 'certificate verify failed')],)",)

如果我们想跳过 12306 的证书验证,把 verify 设置为 False 就可以正常请求了

r = requests.get("https://www.12306.cn/mormhweb/", verify = False)

今天我们就先说这些,这些事比较基本的爬虫知识,这里借鉴了别人的一些资料。还是那句话 遇到不懂的,或者是卡住不知道怎么办了,要学会寻找方法,比如博客 ,论坛,百度,谷歌等等,也可以下边留言,我也会尽量帮助大家。