大家好,我是微学AI,今天给大家介绍机器学习实战11-基于K-means算法的文本聚类分析,生成文本聚类后的文件。文本聚类分析是NLP领域的一个核心任务,通过将相似的文本样本分组,可以帮助我们发现隐藏在文本数据中的模式和结构。

在本项目中,我将利用K-means算法实现文本聚类分析。K-means算法是一种常用的聚类算法,它通过迭代地将样本分配到K个簇中,并通过最小化各簇内样本的平方误差之和来确定最佳的簇划分。通过将文本数据转化为向量表示,并利用K-means算法对向量进行聚类,我们可以实现文本的自动分类和分组。

目录

一、引言

二、文本聚类分析的基础知识

三、文本聚类分析项目的设计与实施

四、文本聚类分析实现代码案例

五、文本聚类分析的优缺点与挑战

六、文本聚类分析的未来发展趋势

七、结论

一、引言

文本聚类分析是一种将文本数据进行分类和组织的技术,它通过发现文本之间的相似性和关联性,将相似的文本归为一类。文本聚类在实际应用中具有重要意义,能够帮助我们理解大规模文本数据的结构和内容,从而发现隐藏在其中的信息和模式。

二、文本聚类分析的基础知识

文本聚类是指将文本数据集分成若干个不相交的类别,使得同一类内的文本相似度较高,不同类之间的相似度较低。常用的文本聚类算法包括K-means算法和层次聚类算法。K-means算法通过迭代优化,将文本数据划分为K个簇,每个簇具有相似性;层次聚类算法则通过计算不同文本之间的相似度,逐步合并最相似的文本,直到形成一个完整的聚类树。

在文本聚类中,文本表示是一个关键问题。常用的文本表示方法包括词袋模型和TF-IDF。词袋模型将文本表示为一个向量,其中每个维度表示某个特定词汇在文本中的出现次数;TF-IDF则考虑了词汇的频率和在整个文本集中的重要性。

K-means算法的数学原理可以通过以下公式表示:

给定一个包含n个样本的数据集 X = { x 1 , x 2 , . . . , x n } X=\{x_1, x_2, ..., x_n\} X={ x1,x2,...,xn},其中每个样本 x i x_i xi是一个d维向量 ( x i 1 , x i 2 , . . . , x i d ) (x_{i1}, x_{i2}, ..., x_{id}) (xi1,xi2,...,xid)。K-means算法旨在将这些样本分为K个簇,其中每个样本属于一个且仅属于一个簇。

首先,我们需要选择K个初始聚类中心 μ = { μ 1 , μ 2 , . . . , μ K } \mu=\{\mu_1, \mu_2, ..., \mu_K\} μ={ μ1,μ2,...,μK},其中每个聚类中心是一个d维向量。

然后,算法的迭代过程如下:

- 对于每个样本 x i x_i xi,计算其与各个聚类中心的距离(通常使用欧氏距离或其他距离度量方法),并将其归类到离它最近的聚类中心所对应的簇。

- 对于每个簇,计算其所有样本的平均值作为新的聚类中心。

- 重复步骤1和步骤2,直到满足停止条件(例如,达到最大迭代次数或聚类中心不再发生明显变化)。

K-means算法的优化目标是最小化所有样本与其所属簇中心的距离之和,也就是最小化以下目标函数:

J = ∑ i = 1 n ∑ j = 1 K r i j ∣ ∣ x i − μ j ∣ ∣ 2 J = \sum_{i=1}^{n} \sum_{j=1}^{K} r_{ij} ||x_i - \mu_j||^2 J=i=1∑nj=1∑Krij∣∣xi−μj∣∣2

其中, r i j r_{ij} rij表示样本 x i x_i xi归属于簇 j j j的指示变量,若 x i x_i xi属于簇 j j j则 r i j = 1 r_{ij}=1 rij=1,否则 r i j = 0 r_{ij}=0 rij=0。

通过迭代的优化过程,K-means算法将不断更新聚类中心,直到找到一组使目标函数 J J J最小化的最终聚类结果。

需要注意的是,K-means算法对于不同的初始聚类中心选择可能收敛到不同的局部最优解。为了克服这个问题,可以使用多次运行或其他启发式方法来改善聚类结果。

三、文本聚类分析项目的设计与实施

在进行文本聚类分析项目时,首先需要进行数据收集与预处理。数据可以来自各种渠道,如新闻报道、社交媒体等,但需要进行清洗和去除噪声。接下来是文本特征提取与表示,可以使用词袋模型或TF-IDF方法将文本转化为向量表示。然后需要选择适合的聚类算法,并进行参数调优。最后,对聚类结果进行评估指标和可视化展示,以便更好地理解和解释聚类结果。

四、文本聚类分析实现代码案例

这里可以给出一个具体的文本聚类分析实现代码案例,例如使用Python语言和scikit-learn库实现K-means聚类算法,将新闻文本数据集进行聚类。

#coding utf-8

import csv

import jieba

from sklearn.cluster import KMeans

from sklearn.feature_extraction.text import TfidfVectorizer

import pandas as pd

import os

import re

from sklearn.decomposition import PCA

import matplotlib.pyplot as plt

# 对中文文本进行分词

def tokenize_text(text):

return " ".join(jieba.cut(text))

# 去除标点符号

def remove_punctuation(text):

punctuation = '!"#,。、$%&\'()*+,-./:;<=>?@[\\]^_`{|}~'

text = re.sub(r'[{}]+'.format(punctuation), '', text)

return text

# 将分词后的文本转化为tf-idf矩阵

def text_to_tfidf_matrix(texts):

tokenized_texts = [tokenize_text(remove_punctuation(text)) for text in texts]

vectorizer = TfidfVectorizer()

tfidf_matrix = vectorizer.fit_transform(tokenized_texts)

return tfidf_matrix

# 聚类函数

def cluster_texts(tfidf_matrix, n_clusters):

kmeans = KMeans(n_clusters=n_clusters)

kmeans.fit(tfidf_matrix)

return kmeans.labels_

# 保存聚类结果到新的CSV文件

def save_clusters_to_csv(filename, texts, labels):

base_filename, ext = os.path.splitext(filename)

output_filename = f"{base_filename}_clusters{ext}"

with open(output_filename, "w", encoding="utf-8", newline="") as csvfile:

csvwriter = csv.writer(csvfile)

for text, label in zip(texts, labels):

csvwriter.writerow([text, label])

return output_filename

# 输出聚类结果

def print_cluster_result(texts, labels):

clusters = {

}

for i, label in enumerate(labels):

if label not in clusters:

clusters[label] = []

clusters[label].append(texts[i])

for label, text_list in clusters.items():

print(f"Cluster {label}:")

for text in text_list:

print(f" {text}")

def text_KMeans(filename,n_clusters):

df = pd.read_csv(filename, encoding='utf-8') # 读取csv文件

texts = df['text'].tolist() # 提取文本数据为列表格

print(df.iloc[:, [0, -1]])

# 将文本转化为tf-idf矩阵

tfidf_matrix = text_to_tfidf_matrix(texts)

# 进行聚类

labels = cluster_texts(tfidf_matrix, n_clusters)

clusters = []

for i, label in enumerate(labels):

clusters.append(label)

df['cluster'] = clusters

output = 'data_clustered.csv'

df.to_csv('data_clustered.csv', index=False, encoding='utf-8')

return output,labels,tfidf_matrix

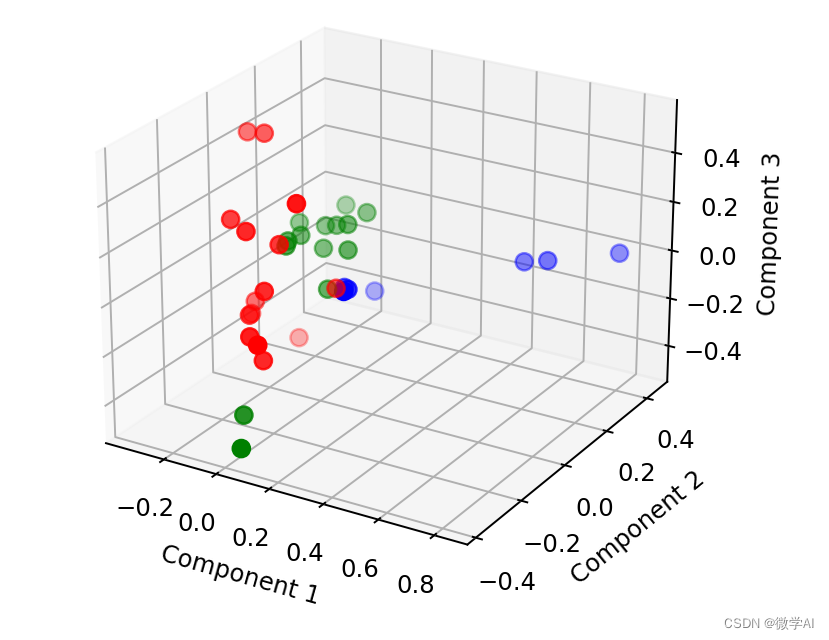

def pca_picture(labels,tfidf_matrix):

# 进行降维操作并将结果保存到DataFrame中

pca = PCA(n_components=3)

result = pca.fit_transform(tfidf_matrix.toarray())

result_df = pd.DataFrame(result, columns=['Component1', 'Component2', 'Component3'])

# 将聚类结果添加到DataFrame中

result_df['cluster'] = labels

# 绘制聚类图形

fig = plt.figure()

ax = fig.add_subplot(111, projection='3d')

colors = ['red', 'blue', 'green']

for i in range(3):

subset = result_df[result_df['cluster'] == i]

ax.scatter(subset['Component1'], subset['Component2'], subset['Component3'], color=colors[i], s=50)

ax.set_xlabel("Component 1")

ax.set_ylabel("Component 2")

ax.set_zlabel("Component 3")

plt.show()

if __name__ == "__main__":

# 加载中文文本

filename = "data.csv"

n_clusters =3

output,labels,tfidf_matrix = text_KMeans(filename, n_clusters)

pca_picture(labels, tfidf_matrix)

运行利用PCA算法生成3D图像:

五、文本聚类分析的优缺点与挑战

文本聚类分析具有以下优点:能够提供洞察力,帮助我们了解文本数据的结构和内容;能够实现自动化聚类,减少人工干预;能够高效处理大规模数据,加快分析速度。

然而,文本聚类也存在一些缺点:由于聚类是基于相似性的,因此对于主观性较强的文本数据,可能会出现分类不准确的情况;聚类算法通常需要标注数据进行训练和调优,这在某些场景下可能难以获取;处理噪声和冗余信息也是一个挑战。

此外,文本聚类还面临一些挑战:高维度问题,即当文本特征维度较高时,聚类结果可能不准确或难以解释;语义相似性问题,由于自然语言的复杂性,文本之间的语义相似性难以捕捉;类别不平衡问题,即不同类别的文本样本数量差异较大,可能影响聚类的效果。

六、文本聚类分析的未来发展趋势

未来,文本聚类分析可能朝着以下方向发展:(可以提出一些观点,如结合深度学习方法改进文本特征表示、应用领域的拓展等)

七、结论

文本聚类分析是一种重要的技术,能够帮助我们理解和组织大规模文本数据。通过选择合适的算法和特征表示方法,并克服相关挑战,我们可以获得准确和可解释的聚类结果。随着技术的不断进步,文本聚类分析在各个领域都有着广泛的应用前景。