接上文: 【NLP】多头注意力概念(01)

五、计算注意力

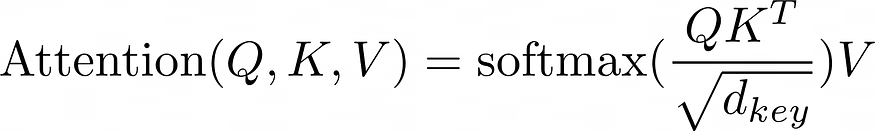

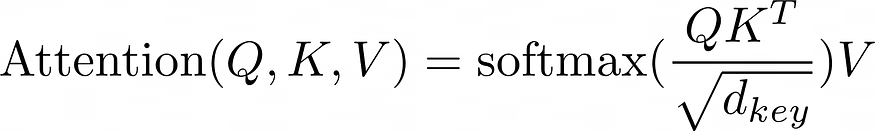

将 Q、K 和 V 拆分为它们的头部后,现在可以计算 Q 和 K 的缩放点积。上面的等式表明,第一步是执行张量乘法。但是,必须先转置 K。

展望未来,每个张量的seq_length形状将通过其各自的张量来识别,以确保清晰度、Q_length、K_length或V_length:

- Q 的形状为 (batch_size、n_heads、Q_length、d_key)

接上文: 【NLP】多头注意力概念(01)

将 Q、K 和 V 拆分为它们的头部后,现在可以计算 Q 和 K 的缩放点积。上面的等式表明,第一步是执行张量乘法。但是,必须先转置 K。

展望未来,每个张量的seq_length形状将通过其各自的张量来识别,以确保清晰度、Q_length、K_length或V_length: