LSTM

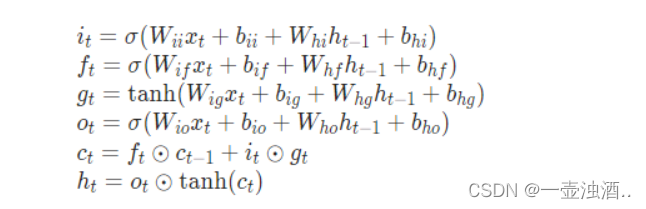

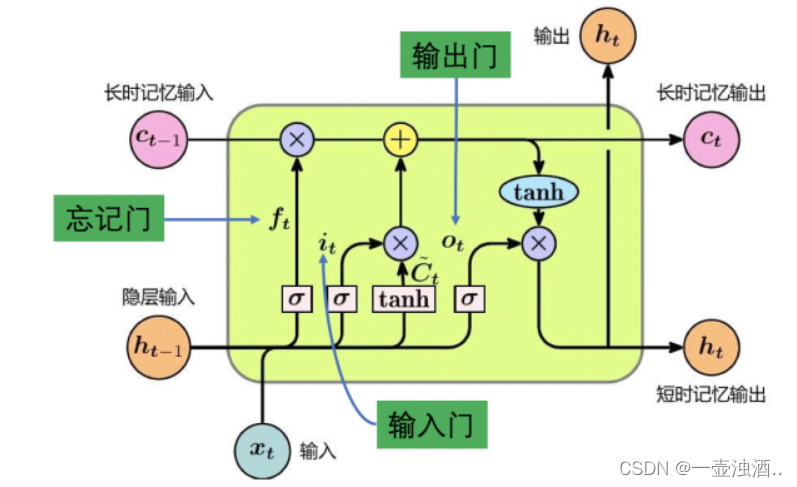

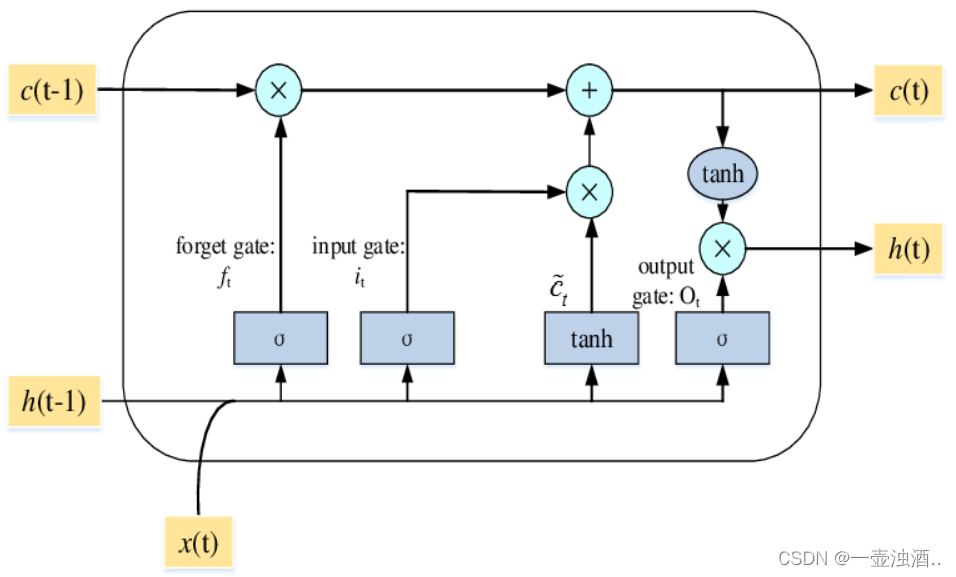

ft表示 遗忘门。LSTM对于每一次的输入,首先决定遗忘掉之前的哪些记忆。将ft和t-1时刻的细胞状态相乘,得出将遗忘哪些记忆。

记忆门 是用来控制是否将t时刻的数据并入细胞状态。tanh函数可以将此刻向量中的有效信息提取出来,为gt。sigmoid函数用于控制此刻多少记忆进入细胞状态,输出为it。

输出门会先将当前输入值与上一时刻输出值整合后的向量,用sigmoid函数提取其中的信息,接着,会将当前的单元状态通过tanh函数压缩映射到区间(-1, 1)。

LSTM - 长短期记忆递归神经网络 - 知乎 (zhihu.com)

单层LSTM

import torch

import torch.nn as nn

lstm = nn.LSTM(input_size=100, hidden_size=20, num_layers=1)

print(lstm)

print(lstm._p