文章目录

摘要

论文链接:https://arxiv.org/pdf/2306.01567v1.pdf

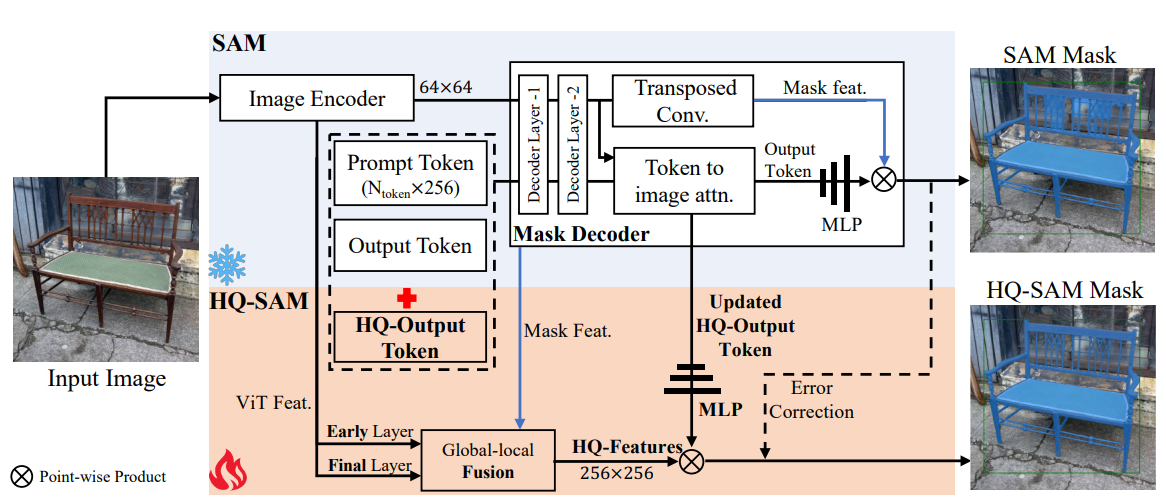

最近的分割一切模型(SAM)代表了分割模型的一个巨大飞跃,允许强大的零样本能力和灵活的提示。尽管使用了11亿个掩模进行训练,但SAM的掩模预测质量在许多情况下都存在不足,特别是在处理结构复杂的物体时。我们提出 HQ-SAM,使SAM具备准确分割一切目标的能力,同时保持SAM原有的提示设计、效率和零样本通用性。我们的精心设计重用并保留了SAM的预训练模型权重,同时只引入了最小的额外参数和计算。我们设计了一个可学习的高质量输出Token,它被注入到SAM的掩码解码器中,负责预测高质量的掩码。而不是只应用它的掩码解码器功能,我们首先融合了早期和最终的ViT功能,以改善掩码细节。为了训练我们引入的可学习参数,我们从几个来源组成了一个由44K个细粒度掩码组成的数据集。HQ-SAM只在引入的44,000个掩码的数据集上进行训练,在8个GPU上只需要4小时。我们展示了HQ-SAM在跨不同下游任务的9个不同分割数据集中的有效性,其中7个在零样本迁移进行了评估。我们的代码和模型将在https://github.com/SysCV/SAM-HQ上发布。

1、介绍

不同对象的准确分割是广泛的场景理解应用的基础,包括图像/视频编辑,机器人感知和AR/VR。经过十亿级掩模标签训练的SAM (Segment Anything Model)[21]是最近发布的一种用于一般图像分割的基础视觉模型。通过采用由点、边界框或粗掩码组成的提示作为输入,SAM能够在不同的场景中分割各种各样的对象、部件和视觉结构。它的零样本分割能力导致了快速的范式转换,因为它可以通过简单的提示转移到许多应用程序。

虽然SAM取得了令人印象深刻的性能,但在许多情况下,它的分割结果仍然令人不满意。特别是,SAM存在两个关键问题:1)粗糙的掩模边界,甚至经常忽略薄目标结构的分割,如图1所示。2)预测不正确,面具破损,或在具有挑战性的情况下出现重大错误。这通常与SAM误解薄结构有关,例如图1中最右边一栏中的风筝线。这些类型的故障严重限制了基本分割模型(如SAM)的适用性和有效性,特别是对于自动注释和图像/视频编辑任务,其中高度精确的图像蒙版至关重要。

我们提出HQ-SAM,即使在非常具有挑战性的情况下(见图1),它也可以预测高度准确的分割掩码,而不会损害原始SAM的强大零样本能力和灵活性。为了保持效率和零样本性能,我们提出了最小的SAM适应性,添加少于0.5%的参数,以扩展其高质量分割的能力。

图1:给定相同的红色框或物体上的几个点作为输入提示,SAM与我们的HQ-SAM的预测掩模。HQ-SAM产生的结果更加详细,边界非常精确。在最右边的一栏中,SAM错误地解释了风筝线的薄结构,并产生了很大一部分输入框提示的错误。

直接对SAM解码器进行微调或引入新的解码器模块会严重降低一般的零采样分割性能。因此,我们提出了一种与已有的SAM结构紧密集成和重用的HQ-SAM结构,以充分保持零样本性能。首先,我们设计了一个可学习的高质量输出Token,它与原始的提示和输出Token一起输入到SAM的掩码解码器。与原始输出Token不同,我们的高质量输出Token及其相关的MLP层经过训练以预测高质量的分割掩码。其次,我们的高质量输出Token不是只重用SAM的掩码解码器功能,而是在一个精炼的功能集上运行,以实现准确的掩码细节。特别是,我们通过将SAM的掩码解码器特征与ViT编码器的早期和晚期特征映射融合在一起,同时使用了全局语义上下文和局部细粒度特征。在训练期间,我们冻结了整个预训练的SAM参数,同时只更新我们的高质量输出 Token,其相关的三层mlp和一个小的特征融合块。

学习准确的分割需要一个具有复杂和详细几何形状的不同对象的准确掩码注释的数据集。SAM是在SA-1B数据集上训练的,SA-1B数据集包含1100万张图像和11亿个掩码,这些图像是由类似SAM的模型自动生成的。然而,使用这个广泛的数据集会带来巨大的成本影响,并且无法实现我们工作中所追求的高质量掩模代,如图1中SAM的性能所示。因此,我们组成了一个新的数据集,称为HQSeg-44K,它包含44K极细粒度的图像掩码注释。HQSeg-44K是通过将现有的6个图像数据集[34,29,26,37,8,45]与高精度的掩码注释合并而成的,涵盖了1000多个不同的语义类。由于规模较小的数据集和我们最小的集成架构,HQ-SAM可以在8个RTX 3090 gpu上仅需4小时即可完成训练。

为了验证HQ-SAM的有效性,我们进行了广泛的定量和定性实验分析。我们将HQ-SAM与SAM在不同下游任务的9个不同分割数据集上进行比较,其中7个数据集采用零样本传输协议,包括COCO[31]、UVO[41]、LVIS[14]、HQ- ytvis[20]、BIG[6]、COIFT[29]和HR-SOD[50]。这一严格的评估表明,与SAM相比,所提出的HQ-SAM可以在保持零样本能力的同时产生更高质量的掩模。

2、相关工作

高质量的分割。现有的高质量分割工作大多是针对特定分割任务进行训练的,如图像和视频实例分割[22,19,20,39,43],语义分割[30,52,38,49]或全景分割[9],在封闭世界范式中。其中一些专注于使用图形模型(如CRF[23]或区域生长[10])进行分割后的细化。然而,基于crf的细化只遵循低层颜色边界,没有充分利用高层语义上下文,不能解决较大的分割错误。。虽然一些基于细化的作品采用单独的深度网络进行级联迭代细化[6,36],但我们的实验表明,它们容易出现过拟合。与这些高质量的分割[19,22,32]或分割细化方法相比,我们专注于在灵活提示的情况下,在新数据上准确分割不同的对象,并构建了一个高质量的零采样分割模型,该模型可以推广到各种分割任务和领域。与分割后的细化工作不同[6,36],为了保持SAM的零镜头分割能力,HQ-SAM不是将粗掩码和图像作为输入,再送入单独的细化网络,而是直接通过重用SAM的图像编码器和掩码解码器来预测新的高质量掩码。HQ-SAM的模型架构建立在SAM的基础上,开销可以忽略不计,其中我们提出了有效的Token学习以实现准确的掩码预测。这与以前的高质量分割作品完全不同,我们在广泛的零样本实验中展示了它的有效性。

基础模型的微调和提示调优。基础模型[2,1]首次出现在NLP社区,其中GPT系列[2]等大型语言模型对未见任务和数据显示出强大的零样本泛化能力。然后,提出了一些基于提示的学习工作[16,27,17],以帮助这些预训练模型泛化到下游任务,而不是微调模型内部参数[15],以更好地迁移学习。对于基于视觉的基础模型[21,42,56],冻结预训练模型的prompt engineering[54,44,48,55]首先在视觉-语言模型中进行了探索,如CLIP[35]。这些具有可学习参数的提示,旨在帮助下游任务进行更好的上下文优化。与现有的基于提示或微调的工作不同,本文专注于SAM对高质量分割的最小自适应。直接使用所提出的高质量输出 Token输出来进行准确的掩码预测,而不是仅利用一些可学习参数[54]来帮助上下文学习和更好的泛化。

3、方法

本文提出HQ-SAM对SAM进行升级,以获得高质量的零样本分割。HQ-SAM是轻量级的,只引入了两个重要的适应性SAM模型。在3.1节中,我们首先简要回顾了构建HQ-SAM的SAM体系结构。在第3.2节中,提出了具有高质量Token (高质量输出 Token)和全局-局部特征融合的HQ-SAM,这是在保持其零样本能力的同时实现更好的SAM分割质量的关键组件。最后,在3.3节中,我们描述了HQ-SAM的训练和推理过程,该过程在数据和计算上都是高效的。

3.1、预备知识:SAM

SAM[21]由三个模块组成:(a)图像编码器:一个基于vit的图像特征提取主干,从而在空间大小上进行图像嵌入64×64。(b)提示编码器:对输入点/框/掩码的交互式位置信息进行编码,以提供掩码解码器。©掩码解码器:一个基于transformer的两层解码器将提取的图像嵌入和连接的输出以及提示Token用于最终的掩码预测。发布的SAM模型在大规模SA-1B数据集上进行训练,该数据集包含超过10亿自动生成的掩码(比任何现有的分割数据集[14,24]多400倍的掩码)和1100万张图像。因此,SAM在不需要额外训练的情况下,对新数据显示出有价值的强零样本泛化。然而,SAM训练是非常昂贵的,其中在SA-1B上分布式训练基于vit - h的SAM 2 epoch需要256个gpu, batch大小为256张图像。要了解更多SAM方法的细节,请参考[21]。

3.2、我们的:HQ-SAM

在本节中,我们将描述HQ-SAM网络的体系结构。为保持SAM的零样本迁移能力,同时防止模型过拟合或灾难性遗忘,而不是直接微调SAM或添加新的重型解码器网络,尽可能采取最小的自适应方法。为此,HQ-SAM尽可能地重用SAM预训练好的模型权重,只增加了两个新的关键组件,即高质量输出Token和全局-局部特征融合,如图2所示。因此,HQ-SAM可以被认为是由SAM演化而来的高质量零样本分割模型,其额外的模型参数和计算开销可以忽略不计。

3.2.1、高质量输出Token

本文提出高效的Token学习来提高SAM的掩码质量。如图2所示,在SAM原始的掩码解码器设计中,采用输出Token(类似于DETR[3]中的对象查询)进行掩码预测,预测动态MLP权重,然后与掩码特征进行点积。为了提升HQ-SAM中SAM的掩码质量,引入高质量输出 Token和一个新的掩码预测层来进行高质量的掩码预测,而不是直接将SAM的粗糙掩码作为输入。

在图2中,通过重用和修复SAM的掩码解码器,一个新的可学习的高质量输出Token(大小为1×256)与SAM的输出Token(大小为4×256)和提示Token(大小为 N p r o m p t N_{prompt} Nprompt×256)连接起来,作为SAM的掩码解码器的输入。与原始输出Token相似,在每个注意力层中,高质量输出Token首先对其他Token进行自注意力,然后进行Token到图像和反向图像到Token的注意力以进行特征更新。请注意,高质量输出Token使用由每个解码器层中的其他Token共享的逐点MLP。更新后的高质量输出 Token在经过两层解码器后,可以访问全局图像上下文、提示Token的关键几何/类型信息以及其他输出Token的隐藏掩码信息。添加了一个新的三层MLP来从更新的高质量输出 Token中生成动态卷积核,然后与融合的hq -特征进行空间逐点积,以生成高质量的掩码。

我们只允许对高质量输出 Token及其相关的三层mlp进行训练,以纠正SAM输出Token的掩码错误,而不是直接微调SAM或进一步添加一个繁重的后细化网络。这与现有的高质量分割模型完全不同[19,6,20,22]。通过广泛实验确定了高效Token学习的两个主要优势:1)该策略显著提高了SAM的掩码质量,而与原始SAM相比只引入了微不足道的参数,使HQ-SAM训练极其耗时和数据高效;2)学习到的Token和MLP层不会过拟合来掩盖特定数据集的标注偏差,从而保持SAM对新图像的强大零样本分割能力,而不会出现灾难性的知识遗忘。

3.2.2、高质量特征的全局-局部融合

非常精确的分割还需要输入既具有丰富的全局语义上下文又具有局部边界细节的图像特征。为了进一步提高掩模质量,在SAM掩模解码器特征中同时丰富高层物体上下文信息和低层边界/边缘信息。本文不直接使用SAM的mask decoder特征,而是通过提取和融合SAM模型不同阶段的特征,构成新的高质量特征(HQFeatures): 1)带有空间形状的SAM的ViT编码器的早期层局部特征64×64,它捕获了更一般的图像边缘/边界细节[12]。在ViT编码器的第一个全局注意力块之后提取特征,对于基于ViT- large的SAM,这是总共24个块的第6个块输出;2)最后一层采用形状64×64的SAM’s ViT编码器的全局特征,具有更多的全局图像上下文信息;3)大小为256×256的SAM掩码解码器中的掩码特征,也由输出Token共享,包含强大的掩码形状信息。

如图2所示,为了获得输入的HQ-Features,我们首先通过转置卷积将早期层和最终层编码器特征上采样到空间大小256×256。然后,经过简单的卷积处理后,以元素的方式总结这三种类型的特征。这种全局-局部特征融合既简单又有效,以较小的内存占用和计算负担产生了保持细节的分割结果。在实验部分,我们还对每个特征源的影响进行了详细的消融(表3)。

3.3、HQ-SAM的训练和推理

训练数据构造。为了以数据高效的方式训练HQ-SAM,而不是在SA-1B[21]上进一步训练,本文构建了一个新的训练数据集HQSeg-44K,其中包含44320个极其精确的图像掩模标注。发布的SA-1B数据集只包含自动生成的掩码标签,缺少对具有复杂结构的物体的非常准确的人工标注。由于标注困难,HQSeg-44K利用了6个现有的图像数据集,包括DIS34、ThinObject-5K29、FSS-1000[26]、ECSSD[37]、MSRA10K[8]、DUT-OMRON[45],并进行了极细粒度的掩码标注,其中每个数据集平均包含7.4K的掩码标签。为了使HQ-SAM对新数据具有鲁棒性和泛化性,HQSeg-44K包含了超过1000个不同的语义类别。在补充分析中,通过将HQ-SAM训练与SA-1B[21]的44K随机采样图像和掩码进行比较,展示了使用HQSeg-44K的优势。

HQ-SAM训练。在训练过程中,固定预训练SAM模型的模型参数,仅使提出的HQ-SAM可学习。因此,可学习参数只包括高质量输出 Token,其相关的三层MLP和三个用于hq -特征融合的简单卷积。由于SAM是为灵活的分割提示而设计的,通过对包括边界框、随机采样点和粗掩码输入在内的混合类型提示进行采样来训练HQ-SAM。通过在GT掩码的边界区域添加随机高斯噪声来生成这些退化掩码。为了对不同对象尺度的泛化能力,我们使用大规模抖动[13]。我们使用学习率0.001并训练HQ-SAM 12个epoch,学习率在10 epoch后下降。我们在8个Nvidia GeForce RTX 3090 gpu上进行训练,总批处理大小为32,训练16.6K迭代耗时4小时。详情请参阅我们的补充文件。

HQ-SAM推理。我们遵循与SAM相同的推理流水线,但使用高质量输出 Token的掩码预测作为高质量的掩码预测。在推理过程中,我们对SAM掩码(通过输出Token)和我们的预测掩码(通过hq -输出Token)的预测logits进行求和,以根据空间分辨率进行掩码校正256×256。然后,我们将校正后的掩模向上采样到原始分辨率1024×1024作为输出。

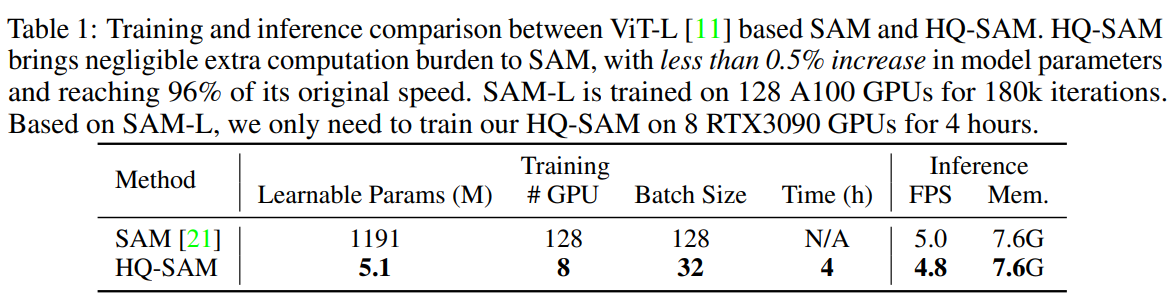

SAM和HQ-SAM的训练和推理。在表1中,我们报告了HQ-SAM和SAM之间详细的训练和推断比较。虽然HQ-SAM产生了明显更好的分割质量,但它的训练非常快速和负担得起,使用8个RTX3090 gpu只需要4个小时。HQ-SAM还轻量级和高效,模型参数、GPU内存使用和每张图像的推理时间的增加可以忽略不计。

4、实验

4.1、实验设置

数据集。我们使用编译后的HQSeg-44K进行训练,如3.3节所述。为了全面评估HQ-SAM的分割性能,我们在广泛的数据集上进行了实验,包括四个极细粒度的分割数据集:DIS34、ThinObject-5K29、COIFT[29]和HR-SOD[50]。在各种基于图像/视频的分割任务中,在零样本设置下对流行和具有挑战性的基准进行了实验,如COCO[31]、UVO[41]、LVIS[14]、HQ-YTVIS[20]和BIG[6]。

评价指标。为了准确量化掩码质量的改进,采用边界度量mBIoU和边界APB[5],而不是仅采用标准的掩码AP或掩码mIoU。我们还通过调整UVO[41]和LVIS[14]上的默认扩张率从0.02到0.01来评估更严格的APstrict B。为了在四个细粒度分割数据集[34,29,50]上进行评估,我们还报告了其中的平均边界和掩码IoU。在HQ-YTVIS[20]上的视频实例分割实验中,我们同时使用了管边界APB和管掩膜APM。

4.2、消融实验

对所提出的HQ-SAM进行了详细的消融研究,使用ViT-Large作为骨干,分析了所提出的高质量输出 Token和HQ-Features对分割质量的影响,特别是在零样本情况下。在消融实验中,我们使用了上述四个极其精确的分割数据集,即DIS (val)[34]、ThinObject-5K (test)[29]、COIFT[29]和hr - sod[50]以及COCO验证集。

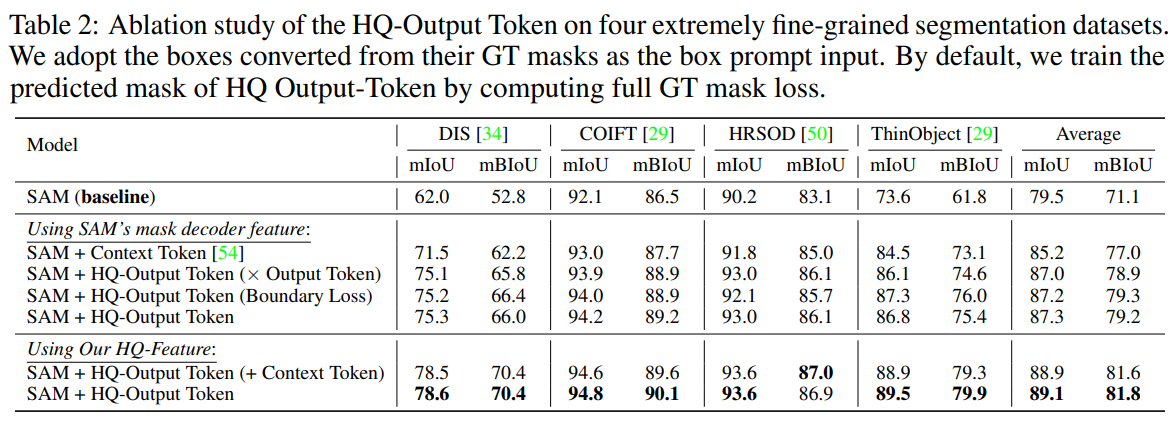

高质量输出Token的效果。HQ-SAM利用高质量输出 Token进行高质量的掩码预测。表2将我们的高质量输出Token与基线SAM和其他现有的提示/Token学习策略进行了比较,例如将额外的三个上下文Token[54]作为可学习向量添加到SAM的掩码解码器中,以更好地进行上下文学习。与使用上下文Token相比,高质量输出Token在四个高质量数据集上始终带来更大的性能提升,在DIS上达到13.2 mBIoU,在COIFT数据集上达到2.7 mBIoU。还进行了其他消融实验变体,如计算原始SAM的输出Token和高质量输出 Token之间的缩放点积[18],或将掩码损失限制在边界区域内,发现它们略微降低了在四个评估数据集上的平均性能。与SAM相比,HQ-SAM在DIS数据集上的mBIoU从52.8提升到70.4,在HRSOD数据集上的mBIoU提升了3.8点。

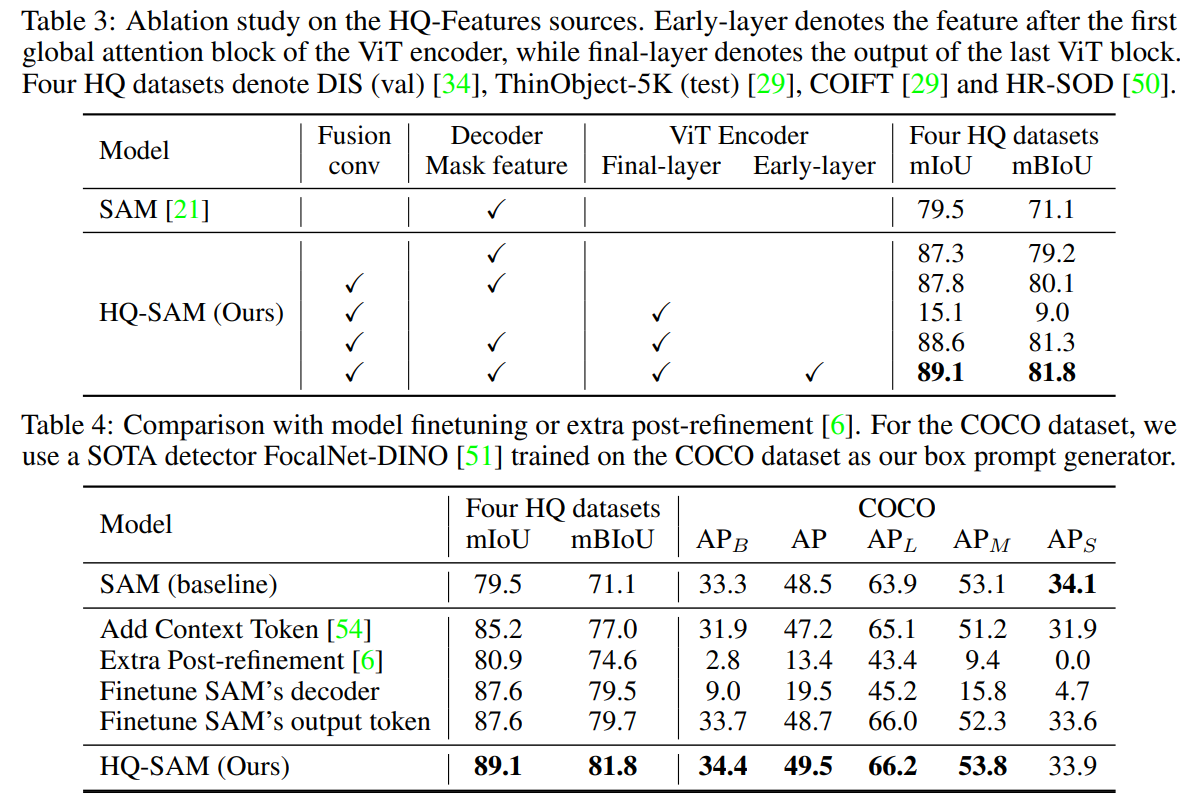

消融高质量特征的全局-局部融合。表3列出了全局-局部融合的效果,其中分析了在融合过程中HQ-Features中每个特征分量的重要性。与直接使用SAM的mask decoder特征相比,整个HQ特征在4个高精度分割数据集上带来了2.6 mBIoU的明显优势。具有全局上下文的最后一层ViT编码器特征将mBIoU从80.1提高到81.3。而具有局部细节的早期层功能进一步将mBIoU提升到81.8。

与SAM微调或细化后的比较。在表4中,将高效的Token自适应策略与添加额外的后细化网络[6]和模型微调进行了比较,包括直接微调SAM的掩码解码器或仅微调其输出Token以进行掩码预测。添加一个额外的重的后优化网络在四个HQ数据集上带来的平均性能提升有限,但在COCO上的性能非常差,这表明存在强烈的过拟合。在直接微调SAM的掩码解码器时,也观察到类似的现象。只有对SAM的输出Token进行微调,才能解决灾难性的遗忘问题,并在四个HQ数据集和COCO上进行改进。然而,与我们的改进相比,增量改进仍然小得多。HQ-SAM在COCO上提高了1.1 APB,而输出Token微调仅提高了0.4 APB。这表明HQ-SAM在保持SAM零样本能力的同时,在数据高效学习方面具有优势。

不同BIoU阈值下的准确性分析。图3比较了从宽松到严格BIoU阈值的SAM和HQ-SAM。我们绘制了BIoU大于x轴上指示的阈值的掩码预测的百分比。COIFT[29]和HRSOD[50]上严格的IoU阈值所带来的巨大性能差距,清楚地验证了HQ-SAM在预测非常准确的掩模方面的优势。然而,即使在0.5的宽松阈值下,HQ-SAM将SAM对COIFT和HRSOD的错误预测数量分别减少了81%和69%。这表明,在具有挑战性的情况下,HQ-SAM预测不仅大大提高了准确性,而且更具鲁棒性。

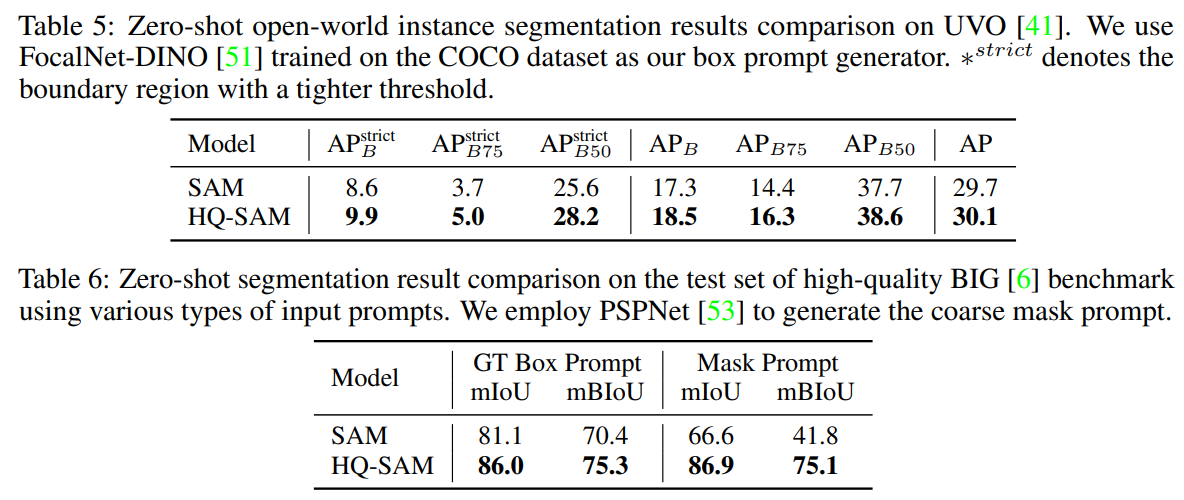

零样本开放世界分割。为了评估开放世界环境中的零样本分割结果,在表5中,我们在具有挑战性的UVO[41]基准上比较了SAM和我们的HQ-SAM,具有多样化和密集的对象掩码注释。通过使用相同的预训练目标检测器[51]作为框提示输入,HQ-SAM比SAM提高了1.3 A P B s t r i c t AP^{strict}_{B} APBstrict和2.6 A P B 50 s t r i c t AP^{strict}_{B50} APB50strict。

高分辨率大数据集的零样本分割。在表6中,我们比较了SAM和HQ-SAM在高分辨率大基准[6]上的零样本分割质量,包括使用GT对象框或提供的粗糙掩码输入。HQ-SAM始终优于SAM,在不同类型的提示下具有明显的优势,并且对具有部分边界误差的粗糙掩码提示具有更强的鲁棒性(PSPNet[53]提供)。

4.3、与SAM的零样本比较

在7个基准上对HQ-SAM和SAM进行了广泛的零样本迁移比较,包括COCO[31]、UVO[41]、LVIS[14]、HQ-YTVIS[20]、BIG[6]、COIFT[29]和HR-SOD[50],其中HQ-SAM优于没有铃和哨子的SAM,证明了其有效性,即使在小规模数据集训练下也保持了泛化能力。

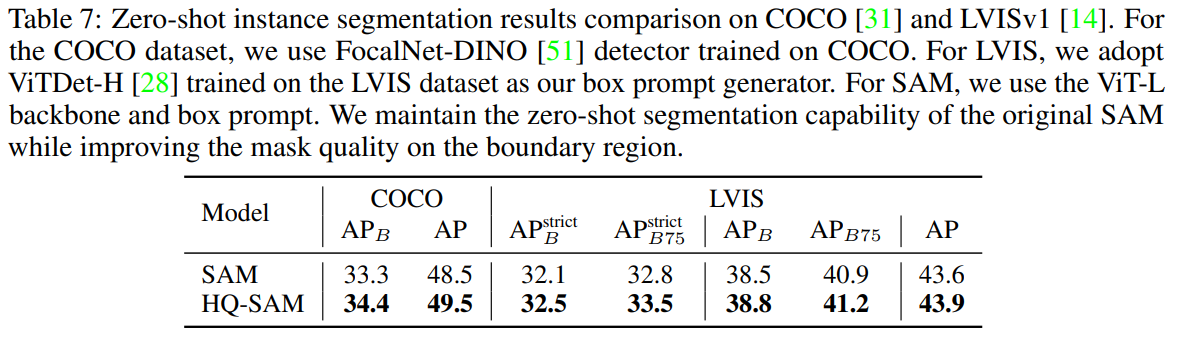

零样本实例分割。在表7中的COCO和LVIS上,我们还通过这两个数据集的训练检测器生成的馈线框提示,分别在流行的COCO和LVIS基准上评估了HQ-SAM。在COCO和LVIS数据集上,HQ-SAM均优于SAM 1.1 APB和0.7 APstrict B75,表明在训练过程中,HQ-SAM提高了掩模质量,并保持了良好的零样本分割能力。

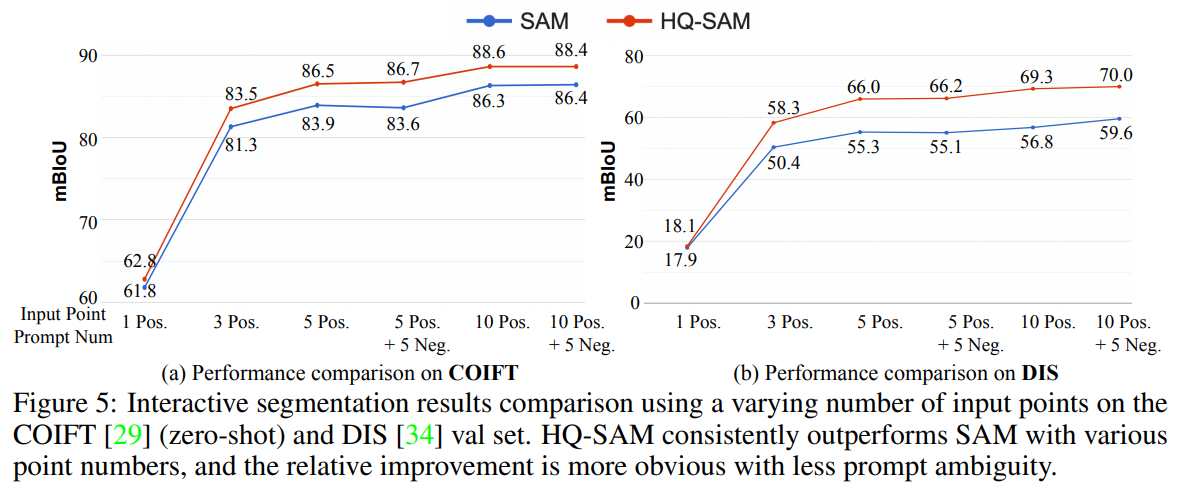

基于点的交互式分割比较。为了研究交互式点提示下HQ-SAM的分割性能,在图5中,我们将HQ-SAM与不同数量输入点的SAM在COIFT [29] (zero-shot)和DIS [34] val集上进行了比较。在两个数据集上,HQ-SAM在不同的点提示下始终优于SAM。我们注意到,当提示包含更少的对象歧义和更多的输入点信息时(从1个积极点增加到10个积极点+ 5个消极点),相对性能的提升更显著。

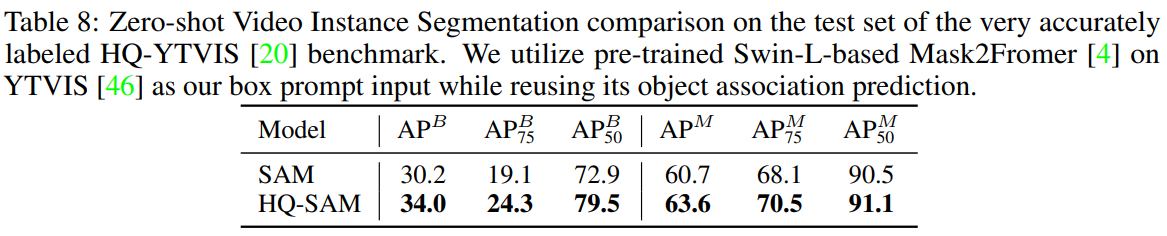

零样本高质量视频实例分割。除了进行基于图像的分割评估,还在精确标注的HQ-YTVIS基准数据集[20]上进行了视频实例分割结果对比。将预训练的Mask2Former[4]作为视频框的提示,并将其输入SAM和HQ-SAM进行掩码预测。在表8中,HQ-SAM在管边界APB上获得了3.8点的显著增益,在管掩膜APM上获得了2.9点的显著增益。

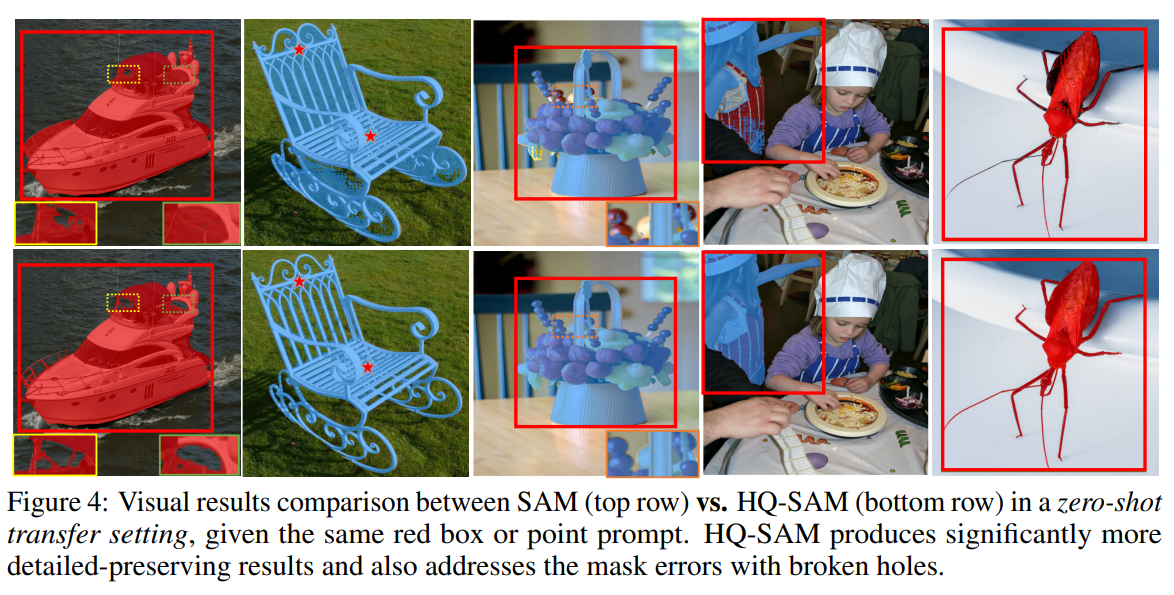

零样本视觉结果比较。在图4中,在零样本迁移设置下,HQ-SAM与SAM进行了定性比较,HQ-SAM显著提升了SAM的掩码细节,并通过丰富的语义上下文改善了破损孔洞或大比例误差的掩码。有关更多可视化比较,请参阅补充文件。

限制。尽管HQ-SAM以微不足道的开销显著提高了SAM的掩码质量,但它共享了SAM沉重的ViT编码器,因此无法实现视频处理的实时速度。

5、结论

我们提出了HQ-SAM,这是第一个高质量的零样本分割模型,通过在原始SAM中引入可忽略不计的开销。我们在HQ-SAM中提出了一个轻量级的高质量输出Token来取代原始SAM的输出Token,以实现高质量的掩码预测。在仅训练了44K个高精度掩模后,HQ-SAM显著提高了SAM的掩模预测质量,SAM训练了11亿个掩模。零样本转移评估在图像和视频任务的7个分割基准上进行,跨越不同的对象和场景。我们的研究为如何以数据高效和计算负担得起的方式利用和扩展类似sam的基础分割模型提供了及时的方式。

6、附件

在本补充材料中,第6.1节首先介绍了我们的HQ-SAM的额外实验分析,包括在图像和视频基准(如YTVIS[46]和DAVIS[33])上与SAM进行更多的零样本迁移比较。然后,在6.2节中,我们将描述该方法实现的更多细节,包括训练和推理。在6.3节中,我们提供了构建的用于训练HQ-SAM的HQSeg-44K数据集的进一步细节。在6.4节中,我们展示了HQ-SAM和SAM在COCO[31]、DIS-test[34]、HR-SOD[50]、NDD20[40]、DAVIS[33]和YTVIS[46]上的广泛视觉结果比较。

6.1、补充实验

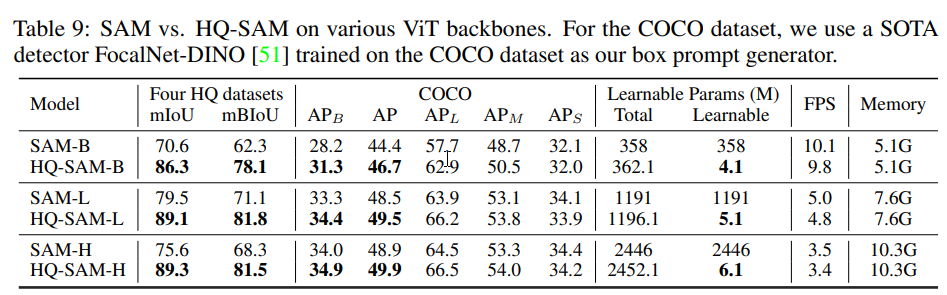

在表9中,我们综合比较了HQ-SAM和使用不同骨干的SAM,包括ViT-B, ViT-L和ViT-H。对比结果不仅包括在四个HQ数据集和COCO验证集上的数值结果,还包括模型大小/速度/内存。HQ-SAM始终优于使用三个不同骨干的SAM,在四个HQ数据集上的mBIoU增加了超过10个点。值得注意的是,基于vite - b的HQ-SAM显著提高了COCO上的APB从28.2提高到31.3,AP从44.4提高到46.7,仅增加了1.1%的模型参数,额外的内存消耗可以忽略不计。

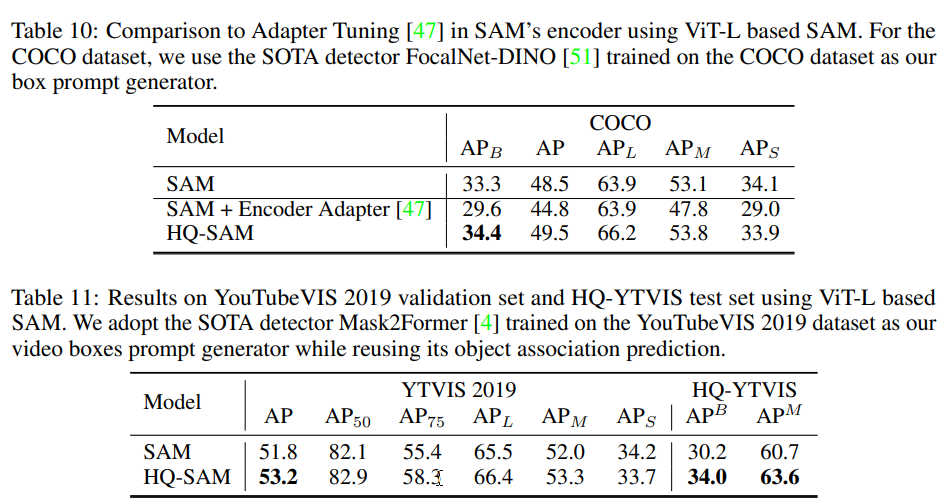

与适配器调优策略的比较在表10中,我们还将高效的Token自适应策略与最近的适配器调优[47]进行了比较。在SAM编码器的ViT层中引入了轻量级适配器来进行编码器调优,并发现这种策略会导致过拟合,其在COCO上的零样本性能从33.3下降到29.6。这验证了我们的设计选择,即冻结SAM的编码器,并主要关注SAM的解码器。

零样本视频实例分割比较。从本文的表8(在HQ-YTVIS基准[20]上的评估)扩展,我们进一步在流行的YTVIS 2019[46]验证集上对零样本视频实例分割结果进行对比分析。将预训练的Mask2Former[4]作为视频框提示,并将它们输入SAM和HQ-SAM进行掩码预测。在表11中,HQ-SAM在Tube Mask AP上获得了1.4个点的一致增益,SAM的性能从51.8提高到53.2。有趣的是,我们发现HQ-SAM在较高IoU阈值下的AP75提升远大于AP50,进一步验证了HQ-SAM在高质量掩码预测方面的优势。

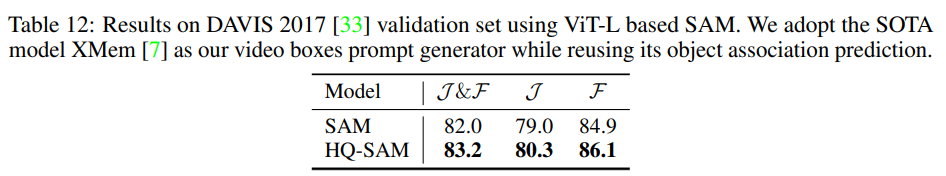

零样本视频对象分割比较。除了视频实例分割,在表12中,我们进一步报告了HQ-SAM和SAM在DAVIS验证集上在零样本传输协议下视频对象分割结果的比较。将预训练的XMem作为视频框的提示,并将相同的提示输入SAM和HQ-SAM。HQ-SAM将SAM的J和F值从82.0提高到83.2,F值从84.9提高到86.1,其中F为测量视频对象的轮廓精度。

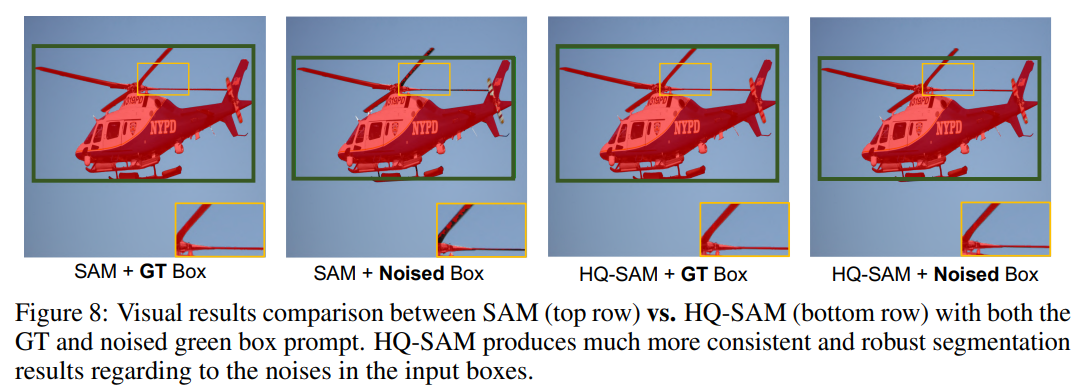

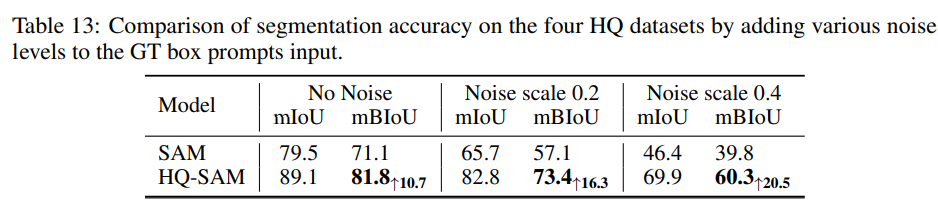

对输入框提示的鲁棒性。在表13中,我们通过在输入的真实值框提示中添加不同尺度的噪声来比较HQ-SAM和SAM。在实践中,我们不能期望人类在交互模式中提供的输入框提示与ground truth (GT)框相同或非常准确。遵循DN-DETR[25]中的数据增强代码添加不同的噪声尺度,发现HQ-SAM比SAM鲁棒得多,当噪声尺度逐渐增大时,相对mBIoU优势从10.7提高到20.5。请注意,我们的方法没有使用带噪声的盒子进行训练。我们还在图8中可视化了这种噪声输入案例,其中SAM对交互式注释中容易发生的小框位置变化更敏感。

6.2、其他实现细节

训练细节。在组成的HQSeg-44K上训练HQ-SAM期间,固定了预训练的SAM模型的模型参数,而只使所提出的HQ-SAM可学习,包括高质量输出 Token、其相关的三层MLP和用于hq -特征融合的三个卷积。其中两个是转置卷积(大小2×2,步幅2),用于将编码器嵌入大小从64×64放大到256×256。与SAM的掩码解码器中的原始4个掩码Token相比,我们将新的高质量输出Token视为第5个掩码Token。在训练期间,这个大小为1×256的新的高质量输出Token与SAM的掩码Token(大小为4×256)、iouToken(大小为1×256)和提示Token(大小为Nprompt×256)连接起来,作为SAM的掩码解码器的输入。例如,如果输入图像包含N个框提示(大小N×2×256),则SAM的2层掩码解码器的最终输入和输出形状为N×(1+4+1+2)×256。对于使用基于ViT-B、ViT-L和vit - h的模型进行训练的实验,我们采用相同的训练设置,学习率为1e-3,并训练我们的HQ-SAM 12个epoch(10个epoch后学习率下降到1e-4)。用BCE损失和Dice损失的组合来监督新高质量输出 Token的掩码预测。

实现细节。我们遵循与SAM相同的推理流水线,但使用高质量输出 Token的掩码预测作为高质量的掩码预测。表9报告了使用各种骨干的详细推理速度比较。在基于框提示的评估中,我们为SAM和HQ-SAM提供相同的图像/视频边界框,并采用SAM的单掩码输出模式。对于使用单点的交互式分割比较,遵循SAM并采用地面真值(GT)掩模的"中心"点,它位于掩模内部距离变换中的最大值位置。对于多点评估,我们从GT掩模中随机采样点,并报告三次试验的平均结果。

6.3、HQSeg-44K的更多细节

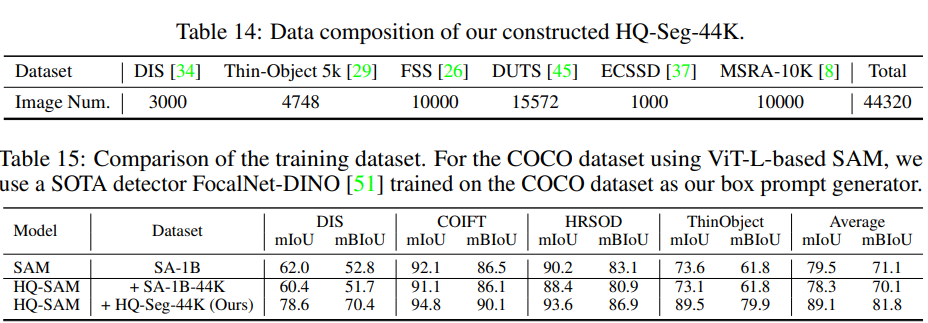

HQSeg-44K的数据组成。在表14中,我们提供了合成的新训练数据集HQSeg-44K的更多细节,该数据集包含44320个非常准确的图像掩模标注。HQSeg-44K集合了6个现有的具有极细粒度掩码标注的图像数据集,包括DIS34、ThinObject-5K29、FSS[26]、ECSSD[37]、MSRA-10K[8]、DUT-OMRON[45],其中每个数据集平均包含7.4K掩码标签。这个组成的训练集没有图像/注释与本文采用的零样本评估数据集重叠。

HQSeg-44K的作用。在表15中,我们通过将HQ-SAM训练与SA-1B[21]的44K随机采样图像和掩码进行比较,展示了使用HQSeg-44K的优势。使用相同的高效Token学习策略,使用SA-1B (44K)进行训练,使四个数据集上的平均mBIoU从71.1降低到70.1,而本文将其从71.1提高到81.8。这验证了所构建的HQSeg-44K基准在提高掩模质量方面的有效性。需要注意的是,本文表2、表3、表4和表10中的消融实验均基于构建的HQSeg-44K。

6.4、更多的视觉结果比较

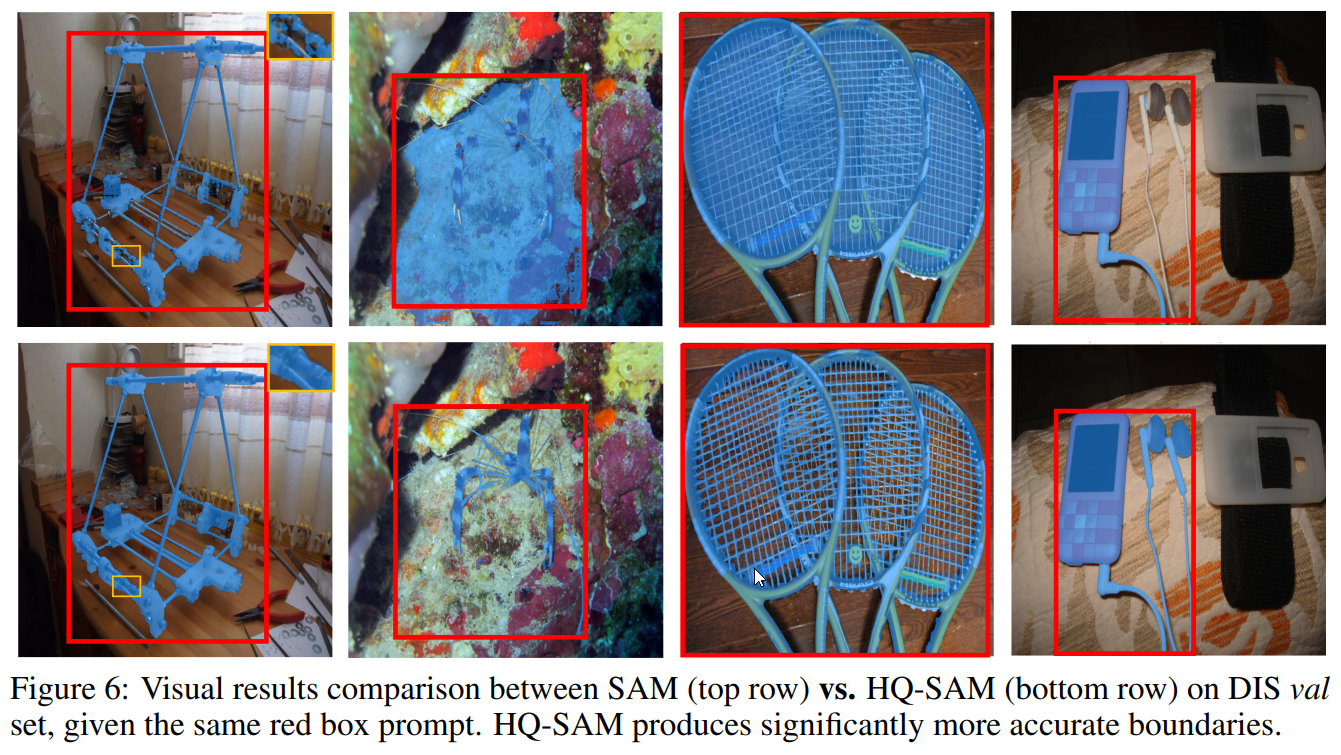

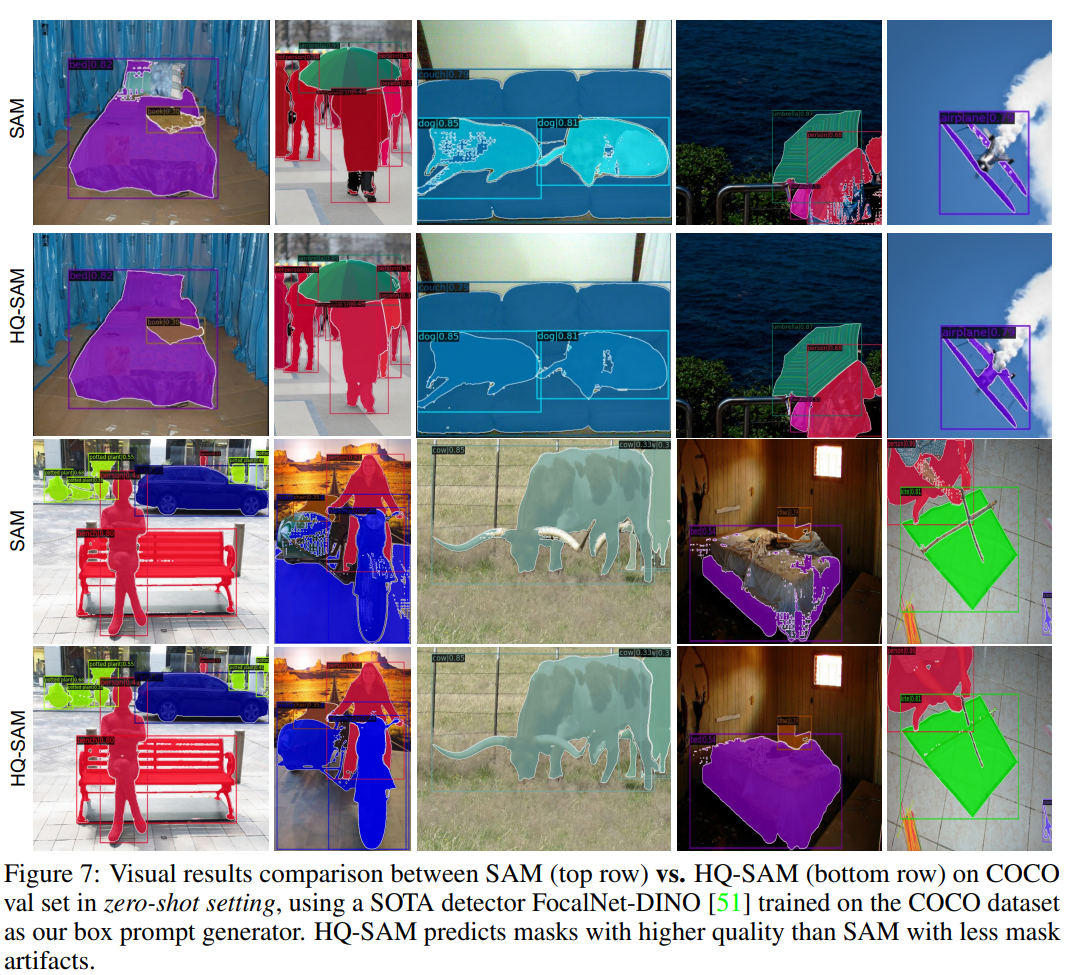

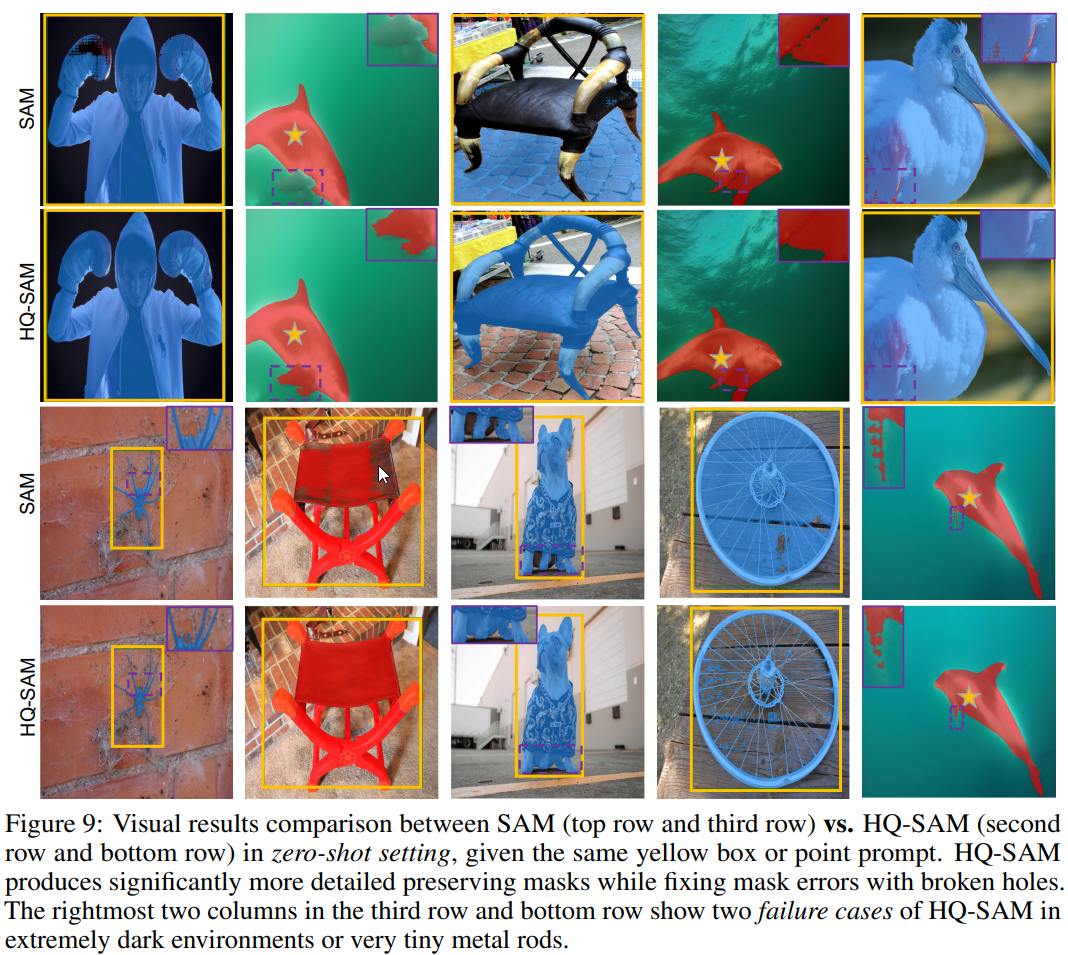

我们在图6 (DIS[34]测试集)、图7 (COCO中的零样本设置)、图8(噪声框输入)和图9 (HRSOD[50]、NDD20[40]和web图像中的零样本设置)中提供了更广泛的视觉结果对比,这些图像涵盖了在不同环境下具有不同结构复杂性的对象。在图10和图11中,我们分别提供了DAVIS 2017和YTVIS 2019基准上的零样本视频分割结果比较。此外,我们将NDD20[40]中的黑暗水下环境和随机选择的web图像包括在图9中,可见HQ-SAM较好地保持了SAM中的零样本分割能力。在图9中,我们还包括在第三行和最底层最右两列的两个失败案例,其中HQ-SAM比SAM有所改进,但仍然不能实现完全正确的掩码预测。