trace和script

pytorch是动态计算图,tensorflow和onnx是静态计算图。动态图编写代码简单易懂,但速度慢。

pytorch转换为静态计算图,有两种方法torch.jit.trace和torch.jit.script。

torch.jit.trace:顾名思义跟踪,给定模型一个输入(只要求输入的shape正确),开始执行一次前向传播,会记录过程中的所有操作。缺点是race将不会捕获根据输入数据而改变的行为。比如if语句,只会记录执行的那一条分支,同样的,for循环的次数,导出与跟踪运行完全相同的静态图。如果要使用动态控制流导出模型,则需要使用torch.jit.script。

torch.jit.script:真正的去编译,去做语法分析句法分析。因此可以使用if等动态控制流。返回ScriptModule。

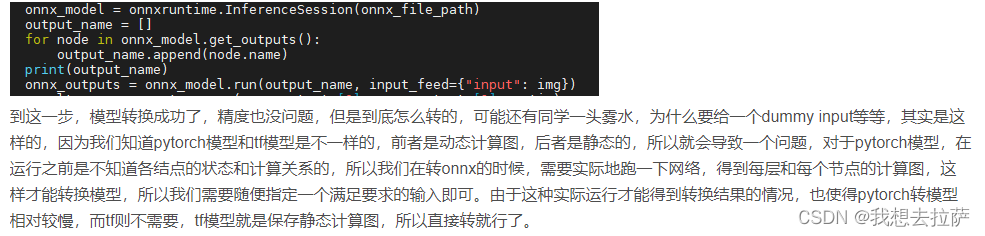

torch.onnx.export在运行时,先判断是否是SriptModule,如果不是,则进行torch.jit.trace,因此export需要一个随机生成的输入参数。

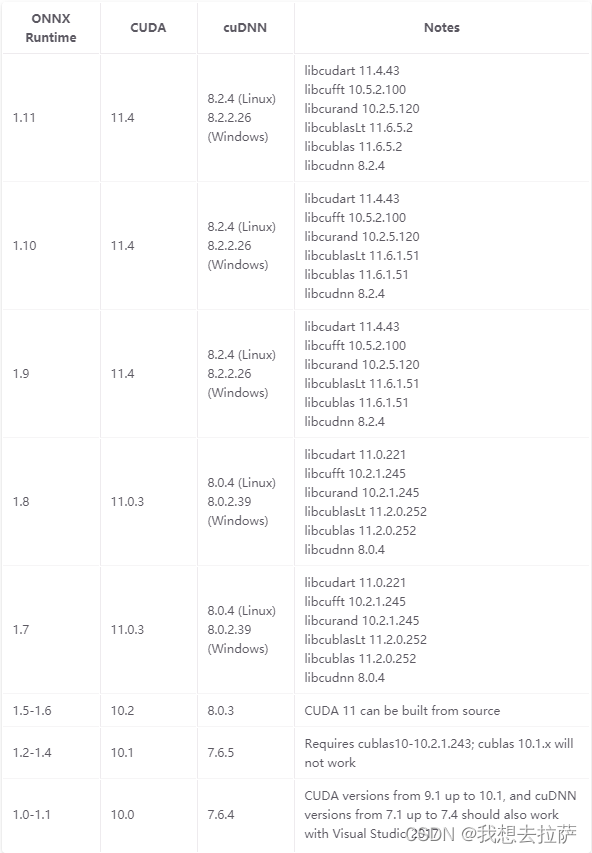

1. onnxruntime-gpu与CUDA版本适配

pip install onnxruntime-gpu==1.1 -i https://pypi.tuna.tsinghua.edu.cn/simple

2. onnxruntime-gpu的c++接口报错未加载kernelbase.pdb

由于onnxruntime-gpu的版本问题

3.python接口onnx的推理比pb慢

4.Polygraphy查看ONNX与TRT模型的输出差异

Polygraphy是TensorRT官方提供的一系列小工具合集,通过这个工具我们看一下这个Resnet34_3inputs_448x448_20200609.onnx模型在转换为trt之后是否会有精度折损

5.onnx simplier(简称 onnxsim)

pip install onnx-simplifier -i https://pypi.douban.com/simple/

把conv和bn合在一块,以及一些计算出来是常量的模块直接折叠之类的,可以加快onnx模型推理。

6.onnx export RuntimeError: Unrecognized attribute: min for operator Clip

pytorch 升级到1.6