简介

之前摆弄了一个docker + hadoop3.1 的镜像,通不了,所以这里直接先再github上找了一个Spark搭建的集群。

docker-spark : https://github.com/houshuai0816/docker-spark 这个项目中当前使用的是Spark 2.3.0 和 hadoop2.7 和jdk8

构建

- 进行检出仓库内容

git clone https://github.com/houshuai0816/docker-spark.git- 进入你的容器

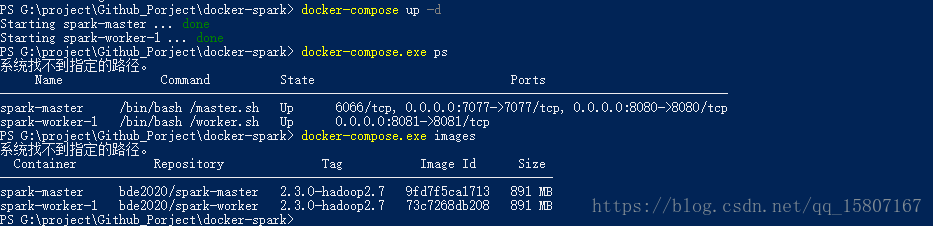

cd G:\project\Github_Porject\docker-spark- 通过

yml进行启动此项目

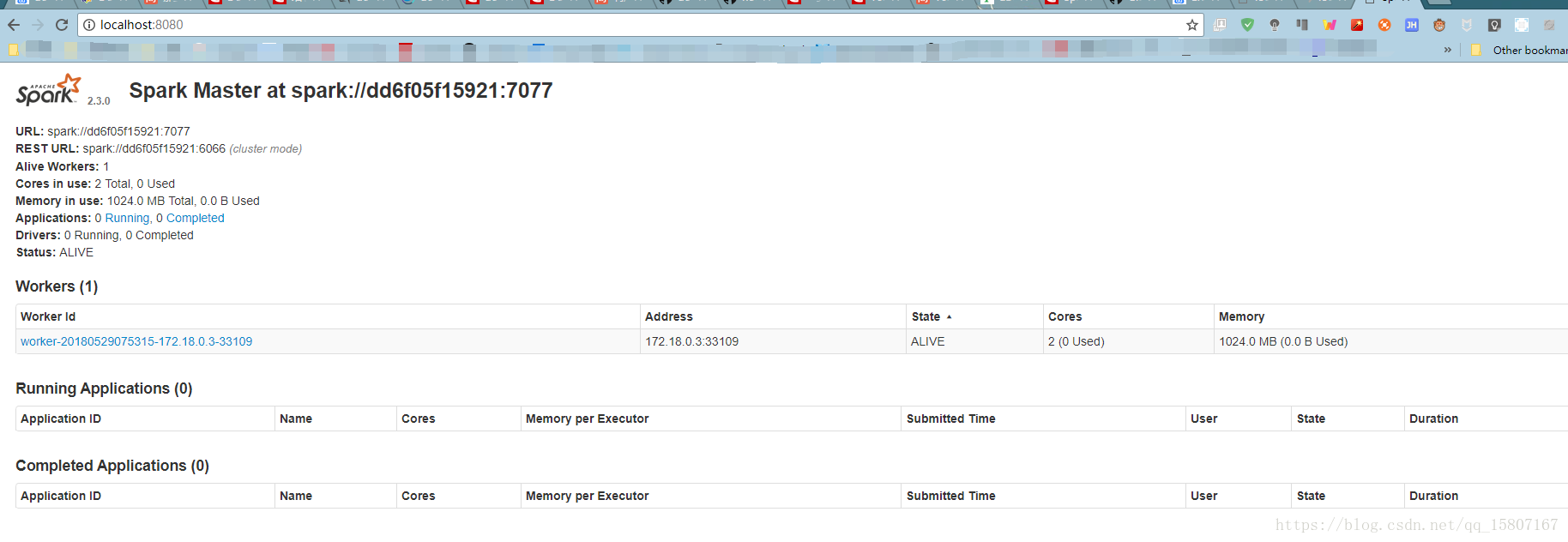

docker-compose up -d- 进行访问web页面进行查看节点

访问此 http://localhost:8080/ 。