线性回归

线性回归是单层的神经网络模型

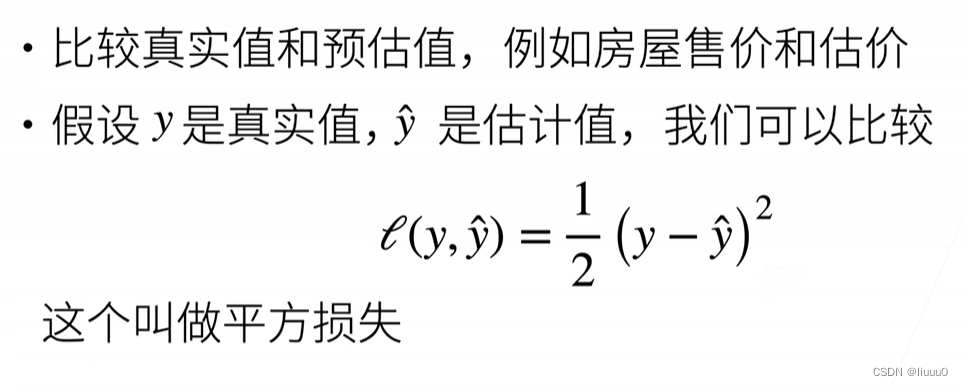

通过平方损失来衡量预测质量,1/2便于求导

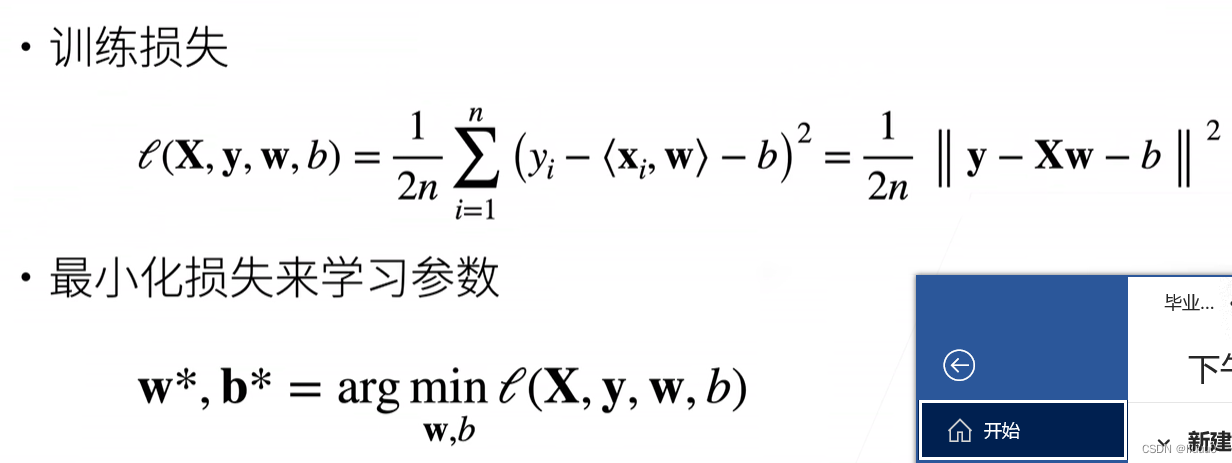

训练损失:加均值

基础优化算法

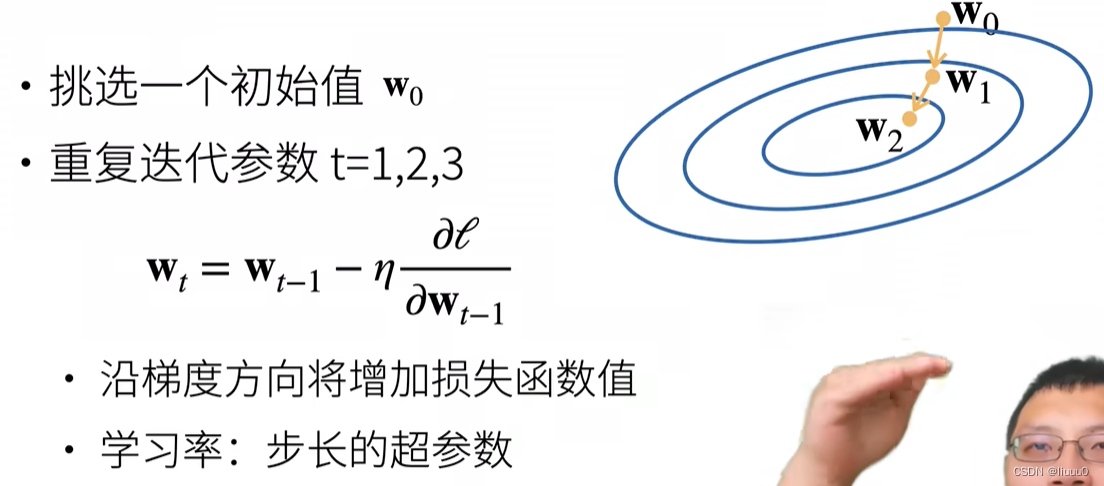

梯度下降

梯度是上升最快的方向,负梯度即为下降最快的方向。因为该函数表示训练损失,所以要找下降最快的方向来更新参数

学习率即为每次的步长

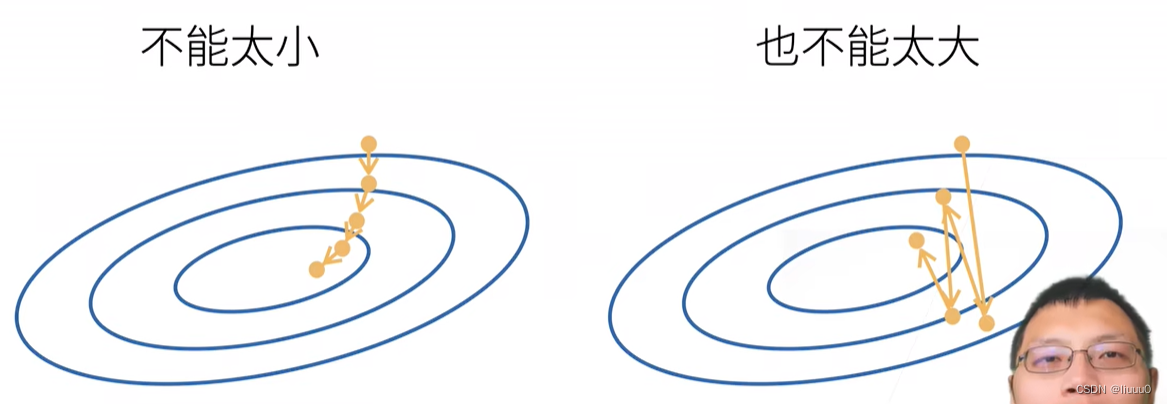

学习率太小,步数多,计算梯度的次数多,太贵;而且陷入局部最优解

学习率太大,容易在最优解附近振荡

小批量随机梯度下降

抽样。通过计算b个样本的平均损失,代替总体然后进行优化,从而可在短时间内多迭代几次

批量大小的选择

批量太小:每次计算量太小,不适合并行来最大利用计算资源

批量太大:内存消耗增加;浪费计算,例如如果所有样本都是相同的

梯度下降通过不断沿着反梯度方向更新参数求解

小批量随机梯度下降是深度学习默认的求解方法

两个重要的超参数是:批量大小和学习率

线性回归的从零开始实现

不使用任何框架。

包括数据流水线、模型、损失函数、小批量随机梯度下降优化器

线性回归的简洁实现

使用框架,调用API