摘要

This is a meteorological forecasting competition being held by Ali Tianchi. The contestants need to predict future meteorological data based on past meteorological data; the meteorological data is given in the form of pictures, including radar echo map, rainfall map, average wind image, so it is necessary to use the technology of image information extraction; the initial idea is to obtain three different Encodings and Decoders through pre-training through the MAE model. These three Encodings will understand the meaning of the image data they are responsible for and keep the three Encodings The parameters remain unchanged, and an optimized Transformer model is combined behind them. The Transformer model will realize the function of completing time series prediction, and the predicted data will be finally decoded into the meteorological data in the picture format through the Decoder in MAE, so as to achieve image recognition and processing. For the purpose of time series prediction, the MAE-Encoder-Transformer-MAE-Decoder model was discovered.

这是阿里天池正在进行的一个气象预测的比赛,选手需要根据过去的气象数据预测未来的气象数据;气象数据是以图片的形式给出的,其中包括雷达回波图、降雨量图、平均风图,故需要用到图像信息提取的技术;初步想法是通过MAE模型,预训练得到三个不同的Encoding和Decoder,这三个Encoding将会明白各自负责的图片数据含义,保持这三个Encoding的参数不变,在其后面接一个优化后的Transformer模型,Transformer模型将实现时序预测的功能,将预测的数据,最后再通过MAE中的Decoder解码为图片格式的气象数据,以达到图像识别加时序预测的目的,于是便有了MAE-Encoder-Transformer-MAE-Decoder模型。

一、数据分析

数据是图片形式的,空间分辨率为1KM,时间分辨率为6分钟,且图片按时间顺序命名,如下图:

数据为雷达回波(Radar)、降水(Precip)和平均风(Wind)三类。使用说明:

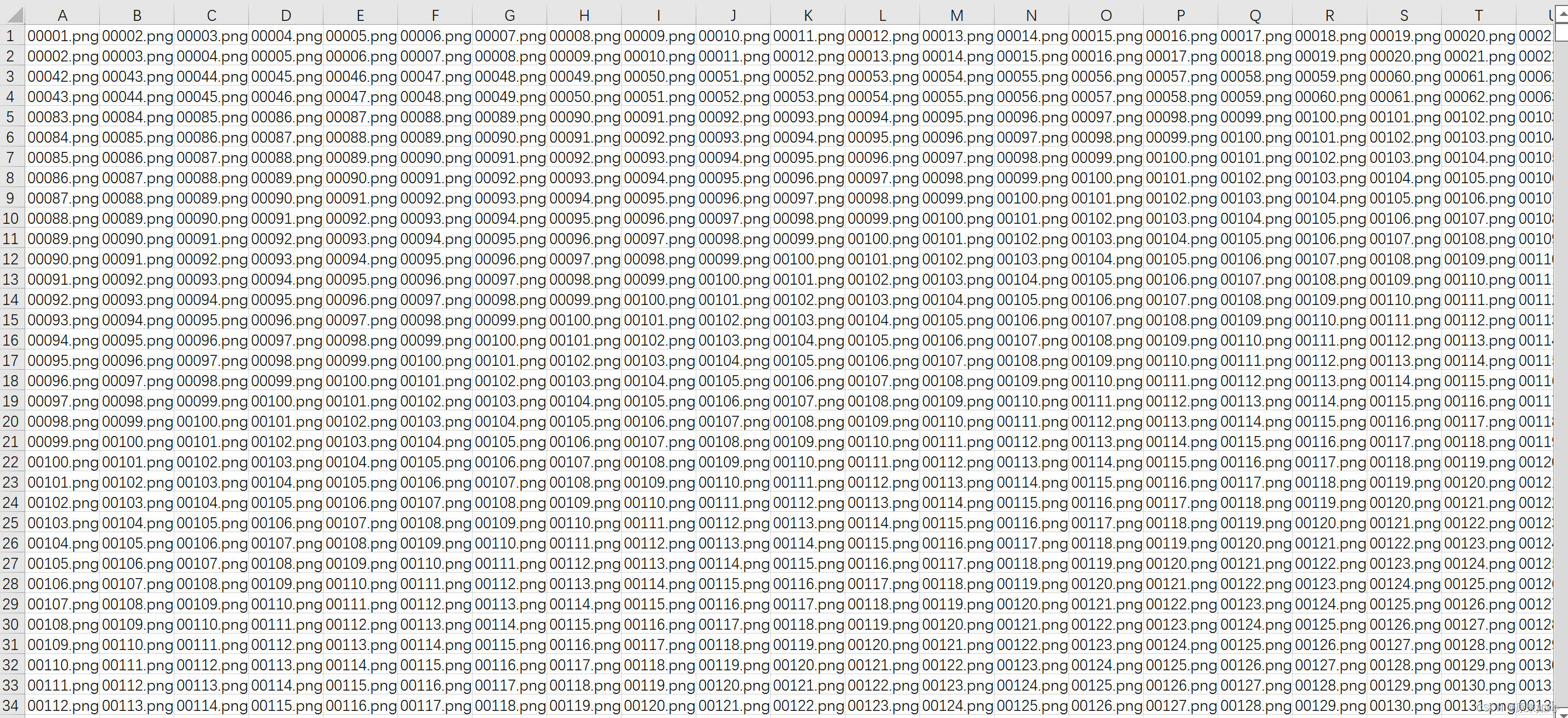

在训练集Train提供的所有数据中,既包含强天气过程(Radar或Precip或Wind有较高的数值),也有好天(Radar或Precip或Wind数值很低),赛题组从中挑出了2万+次有强天气发生的过程并以案例的形式呈现在对应的Train.csv中供选手参照,其中每行的41列为一次案例,各行之间相互独立,每个案例以序号.png的形式列出。以截取自Train.csv的图1为例,第一行有41列,对应为任一天中任意4小时时段内的逐6分钟图片序列(共41张),前21张图片为过去2小时的数据(例如00时—02时),后21张图片为后2小时数据(例如02时06分—04时)。该序号同时适用于Radar、Precip和Wind,可据此从原始数据文件中索引找到相应图片并进行模型构建,对未来2小时(20张图片)的Radar、Precip和Wind进行预测;

要用过去20张图片的气象数据,去预测未来20张气象数据图片,显然,这个时间序列是比较长的,所以需要我们的模型能够很好的理解气象图片的数据含义,才有可能得到比较好的效果

二、MAE简介

MAE是一个用来做图像识别的预训练模型,他是Encoder-Decoder架构,它是做法是通过遮掩掉一部分的图像数据,让模型根据遮掩的图片还原出全部的图片,以训练出一个能够有效提取图片信息的模型。

三、Transformer简介

Transformer也是Encoder-Decoder架构,在Encoder端会通过位置编码将位置信息加入到输入数据,再将数据映射到不同空间,用多头注意力让模型抓住重要信息,抛弃无用信息。在Decoder端,对Encoder的数据进行解码,得到预测数据,达到时序预测的效果。