chatgml-6B

1.GLM预训练介绍

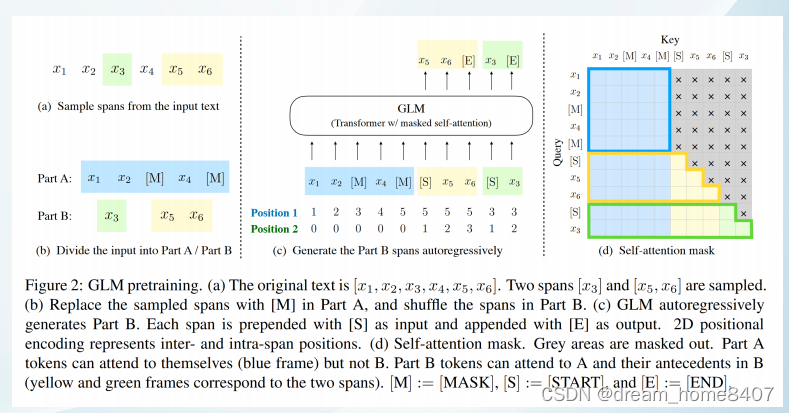

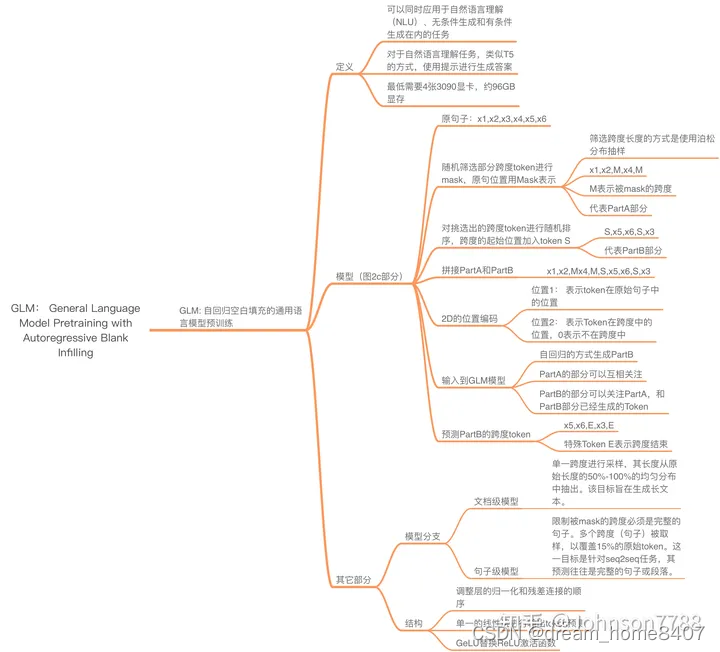

GLM(通用语言模型),基于自回归空白填充假设输入语段是是x1-x6,随机mask掉一部分,模型开始预测被mask的语段是什么,同时随机打乱mask的位置。

链接: GLM Paper

链接: GLM-130B Paper

链接: ChatGLM-6B

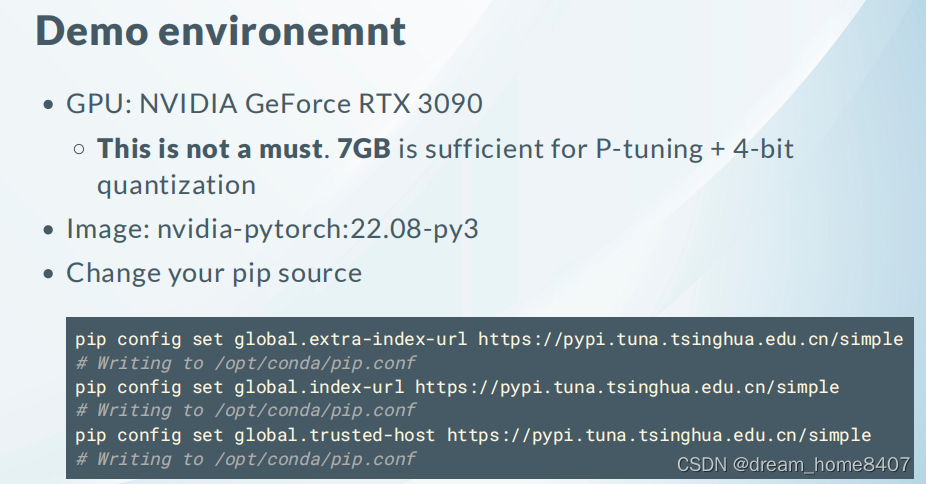

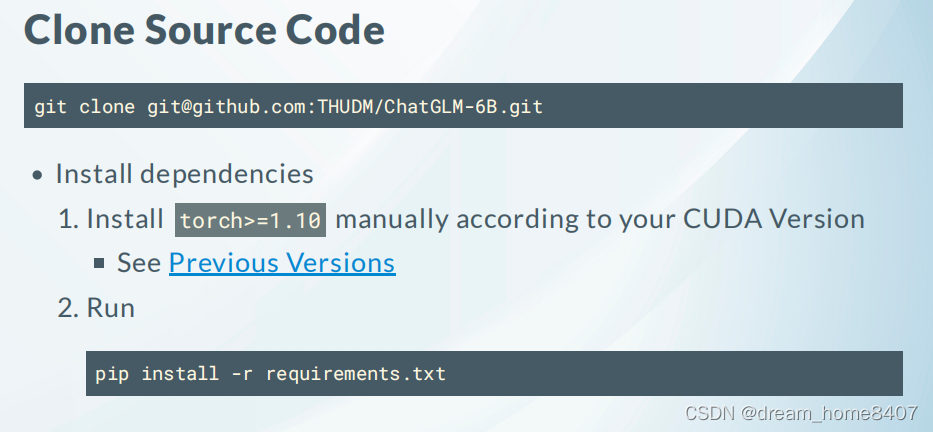

2.基础环境及镜像镜像下载方式

链接: HuggingFace Repo

链接: Get Started

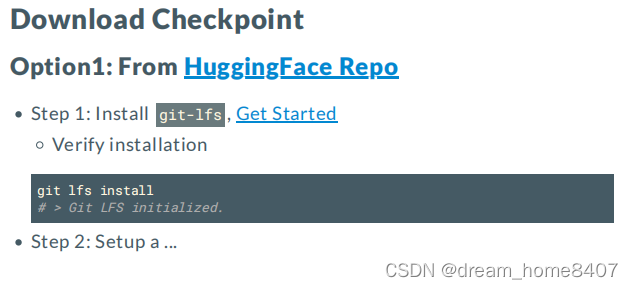

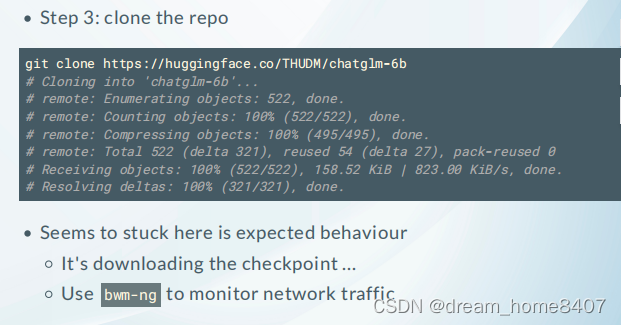

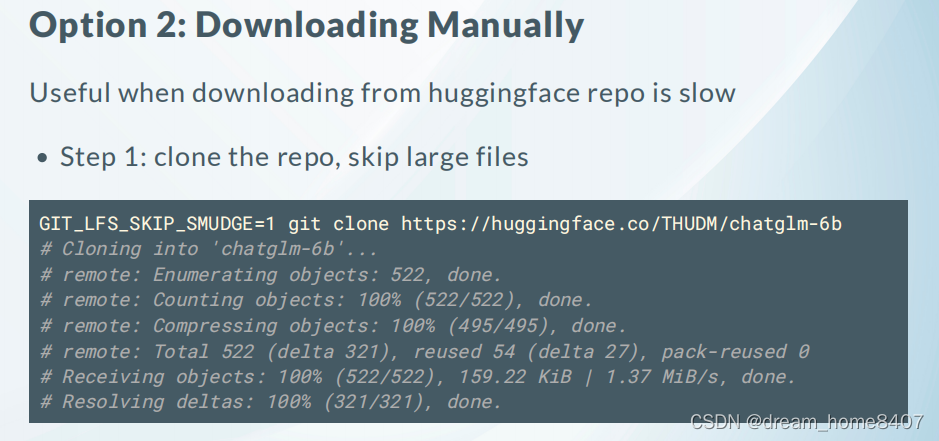

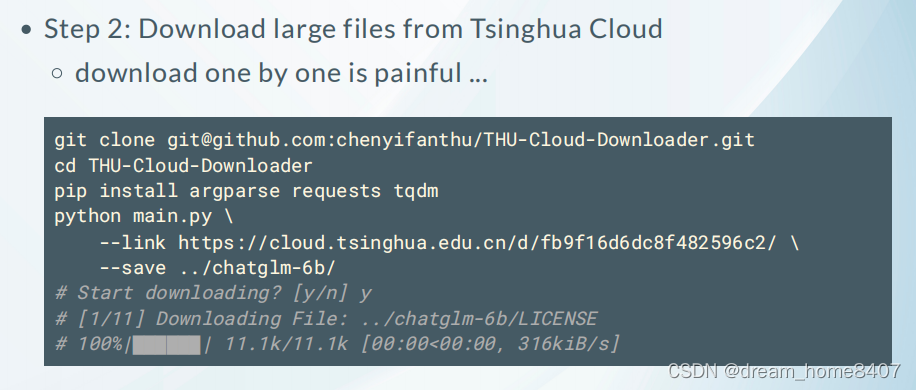

3.模型文件下载

链接: Torch Version

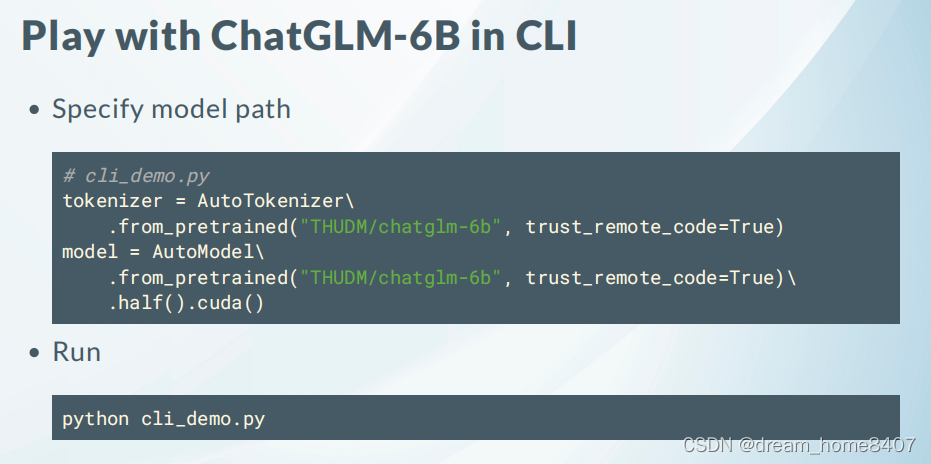

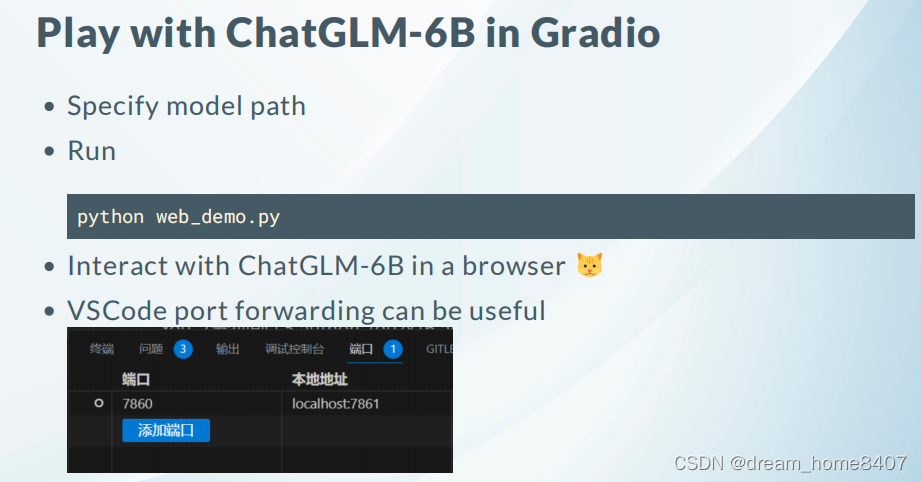

3.1推理

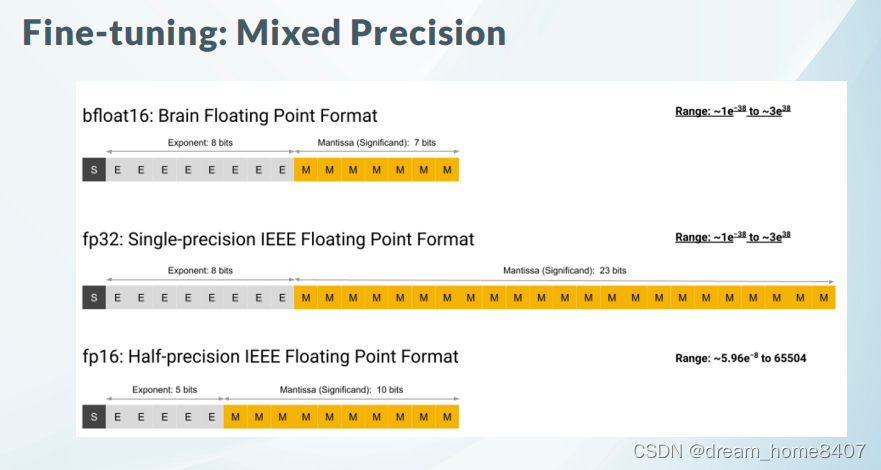

4. Fingtuing

P-Tuning (1 RTX2080 ti *11G)

LoRA (1 RTX2080 ti *11G)

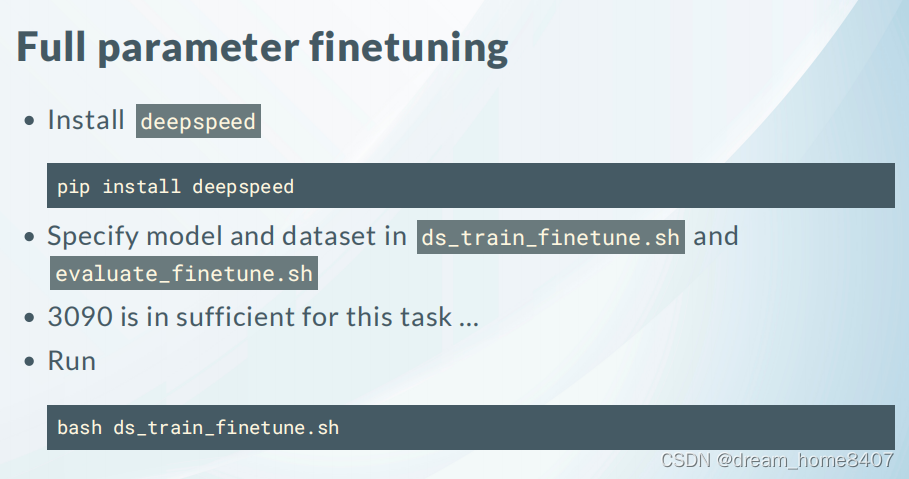

Full Parameter

4.1数据准备

样例数据下载链接

链接: Dataset

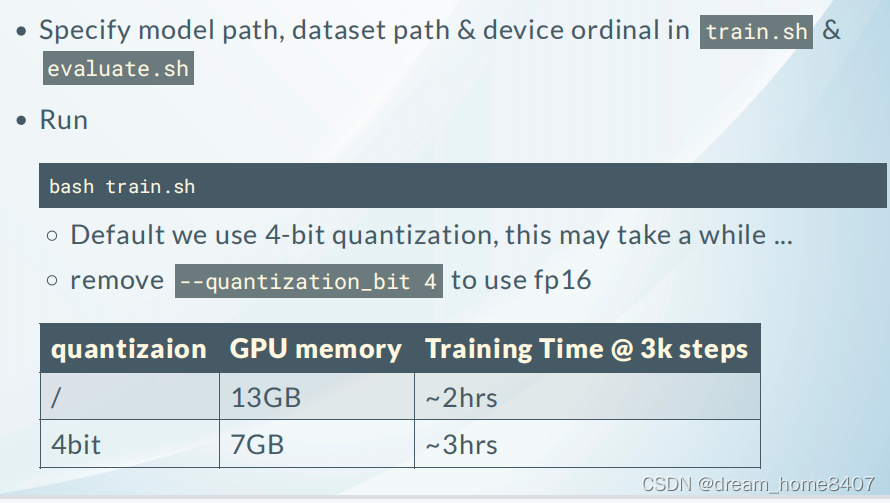

5.有监督训练量化训练

5.1更改全部参数训练方式

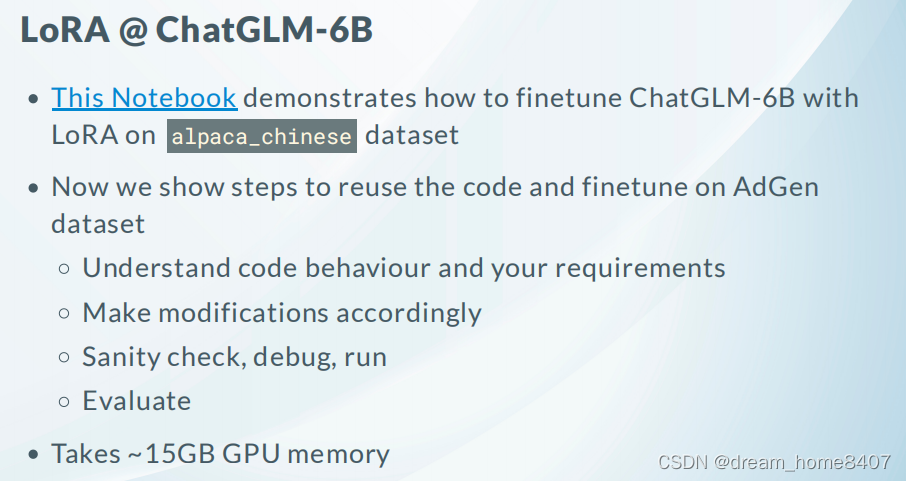

5.2 LoRA训练方式

链接: LoRA详细介绍