1、定义

1.1、定义

简单来说, 逻辑回归(Logistic Regression)是一种用于解决二分类(0 or 1)问题的机器学习方法,用于估计某种事物的可能性。比如某用户购买某商品的可能性,某病人患有某种疾病的可能性,以及某广告被用户点击的可能性等。

1.2、逻辑回归与线性回归的关系

逻辑回归(Logistic Regression)与线性回归(Linear Regression)都是一种广义线性模型(generalizedlinear model)。逻辑回归假设因变量 y 服从伯努利分布,而线性回归假设因变量 y 服从高斯分布。 因此与线性回归有很多相同之处,去除Sigmoid映射函数的话,逻辑回归算法就是一个线性回归。可以说,逻辑回归是以线性回归为理论支持的,但是逻辑回归通过Sigmoid函数引入了非线性因素,因此可以轻松处理0/1分类问题。

2、预测函数

对于线性边界的情况,边界形式如下:

构造预测函数为:

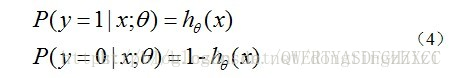

hθ(x)函数的值有特殊的含义,它表示结果取1的概率,因此对于输入x分类结果为类别1和类别0的概率分别为:

3、代价函数

通过最大似然估计推导得到。下面详细说明推导的过程。(4)式综合起来可以写成:

取似然函数为:

对数似然函数为:

最大似然估计就是要求得使l(θ)取最大值时的θ,其实这里可以使用梯度上升法求解,求得的θ就是要求的最佳参数。我们可以乘一个负的系数-1/m,所以J(θ)取最小值时的θ为要求的最佳参数:

4、梯度下降

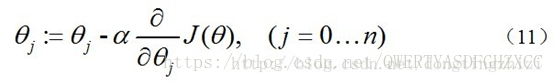

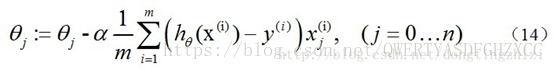

求J(θ)的最小值可以使用梯度下降法,根据梯度下降法可得θ的更新过程:

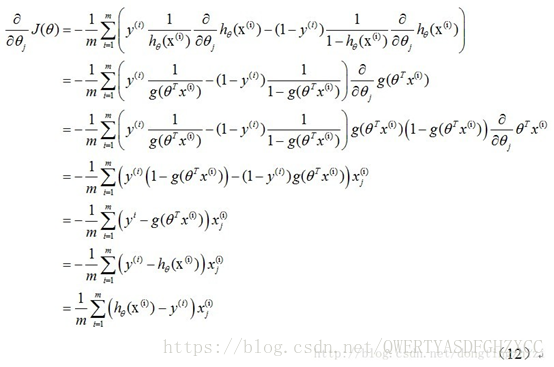

式中为α学习步长,下面来求偏导:

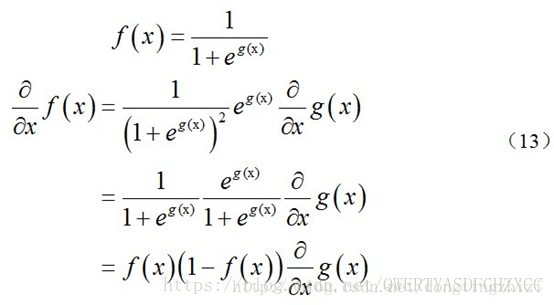

上式求解过程中用到如下的公式:

因此,(11)式的更新过程可以写成:

因为式中α本来为一常量,所以1/m一般将省略,所以最终的θ更新过程为:

代码实现:https://github.com/sunjiaxin111/machine_learning/tree/master/logistic_regression