2021SC@SDUSC

目录

一、前情回顾

1.1 PP-OCR文字识别策略

策略的选用主要是用来增强模型能力和减少模型大小。下面是PP-OCR文字识别器所采用的九种策略:

- 轻主干,选用采用 MobileNetV3 large x0.5 来权衡精度和效率;

- 数据增强,BDA (Base Dataaugmented)和TIA (Luo et al. 2020);

- 余弦学习率衰减,有效提高模型的文本识别能力;

- 特征图辨析,适应多语言识别,进行向下采样 feature map的步幅修改;

- 正则化参数,权值衰减避免过拟合;

- 学习率预热,同样有效;

- 轻头部,采用全连接层将序列特征编码为预测字符,减小模型大小;

- 预训练模型,是在 ImageNet 这样的大数据集上训练的,可以达到更快的收敛和更好的精度;

- PACT量化,略过 LSTM 层;

1.2 本文介绍策略

前文,我们根据模型实现流程再次介绍了Paddle-OCR文字识别器的CRNN-CTC模型。

基于之前对整体模型选择,以及各种策略算法代码实现的具体介绍,本篇文章将结合实际文字识别场景对Paddle-OCR识别文字过程进行总体认识,并对过程中使用到的关键代码进行分析。

二、PP-OCR识别流程

2.1 数据集收集

结合ppocr中的__init__和__getitem__方法实现自定义数据集读取。

代码位置

![]()

代码详细实现及分析:

import os

import PIL.Image as Image

import numpy as np

from paddle.io import Dataset

# 图片信息配置 - 通道数、高度、宽度

IMAGE_SHAPE_C = 3

IMAGE_SHAPE_H = 30

IMAGE_SHAPE_W = 70

# 数据集图片中标签长度最大值设置 - 因图片中均为4个字符,故该处填写为4即可

LABEL_MAX_LEN = 4

class Reader(Dataset):

def __init__(self, data_path: str, is_val: bool = False):

"""

数据读取Reader

:param data_path: Dataset路径

:param is_val: 是否为验证集

"""

super().__init__()

self.data_path = data_path

# 读取Label字典

with open(os.path.join(self.data_path, "label_dict.txt"), "r", encoding="utf-8") as f:

self.info = eval(f.read())

# 获取文件名列表

self.img_paths = [img_name for img_name in self.info]

# 将数据集后1024张图片设置为验证集,当is_val为真时img_path切换为后1024张

self.img_paths = self.img_paths[-1024:] if is_val else self.img_paths[:-1024]

def __getitem__(self, index):

# 获取第index个文件的文件名以及其所在路径

file_name = self.img_paths[index]

file_path = os.path.join(self.data_path, file_name)

# 捕获异常 - 在发生异常时终止训练

try:

# 使用Pillow来读取图像数据

img = Image.open(file_path)

# 转为Numpy的array格式并整体除以255进行归一化

img = np.array(img, dtype="float32").reshape((IMAGE_SHAPE_C, IMAGE_SHAPE_H, IMAGE_SHAPE_W)) / 255

except Exception as e:

raise Exception(file_name + "\t文件打开失败,请检查路径是否准确以及图像文件完整性,报错信息如下:\n" + str(e))

# 读取该图像文件对应的Label字符串,并进行处理

label = self.info[file_name]

label = list(label)

# 将label转化为Numpy的array格式

label = np.array(label, dtype="int32")

return img, label

def __len__(self):

# 返回每个Epoch中图片数量

return len(self.img_paths)

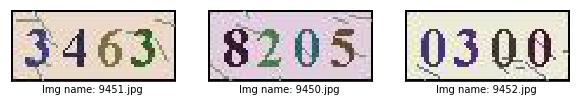

实例读取的数据

2.2 模型配置

模型方面使用的是我们上一篇文章介绍的简单的CRNN-CTC结构。

输入形为CHW的图像在经过CNN->Flatten->Linear->RNN->Linear后输出图像中每个位置所对应的字符概率。考虑到CTC解码器在面对图像中元素数量不一、相邻元素重复时会存在无法正确对齐等情况,故额外添加一个类别代表“分隔符”进行改善。

代码位置:

![]()

具体代码实现及分析:

import paddle

# 分类数量设置 - 因数据集中共包含0~9共10种数字+分隔符,所以是11分类任务

CLASSIFY_NUM = 11

# 定义输入层,shape中第0维使用-1则可以在预测时自由调节batch size

input_define = paddle.static.InputSpec(shape=[-1, IMAGE_SHAPE_C, IMAGE_SHAPE_H, IMAGE_SHAPE_W],

dtype="float32",

name="img")

# 定义网络结构

class Net(paddle.nn.Layer):

def __init__(self, is_infer: bool = False):

super().__init__()

self.is_infer = is_infer

# 定义一层3x3卷积+BatchNorm

self.conv1 = paddle.nn.Conv2D(in_channels=IMAGE_SHAPE_C,

out_channels=32,

kernel_size=3)

self.bn1 = paddle.nn.BatchNorm2D(32)

# 定义一层步长为2的3x3卷积进行下采样+BatchNorm

self.conv2 = paddle.nn.Conv2D(in_channels=32,

out_channels=64,

kernel_size=3,

stride=2)

self.bn2 = paddle.nn.BatchNorm2D(64)

# 定义一层1x1卷积压缩通道数,输出通道数设置为比LABEL_MAX_LEN稍大的定值可获取更优效果,当然也可设置为LABEL_MAX_LEN

self.conv3 = paddle.nn.Conv2D(in_channels=64,

out_channels=LABEL_MAX_LEN + 4,

kernel_size=1)

# 定义全连接层,压缩并提取特征(可选)

self.linear = paddle.nn.Linear(in_features=429,

out_features=128)

# 定义RNN层来更好提取序列特征,此处为双向LSTM输出为2 x hidden_size,可尝试换成GRU等RNN结构

self.lstm = paddle.nn.LSTM(input_size=128,

hidden_size=64,

direction="bidirectional")

# 定义输出层,输出大小为分类数

self.linear2 = paddle.nn.Linear(in_features=64 * 2,

out_features=CLASSIFY_NUM)

def forward(self, ipt):

# 卷积 + ReLU + BN

x = self.conv1(ipt)

x = paddle.nn.functional.relu(x)

x = self.bn1(x)

# 卷积 + ReLU + BN

x = self.conv2(x)

x = paddle.nn.functional.relu(x)

x = self.bn2(x)

# 卷积 + ReLU

x = self.conv3(x)

x = paddle.nn.functional.relu(x)

# 将3维特征转换为2维特征 - 此处可以使用reshape代替

x = paddle.tensor.flatten(x, 2)

# 全连接 + ReLU

x = self.linear(x)

x = paddle.nn.functional.relu(x)

# 双向LSTM - [0]代表取双向结果,[1][0]代表forward结果,[1][1]代表backward结果,详细说明可在官方文档中搜索'LSTM'

x = self.lstm(x)[0]

# 输出层 - Shape = (Batch Size, Max label len, Signal)

x = self.linear2(x)

# 在计算损失时ctc-loss会自动进行softmax,所以在预测模式中需额外做softmax获取标签概率

if self.is_infer:

# 输出层 - Shape = (Batch Size, Max label len, Prob)

x = paddle.nn.functional.softmax(x)

# 转换为标签

x = paddle.argmax(x, axis=-1)

return x

2.3 训练准备

定义label输入以及超参数

代码位置:

![]()

使用时的代码及分析:

# 数据集路径设置

DATA_PATH = "./data/OCR_Dataset"

# 训练轮数

EPOCH = 10

# 每批次数据大小

BATCH_SIZE = 16

label_define = paddle.static.InputSpec(shape=[-1, LABEL_MAX_LEN],

dtype="int32",

name="label")

定义CTC Loss

我们在之前的文章已经具体介绍过loss函数。

代码位置:

![]()

代码实现与分析:

class CTCLoss(paddle.nn.Layer):

def __init__(self):

"""

定义CTCLoss

"""

super().__init__()

def forward(self, ipt, label):

input_lengths = paddle.full(shape=[BATCH_SIZE],fill_value=LABEL_MAX_LEN + 4,dtype= "int64")

label_lengths = paddle.full(shape=[BATCH_SIZE],fill_value=LABEL_MAX_LEN,dtype= "int64")

# 按文档要求进行转换dim顺序

ipt = paddle.tensor.transpose(ipt, [1, 0, 2])

# 计算loss

loss = paddle.nn.functional.ctc_loss(ipt, label, input_lengths, label_lengths, blank=10)

return loss

实例化模型并配置优化策略

PP-OCR文字识别器的优化器我们之前也逐篇介绍过了。

代码位置:

![]()

代码实现与分析:

# 定义优化器

optimizer = paddle.optimizer.Adam(learning_rate=0.0001, parameters=model.parameters())

# 为模型配置运行环境并设置该优化策略

model.prepare(optimizer=optimizer,

loss=CTCLoss())

2.4 训练

训练部分具体代码:

# 执行训练

model.fit(train_data=Reader(DATA_PATH),

eval_data=Reader(DATA_PATH, is_val=True),

batch_size=BATCH_SIZE,

epochs=EPOCH,

save_dir="output/",

save_freq=1,

verbose=1,

drop_last=True)

2.5 预测前准备

像定义训练Reader一样定义预测Reader

# 与训练近似,但不包含Label

class InferReader(Dataset):

def __init__(self, dir_path=None, img_path=None):

"""

数据读取Reader(预测)

:param dir_path: 预测对应文件夹(二选一)

:param img_path: 预测单张图片(二选一)

"""

super().__init__()

if dir_path:

# 获取文件夹中所有图片路径

self.img_names = [i for i in os.listdir(dir_path) if os.path.splitext(i)[1] == ".jpg"]

self.img_paths = [os.path.join(dir_path, i) for i in self.img_names]

elif img_path:

self.img_names = [os.path.split(img_path)[1]]

self.img_paths = [img_path]

else:

raise Exception("请指定需要预测的文件夹或对应图片路径")

def get_names(self):

"""

获取预测文件名顺序

"""

return self.img_names

def __getitem__(self, index):

# 获取图像路径

file_path = self.img_paths[index]

# 使用Pillow来读取图像数据并转成Numpy格式

img = Image.open(file_path)

img = np.array(img, dtype="float32").reshape((IMAGE_SHAPE_C, IMAGE_SHAPE_H, IMAGE_SHAPE_W)) / 255

return img

def __len__(self):

return len(self.img_paths)

预测数据

2.6 预测

预测使用代码

# 编写简易版解码器

def ctc_decode(text, blank=10):

"""

简易CTC解码器

:param text: 待解码数据

:param blank: 分隔符索引值

:return: 解码后数据

"""

result = []

cache_idx = -1

for char in text:

if char != blank and char != cache_idx:

result.append(char)

cache_idx = char

return result

# 实例化推理模型

model = paddle.Model(Net(is_infer=True), inputs=input_define)

# 加载训练好的参数模型

model.load(CHECKPOINT_PATH)

# 设置运行环境

model.prepare()

# 加载预测Reader

infer_reader = InferReader(INFER_DATA_PATH)

img_names = infer_reader.get_names()

results = model.predict(infer_reader, batch_size=BATCH_SIZE)

index = 0

for text_batch in results[0]:

for prob in text_batch:

out = ctc_decode(prob, blank=10)

print(f"文件名:{img_names[index]},推理结果为:{out}")

index += 1

结果

和待测数据一致。

总结

本篇文章结合实际文字识别场景对Paddle-OCR识别文字过程进行总体认识,并对过程中使用到的关键代码进行了分析。