Spark是一个开源集群运算框架,Spark在存储器内运行程序运算速度比Hadoop MapReduce的运算快100倍以上。

Spark支持多种运行模式,包括独立模式(本地Spark集群)、Hadoop YARN或Apache Mesos的集群管理,本次及以后的实验均采用Running Spark on YARN模式。

安装部署之前需要准备的环境

- 操作系统Centos

- Hadoop Yarn环境

- JDK

1、安装配置Scala,点击下载scala

#cd /usr/local #tar -zxf scala-2.11.0.tar.gz #mv scala-....... scala #vim /etc/profile 键入 export SCALA_HOME=/usr/local/scala export PATH=$PATH:$SCALA_HOME/bin #source /etc/profile #scala -version

2、安装Spark,点击下载Spark2.2.0

- 设置环境变量

#cd /usr/spark #tar -zxvf spark-2.2.0....tar.gz #mv spark... spark #vim /etc/profile 键入 export SPARK_HOME=/usr/local/spark export PATH=$PATH:/$SPARK_HOME/bin #source /etc/profile

- 编辑配置文件spark-env.sh

#cd /usr/local/spark/conf

#cp spark-env.sh.template spark-env.sh

#vim spark-env.sh

在spark-env.sh末尾添加以下内容:

export SPARK_HOME=/usr/local/spark

export SCALA_HOME=/usr/local/scala

export JAVA_HOME=${JAVA_HOME}

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$SCALA_HOME/bin

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export YARN_CONF_DIR=$YARN_HOME/etc/hadoop

export SPARK_MASTER_IP=localhost

SPARK_LOCAL_DIRS=/usr/spark/spark

SPARK_DRIVER_MEMORY=1G

export SPARK_LIBARY_PATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$HADOOP_HOME/lib/native

- 添加slaves文件

cp slaves.template slaves

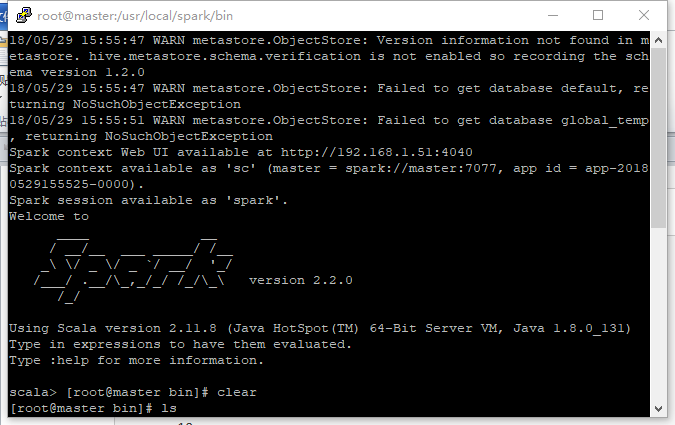

- 测试Spark

#spark-shell

如下图: