学习Spark中的RDD

文章目录

一、RDD概念

Spark提供了一种对数据的核心抽象,称为弹性分布式数据集(Resilient Distributed Dataset,RDD)。这个数据集的全部或部分可以缓存在内存中,并且可以在多次计算时重用。RDD其实就是一个分布在多个节点上的数据集合。

RDD的弹性主要是指当内存不够时,数据可以持久化到磁盘,并且RDD具有高效的容错能力。

分布式数据集是指一个数据集存储在不同的节点上,每个节点存储数据集的一部分。

二、准备工作

(一)准备数据文件

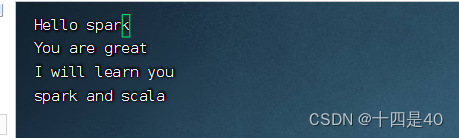

1.创建本地文件

在本地 /home 目录里创建 test.txt 文件

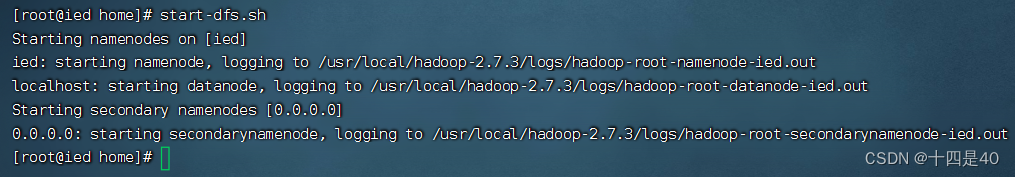

2.启动HDFS服务

执行命令:start-dfs.sh 命令

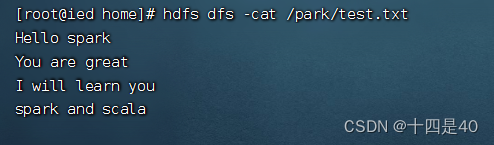

3.上传文件到HDFS

将文件 test.txt 传到HDFS的 /park 目录里

并查看

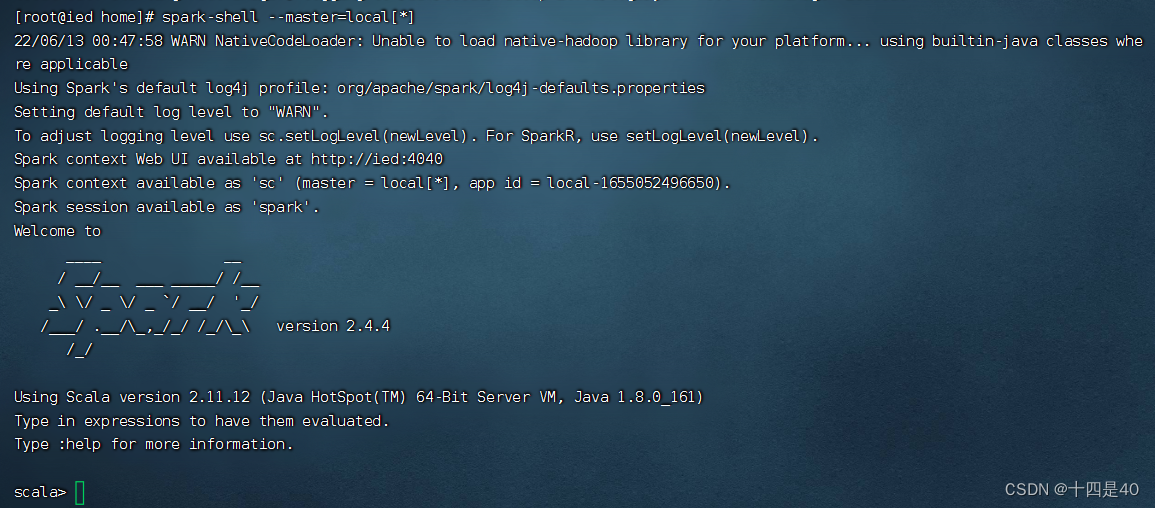

(二)启动Spark Shell

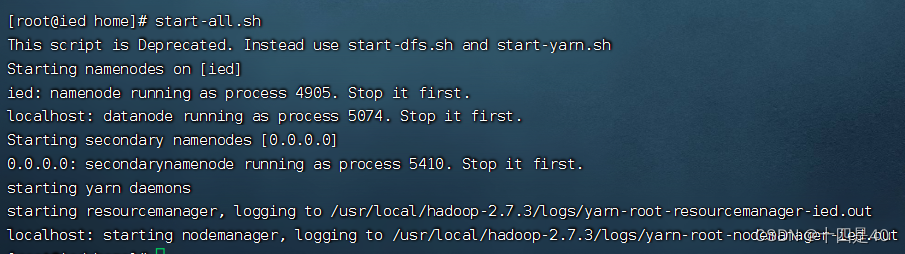

1.启动Spark服务

执行命令:start-all.sh

2.启动Spark Shell

执行命令:spark-shell --master=local[*]

查看Spark Shell的WebUI界面

三、创建RDD

(一)从对象集合创建RDD

1.利用parallelize()方法创建RDD

执行命令:val rdd = sc.parallelize(List(1, 2, 3, 4, 5, 6, 7, 8))

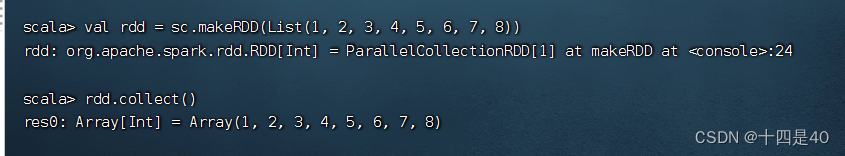

2.利用makeRDD()方法创建RDD

执行命令:val rdd = sc.makeRDD(List(1, 2, 3, 4, 5, 6, 7, 8))

执行命令:rdd.collect(),收集rdd数据进行显示

(行动算子[action operator]collect()的括号可以省略)

(二)从外部存储创建RDD

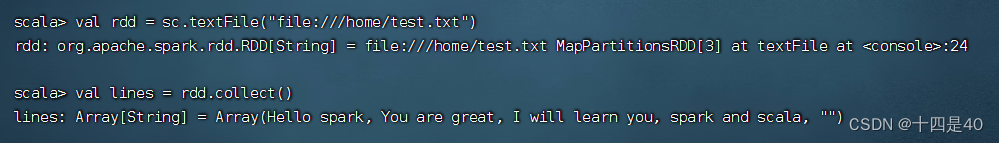

1.读取本地系统文件

执行命令:val rdd = sc.textFile("file:///home/test.txt")

执行命令:val lines = rdd.collect(),查看RDD中的内容,保存到常量lines

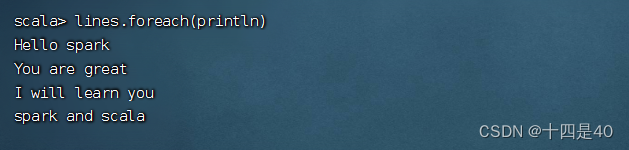

执行命令:lines.foreach(println)(利用foreach遍历算子)

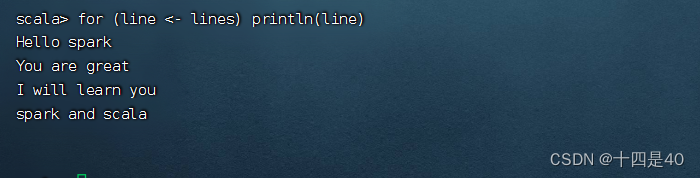

执行命令:for (line <- lines) println(line)

2.读取HDFS上的文件

执行命令:val rdd = sc.textFile("hdfs://master:9000/park/test.txt")

执行命令:val lines = rdd.collect,查看RDD中的内容

获取包含spark的行,执行命令:val sparkLines = rdd.filter(_.contains("spark"))

利用遍历算子显示sparkLines内容

总结

以上就是本文内容