Abstract

基于学习的多视图立体 (MVS) 方法将源图像扭曲到参考相机的视锥中以形成 3D volume,这些volume融合为从cost volume,由后续网络进行正则化。融合步骤在连接 2D 语义和 3D 空间关联方面起着至关重要的作用。然而,以前的方法利用额外的网络来学习 2D 信息作为融合线索,未充分利用 3D 空间相关性并带来额外的计算成本。因此,提出了 MVSTER,它利用所提出的对极 Transformer 来有效地学习 2D 语义和 3D 空间关联。具体来说,极线transformer利用可拆卸的单目深度估计器来增强 2D 语义,并使用交叉注意力沿极线构建数据相关的 3D 关联。此外,MVSTER 构建在级联结构中,其中利用熵正则化的最优传输在每个阶段传播更精细的深度估计。大量实验表明,MVSTER 以显着更高的效率实现了最先进的重建性能。与 MVSNet 和 CasMVSNet 相比,我们的 MVSTER 在 DTU 基准上实现了 34% 和 14% 的相对改进,运行时间相对减少了 80% 和 51%。 MVSTER 在 Tanks&Temples-Advanced 的所有已发表作品中也排名第一。

1. Introduction & 2. Related Work

主要贡献:

- 我们提出了一种新颖的基于 Transformer 的端到端多视图立体方法,名为 MVSTER。 它利用提出的极线Transformer来有效地学习沿极线的 3D 关联。

- 辅助单目深度估计器用于指导查询特征在训练期间学习深度判别信息,这增强了特征语义,但不会带来效率降低。

- 我们将深度估计制定为一个深度感知分类问题,并使用熵正则化最优传输来解决它,这会产生在级联结构中传播的更精细的深度估计。

- 在 DTU、Tanks&Temples、BlendedMVS 和 ETH3D 上进行的大量实验表明,我们的方法比现有方法实现了卓越的性能和显着更高的效率。

此外介绍了learning-based MVS、3D视觉中的Transformer的一些背景。

3. Method

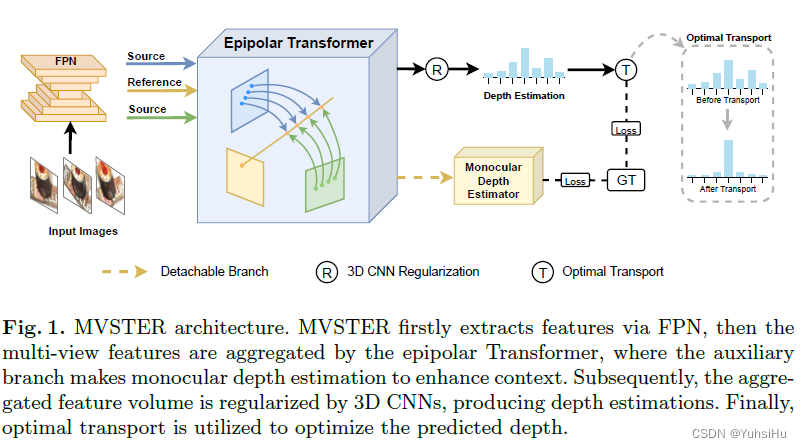

整体架构如图:

3.1 2D Encoder and 3D Homography

介绍了问题的定义与homography warping。

3.2 Epipolar Transformer

介绍如何使用epipolar transformer来把来自各个视角的source volumes融合。原始transformer的注意力函数可以被描述为把query和一系列key-value对映射为输出。相似地,在推出的epipolar transformer中,reference feature被用作用户query来匹配沿epipolar line的source feature(keys),从而增强相应的深度值。具体而言,我们通过单目深度估计的辅助任务来丰富reference query。 随后,交叉注意力在极线约束下计算query和source volumes之间的关联,生成注意力引导以聚合来自不同视图的feature volumes。 然后,通过轻量级 3D CNN 对聚合特征进行正则化。 下面,我们首先给出query构造的细节,然后详细说明对极 Transformer 引导的特征聚合。 最后给出了轻量级正则化策略。

Query Construction

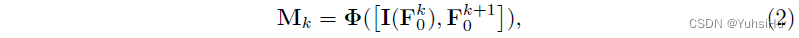

如前所述,我们将reference feature视为对epipolar transformer的query。 然而,由浅层 2D CNN 提取的特征在非朗伯和低纹理区域的判别性降低。 为了解决这个问题,一些方法利用昂贵的 DCN 或 ASPP 来丰富功能。 相比之下,我们提出了一种更有效的方法来增强我们的确认样:构建一个辅助单目深度估计分支来规范查询并学习深度判别特征。 在我们的辅助分支中应用了单目深度估计任务中使用的通用解码器。 给定通过 FPN 提取的多尺度参考特征,我们通过插值扩展低分辨率特征图,并将其与后续尺度特征连接。 聚合的特征图被输入回归头以进行单目深度估计:

其中 Φ ( ⋅ ) Φ(·) Φ(⋅)是单目深度解码器, I ( ⋅ ) I(·) I(⋅)是插值函数, [ ⋅ , ⋅ ] [·,·] [⋅,⋅]表示连接操作。 随后,针对不同尺度的查询单目深度估计。 值得注意的是,这种辅助分支仅用于训练阶段,指导我们的网络学习深度感知特征。

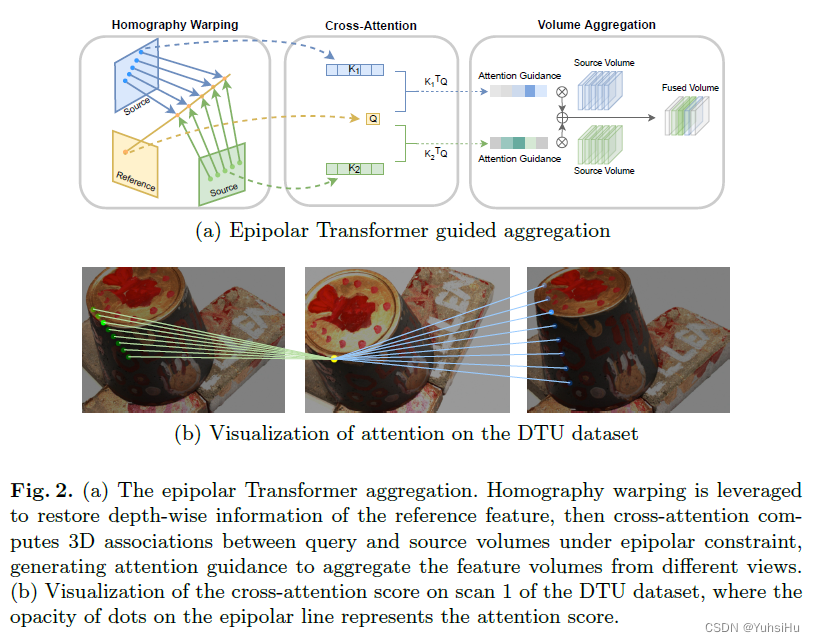

Epipolar Transformer Guided Aggregation

Pipeline如图 2(a) 所示,旨在构建查询特征的 3D 关联。 然而,深度方向的 3D 空间信息不是由 2D 查询特征图明确传递的,因此我们首先通过homography warping恢复深度信息。 根据等式(1)中的warp操作,将查询特征 p r p_{r} pr的假设深度位置投影到源图像极线上,得到source volume features { p s i , j } j = 0 D − 1 {\{p_{s_{i},j}}\}^{D−1}_{ j=0} {

psi,j}j=0D−1 ,即对epipolar transformer的key。因此,沿极线的关键特征被用来构建查询特征的深度 3D 关联,这是通过交叉注意力操作实现的:

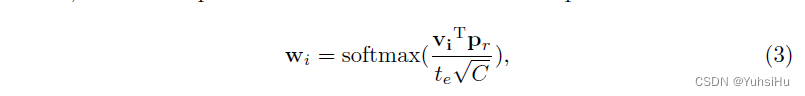

其中 v i v_{i} vi是沿着深度维度堆叠 { p s i , j } j = 0 D − 1 {\{p_{s_{i},j}}\}^{D−1}_{ j=0} {

psi,j}j=0D−1计算得到的, t e t_{e} te是温度参数, w i w_{i} wi是注意力相关的query和keys。我们在图 2(b)中可视化了一个真实图像的示例,其中注意力集中在极线上最匹配的位置。

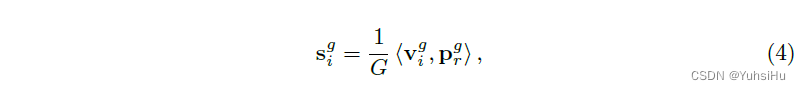

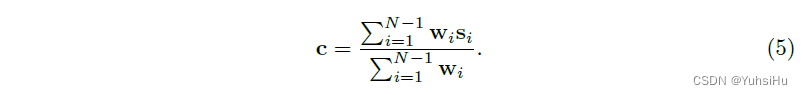

计算出的query和keys之间的注意力 w i w_{i} wi 用于聚合values。对于 Transformer 的value设计,我们遵循 [55,60,71] 使用分组相关性,它以有效的方式测量reference feature和source volumes之间的视觉相似性。

最后,通过epipolar attention score w i w_{i} wi 聚合values以确定final cost volume:

总之,对于所提出的对极 Transformer,首先利用可分离的单目深度估计分支来增强深度判别 2D 语义,然后利用查询和键之间的交叉注意力来构建深度方向的 3D 关联。 最后,组合的 2D 和 3D 信息用作聚合不同视图的指导。 如等式(3)-(5)所示,epipolar Transformer被设计为一个高效的聚合模块,其中没有引入可学习的参数,并且epipolar Transformer只学习数据相关的关联。

Lightweight Regularization

由于非朗伯表面或物体遮挡,原始cost volume容易受到噪声污染。 为了平滑最终的深度图,使用 3D CNN 来规范成本量。 考虑到我们已将 3D 关联嵌入到cost volume中,在我们的 3D CNN 中省略了深度特征编码,这使其更有效。 具体来说,我们将卷积核大小从 3 × 3 × 3 3 × 3 × 3 3×3×3 减小到 3 × 3 × 1 3 × 3 × 1 3×3×1,仅沿特征宽度和高度聚合成本量。 正则化概率体积 P ∈ R H × W × D P ∈ \mathbb{R}^{H×W×D} P∈RH×W×D 在每像素深度置信度预测中是非常理想的,它被用来在级联结构中进行深度估计。

3.3 Cascade Depth Map Propagation

使用了4个级联的结构来做推断。 H × W × 64 H × W × 64 H×W×64, H / 2 × W / 2 × 32 H/2×W/2 × 32 H/2×W/2×32, H / 4 × W / 4 × 16 H/4 × W/4 × 16 H/4×W/4×16, H / 8 × W / 8 × 8 H/8 × W/8 × 8 H/8×W/8×8。

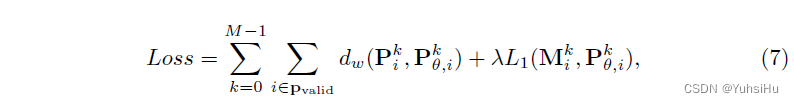

3.4 Loss