1、神经网络如何防止过拟合?

你这个问题本来就问的很模糊,你是想问神经网络的过拟合变现什么样还是为什么出现过拟合呢。为此针对于第一个问题,神经网络的过拟合与支持向量机、高斯混合模型等建模方法的过拟合类似,表现为针对于训练数据集的建模效果很好,而对于测试数据集的建模效果很差,因为过于强大的学习能力是的预测模型中的噪声将有用信息湮没了,致使泛化能力很差。

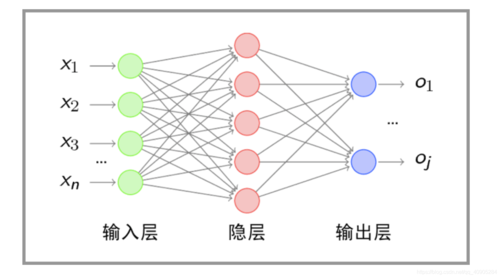

针对于第二个问题,出现上述现象的主要原因在于隐层节点数太多(隐层节点数越多,学习能力越强),使得预测模型在训练时候将训练数据集中的噪声也挖掘出来了,也就是噪声将有用信息湮没了。

所以在使用神经网络进行建模时一定要处理好模型过拟合的问题,可以一方面增加数据的样本集,另一方面采用交叉验证选择合适的隐层节点数,在精度与泛化能力之间做一个权衡,最常用的方法就是增加正则化项,一定程度上可以防止模型的过拟合问题。(+机器学习算法与Python学习)

2、神经网络,什么过拟合?,什么是欠拟合?

相关介绍:

人工神经网络(ANN)或联结主义系统是受构成动物大脑的生物神经网络的启发但不完全相同的计算系统。这种系统通过例子来“学习”执行任务,而不用特定于任务的规则进行编程。

例如,在图像识别中,人工神经网络可能会通过分析一些图像样本来学习识别包含猫的图像,这些图像被手工标记为“猫”或“不是猫”,并使用结果识别在其他图像中的猫。

他们这样做是在没有猫的任何先验知识的情况下进行的,例如,它们有毛皮,尾巴,胡须和类似猫的脸。相反,人工神经网络会自动从它们处理的学习材料中生成识别特征。

人工神经网络是基于称为人工神经元的连接单元或节点所构成的集合,这些单元或节点松散地模拟生物大脑中的神经元。像生物大脑中的突触一样,每个连接可以将信号从一个人工神经元传输到另一个人工神经元。接收信号的人工神经元可以对其进行处理,然后向与之相连的附加人造神经元发出信号。

3、如何防止神经网络过拟合,用什么方法可以防止?

你这个问题本来就问的很模糊,你是想问神经网络的过拟合变现什么样还是为什么出现过拟合呢。为此针对于第一个问题,神经网络的过拟合与支持向量机、高斯混合模型等建模方法的过拟合类似,表现为针对于训练数据集的建模效果很好,而对于测试数据集的建模效果很差,因为过于强大的学习能力是的预测模型中的噪声将有用信息湮没了,致使泛化能力很差。

针对于第二个问题,出现上述现象的主要原因在于隐层节点数太多(隐层节点数越多,学习能力越强),使得预测模型在训练时候将训练数据集中的噪声也挖掘出来了,也就是噪声将有用信息湮没了。

所以在使用神经网络进行建模时一定要处理好模型过拟合的问题,可以一方面增加数据的样本集,另一方面采用交叉验证选择合适的隐层节点数,在精度与泛化能力之间做一个权衡,最常用的方法就是增加正则化项,一定程度上可以防止模型的过拟合问题。(+机器学习算法与Python学习)

欠拟合是指模型不能在训练集上获得足够低的误差神经网络数据过拟合。而过拟合是指训练误差和测试误差之间的差距太大。

4、神经网络,什么过拟合?,什么是欠拟合?

欠拟合是指模型不能在训练集上获得足够低的误差。而过拟合是指训练误差和测试误差之间的差距太大。

通过调整模型的容量(capacity),我们可以控制模型是否偏向于过拟合或者欠拟合。通俗地,模型的容量是指其拟合各种函数的能力。容量低的模型可能很难拟合训练集。容量高的模型可能会过拟合,因为记住了不适用于测试集的训练集性质。

5、神经网络过拟合的意思?

过拟合现象一般都是因为学习的过于精确,就好比让机器学习人脸,取了100个人的脸训练,但是由于你学习的过精确,导致除了这个样本100人外 其他的人脸神经网络都认为不是人脸,实际我们只需要学习人脸的基本特征 而不是详细到人的皮肤细腻 眼睛大小等过于细致的特征,这样可以保证机器还是能识别别的图片中的人脸的

6、什么是「过拟合」,如何判断,常见的原因是什么?

从标准定义来说,过拟合是指,给定一个假设空间H,一个假设h属于H,如果存在其他的假设h’属于H,使得在训练样例上h的错误率比h’小,但在整个实例分布上h’比h的错误率小,那么就说假设h过度拟合训练数据。判断方法是,模型在验证集合上和训练集合上表现都很好,而在测试集合上变现很差。

常见原因主要是学习过度和样本特征不均衡,如果细分,还可以包括(并未能列举全部原因)。

1、建模样本选取有误,样本标签错误等,导致选取的样本数据不足以代表预定的分类规则。

2、样本噪音干扰过大,使得机器将学习了噪音,还认为是特征,从而扰乱了预设的分类规则。

3、假设的模型无法合理存在,或者说是假设成立的条件实际并不成立。

4、参数太多,模型复杂度过高。

5、对于tree-based模型,如果我们对于其深度与split没有合理的限制,有可能使节点只包含单纯的事件数据(event)或非事件数据(no event),使其虽然可以完美匹配(拟合)训练数据,但是无法适应其他数据集。

6、对于神经网络模型,权值学习迭代次数太多(Overtraining),BP算法使权值可能收敛过于复杂的决策面。

解决方法,模型上,神经网络加dropout,batch normalization,基于树的模型限制深度,加入正则化项等,设置提前终止条件。数据上,增加数据集,对数据集进行增强处理(augmentation)。

7、神经网络的遗传算法可以防止过拟合嘛?

你好,遗传算法在一定程度上可以防止过拟合。

遗传算法主要是针对神经网络的优化的。他是通过交叉和突变来实现对神经网络的优化。

过拟合其实是说模型太过严格,泛化不够。容错性不够好。

因为遗传算法通过交叉和突变,他可以提升模型的泛化能力。