分类目录:《机器学习中的数学》总目录

相关文章:

· 病态

· 局部极小值

· 高原、鞍点和其他平坦区域

· 梯度消失和梯度爆炸

· 非精确梯度

· 局部和全局结构间的弱对应

迄今为止,我们讨论的许多问题都是关于损失函数在单个点的性质——若 J ( θ ) J(\theta) J(θ)是当前点 θ \theta θ的病态条件,或者 θ \theta θ在悬崖中,或者 θ \theta θ是一个下降方向不明显的鞍点,那么会很难更新当前步。

如果该方向在局部改进很大,但并没有指向代价低得多的遥远区域,那么我们有可能在单点处克服以上所有困难,但仍然表现不佳。Goodfellow等人认为大部分训练的运行时间取决于到达解决方案的轨迹长度。如下图所示,学习轨迹将花费大量的时间探寻一个围绕山形结构的宽弧。

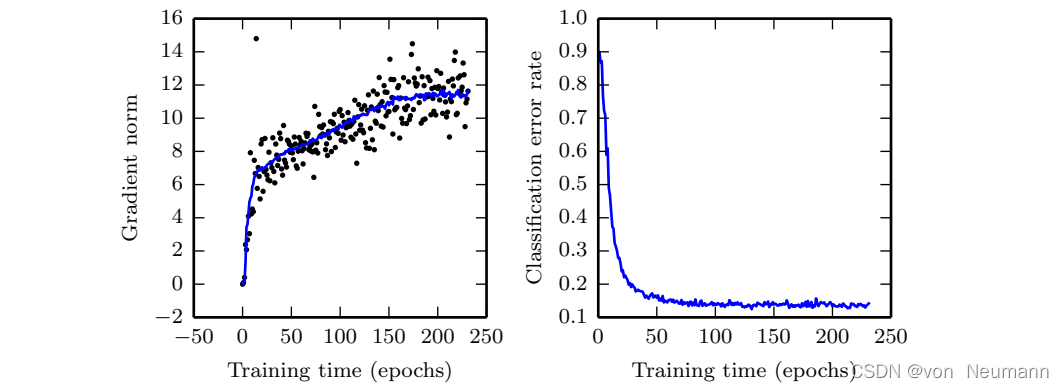

大多数优化研究的难点集中于训练是否找到了全局最小点、局部极小点或是鞍点,但在实践中神经网络不会到达任何一种临界点。下图表明神经网络通常不会到达梯度很小的区域。甚至,这些临界点不一定存在。例如,损失函数 − log p ( y ∣ x ; θ ) -\log p(y|x;\theta) −logp(y∣x;θ)可以没有全局最小点,而是当随着训练模型逐渐稳定后,渐近地收敛于某个值。对于具有离散的 y y y和Softmax分布 p ( y ∣ x ) p(y|x) p(y∣x)的分类器而言,若模型能够正确分类训练集上的每个样本,则负对数似然可以无限趋近但不会等于零。同样地,实值模型 p ( y ∣ x ) = N ( y ; f ( θ , β − 1 ) ) p(y|x)=N(y;f(\theta,\beta^{-1})) p(y∣x)=N(y;f(θ,β−1))的负对数似然会趋向于负无穷——如果 f ( θ ) f(\theta) f(θ)能够正确预测所有训练集中的目标 y y y,学习算法会无限制地增加 β \beta β。上图给出了一个失败的例子,即使没有局部极小值和鞍点,该例还是不能从局部优化中找到一个良好的代价函数值。

未来的研究需要进一步探索影响学习轨迹长度和更好地表征训练过程的结果。许多现有研究方法在求解具有困难全局结构的问题时,旨在寻求良好的初始点,而不是开发非局部范围更新的算法。

梯度下降和基本上所有的可以有效训练神经网络的学习算法,都是基于局部较小更新。之前的小节主要集中于为何这些局部范围更新的正确方向难以计算。我们也许能计算目标函数的一些性质,如近似的有偏梯度或正确方向估计的方差。在这些情况下,难以确定局部下降能否定义通向有效解的足够短的路径,但我们并不能真的遵循局部下降的路径。目标函数可能有诸如病态条件或不连续梯度的问题,使得梯度为目标函数提供较好近似的区间非常小。在这些情况下,步长为 ϵ \epsilon ϵ的局部下降可能定义了到达解的合理的短路经,但是我们只能计算步长为 δ < < ϵ \delta<<\epsilon δ<<ϵ的局部下降方向。在这些情况下,局部下降或许能定义通向解的路径,但是该路径包含很多次更新,因此遵循该路径会带来很高的计算代价。有时,比如说当目标函数有一个宽而平的区域,或是我们试图寻求精确的临界点(通常来说后一种情况只发生于显式求解临界点的方法,如牛顿法)时,局部信息不能为我们提供任何指导。在这些情况下,局部下降完全无法定义通向解的路径。在其他情况下,局部移动可能太过贪心,朝着下坡方向移动,却和所有可行解南辕北辙,或者是用舍近求远的方法来求解问题。

不管哪个问题最重要,如果存在一个区域,我们遵循局部下降便能合理地直接到达某个解,并且我们能够在该良好区域上初始化学习,那么这些问题都可以避免。最终的观点还是建议在传统优化算法上研究怎样选择更佳的初始化点,以此来实现目标更切实可行。

一些理论结果表明,我们为神经网络设计的任何优化算法都有性能限制。通常这些结果不影响神经网络在实践中的应用。

一些理论结果仅适用于神经网络的单元输出离散值的情况。然而,大多数神经网络单元输出光滑的连续值,使得局部搜索求解优化可行。一些理论结果表明,存在某类问题是不可解的,但很难判断一个特定问题是否属于该类。其他结果表明,寻找给定规模的网络的一个可行解是很困难的,但在实际情况中,我们通过设置更多参数,使用更大的网络,能轻松找到可接受的解。此外,在神经网络训练中,我们通常不关注某个函数的精确极小点,而只关注将其值下降到足够小以获得一个良好的泛化误差。对优化算法是否能完成此目标进行理论分析是非常困难的。因此,研究优化算法更现实的性能上界仍然是学术界的一个重要目标。