1、LeNet - 5

1)LeNet 是在灰度图上训练的、所以其输入图像的 channel = 1

2)第一层卷积采用 6 个 5 * 5 的卷积核,stride(跨步)= 1、(在 1998 年、人们并不用 Padding,即 p = 0)

3)第一层池化采用 Average Pooling(平均池化),f = 2;s = 2

4)第二层卷积采用 16 个 5 * 5 的卷积核,s = 1,p = 0

5)第二层池化采用平均池化,f = 2,s = 2

6)全链接层采用 120 + 84 个神经元的组合

7)输出层可采用 Softmax 作为 10 分类器、但当时 LenNet 用的分类器现在很少用

2、LenNet 网络随着层数的深入、图像的 Height(h,高度,行数)与 Width(w,宽度,列数)逐渐下降、Channels(频道数)逐渐上升

3、LenNet 网络的连接模式

应用得非常普遍

4、以前人们常用 sigmoid / tanh 激活函数而不用 ReLU 激活函数

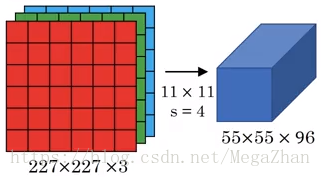

5、AlexNet

1)输入图像的 channel = 3

2)第一层卷积采用 96 个 11 * 11 的卷积核,stride(跨度)= 4

3)第一层池化采用 Max Pooling(最大池化),f = 3,s = 2

4)第二层卷积采用 Same Convolution,256 个 5 * 5 卷积核

5)第二层池化采用 Max Pooling,f * f = 3 * 3,s = 2

6)第三层卷积采用 Same Convolution,384 个 3 * 3 卷积核;再接一个 Same Convolution 卷积(384 个 3 * 3 卷积核);再接一个 Same Convolution 卷积(256 个 3 * 3 卷积核)

7)第三层池化采用 Max Pooling,f = 3,s = 2

8)全链接层 + Softmax 分类器

6、AlexNet 采用 ReLU 激活函数

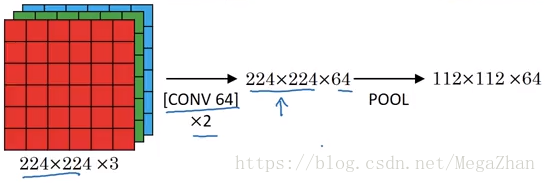

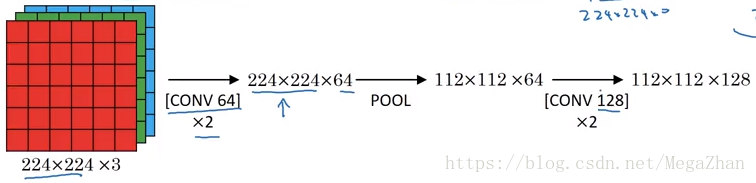

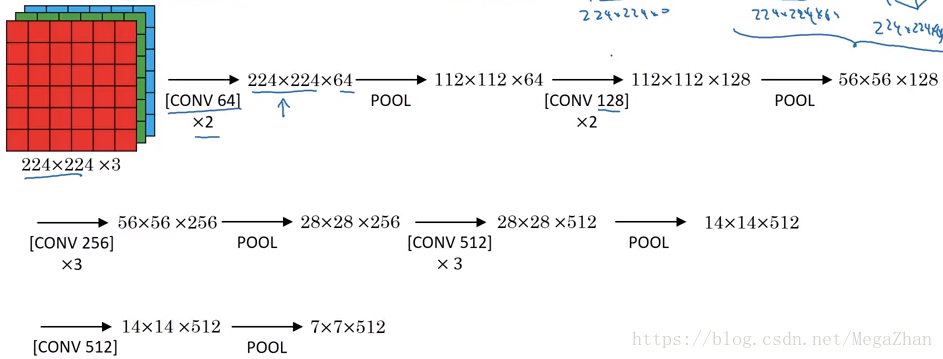

7、VGG - 16

· VGG - 16 网络所有层的卷积均采用 Same Convolution,3 * 3 的卷积核,stride = 1;所有层的池化均采用 Max Pooling,f = 2,s = 2

· VGG 的优点是模型简单

1)第一层采用两次卷积,每次卷积采用 64 个卷积核

2)第一层池化

3)第二层采用两次卷积,每次卷积采用 128 个卷积核

4)第二层池化

5)依此类推

6)Fully Connect(全链接)层 + Softmax 分类器

8、VGG - 16 中的 ‘16’代表有 16 个(含参数的)网络层