Spark 初识

从今天开始我们进入数据仓库的查询引擎篇了,前面我们已经写了大量的文章介绍Hive,具体你可以看hive 的专栏,而且关于工具这一块我们的重点就在hive 上,后面关于spark、presto、impala、clickHouse的介绍都不会像前面这样细了,因为我们的重点是在数仓建设的方法论上面,而不是工具上面。

Spark是什么

Spark 是一种高效且多用途的集群计算平台。换句话说,Spark 是一种开源的,大规模数据处理引擎。它提供了一整套开发 API,包括流计算、机器学习或者SQL。Spark 支持批处理和流处理。批处理指的是对大规模数据一批一批的计算,计算时间较长,而流处理则是一条数据一条数据的处理,处理速度可达到秒级。

Spark 集成了许多大数据工具,例如 Spark 可以处理任何 Hadoop 数据源,也能在 Hadoop 集群上执行。大数据业内有个共识认为,Spark 只是Hadoop MapReduce 的扩展(事实并非如此),如Hadoop MapReduce 中没有的迭代查询和流处理。然而Spark并不需要依赖于 Hadoop,它有自己的集群管理系统。更重要的是,同样数据量,同样集群配置,Spark 的数据处理速度要比 Hadoop MapReduce 快10倍左右,这主要是因为spark 强大的设计和对计算的优化。

Spark 的一个关键的特性是数据可以在内存中迭代计算,提高数据处理的速度。虽然Spark是用 Scala开发的,但是它对 Java、Scala、Python 和 R 等高级编程语言提供了开发接口。

Apache Spark演变

2009年,Spark 诞生于伯克利大学的AMPLab实验室。最初 Spark 只是一个实验性的项目,代码量非常少,属于轻量级的框架。

2010年,伯克利大学正式开源了 Spark 项目。

2013年,Spark 成为了 Apache 基金会下的项目,进入高速发展期。第三方开发者贡献了大量的代码,活跃度非常高。

2014年,Spark 以飞快的速度称为了 Apache 的顶级项目。

2015年至今,Spark 在国内IT行业变得愈发火爆,大量的公司开始重点部署或者使用 Spark 来替代MapReduce、Hive、Storm 等传统的大数据计算框架。

为什么使用Spark

Spark 诞生之前,在大数据处理领域,并没有一个通用的计算引擎。

离线批处理使用 Hadoop MapReduce

流处理需要使用 Apache Storm

即时查询使用 Impala 或者 Tez

执行图计算使用 Neo4j 或者 Apache Giraph

而Spark囊括了离线批处理、流处理、即时查询和图计算4大功能。

早期我们任务spark 是MR 替代品,这是因为MR 对数据集的处理并不高效,这主要体现在迭代算法和交互式查询,这两种场景下,如果能将数据保存到内存中都将极大的提高效率,从而避免每次都需要从HDFS 上将数据读取出来。

全

全,指的是 Spark 在计算场景的支持上非常全面。我们知道,在数据应用领域,有如下几类计算场景,它们分别是批处理、流计算、数据分析、机器学习和图计算。

批处理作为大数据的基础,自然不必多说了。与以往任何时候都不同,今天的大数据处理,对于延迟性的要求越来越高,流处理的基本概念与工作原理,是每一个大数据从业者必备的“技能点”。而在人工智能火热的当下,数据分析与机器学习也是我们必须要关注的重中之重。

对于这几类计算场景,Spark 提供了丰富的子框架予以支持。比如,针对流计算的 Structured Streaming,用于数据分析的 Spark SQL,服务于机器学习的 Spark MLlib,等等。Spark 全方位的场景支持,让开发者、在同一套计算框架之内,即可实现不同类型的数据应用,从而避免为了实现不同类型的数据应用,而疲于奔命地追逐各式各样的新技术、新框架。

快

快,有两个方面,一个是开发效率快,另一个是执行效率快。

Spark 支持多种开发语言,如 Python、Java、Scala、R 和 SQL,同时提供了种类丰富的开发算子,如 RDD、DataFrame、Dataset。这些特性让开发者能够像搭积木一样,信手拈来、驾轻就熟地完成数据应用开发。

第二个就是凭借 Spark Core 和 Spark SQL 这两个并驾齐驱的计算引擎,我们开发出的数据应用并不需要太多的调整或是优化,就能享有不错的执行性能,而这,主要得益于 Spark 社区对于底层计算引擎的持续打磨与优化,才让开发者能够把精力专注于业务逻辑实现,而不必关心框架层面的设计细节。

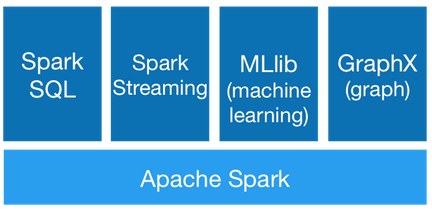

Spark组件

Spark提供了6大组件:

- Spark Core

- Spark SQL

- Spark Streaming

- Spark MLlib

- Spark GraphX

- SparkR

这些组件解决了使用Hadoop时碰到的特定问题。

Spark Core

将分布式数据抽象为弹性分布式数据集(RDD),实现了应用任务调度、RPC、序列化和压缩,并为运行在其上的上层组件提供API。所有Spark的上层组件(如:Spark SQL、Spark Streaming、MLlib、GraphX)都建立在Spark Core的基础之上,它提供了内存计算的能力,因此,Spark Core是分布式处理大数据集的基础。

Spark SQL

Spark Sql 是Spark来操作结构化数据的程序包,可以让我使用SQL语句的方式来查询数据,Spark支持 多种数据源,包含 Hive 表,parquest以及JSON等内容。

Spark Streaming

除了处理动态数据流,Spark Streaming 还能开发出强大的交互和数据查询程序。事实上,在处理动态数据流时,流数据会被分割成微小的批处理,这些微小批处理将会在Spark Core上按时间一个一个执行,且速度非常快。

Spark MLlib

Spark MLlib 封装了很多高效的机器学习算法。它是数据科学最热门的选择,因为它是在内存处理数据的,非常有效的提高数据迭代算法的性能。

Spark GraphX

Spark GraphX一个建立在Spark之上大规模处理图数据的计算引擎。

SparkR

SparkR 是一个 R 语言包,它提供了轻量级的方式使得可以在 R 语言中使用 Apache Spark。在Spark 1.4中,SparkR 实现了分布式的 data frame,支持类似查询、过滤以及聚合的操作(类似于R中的data frames:dplyr),但是这个可以操作大规模的数据集。

pySpark

是spark 提供的python 的api,而且最新的spark 将引入pandas 的api ,这算是对数据工作者的又一大福音。

spark 在数仓的应用

因为我们的课程是针对数仓的,所以我们这里介绍一下spark 在数仓里的应用,这主要是我们将spark作为一个高性能的查询引擎来使用,也就是说我们ETL 的工作可以使用spark 完成,但是这里的意思不是事说我们就不需要Hive 了,因为我们的数仓表涉及到大量的元数据,而spark 需要操作这些表就需要这些元数据,所以说在数仓里面我们的spark还是依赖Hive 的元数据的。

这里需要说明一下,spark本身事可以单独使用的,不需要依赖Hadoop,不需要依赖Hive,但是因为我们需要操作Hive 的表,所以依赖Hive,还有一点就是我们的Hive现在支持多种查询引擎,默认的就是MR,也就是我们俗称的Hive on MR,初次之外我们的Hive 还支持 TEZ 和 Spark 引擎。

数仓里使用Spark ,一般指的是使用Spark 的批计算,主要就是Spark-SQL, 这里我们强调的是主要,如果你学习了我们前面的文章的话,就知道我现在所在的公司里还是用到了Spark的Grap以及Spark 的其他的组件。

总结

Spark 作为一个批流一体的的计算引擎,虽然流计算上存在一定的缺陷,但是在当时的技术背景下它具有颠覆性的意义。

Spark凭借其完整的技术栈和强悍的性能在众多互联网公司中赢得了一席之地。