开放域QA

从大规模无监督文本中(千万级以上)通过检索+机器阅读理解的方法已经成为当前学术界和工业界研究的热点。一方面存在很多挑战,另一方面对于实际开放域问答有着非常重要的现实意义。目前主流检索平台(百度,谷歌,bing)已经实现和应用相关技术在线上的产品中。

从陈丹琦DrQA开始,越来越多顶会相关论文和工作发布。比较权威的数据库QAngaroo (Welblet al., 2018) and HOTPOTQA (Yang et al., 2018)

存在的挑战

1.一次检索,并不能检索出问题的所用支撑事实。提高第一次检索的准确率和产生多次相关检索成为该问题的研究重点。

2. 如何中到的文档中找到问题的答案成为第二个研究的重点。目前比较有效的方法是预训练语言模型。例如BERT、ALBERT、RoBERTa等。

本文介绍EMNLP2019 两篇关于开放域QA 的相关论文,论文创新点十足,同时也开源了相关代码。具有比较强的可读性和复现性。

GoldEn Retriever

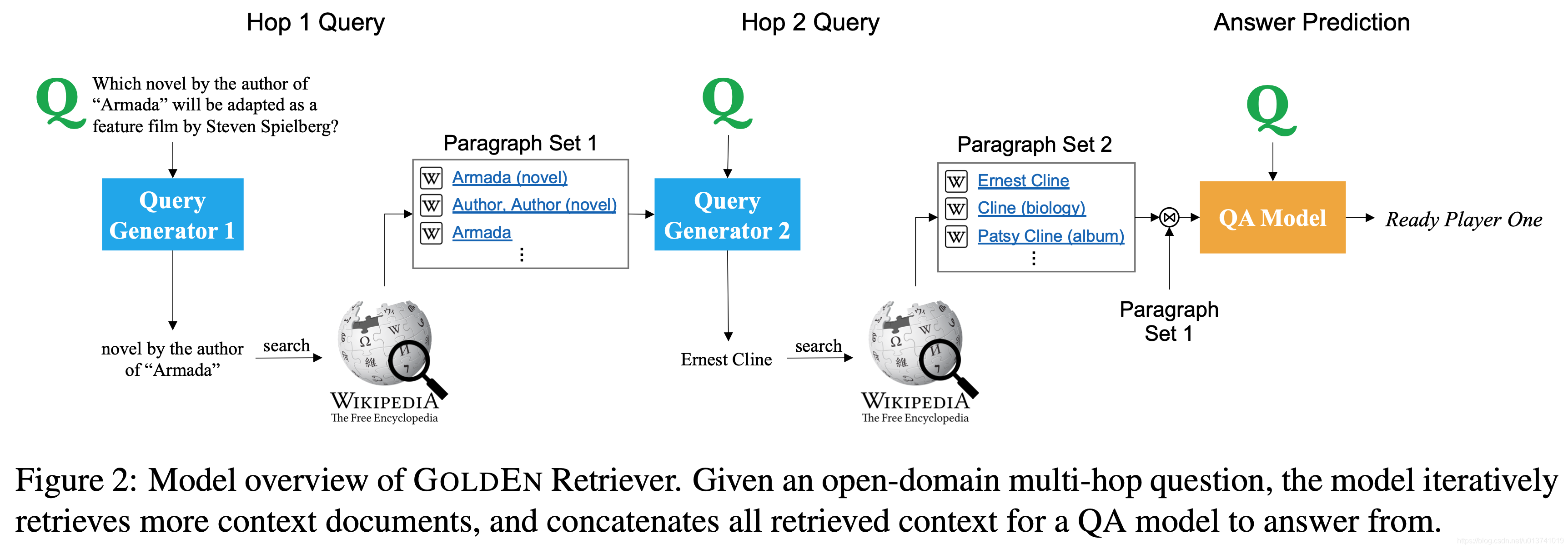

Answering Complex Open-domain Questions Through Iterative Query Generation

摘要(原文)

当前的一步检索-阅读问答(QA)系统面临着很大的挑战,回答诸如“史蒂芬·斯皮尔伯格要把《无敌舰队》的作者将把哪部小说改编成电影”之类的问题。因为这个问题很少包含可检索的线索缺失的实体(这里是作者)。回答这样一个问题需要多跳推理,其中一个必须收集缺少的实体(或事实)进一步的推理。我们提出了GoldEn Retriever,它在读取上下文和检索更多支持之间迭代回答开放域多跳的文档的问题。而不是使用不透明且计算昂贵的神经检索模型。GoldEn Retriever能产生自然语言搜索问题和可用的查询

上下文,并利用现有的信息检索系统来查询缺少的实体。这使得GoldEn Retriever可以伸缩.在保持可解释性的同时,高效地进行开放域多跳推理。我们评价GoldEn Retriever最近的表现提出的开放域多跳QA数据集,,并证明它比之前发布的最好的模型表现得更好,尽管没有使用预先训练好的语言模型如伯特。该文主要迭代生产查询的方式去寻找问题的支持依据,比传统一次检索能够回答更复杂的问题。

该文突出贡献点

- 该模型的核心创新之处在于,它在每一步都使用先前的IR结果来生成新的自然语言查询,并检索新的证据来回答原始问题,而不是单纯依靠原始问题来检索文章段落。从而实现多跳推理。

多跳检索的实现

去训练一个query生成模型代价十分大的,一方面目前有效的数据集不多,另一方面潜在的检索量十分大。

qk = Gk(q; Ck);

Ck+1 = Ck .+ IRn(qk)

IRn(qk) 是通过 qk检索到的前N篇文档

传统的训练过程是通过强化学习的方法去完成,强化学习本身具有计算复杂度高,方差高的特点。通常非常依赖前一步选择的query和IR 结果。

该文通过弱监督的数据去训练模型,在多跳检索模型中,当前检索内容,和下一步要检索的内容具有很强的语义相关性。

通过启发式的方法来生成新的查询。计算当前文档和候选文档最长公共子序列

SemanticRetrievalMR

Multi-passage BERT: A Globally Normalized BERT Model for Open-domain Question Answering

摘要(原文)

BERT模型已成功地应用于open-domain QA任务。但是,先前的工作通过将同一问题对应的段落作为独立的训练实例来训练BERT,这可能会导致不同答案的分数无法比较段落。为了解决这个问题,我们建议多篇BERT模型对同一个问题在所有文章的回答分数进行全局标准化。我们的QA模型通过使用更多的段落来找到更好的答案。另外,我们发现用把文章分成几段,通过滑动窗口输入100个单词可以提高4%的性能。为了选择高质量的段落,多段RoBERTa能够提升的2%。在四个标准基准上的实验表明,多段RoBERTa取得了SOTA。特别是在OpenSQuAD的数据集上,我们的模型对比非BERT,EM提升21.4%,F1提升21.5%,对比BERT-based模型5.8% EM和6.5% F1。

参考

GoldEn Retriever: Answering Complex Open-domain Questions Through Iterative Query Generation

Multi-passage BERT: A Globally Normalized BERT Model for

Open-domain Question Answering