文章目录

PaddleHub直击白嫖党的内心!快来试试哇!

1.快速安装paddlehub

pip install --upgrade paddlepaddle -i https://mirror.baidu.com/pypi/simple

pip install --upgrade paddlehub -i https://mirror.baidu.com/pypi/simple

2.在模型库中物色心仪的模型

PaddleHub模型库

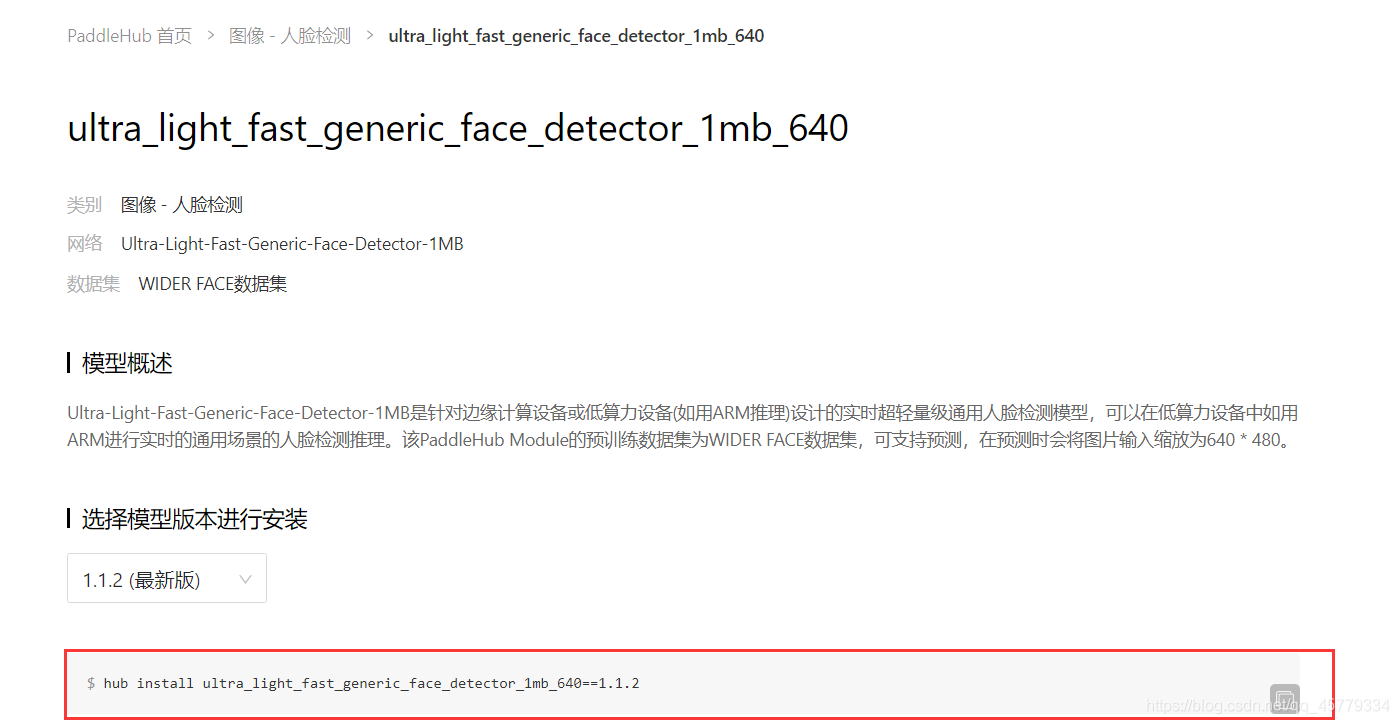

3.一键搞到模型

hub install XXXX

模型下有写具体命令,直接粘贴即可:

4.轻量级部署

(1)X86端(Windows或者Linux)

PaddleHub——Windows端用轻量代码实现调用预训练模型实现目标检测

(2)arm端(树莓派4B等)

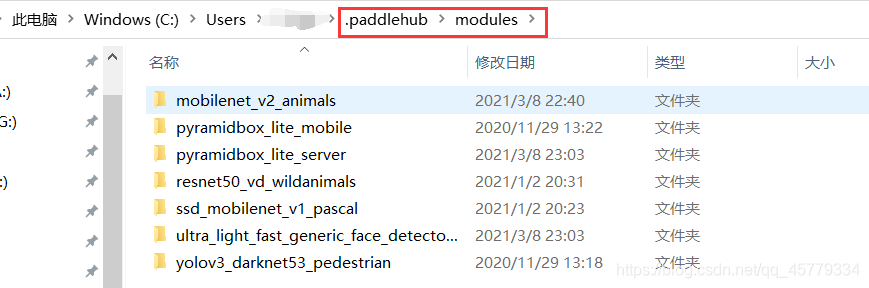

先将模型在Windows端下载下来,用hub install命令,然后找到模型,一般都在这个路径下:

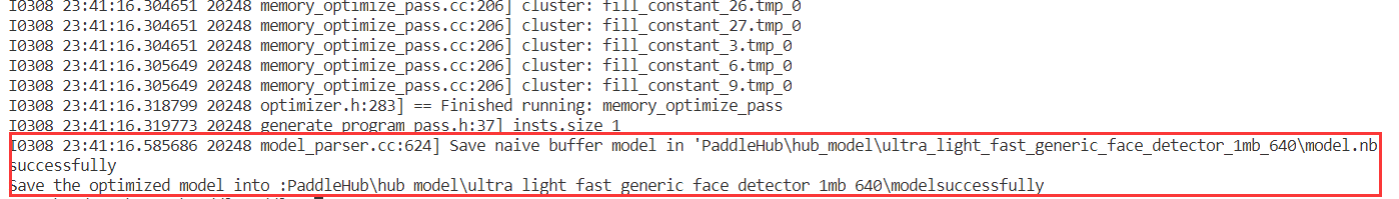

然后把模型使用opt工具转换一下,在Windows端直接写个py程序:

opt_preocess.py

# 引用Paddlelite预测库

from paddlelite.lite import *

# 1. 创建opt实例

opt=Opt()

# 2. 指定输入模型地址

opt.set_model_dir(r"PaddleHub\hub_model\ultra_light_fast_generic_face_detector_1mb_640\ultra_light_fast_generic_face_detector_1mb_640")

# 3. 指定转化类型: arm、x86、opencl、xpu、npu

opt.set_valid_places("arm")

# 4. 指定模型转化类型: naive_buffer、protobuf

opt.set_model_type("naive_buffer")

# 4. 输出模型地址

opt.set_optimize_out(r"PaddleHub\hub_model\ultra_light_fast_generic_face_detector_1mb_640\model")

# 5. 执行模型优化

opt.run()

然后就会生成arm端部署的model.nb模型,然后传送到arm(例如树莓派)端,通过Paddle Lite部署预测就行啦~

但需要注意的是,Paddle Lite的arm端不一定会支持某些模型的算子,所以不是所有的hub上的模型都能部署在arm端。

如果想进一步在树莓派上部署模型进行预测,可以参考我的博客:

- Paddle-Lite——在树莓派4B端(Raspi OS)基于python API部署Paddle模型

- Paddle-Lite——在树莓派4B端(Ubuntu18.04)源码编译并基于python API部署Paddle模型