代码参考:https://github.com/MVIG-SJTU/AlphaPose

文档很齐全,在docs目录下。

AlphaPose做姿态关键点检测,利用yolov3行人检测+姿态关键点检测。

AlphaPose多人姿态估计,利用yolov3行人检测+姿态关键点检测+行人重识别算法。

1.环境

ubuntu16.04

cuda9.0

torch==1.1.0

torchvision==0.3.0

opencv-python==4.1.0.25

tqdm

natsort

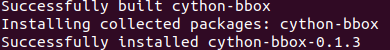

Cython

pycocotools

python setup.py build develop --user

apt-get update

apt-get -y install python3.6-tk2.模型准备

参考此处:https://github.com/MVIG-SJTU/AlphaPose/tree/master/trackers

(1)行人检测模型

yolov3-spp.weights模型下载,放到AlphaPose/detector/tracker/data/目录下。

(2)姿态关键点检测模型

https://github.com/MVIG-SJTU/AlphaPose/blob/master/docs/MODEL_ZOO.md

这里我选择:

| Model | Backbone | Detector | Input Size | AP | Speed | Download |

|---|---|---|---|---|---|---|

| Fast Pose (DCN) | ResNet50 - dcn | YOLOv3 | 256x192 | 72.8 | 2.94 iter/s | model 或者 我的链接 |

放到pretrained_models目录下。

(3)行人重识别模型(跟踪)

从这里下载,外网上不去。放到目录下:

trackers/weights/osnet_ain_x1_0_msmt17_256x128_amsgrad_ep50_lr0.0015_coslr_b64_fb10_softmax_labsmth_flip_jitter.pth

3.demo可视化测试

参考:https://github.com/MVIG-SJTU/AlphaPose/blob/master/docs/GETTING_STARTED.md / docs/GETTING_STARTED.md

python scripts/demo_inference.py --cfg configs/coco/resnet/256x192_res50_lr1e-3_2x-dcn.yaml --checkpoint pretrained_models/fast_dcn_res50_256x192.pth --indir examples/demo/ --vis --showbox --save_img运行这个,是对examples/demo目录下的几张图片上测试结果。

其中结果保存在examples/res/与examples/res/vis/目录下。

跟踪的话,在上面命令基础上加--pose_track:

python scripts/demo_inference.py --cfg configs/coco/resnet/256x192_res50_lr1e-3_2x-dcn.yaml --checkpoint pretrained_models/fast_dcn_res50_256x192.pth --indir examples/demo/ --vis --showbox --save_img --pose_track如果使用了很多图片或者一个视频,需要加上--sp参数。

python scripts/demo_inference.py --cfg configs/coco/resnet/256x192_res50_lr1e-3_2x-dcn.yaml --checkpoint pretrained_models/fast_dcn_res50_256x192.pth --indir examples/demo/ --vis --showbox --save_img --pose_track --sp