[yygq]

不会吧?不会吧?我也配看这篇论文???

[标题]

Dependency-based syntax-aware word representations

它的父亲:Syntax-Enhanced Neural Machine Translation with Syntax-Aware Word

[代码地址]

https://github.com/zhangmeishan/DepSAWR

[知识储备]

什么是异质性(heterogeneity):

什么是同质性(homogeneous):

dependency trees与constituent trees的转化:

什么是BIAFFINE DEPENDENCY PARSING: https://arxiv.org/pdf/1611.01734.pdf

什么是LAS:

什么是bootstrap resampling:

[一些问题]

Tree-RNN and Tree-Linearization approaches是什么?

目录

一、背景与概览

1.0 引言

聚合了丰富的依赖语法,而不是使用单一的解析树输出(利用了一个训练好的解析器的中间影藏层)

把上面得到的输出和常规的词向量做concatenate

1.1 相关研究

The importance of Syntactic information:

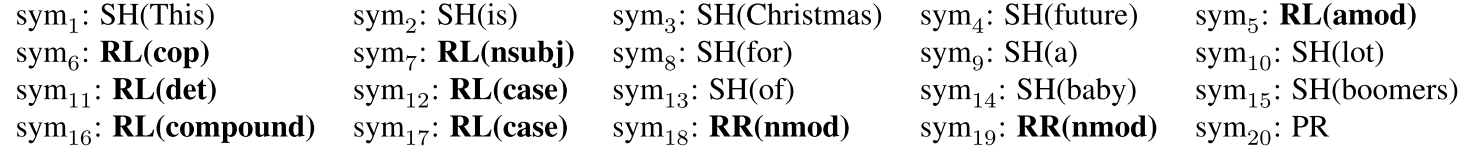

依赖语法能够缩短单词序列内部,单词和单词之间的距离,就比如下图中,future和boomers的距离从6,经过lot这个单词,变成了2.

统计学习方法:(这完全不懂)

神经网络方法:

- Tree-RNN:尽管这些方法是有效的,但由于依赖树的异质性,这些方法存在严重的效率低下问题。

- Tree-Linearization:这些方法首先将分层树输入线性化为顺序符号

上述神经网络的缺点是:使用parser建模了唯一一颗最好的解析树,给下游任务带去误差.

1.2 贡献点

提出以下模型:直接把Input送入Encoder(这该怎么送…),输出的向量经过归一化?简单的后处理?,然后和word embedding进行拼接? 进一步送入Decoder,预测同时,语法标签应该也要被送入Decoder(毕竟是标注好的数据,为何不用?),然后干什么就不知道了.

sentence classification task : BiLSTM+dependency syntax+ELMo or BERT representations

sentence matching task : ESIM+dependency syntax+ELMo or BERT representations

equence labeling task :BiLSTM-CRF+dependency syntax+ELMo or BERT representations

machine translation task : RNN-Search(?) / Transformer

复现了Tree-RNN和Tree-Linearization用于比较

1.3 相关工作

1.3.1 Tree-RNN

与Tree-RNN的不同点:

- 采用dependency trees而不是constituent trees

- 使用 non-leaf compositions

- 定义聚合操作,支持任意数量的子节点的递归组合

需要注意的是:

- x_i是 a concatenation of word embedding and dependency label embedding

- {L,R}意味着什么?

- 输出是h↑和h↓的concatenation

Tree-RNN的缺点是由于依赖树的异质性,批处理困难.

1.3.2 Tree linearization

进行以下两步操作:

- 维护已处理栈和未处理栈,最后合并相应的shift-reduce操作,得到symbols序列

- 将序列送入序列LSTM

流程如下:从This开始,通过SH action把单词加入Stack,如果遇到一个单词,它有自己的左子树,则从右往左,依次执行RL,来建立单词和单词之间的连边,遍历到最后一个单词之后,开始往回走,找到有自己的右子树的单词,依次(从左往右?)执行RR,最后加入PR.(这都让我看懂了?真的很佩服张教授等人)

关于embedding:

- 使用ELMo and BERT来得到单词对应的SH操作的向量表示

- 其它符号有自己的向量表示

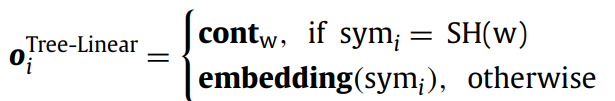

啊,模型的公式化描述如下,模型学习啥,学习sym的embedding么…

二、模型

2.1 BiAffine dependency parser

2.2 Dep-SAWR

虚线部分没有training object,Encoder的输入也就是单词序列啊,然后经过所谓的Bilstm和Linear,得到o_encoder,进一步得到projected之后的word representation,去与原来的embedding做concatenation. 那它的dependency parse tree的先验知识去哪儿了?

三、实验与评估

3.1 任务一:Sentence classification

word embedding+bilstm+pooling,其中,词嵌入部分尝试了glove、bert和elmo

3.2 任务二:Sentence matching

以ESIM模型为例:

3.3 任务三:sequence labeling

以BILSTM+CRF为例

3.4 任务四:machine translation

机器翻译不太懂

3.5 其它细节

- 在三种语言上进行了实验

- 英文:Glove300\ELMO\BERT

- 中文:自己预训练???..

- 德文:FastText\ELMO\BERT

- 关于bert

平均了word piece来得到单词的向量表示 - 关于先验

对BiAffine dependency parsing model进行预训练 具体怎么训练? LAS指标是什么?