第四阶段:Hadoop部署

第一步:上传压缩包并解压

将hadoop包上传到第一台服务器并解压 第一台机器执行以下命令

cd /bigdata/soft/

tar -zxvf hadoop-2.6.0-cdh5.14.2.tar.gz -C /bigdata/install/第二步:查看hadoop支持的压缩方式以及本地库

第一台机器执行以下命令

cd /bigdata/install/hadoop-2.6.0-cdh5.14.2

bin/hadoop checknative

结果如下:

hadoop: true /bigdata/install/hadoop-2.6.0-cdh5.14.2/lib/native/libhadoop.so.1.0.0

zlib: true /lib64/libz.so.1

snappy: true /lib64/libsnappy.so.1

lz4: true revision:10301

bzip2: true /lib64/libbz2.so.1

openssl: false Cannot load libcrypto.so (libcrypto.so: cannot open shared object file: No such file or directory)!

如果出现openssl为false,那么所有机器在线安装openssl即可,执行以下命令,虚拟机联网之后就可 以在线进行安装了

yum -y install openssl-devel

第三步:修改配置文件

第一台机器执行以下命令

cd /bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop

vi core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://node01:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/tempDatas</value>

</property>

<!-- 缓冲区大小,实际工作中根据服务器性能动态调整 -->

<property>

<name>io.file.buffer.size</name>

<value>4096</value>

</property>

<!-- 开启hdfs的垃圾桶机制,删除掉的数据core可以从垃圾桶中回收,单位分钟 -->

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

</configuration>

第一台机器执行以下命令

cd /bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop

vi hdfs-site.xml

<configuration>

<!-- NameNode存储元数据信息的路径,实际工作中,一般先确定磁盘的挂载目录,然后多个目录用,进行分割 -->

<!-- 集群动态上下线

<property>

<name>dfs.hosts</name>

<value>/bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop/accept_host</value>

</property>

<property>

<name>dfs.hosts.exclude</name>

<value>/bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop/deny_host</value>

</property>

-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node01:50090</value>

</property>

<property>

<name>dfs.namenode.http-address</name>

<value>node01:50070</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/namenodeDatas</value>

</property>

<!-- 定义dataNode数据存储的节点位置,实际工作中,一般先确定磁盘的挂载目录,然后多 个目录用,进行分割 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/datanodeDatas</value>

</property>

<property>

<name>dfs.namenode.edits.dir</name>

<value>file:///bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/nn/edits</value>

</property>

<property>

<name>dfs.namenode.checkpoint.dir</name>

<value>file:///bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/snn/name</value>

</property>

<property>

<name>dfs.namenode.checkpoint.edits.dir</name>

<value>file:///bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/nn/snn/edits</value>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<property>

<name>dfs.blocksize</name>

<value>134217728</value>

</property>

</configuration>修改hadoop-env.sh

第一台机器执行以下命令

cd /bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop

vi hadoop-env.sh

export JAVA_HOME=/bigdata/install/jdk1.8.0_141修 改 mapred-site.xml 第一台机器执行以下命令

cd /bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop

cp mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.job.ubertask.enable</name>

<value>true</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>node01:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node01:19888</value>

</property>

</configuration>

第一台机器执行以下命令

cd /bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop

vi yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>node01</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

第一台机器执行以下命令

cd /bigdata/install/hadoop-2.6.0-cdh5.14.2/etc/hadoop

vi slaves

node02

node03

第四步:创建文件存放目录

第一台机器执行以下命令

node01机器上面创建以下目录

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/tempDatas

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/namenodeDatas

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/datanodeDatas

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/nn/edits

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/snn/name

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/nn/snn/edits

第五步:安装包的分发

第一台机器执行以下命令

cd /bigdata/install/

scp -r hadoop-2.6.0-cdh5.14.2/ node02:$PWD

scp -r hadoop-2.6.0-cdh5.14.2/ node03:$PWD

第六步:配置hadoop的环境变量

三台机器都要进行配置hadoop的环境变量三台机器执行以下命令

vi /etc/profile

export HADOOP_HOME=/bigdata/install/hadoop-2.6.0-cdh5.14.2

export PATH=:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

配置完成之后生效

source /etc/profile

第七步:集群启动

要启动 Hadoop 集群,需要启动 HDFS 和 YARN 两个集群。

注意:首次启动HDFS时,必须对其进行格式化操作。本质上是一些清理和准备工作,因为此时的

HDFS 在物理上还是不存在的。

在node01上执行以下命令

hdfs namenode -format如果配置了 etc/hadoop/slaves 和 ssh 免密登录,则可以使用程序脚本启动所有Hadoop 两个集群的相关进程,在主节点所设定的机器上执行。

启动集群

node01节点上执行以下命令

start-all.sh

第八步:浏览器查看启动页面

hdfs集群访问地址

http://192.168.173.100:50070/dfshealth.html#tab-overview

结果如下:

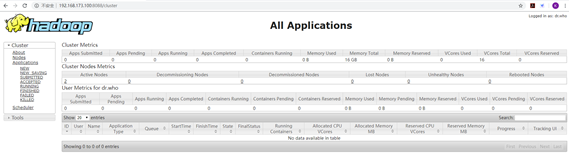

yarn集群访问地址

http://192.168.173.100:8088/cluster

结果如下:

在node1上通过以下命令启动日志服务器

mr-jobhistory-daemon.sh start historyserver有了日志服务器,以后在运行MR出错时,就可以调出错误信息了。

mr-jobhistory-daemon.sh stop historyserver错误处理(按照步骤来一般不会出错的哦~)

如果出现错误,可以通过查看history解决

处理方式:

第1步: 通过stop-all.sh关闭服务

第2步: 分别删除3个节点上的hadoopDatas目录

rm -rf /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/第3步: 分别在3个节点,通过以下命令创建生成相应的目录

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/tempDatas

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/namenodeDatas

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/datanodeDatas

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/nn/edits

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/snn/name

mkdir -p /bigdata/install/hadoop-2.6.0-cdh5.14.2/hadoopDatas/dfs/nn/snn/edits第4步:格式化

通过hdfs namenode -format重新格式化分布式系统

第5步:启动服务

start-all.sh第6步:创建相应的目录,并上传文件

hdfs dfs -mkdir -p /bigdata1/input第7步:在install目录下面执行以下命令:

hadoop jar MapReduceDemo-1.0-SNAPSHOT.jar com.css.bigdata.mr.WordCount第8步:查看打印的信息

20/05/17 12:17:54 INFO mapreduce.Job: Job job_1589688960173_0002 completed successfully

第9步:查看生成的文件

[root@node01 install]# hdfs dfs -ls /bigdata1/out_result

Found 2 items

-rw-r--r-- 2 root supergroup 0 2020-05-17 12:17 /bigdata1/out_result/_SUCCESS

-rw-r--r-- 2 root supergroup 32 2020-05-17 12:17 /bigdata1/out_result/part-r-00000

第10步:查看文件内容

[root@node01 install]# hdfs dfs -cat /bigdata1/out_result/part-r-00000

China 1

I 2

am 2

bruce 1

from 1

软件及视频链接:https://pan.baidu.com/s/1pEHcwWB51BhiYT8S7AQ1Lg

提取码:2580