1.内存中创建

代码如下(示例):

object MakeRdd {

def main(args: Array[String]): Unit = {

val spark = SparkSession

.builder

.master("local")

.appName("make rdd")

.getOrCreate()

val sc = spark.sparkContext;

val seq = Seq[Int](1,2,3,4)

// parallelize是并行的意思,但是在这里不太好理解

// 因此出了makeRDD 方法,和parallelize的效果一样,在makeRDD 里面就是调用的parallelize方法

val value : RDD[Int] = sc.parallelize(seq)

val value2 : RDD[Int] = sc.makeRDD(seq)

// 只有执行collect方法才会执行应用程序

value.collect().foreach(println);

}

}

1

2

3

4

2.文件创建

代码如下(示例):

def main(args: Array[String]): Unit = {

val spark = SparkSession

.builder

.master("local")

.appName("make rdd")

.getOrCreate()

// 指定文件

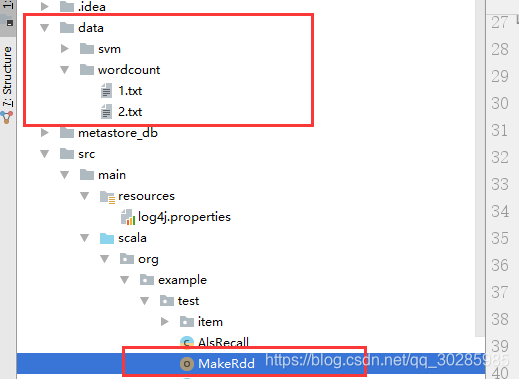

val value:RDD[String] = spark.sparkContext.textFile("data/wordcount/1.txt")

// 目录下的所有文件

val value2:RDD[String] = spark.sparkContext.wholeTextFiles("data/wordcount")

// 通配符的使用 只1-开头的所有文件。

val value3:RDD[String] = spark.sparkContext.textFile("data/wordcount/1-*.txt")

// hdfs中的文件

val value4:RDD[String] = spark.sparkContext.textFile("hdfs://linux1:")

// 只有执行collect方法才会执行应用程序

value.collect().foreach(println);

}

在读取文件夹内容时,通过textFile读取,会不知道内容的来源,这样通过wholeTextFiles方法读取,能获取到内容的来源。

相对路径的时候,注意文件位置