- 前言: …

-

目录

0 More Details: HomeLink

1 MobileNet-V1

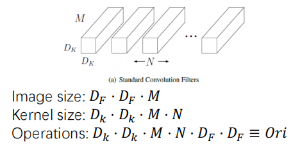

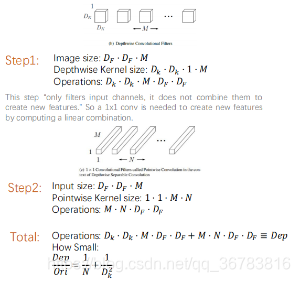

1.1 Depthwise Conv

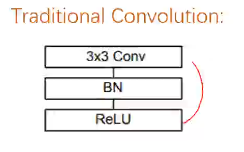

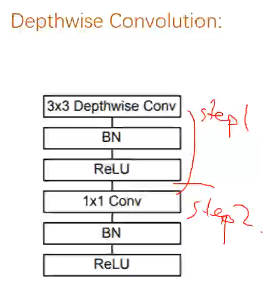

- 传统卷积操作 VS 论文中提到的卷积操作

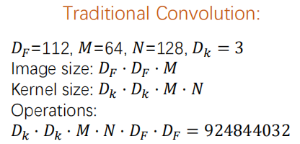

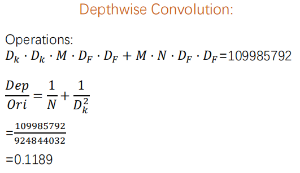

这部分还是相当重要的,Depthwise Convolution 计算量要比 Traditional Convoulution 小的多

- 比如,举个简单的列子

- 发现了吧,通常情况下,相对标准的卷积计算减少8~9倍的计算量,却只有1%的精度损失

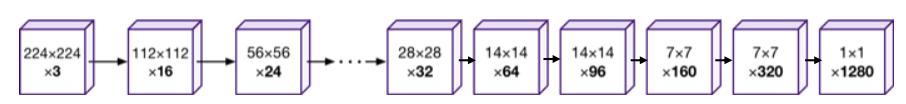

- 总体感觉一下 ,Structure-Macro 大概是下面的这个样子:

具体怎么画的?用caffe的网络文件 .prototx, 直接copy到netscope,在线绘制caffe模型,copy完成后,shift+enter就可以看到网络结构了。

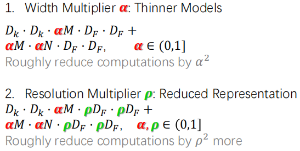

1.2 Hyperparameters

- 以上两点强烈感觉意义不大,甚至以为是凑论文用的。

1.3 Training-Some Details

- RMSprop 这个没看,不懂

Less regularization and data augmentation considering small models have less trouble overfitting 数据集不用太复杂

Very Little or no weight decay (l2 regularization) on depthwise filters since there are so few parameters in them.

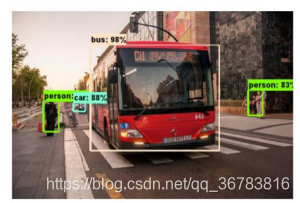

下面是一个例子,MobileNet + SSD

总之,重要的是1.1那里

2 MobileNet-V2

2.1 Inverted Residuals & Linear Bottlenecks

该论文主要贡献——高逼格版:

该论文主要贡献——高逼格版:

Inverted Residuals + Linear Bottlenecks

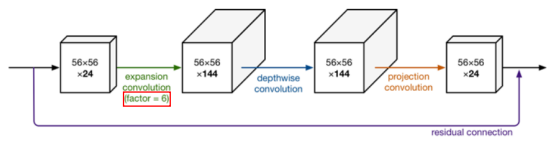

普通话版:肯定在每层中间增加channel数来增加参数数量,然后在下一层前再缩回去…

First impression: very little parameters, very slim blobs

心灵拷问:Then how could it be better?

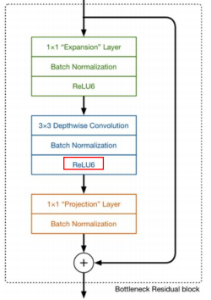

Original residual: reduce - transffer - expand

Original bottlenecks: Eltwise + with ReLU at the end of a bottleneck

Inverted residual: expand - transfer – reduce

Linear Bottlenecks: Eltwise+ with NO ReLU at the end of a bottleneck

品质解释:

Inverted Residuals: 作用是uncompress数据,使得我们感兴趣的低维流形(manifold of interest)能够包含于我们的高维空间中。

Linear Bottlenecks: 神经网络被认为可以使MOI嵌入低维空间。如果当前激活空间MOI完整度较高,ReLU会让空间坍塌,丢失信息;并且,其非0部分是做线性变换,实为一个线性分类器。因而采用线性bottleneck

Manifold:流形-局部具有欧式空间性质的空间-

普通话解释:

Inverted Residuals: Skip connection 这种bottleneck的结构被证明很有效,所以想用;但是如果像以前那样先压缩channel,channel数本来就少,再压没了,所以不如先增大再减少。

Linear Bottlenecks: ReLU让负半轴为0。本来我参数就不多,学习能力就有限,这一下再让一些参数为0了,就更学不着什么东西了。干脆在eltwise+那里不要ReLU了。

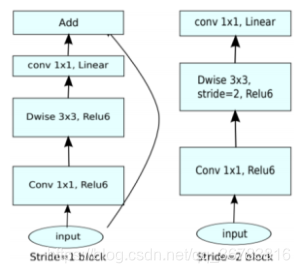

Structure: Stride = 1 block 和 Stride = 2 block 是不一样的,嗯。

2.2 Effect

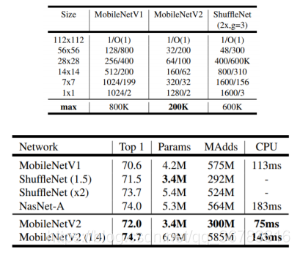

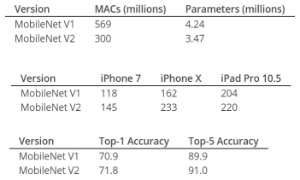

换句话说,V2 效果更好,速度更快,参数更少

3 Summary

V1与V2如何加速的总结额

MobileNet-V1-Accelerate conv operation:

Mainly separate traditional conv into 2 steps: Depthwise + Pointwise

MobileNet-V2-Add more useful parameters:

Inverted residual: expand – transfer – reduce

+

Linear bottleneck: remove ReLU after Eltwise+