今天来推荐一下自己开源的一个小项目,主要包括NLP中一些经典模型的理解与相关实践,从最初的Seq2Seq到目前比较流行的BERT模型,以及BERT模型改进——ALBERT模型等。

链接地址:https://github.com/LIANGQINGYUAN/NLP-Notebook

下面包含这个仓库的基本学习路线、目录和示例。

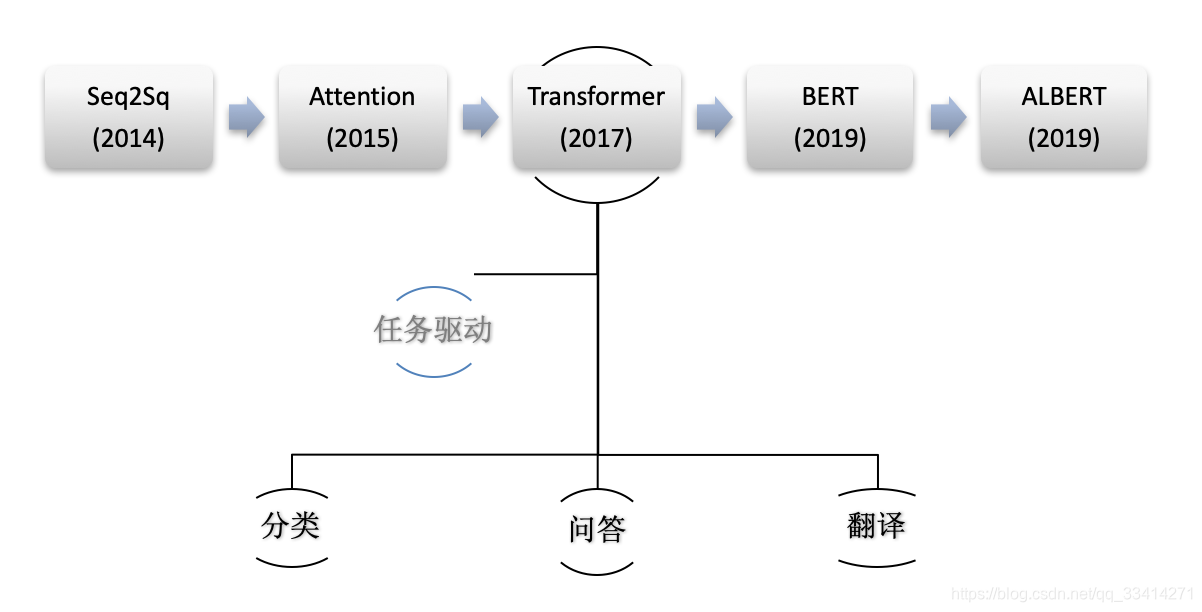

基本学习路线

下面是模型实践的基本学习路线:

图片内年分为对应模型的论文发表年份。

仓库目录

1、Seq2Seq模型

- 机器翻译

2、Attention机制

- 机器翻译中的Attention机制

- 垃圾邮件分类

3、Transformer模型

- 机器翻译中的Transformer

4、BERT模型

- 中文微博情感分类

5、ALBERT模型

- 推特情感分类

6、多模型的融合(Ensemble)

- 加权平均法的实践 : BERT+ALBERT

- Stacking & Blending技术

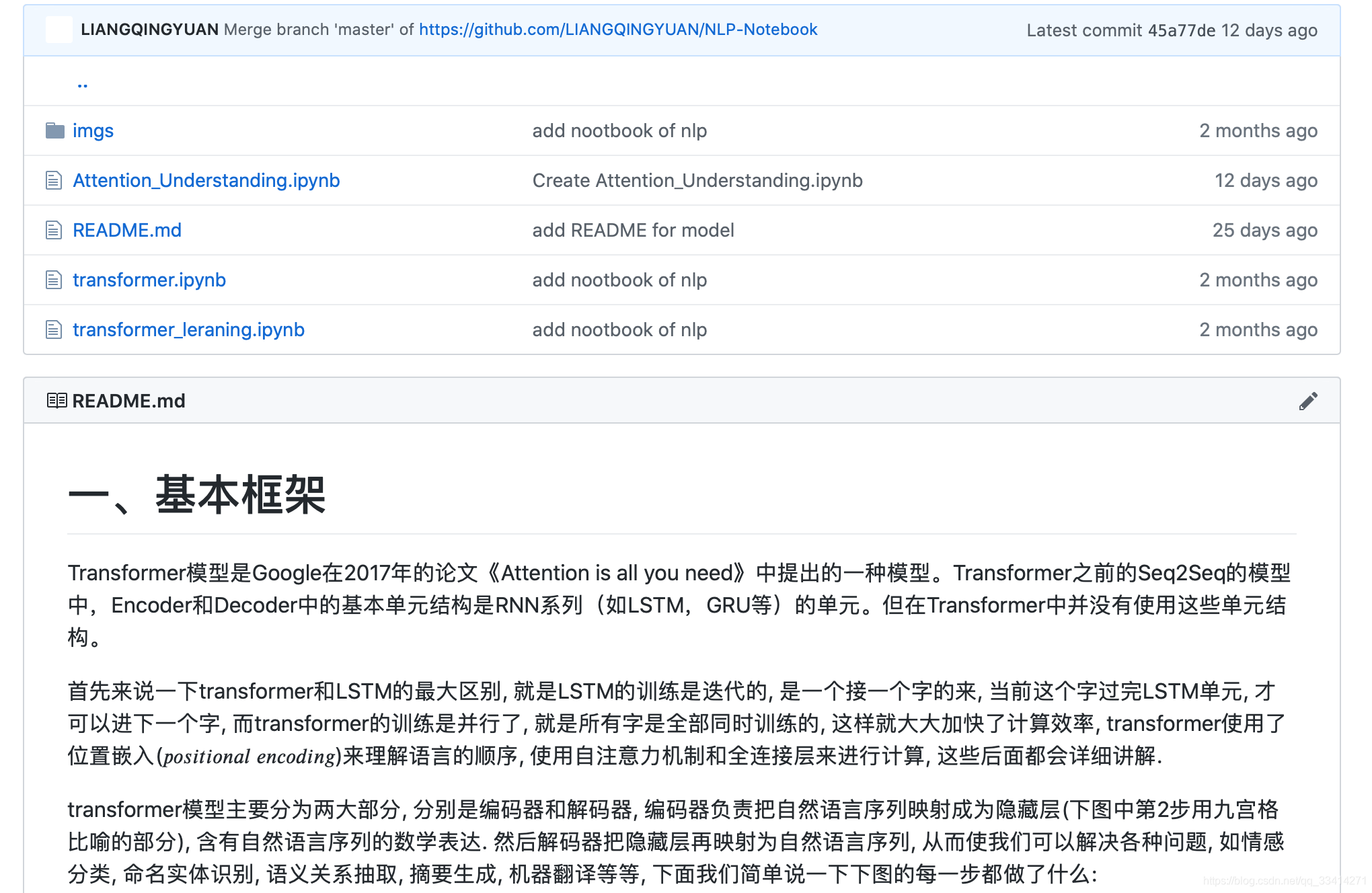

示例

如上图中,每个模型下面包含模型理解的README.md文件,还包括1个或多个的实践项目(如transformer.ipynb等);对于比较重要的概念还会使用notebook配合代码进行实践和深入理解(如Attention_Understanding.ipynb)。

最后如果有相关模型学习和实践的朋友去star和fork~