1.刚开始第一个作业搭建环境PARL:

PARL是一个算法库,是对Agent的框架抽象。简单来说就是在一台机器上调用pip install parl,就可以启动集群并行计算,使运算加速。

PS:心里窃喜,对于我们小白,非常友好,因为之前有机器学习的基础,又经常白嫖 参加aistudio的活动,所以上手非常快,没有两分钟就干完了。

2.迷宫游戏对比Sarsa和Q-learning

Sarsa的学习过程和Q-Learning差不多一样,**不同的地方是Q-Learning在走下一步的时候是先看下一步应该走哪,但是最后不一定走,而Sarsa是决定完要走的步之后一定会去走那一步。**换句话说,Q-Learning在更新当前位置的Q值的时候会参考表中收益最大的那个值,但下一步不一定会走到那个位置,而Sarsa是先选取下一步要走的位置的Q值来更新当前位置的Q值,当然,选完它下一步一定会去走那一步。

Sarsa虽然说是说到做到,但是由于它选取下一步的位置是严格按照已有学习到的经验来选择,所以它探索未知位置的能力就会很差,相对于说了不一定算的Q-Learning来说,反而Q-Learning更勇敢一些。

PS:作业难度稍微增加,但是算法基础还算在我本科生的理解范围之内

3. DQN解决MountainCar

强化学习算法可以分为三大类:value based, policy based 和 actor critic。常见的是以DQN为代表的value based算法,这种算法中只有一个值函数网络,没有policy网络,以及以DDPG,TRPO为代表的actor-critic算法,这种算法中既有值函数网络,又有policy网络。

具体算法原理,我查了一下资料,直接甩链接吧: DQN算法原理

PS:可能是运气好吧,第一次调参就成功了,看群里的小伙伴试了很多次都没有成功。

4.PG解决Pong

PG算法的全称是Policy Gradient,前面提到过强化学习算法可以分为三大类,Policy-based的算法的典型代表为Policy Gradient,直接优化策略函数。细节请移步:PG算法理解或者看科科老师的讲解比较通俗易懂,B站关注百度飞桨。

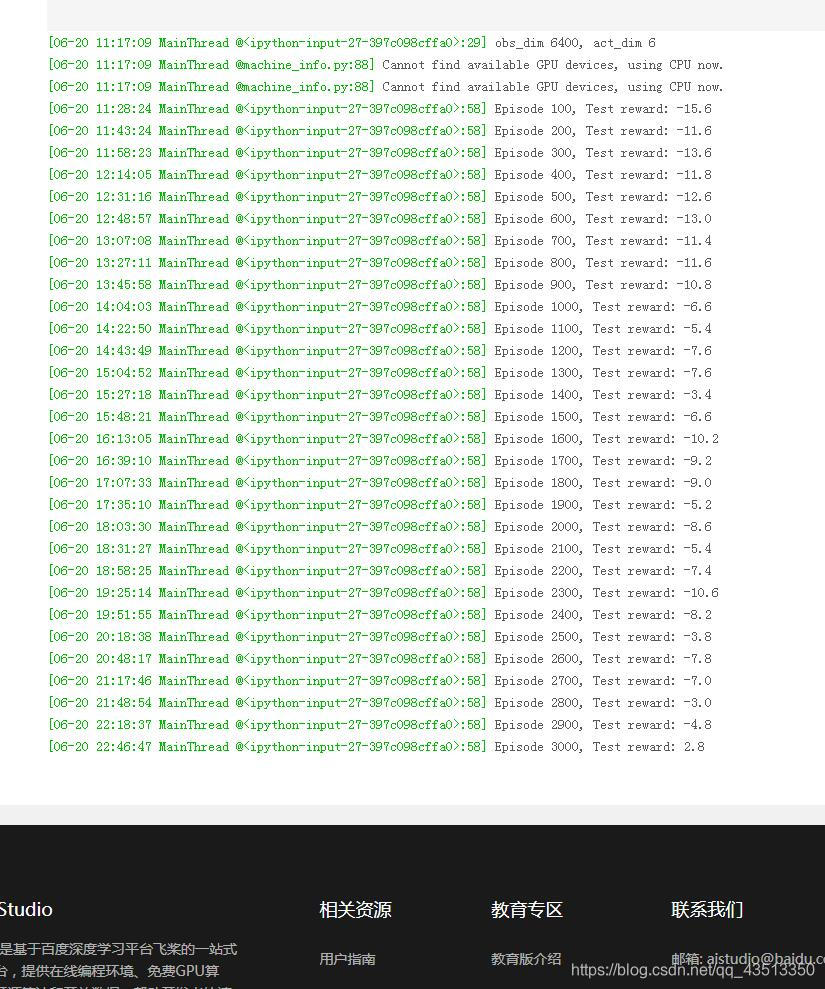

PS:这个作业真正体验到了炼丹的辛苦,由于电脑会崩溃,我不得不另辟蹊径,于是我用我的树莓派,低功耗炼丹,并且增加了训练的回合数,直接跑3000次,经过一个晚上,跑到2900的时候心态崩了,还是没有收敛,直到刚好跑到3000,奇迹发生了,这么多回合都是负数,最后一次居然是正数,心里窃喜,兴奋了一个晚上。

PS:最后要感谢人美心善代码6的百度资深研发工程师科科老师通俗易懂的讲解课程,虽然是快餐式的入门,但介绍了那么多干货,下来够琢磨一阵子了,不枉期末冒着挂科风险来参加这次课程o(╥﹏╥)o,加油,冲鸭,奥利给!