经过上篇的简单介绍,相信大家对Kafka有了初步的了解,本篇为博主带来的是Kafka的集群部署。

需要的东西博主都已经打包上传到百度云了,如有需要的可以通过链接自取:

链接:https://pan.baidu.com/s/1YtXgkt2430leNgCaNf2SLQ

提取码:jnwl

一. 环境准备

1. 初始化环境准备

安装jdk,安装zookeeper并保证zk服务正常启动。

因为在之前的博客中,博主已经将如何搭建Hadoop集群的过程叙述过了,这里就不再重复赘述,有需要的同学可以看看这篇博客《Hadoop分布式环境搭建(简单高效~)》。

- 1.集群规划

| hadoop002 | hadoop003 | hadoop004 |

|---|---|---|

| zk | zk | zk |

| kafka | kafka | kafka |

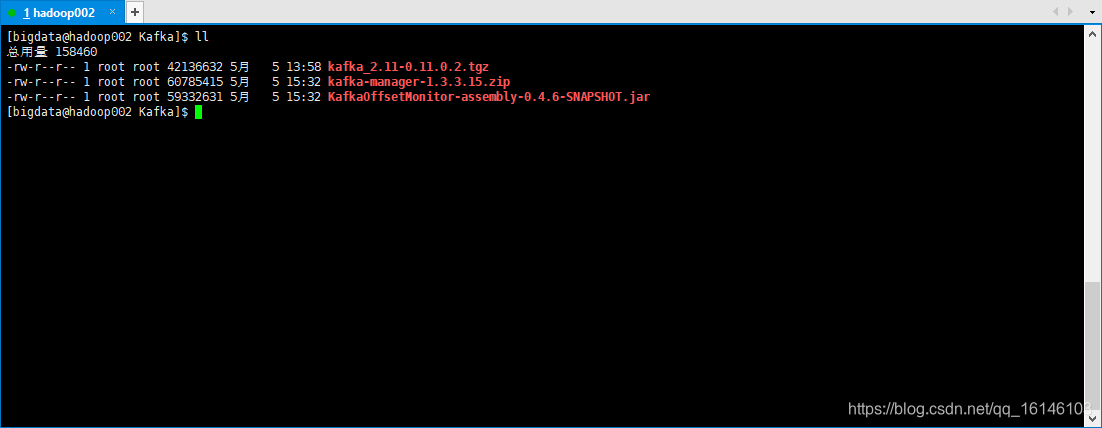

- 2. 所需包

二. Kafka集群部署

- 1. 解压安装包

[bigdata@hadoop002 Kafka]$ tar -zxvf kafka_2.11-0.11.0.2.tgz -C /opt/module/

- 2. 修改解压后的文件名称

[bigdata@hadoop002 module]$ mv kafka_2.11-0.11.0.2/ kafka

- 3. 在/opt/module/kafka目录下创建logs文件夹

[bigdata@hadoop002 kafka]$ mkdir logs

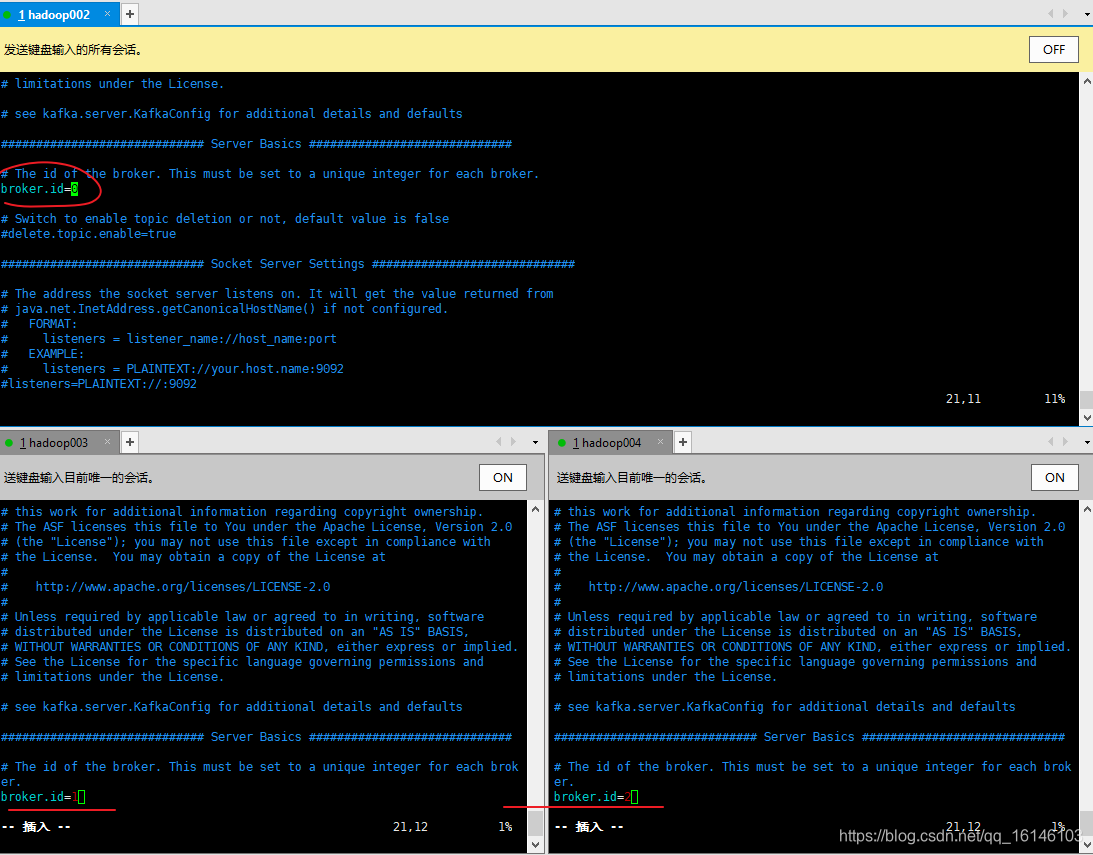

- 4. 修改配置文件

[bigdata@hadoop002 kafka]$ cd config/

[bigdata@hadoop002 config]$ vim server.properties

// 输入以下内容

#broker的全局唯一编号,不能重复

# 不同机器不能重复

broker.id=0

#删除topic功能使能

delete.topic.enable=true

#处理网络请求的线程数量

num.network.threads=3

#用来处理磁盘IO的现成数量

num.io.threads=8

#发送套接字的缓冲区大小

socket.send.buffer.bytes=102400

#接收套接字的缓冲区大小

socket.receive.buffer.bytes=102400

#请求套接字的缓冲区大小

socket.request.max.bytes=104857600

#kafka运行日志存放的路径

# 需要修改的地方,已经以前修改好了

log.dirs=/opt/module/kafka/logs

#topic在当前broker上的分区个数

num.partitions=1

#用来恢复和清理data下数据的线程数量

num.recovery.threads.per.data.dir=1

#segment文件保留的最长时间,超时将被删除

log.retention.hours=168

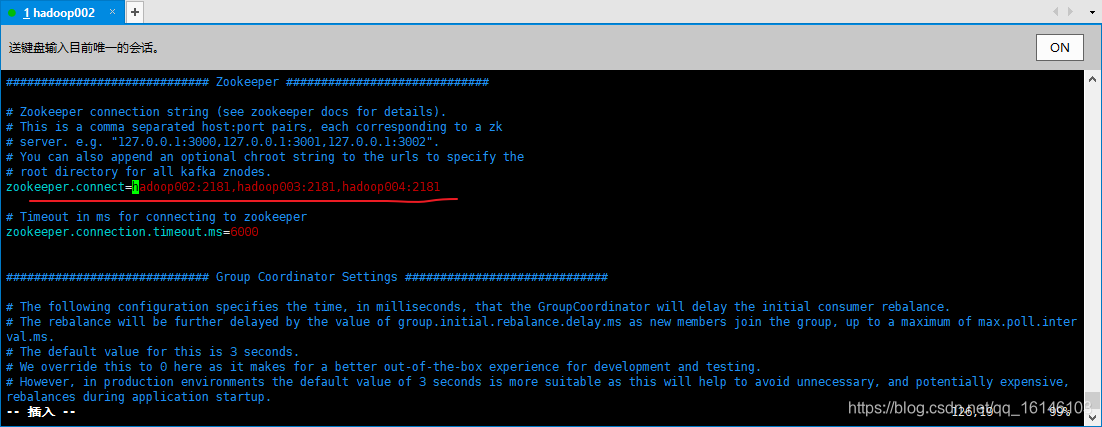

#配置连接Zookeeper集群地址

# 需要求改成自己的

zookeeper.connect=hadoop002:2181,hadoop003:2181,hadoop004:2181

-

需要修改的地方①:

-

需要修改的地方②

-

需要修改的地方③

-

5. 配置环境变量

[bigdata@hadoop002 kafka]$ sudo vim /etc/profile

// 添加如下内容

#KAFKA_HOME

export KAFKA_HOME=/opt/module/kafka

export PATH=$PATH:$KAFKA_HOME/bin

[bigdata@hadoop002 kafka]$ source /etc/profile

由于三台虚拟机已经同时修改好了,所以下面就可以启动集群看看是否成功了

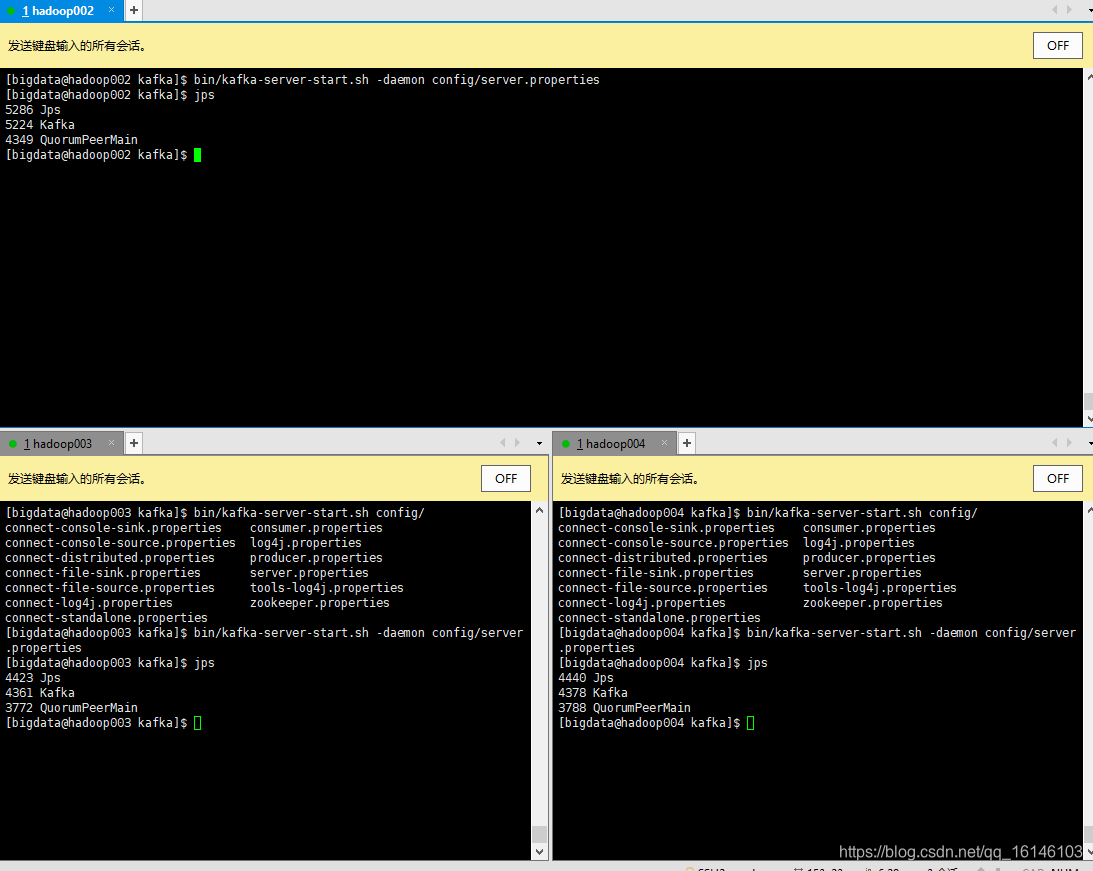

- 6. 启动集群

// 再启动kafka之前需要先启动zookeeper

[bigdata@hadoop002 zookeeper-3.4.10]$ bin/zkServer.sh start

[bigdata@hadoop003 zookeeper-3.4.10]$ bin/zkServer.sh start

[bigdata@hadoop004 zookeeper-3.4.10]$ bin/zkServer.sh start

[bigdata@hadoop002 kafka]$ bin/kafka-server-start.sh -daemon config/server.properties

[bigdata@hadoop003 kafka]$ bin/kafka-server-start.sh -daemon config/server.properties

[bigdata@hadoop004 kafka]$ bin/kafka-server-start.sh -daemon config/server.properties

- 下图为成功案例

- 7. 启动集群

[bigdata@hadoop002 kafka]$ bin/kafka-server-stop.sh stop

[bigdata@hadoop003 kafka]$ bin/kafka-server-stop.sh stop

[bigdata@hadoop004 kafka]$ bin/kafka-server-stop.sh stop

本次的分享就到这里了,

^ _ ^ ❤️ ❤️ ❤️

码字不易,大家的支持就是我坚持下去的动力。点赞后不要忘了关注我哦!