开篇

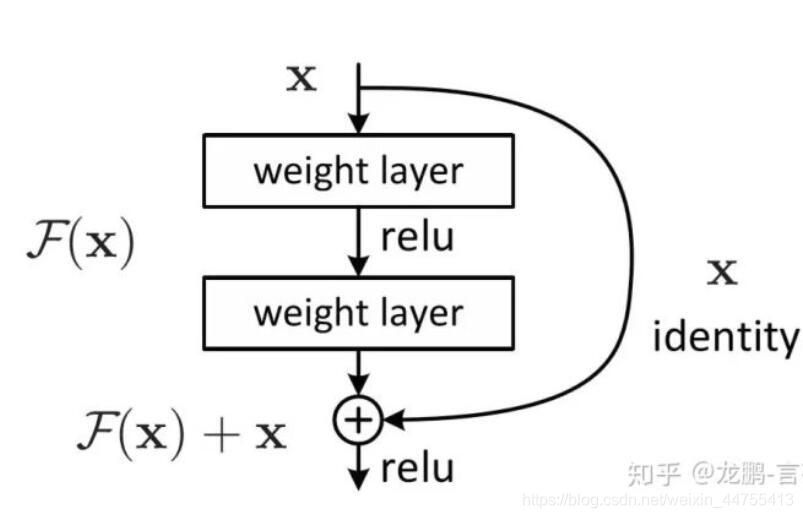

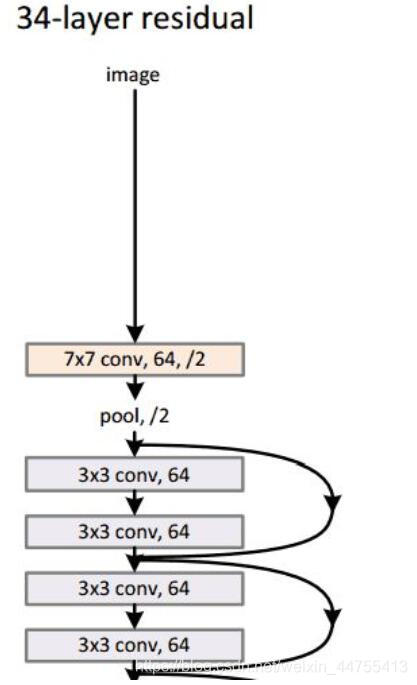

这次我们来聊一下残差神经网络的实现。这是咱们国内大神何凯明当年在CVPR上荣获一等奖的作品。它通过相等输入输出维度之间的恒等映射,高维度向低维度的下采样等方法构造残差块,对于很深的网络降低了学习难度,同时由于是恒等映射,我们在求解梯度的时候也相对轻松很多。

这也引入了一个新的方法去解决梯度爆炸或者梯度消失的问题,除了使用Batch Normalization和RELU以外,我们也可以构建残差块生成ResNet。

这里我们不介绍ResNet的主要原理,大家可以下载ResNet论文自己阅读,或者看一些介绍原理的博客,建议学完基础原理再回来看实现方法,因为这种实现方法其实是论文的一种复现。我们开始吧。

ResNet残差神经网络

库的引入

import torch

import torch.nn as nn

import torchvision

import torchvision.transforms as transforms

设备配置及超参数的定义

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

num_epochs = 80

batch_size = 100

learning_rate = 0.001定义图像预处理的操作

这里就有需要用到很多我们transforms库中的函数了

transform = transforms.Compose([

transforms.Pad(4),

transforms.RandomHorizontalFlip(),

transforms.RandomCrop(32),

transforms.ToTensor()])Compose表示一个集合,这个图像预处理操作包括内部的内容:

1.图像填充

2.图像随机垂直旋转

3.图像随即剪切

4.图像转变为张量

数据集的引入与加载

这次我们不再使用mnist数据集,而是使用CIFAR10数据集。这是多伦多大学的数据集,内部图片都是32*32的3通道彩色图片,基本都是外部世界的真是物品,某种程度上来说比MNIST好得多。大家可以去http://www.cs.toronto.edu/~kriz/cifar.html找到这个数据集。

train_dataset = torchvision.datasets.CIFAR10(root='../../data/',

train=True,

transform=transform,

download=True)

test_dataset = torchvision.datasets.CIFAR10(root='../../data/',

train=False,

transform=transforms.ToTensor())

# Data loader

train_loader = torch.utils.data.DataLoader(dataset=train_dataset,

batch_size=batch_size,

shuffle=True)

test_loader = torch.utils.data.DataLoader(dataset=test_dataset,

batch_size=batch_size,

shuffle=False)定义一个卷积核为3*3,步长为1,填充长度也为1的卷积函数

def conv3x3(in_channels, out_channels, stride=1):

return nn.Conv2d(in_channels, out_channels, kernel_size=3,

stride=stride, padding=1, bias=False)这个函数的定义主要是为了方便之后的调用,再使用的时候就不需要写很长一块了

残差块类的定义

class ResidualBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1, downsample=None):

super(ResidualBlock, self).__init__()

self.conv1 = conv3x3(in_channels, out_channels, stride)

self.bn1 = nn.BatchNorm2d(out_channels)

self.relu = nn.ReLU(inplace=True)

self.conv2 = conv3x3(out_channels, out_channels)

self.bn2 = nn.BatchNorm2d(out_channels)

self.downsample = downsample

def forward(self, x):

residual = x

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

# 下采样

if self.downsample:

residual = self.downsample(x)

out += residual

out = self.relu(out)

return out

残差块是残差神经网络中很重要的一块,我们的核心都在里面。

我们可以看到残差块先是经过一个3*3的卷积神经网络,然后经过Batch Normalization函数进行标准化,然后经过RELU激活函数,再经过卷积网络和Batch Normalization。最后就是我们残差映射,如果downsample不为None,则我们应该从低维进行下采样,加到out上,如果为None,即两个维度相同,则直接加上恒等映射的x.

下面我们会说这个downsample到底什么样子。

残差网络的定义

class ResNet(nn.Module):

def __init__(self, block, layers, num_classes=10):

super(ResNet, self).__init__()

self.in_channels = 16

self.conv = conv3x3(3, 16)

self.bn = nn.BatchNorm2d(16)

self.relu = nn.ReLU(inplace=True)

# 构建残差块,恒等映射

# in_channels == out_channels and stride = 1 所以这里我们构建残差块,没有下采样

self.layer1 = self.make_layer(block, 16, layers[0], stride=1)

# 不构建残差块,进行了下采样

# layers中记录的是数字,表示对应位置的残差块数目

self.layer2 = self.make_layer(block, 32, layers[1], 2)

# 不构建残差块,进行了下采样

self.layer3 = self.make_layer(block, 64, layers[2], 2)

self.avg_pool = nn.AvgPool2d(8)

self.fc = nn.Linear(64, num_classes)

def make_layer(self, block, out_channels, blocks, stride=1):

downsample = None

if (stride != 1) or (self.in_channels != out_channels):

downsample = nn.Sequential(

conv3x3(self.in_channels, out_channels, stride=stride),

nn.BatchNorm2d(out_channels))

layers = []

layers.append(block(self.in_channels, out_channels, stride, downsample))

# 当out_channels = 32时,in_channels也变成32了

self.in_channels = out_channels

# blocks是残差块的数目

# 残差块之后的网络结构,是out_channels->out_channels的

# 可以说,make_layer做的是输出尺寸相同的所有网络结构

# 由于输出尺寸会改变,我们用make_layers去生成一大块对应尺寸完整网络结构

for i in range(1, blocks):

layers.append(block(out_channels, out_channels))

return nn.Sequential(*layers)

def forward(self, x):

out = self.conv(x)

out = self.bn(out)

out = self.relu(out)

# layer1是三块in_channels等于16的网络结构,包括三个恒等映射

out = self.layer1(out)

# layer2包括了16->32下采样,然后是32的三个恒等映射

out = self.layer2(out)

# layer3包括了32->64的下采样,然后是64的三个恒等映射

out = self.layer3(out)

out = self.avg_pool(out)

# 全连接压缩

# out.size(0)可以看作是batch_size

out = out.view(out.size(0), -1)

out = self.fc(out)

return out

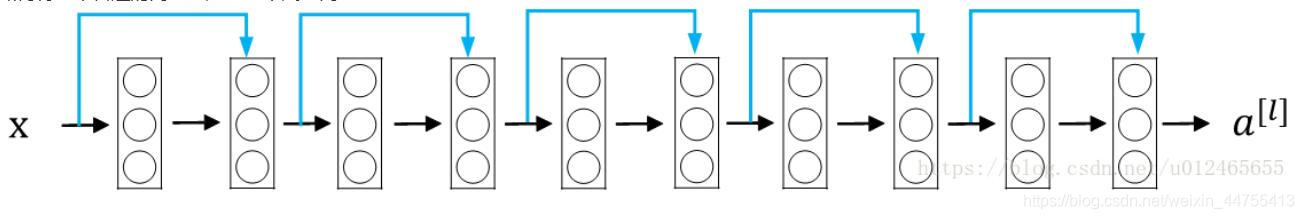

这就是我们的核心部分,我们可以看到,残差网络本身要先经过Conv3*3->Batch Normalization->RELU。然后才是我们的三层残差块。

我们主要来看我们的make_layers函数:

函数内部给出了何时进行下采样。如果步长不为1或者输入维度不等于输出维度的时候进行下采样,否则进行恒等映射。什么意思呢?

在layer1处,当我们的输入维度是16时,输出维度也是16,此时我们需要进行恒等映射,然后将out_channels设置为16.然后在layer2处,由于输入维度变成了32,我们就需要从32向16维度进行下采样,即会从16维度的残差块引出一条线进入32维度。然后out_channels = 32了,32维度残差块内部进行恒等映射。到了layer3我们又要从32维度的残差块下采样到64维度,然后out_channels=64,我们在64内部进行恒等映射。

这里面的参数layers[0],layer[1],layers[2]表示的是各个维度残差块的数目。

定义模型

# [2,2,2]表示的是不同in_channels下的恒等映射数目

model = ResNet(ResidualBlock, [2, 2, 2]).to(device)损失函数的定义

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)设置一个通过优化器更新学习率的函数

def update_lr(optimizer, lr):

for param_group in optimizer.param_groups:

param_group['lr'] = lr训练模型更新学习率

total_step = len(train_loader)

curr_lr = learning_rate

for epoch in range(num_epochs):

for i, (images, labels) in enumerate(train_loader):

images = images.to(device)

labels = labels.to(device)

# Forward pass

outputs = model(images)

loss = criterion(outputs, labels)

# Backward and optimize

optimizer.zero_grad()

loss.backward()

optimizer.step()

if (i + 1) % 100 == 0:

print("Epoch [{}/{}], Step [{}/{}] Loss: {:.4f}"

.format(epoch + 1, num_epochs, i + 1, total_step, loss.item()))

if (epoch + 1) % 20 == 0:

curr_lr /= 3

update_lr(optimizer, curr_lr)测试模型并保存

model.eval()

with torch.no_grad():

correct = 0

total = 0

for images, labels in test_loader:

images = images.to(device)

labels = labels.to(device)

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print('Accuracy of the model on the test images: {} %'.format(100 * correct / total))

torch.save(model.state_dict(), 'resnet.ckpt')总结

残差神经网络是很重要的一个网络模型,它的使用场景也非常广泛,如果我们有很深的网络,那就存在难以避免的学习困难和梯度爆炸或者消失的影响,这时候我们就可以使用深度残差神经网络。因为我们可以看到,在本次的例子中,我们残差网络基础有3层,残差块中又有6层(恒等映射或者下采样不算一层)。我们有三个残差结构,每一个残差结构两个残差块,所以我们就有6x2x3=36层。最后我们还有一个平均池化层一个全连接层,所以我们这个例子中就有36+3+1+1=41层网络。因此对于深度神经网络来说ResNet是个不错的选择。