CentOS6.5安装教程:https://blog.csdn.net/qq_38741971/article/details/80393275

一、删除CentOS本机自带的JDK

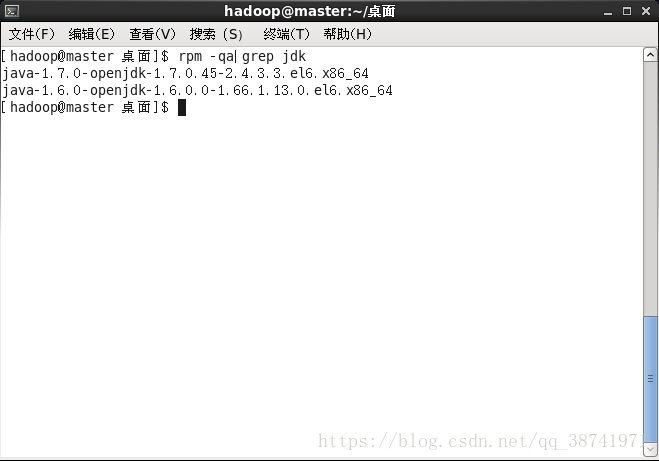

1.查看当前本机安装的jdk版本

rpm -qa|grep jdk

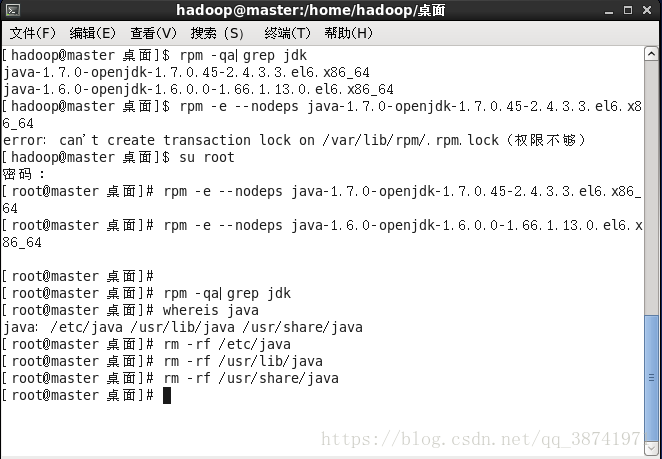

2.切换到root用户下,获取一定的权限

su root

3.分别运行下方命令删除本机自带的jdk版本

rpm -e --nodeps java-1.7.0-openjdk-1.7.0.45-2.4.3.3.el6.x86_64 rpm -e --nodeps java-1.6.0-openjdk-1.6.0.0-1.66.1.13.0.el6.x86_64

4.再次运行rpm -qa|grep jdk 确认是否删除完毕

rpm -qa|grep jdk

5.运行whereis java查看java的安装目录

whereis java

6.分别使用rm -rf *,删除所有的安装文件夹,再次运行whereis java确认是否删除完毕

rm -rf /etc/java rm -rf /usr/lib/java rm -rf /usr/share/java

二、关闭防火墙

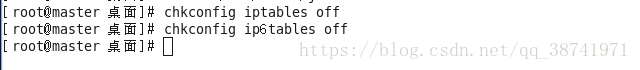

1.分别使用命令关闭防火墙

chkconfig iptables off chkconfig ip6tables off

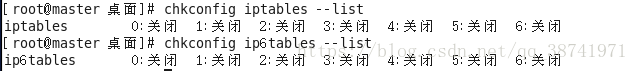

2.分别运行命令查看防火墙状态,确认防火墙关闭

chkconfig iptables --list chkconfig ip6tables --list

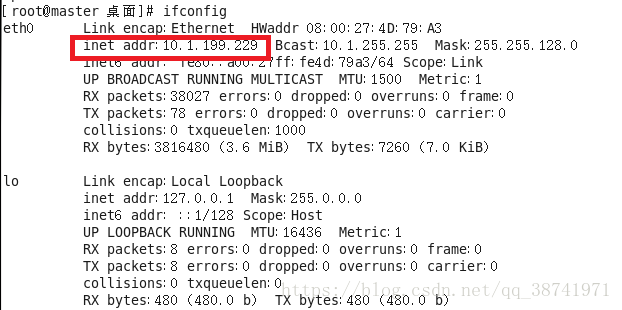

3.使用ifconfig查看自己的ip信息,并且记住

4.回到window界面,键盘快捷键win+r,打开运行窗口,输入cmd,打开dos窗口

5.使用命令ping虚拟机ip:ping xxx.xxx.xxx.xxx

6.出现上述信息,代表主机可以与虚拟机通信

jdk-1.8u172下载:

链接:https://pan.baidu.com/s/1fNMjBhu6a-c5Js-6xgya8A 密码:6z7b

hadoop2.7.3下载:

链接:https://pan.baidu.com/s/1G_47KpTaUwhCqFKYFseGQA 密码:n11x

Filezilla下载:

链接:https://pan.baidu.com/s/1msZQ8f39u2i1ZSsCjV-6pQ 密码:mrcx

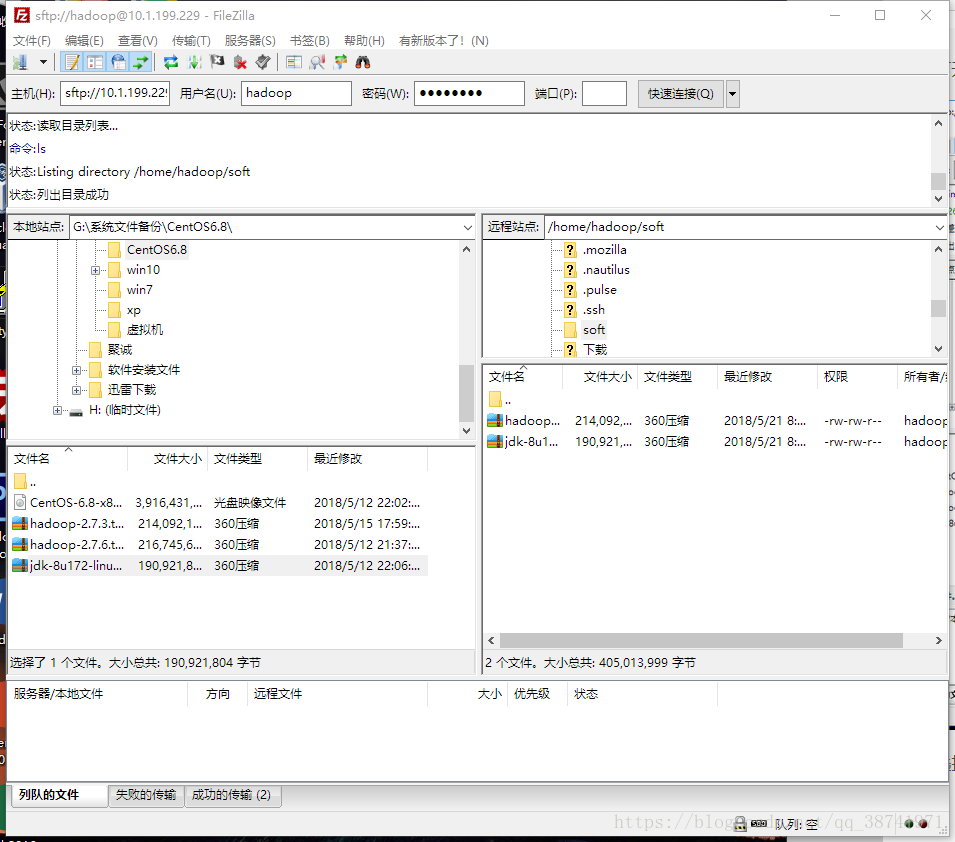

三、使用FileZilla传输我们需要的软件

14.切换回普通用户hadoop

su hadoop

15.回到普通用户的家目录下

cd

16.可以使用命名确认一下当前目录

pwd

17.在当前目录下创建soft目录

mkdir soft

18.打开Filezilla,输入虚拟机的ip地址,普通用户名,密码,端口号22,快速链接

19.选择我们需要传送的文件,和指定CentOS接收文件的地址/home/hadoop/soft,将hadoop2.7.3和jdk-8u172传到CentOS

20.关闭Filezilla,回到虚拟机下

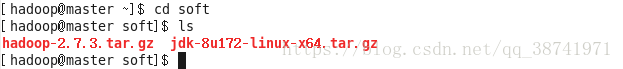

21.查看文件是否传入,失败重复18~20步骤

cd soft ls

四、解压配置JDK

1.将jJDK解压

tar -zxvf jdk-8u172-linux-x64.tar.gz

2.回到当前用的家目录下

cd

3.配置环境变量

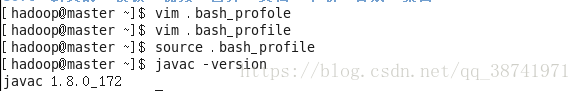

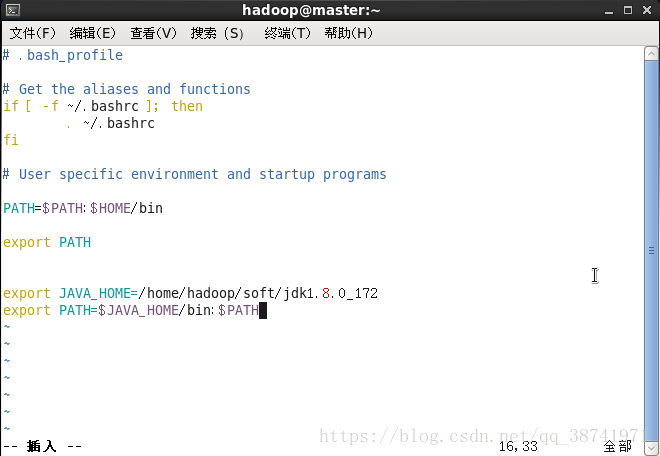

vim .bash_profile

4.光标移到最后一行,按下o,输入

export JAVA_HOME=/home/hadoop/soft/jdk1.8.0_172 export PATH=$JAVA_HOME/bin:$PATH

5.按下esc,输入:wq,保存退出

6.source .bash_profile刷新下配置文件

7.使用javac -version查看JDK是否配置成功

五、配置免密码登录

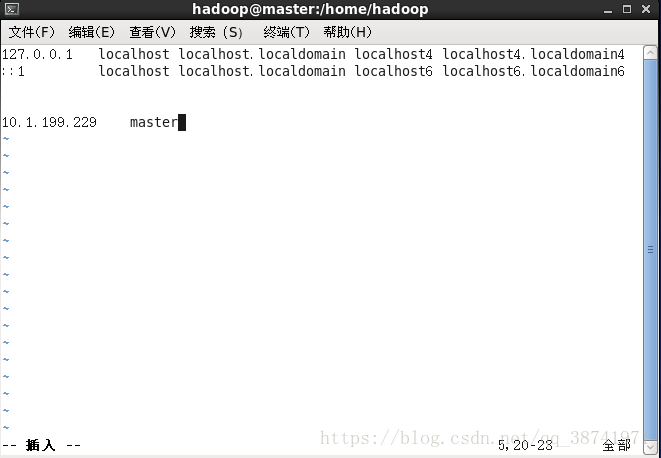

1.切换到root用户下,编辑/etc/hosts,将本机的ip地址与主机名绑定

su root vim /etc/hosts

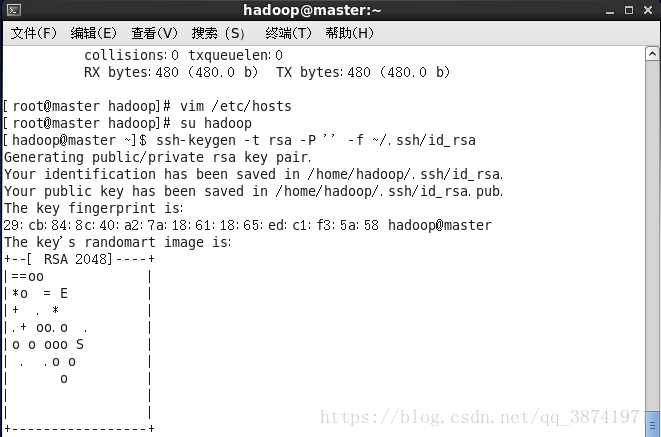

2.切换回普通用户hadoop

su hadoop

3.开始配置免密,生成密钥和公钥

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

4.将公钥追加到认证库中

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

5.修改认证库的访问权限

chmod 0600 ~/.ssh/authorized_keys

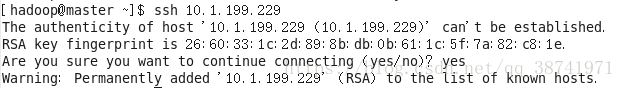

6.测试免密登录

ssh 本机ip

第一次登录,仅需要需要yes即可,到此,免密完成

六、安装hadoop,搭建Hadoop伪分布式集群

1.进入soft目录

cd /home/hadoop/soft

2.解压hadoop2.7.3

tar -zxvf hadoop-2.7.3.tar.gz

3.将hadoop-2.7.3重新命名为hadoop

mv hadoop-2.7.3 hadoop

4.切换目录

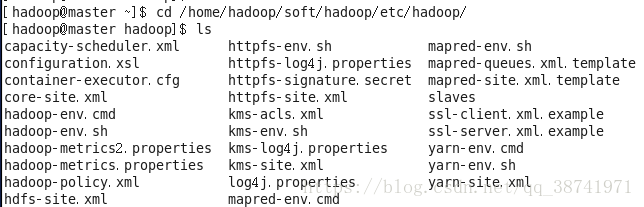

cd /home/hadoop/soft/hadoop/etc/hadoop

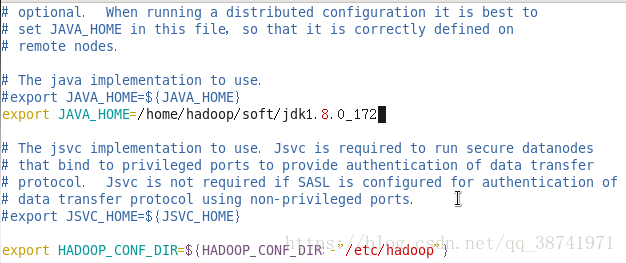

5.编辑hadoop-env.sh文件,修改hadoop依赖的JAVA_HOME

vim hadoop-env.sh

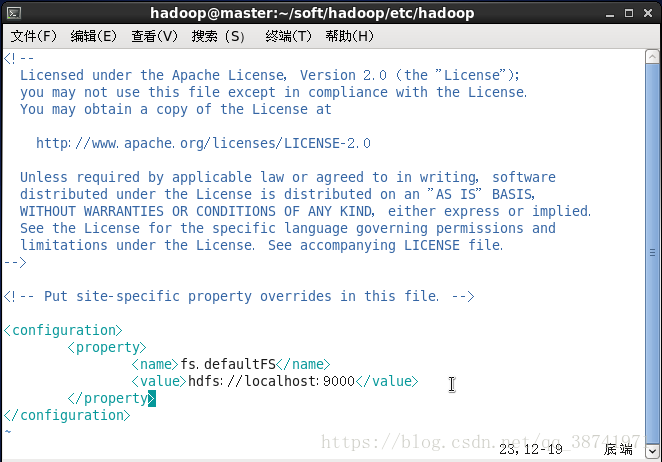

6.编辑core-site.xml文件,加入下方内容

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

7.编辑hdfs-site.xml,加入下方内容

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

8.配置hadoop环境变量

cd vim .bash_profile

在文件下方追加

export HADOOP_HOME=/home/hadoop/soft/hadoop export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

按下esc,输入:wq,保存退出编辑

9.刷新配置文件

source .bash_profile

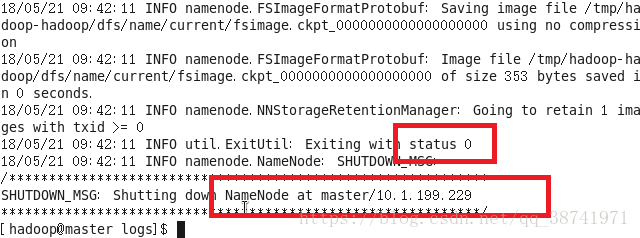

10.格式化namenode

hdfs namenode -format

出现红框位置信息,配置正确

10.启动hdfs

start-dfs.sh

11.查看启动的进程数

jps

出现上面四个进程,表示hdfs启动成功

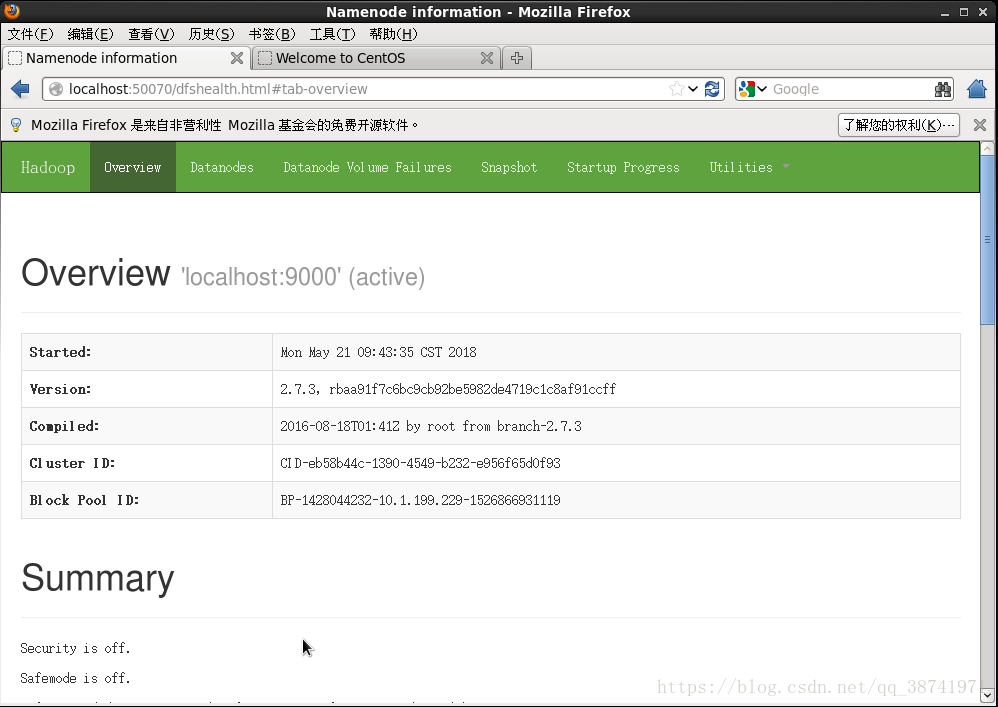

12.可以在虚拟机内打开浏览,输入

http://master:50070/ http://localhost:50070/ http://10.1.199.229:50070/

能出现下述界面,至此hadoop伪分布式搭建成功

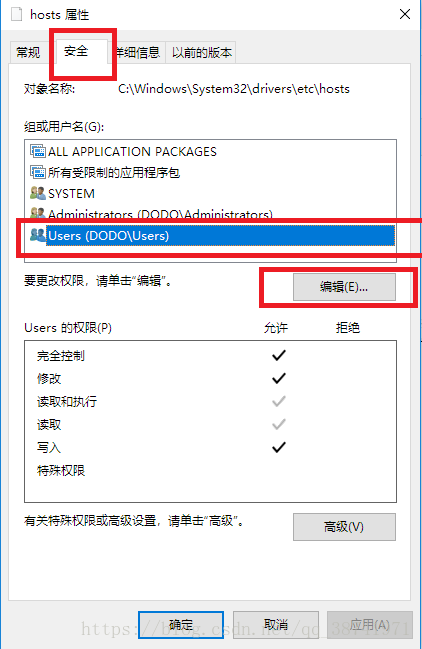

13.在window下翻墙,进入目录:C:\Windows\System32\drivers\etc

14.右键hosts文件,选择属性

15.切换到安全选项卡,选中当前window用户,选择编辑

16.对Users的权限赋予完全控制,修改,读取和执行,读取,执行。

17.打开hosts文件,在空白处追加

10.1.199.229 master

18.windows浏览器界面也能够打开

http://master:50070/ http://10.1.199.229:50070/