首先我们要明白激活函数的作用是:简而言之,增加模型的非线性表达能力。为什么能增加非线性能力,看参考地址。

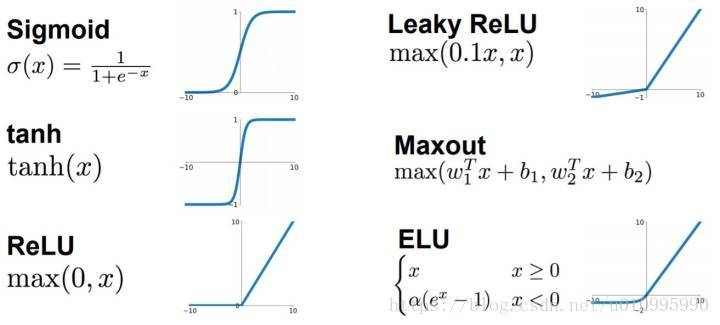

几大激活函数的具体公式如上图。

如上所示,sigmoid只会输出正数,以及它靠近0的输出变化率最大。tanh与sigmoid不同的是,tanh输出可以是负数。Relu是输入只能大于0,如果你输入含有负数,Relu就不合适,如果你的输入是图片格式,Relu就挺常用的。

首先我们要明白激活函数的作用是:简而言之,增加模型的非线性表达能力。为什么能增加非线性能力,看参考地址。

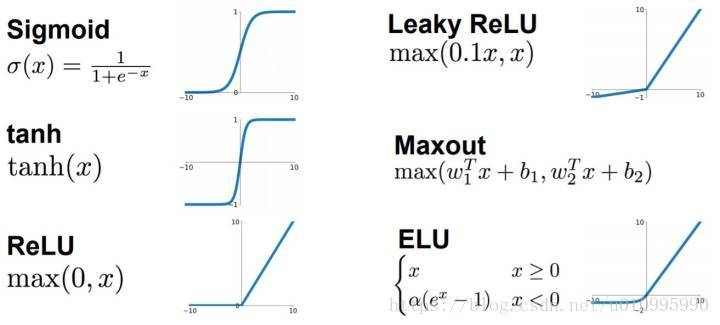

几大激活函数的具体公式如上图。

如上所示,sigmoid只会输出正数,以及它靠近0的输出变化率最大。tanh与sigmoid不同的是,tanh输出可以是负数。Relu是输入只能大于0,如果你输入含有负数,Relu就不合适,如果你的输入是图片格式,Relu就挺常用的。