本文有比较多的转载其他研究人员的博客

https://blog.csdn.net/u014772862/article/details/52335970

作为一名机器学习的科研人员,之前在推荐系统的开发和工作中,学习了PCA(主成分分析)与SVD(奇异值分解)方面的技术,但是还没有写过总结性的文章,此次,本人总结一些关于降维技术的调研,希望大家多多指教。

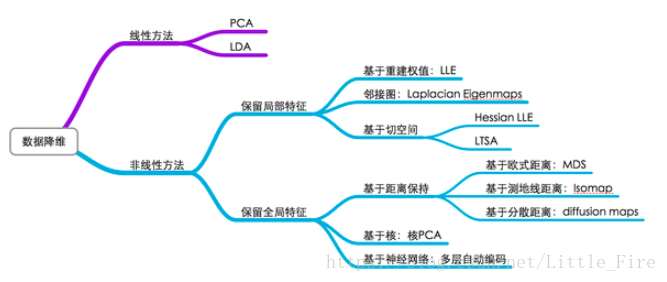

降维方法一般分为线性降维方法和非线性降维方法,如下图所示:

在机器学习中,说到降维,其目的是进行特征选择和特征提取,注意特征选择和特征提取这二者的不同之处:

(1)特征选择:选择重要特征子集,并删除其余特征。

(2)特征提取:由原始特征形成较少的新特征。

在特征提取中,我们要找到k个新的维度的集合,这些维度是原来k个维度的组合,这个方法可以是监督的,也可以是非监督的,

其中,pca是unsupervised的降维方法,lda(线性判别分析)是supervised的方法,这两个都是线性投影来做降维的。

另外,因子分析,和多维标定(mds)也是unsupervised的线性降为方法。

【降维的目的】

1.减少预测变量的个数;

2.确保这些变量是相互独立的;

3.提供一个框架来解释结果。

本文中,列出了几种常见的降维方法,包括Lasso,PCA,小波分析,LDA(线性判别分析), SVD(奇异值分解),拉普拉斯特征映射,SparseAutoEncoder(稀疏编码),局部线性嵌入LLE,等距映射Isomap等。

(一)LASSO:通过参数缩减实现降维

LASSO(Least absolute shrinkage and selection operator) 是一种压缩估计,通过在cost function中构造一个正则化项,从而训练到一个较为精炼的模型,使得压缩一些系数(设定一些系数为零),是一种有偏估计。Lasso 的基本思想:在回归系数的绝对值之和小于一个常数的约束条件下,使残差平方和最小化(构造拉格朗日函数解决),从而产生某些严格等于 0 的回归系数,得到可解释的模型。

(二)PCA:通过提取线性无关组做降维

PCA(Principal Component Analysis),通过线性变换,将原始数据变换为一组各维度线性无关的表示,可用于提取数据的主要特征分量,常用于高维数据的降维。 设有m条n维数据,

1)将原始数据按列组成m行n列矩阵X2)将X的每一列进行零均值化,即减去这一行的均值;

3)求出协方差矩阵C;

4)求出协方差矩阵的特征值及对应的特征向量;

5)将特征向量按对应的特征值大小从左到右排成矩阵,取前k列组成矩阵P(n*k);

6)Y=XP,即为降维到k维后的数据

PCA把原先的n个特征用数目更少的k个特征取代,新特征是旧特征的线性组合,这些线性组合最大化样本方差,尽量使新的k个特征互不相关。从旧特征到新特征的映射捕获数据中的固有变异性。

PCA降维过程请参考http://www.cnblogs.com/zhangchaoyang/articles/2222048.html

(三)聚类分析

将个体(样品)或者对象(变量)按相似程度(距离远近)划分类别,使得同一类中的元素之间的相似性比其他类的元素的相似性更强,使类间元素的同质性最大化和类间元素的异质性最大化。以K-means举例,Kmeans实现的过程如下:

(1)随机初始化个聚类中心(cluster centroid)

(2)Cluster Assignment: 对于每个数据点,寻找离它最近的聚类中心,将其归入该类;

(3)Move Centroid: 更新聚类中心的值为所有属于类的数据点的平均值

(4)重复2、3步直到收敛或者达到最大迭代次数

(4)小波分析

小波分析有一些变换的操作降低其他干扰可以看做是降维。

http://www.360doc.com/content/15/0613/14/21899328_477836495.shtml

(5)线性判别(LDA)

线性判别式分析(Linear Discriminant Analysis),简称为LDA,是模式识别的经典算法。基本思想是将高维的模式样本投影到最佳鉴别矢量空间,以达到抽取分类信息和压缩特征空间维数的效果,投影后保证模式样本在新的子空间有最大的类间距离和最小的类内距离,即模式在该空间中有最佳的可分离性。

LDA与PCA都是常用的降维技术。PCA主要是从特征的协方差角度,去找到比较好的投影方式。LDA更多的是考虑了标注,即希望投影后不同类别之间数据点的距离更大,同一类别的数据点更紧凑。

详细请参考http://www.cnblogs.com/zhangchaoyang/articles/2644095.html

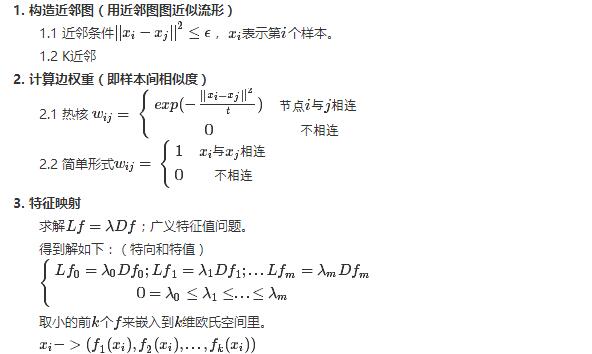

(6)拉普拉斯特征映射

拉普拉斯特征映射将处于流形上的数据,在尽量保留原数据间相似度的情况下,映射到低维下表示。

求解广义特征向量,取前几个非零最小特值对应的特向,即为原数据在低维下的表示。

资料来源于:http://blog.csdn.net/yujianmin1990/article/details/48420483