1、Mac安装python

参考:Mac安装python3

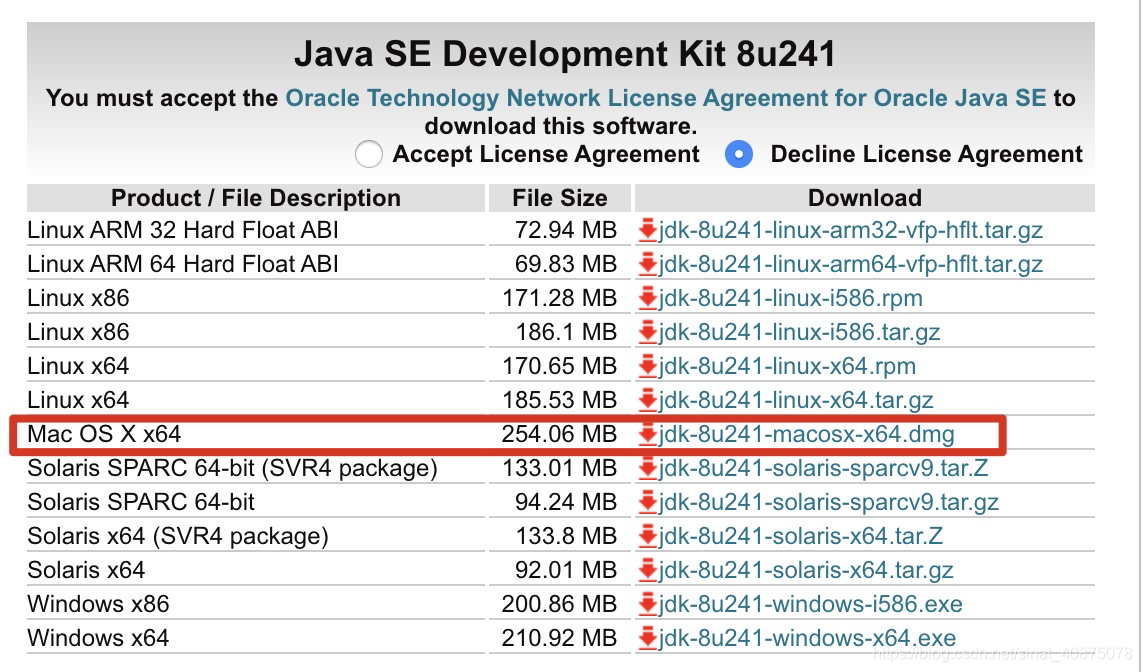

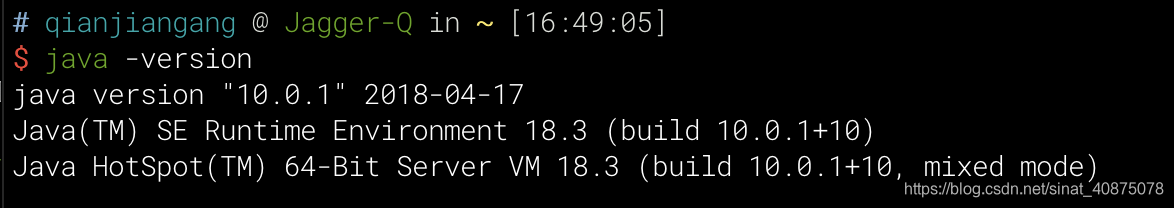

2、安装jdk

安装完成之后终端键入:java -version

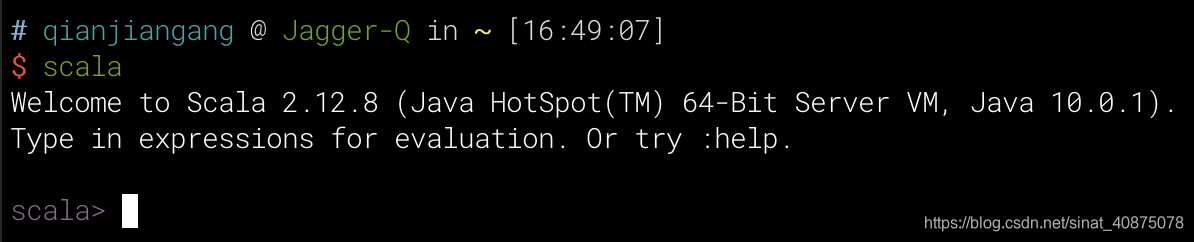

3、安装scala

下载好之后,解压Scala包,配置环境变量:

vi ~/.bash_profile

在文件末尾添加:

export SCALA_HOME=/安装路径/scala-2.12.8

export PATH=$PATH:$SCALA_HOME/bin

安装完成之后终端键入:scala

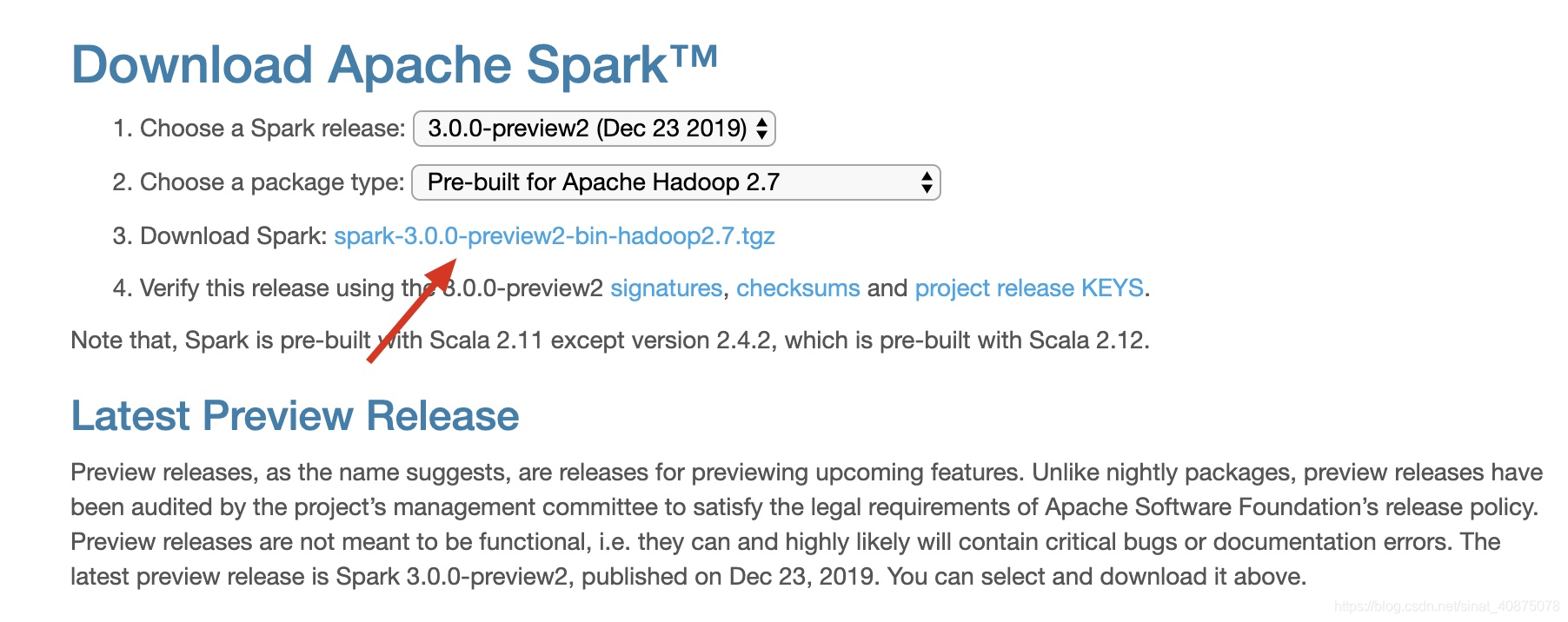

4、安装Spark

下载好之后,解压Spark包,配置环境变量:

vi ~/.bash_profile

在文件末尾添加:

export SPARJ_HOME=/Users/qianjiangang/spark-3.0.0-preview2-bin-hadoop2.7

47 export PATH=${PATH}:${SPARK_HOME}/bin

保存退出。

然后终端运行命令source ~/.bash_profile

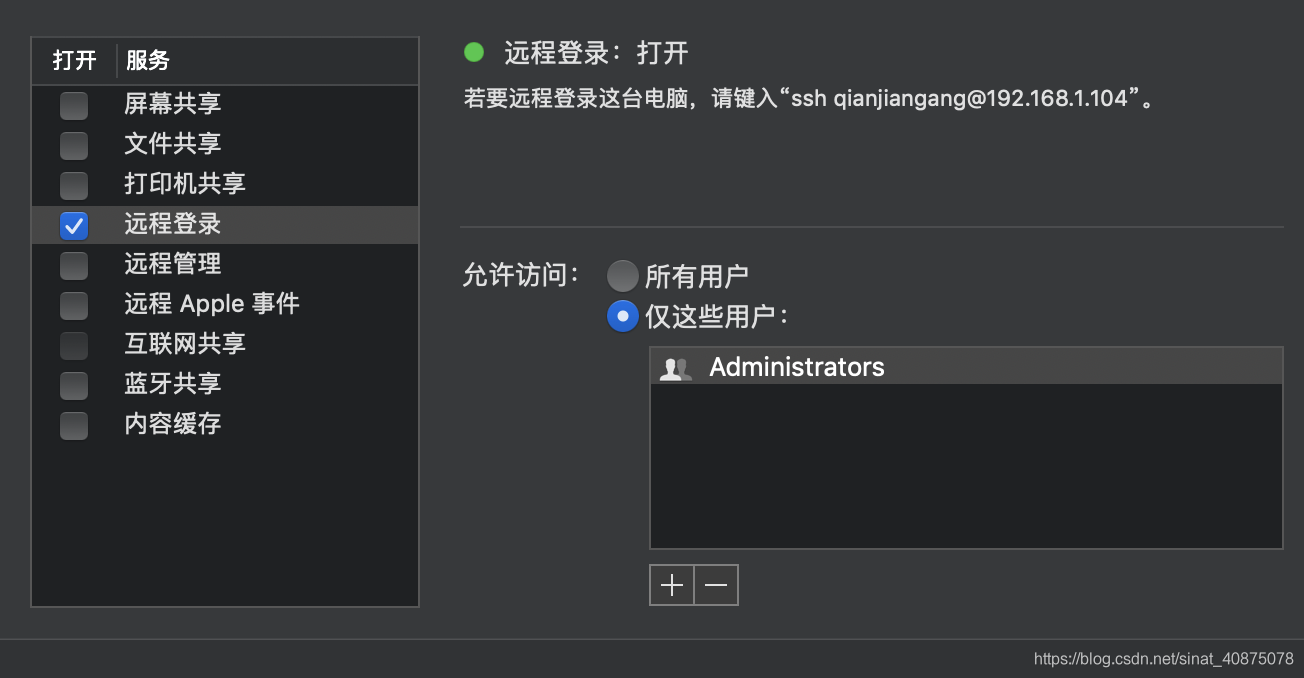

打开mac远程登录设置——>文件共享——>远程登录:

终端进入spark安装目录的bin目录下键入:./spark-shell

到此即安装成功。

启动spark:终端进入spark安装目录下sbin:执行./start-all.sh

jps查看有两个进程:

Master

Worker

访问spark页面:http://localhost:8080/

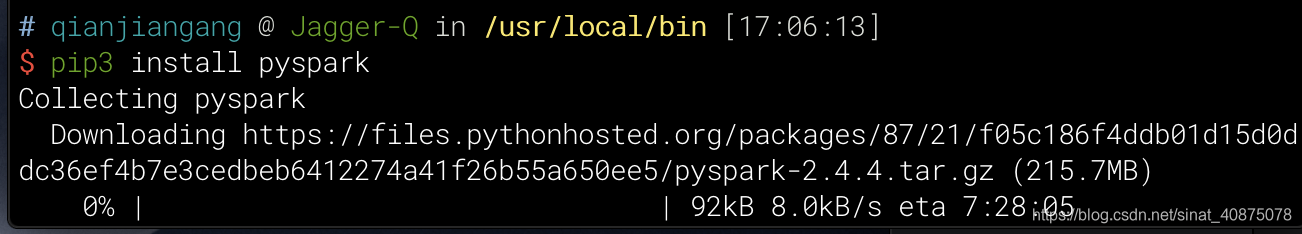

5、安装pyspark

完成以上安装之后,终端键入:pip3 install pyspark,下载比较慢,等待安装即可。