1.前言

神经网络可以用来模拟回归问题 (regression),例如给一组数据,用一条线来对数据进行拟合,并可以预测新输入 x 的输出值。

2.用Keras搭建线性回归神经网络

2.1.导入必要模块

import numpy as np

from keras.models import Sequential

from keras.layers import Dense

import matplotlib.pyplot as plt

2.2.创建数据

np.random.seed(42)

X = np.linspace(-1,1,200) #(200,)

np.random.shuffle(X)

Y = -0.5*X + 2.7 + np.random.normal(0,0.05,(200,)) #均值,标准差,输出的shape

plt.scatter(X, Y)

plt.show()

X_train, Y_train = X[:160],Y[:160] #训练数据0-159

X_test, Y_test = X[160:], Y[160:] #测试数据

2.3.搭建模型

然后用 Sequential 建立 model, 再用 model.add 添加神经层,添加的是 Dense 全连接神经层。参数有两个,一个是输入数据和输出数据的维度, x 和 y 是一维的。

如果需要添加下一个神经层的时候,不用再定义输入的纬度,因为它默认就把前一层的输出作为当前层的输入。在这个例子里,只需要一层就够了。

model = Sequential() #用来一层一层一层的去建立神经层

model.add(Dense(units=1, input_dim=1)) #Dense指这个神经层是全连接层

2.4.激活模型

接下来要激活神经网络,上一步只是定义模型。

参数中,误差函数用的是 mse 均方误差;优化器用的是 sgd 随机梯度下降法。

model.compile(loss='mse',optimizer='sgd') #激活模型

2.5.训练+测试

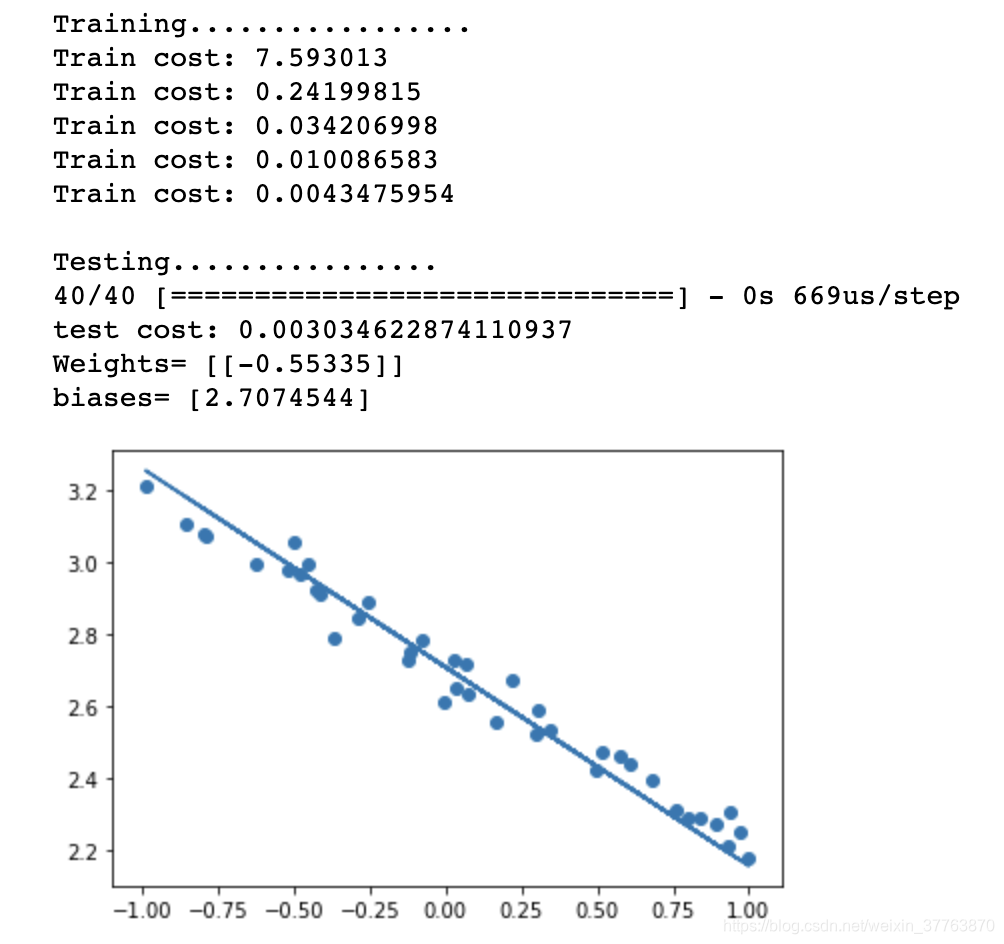

训练的时候用 model.train_on_batch 一批一批的训练 X_train, Y_train。默认的返回值是 cost,每100步输出一下结果。

测试用到的函数是 model.evaluate,输入测试集的x和y, 输出 cost,weights 和 biases。其中 weights 和 biases 是取在模型的第一层 model.layers[0] 学习到的参数。从学习到的结果你可以看到, weights 比较接近-0.5,bias 接近 2.7。

print('Training.................')

for step in range(500):

cost = model.train_on_batch(X_train, Y_train) #一批一批的训练

if step % 100 == 0:

print('Train cost:',cost)

print('\nTesting................')

cost = model.evaluate(X_test, Y_test, batch_size=40)

print('test cost:',cost)

W, b = model.layers[0].get_weights() #取模型的第一层的参数

print('Weights=',W,'\nbiases=',b)

Y_pred = model.predict(X_test)

plt.scatter(X_test, Y_test)

plt.plot(X_test, Y_pred)

plt.show()

扫描二维码关注公众号,回复:

10942918 查看本文章