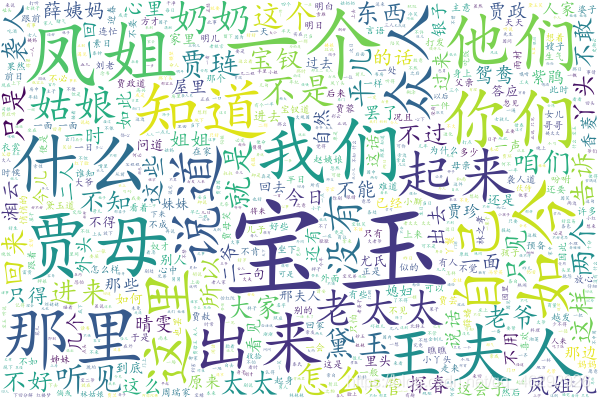

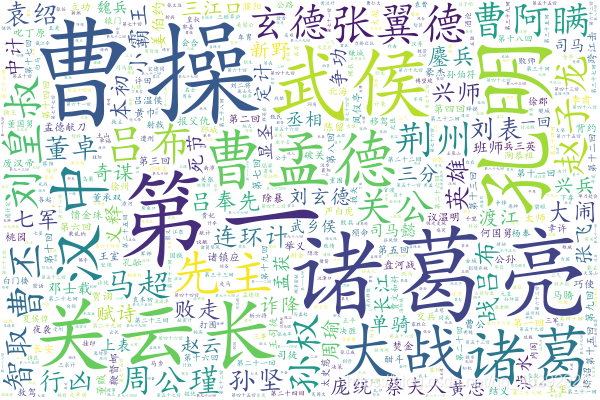

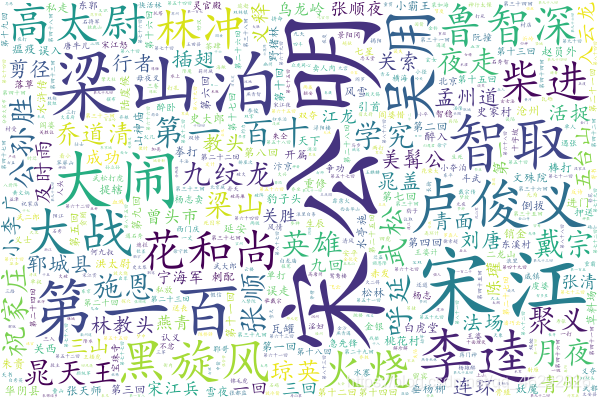

看了嵩天老师的《python编程新思维及实战》的课程后,看词云分析挺有意思的,自己也想试试词云分析,所以就爬取了聊斋志异,红楼梦,三国演义三部图书,存放为txt文件格式以供分析。本次的分析没有加入图片的形状,后续会加入图片的形状。

代码如下:

# 导入词云库

import wordcloud

# 导入jieba库,做分词使用

import jieba

# 需要分析的文本

txt = "聊斋志异.txt"

# 打开需要分析的文本,爬取的格式为gbk

f = open(txt, 'r', encoding="gbk")

# 读取文本内容

t = f.read()

# 读取后关闭

f.close()

# 精确模式,分词后返回一个列表

ls = jieba.lcut(t)

# 将空格与分词分隔开

txt1 = " ".join(ls)

# 调用词云

w = wordcloud.WordCloud(font_path="simkai.ttf", background_color="white",

width=600, height=400, max_font_size=120, max_words=3000)

# 生成词云

w.generate(txt1)

# 词云图片命名

w.to_file(txt.split('.')[0] + ".png")

分析结果如下: