学习周期:5.12-5.18

学习时长:未精确记录

学习内容:Chap1-Chap6

一句话心得:

- 本周学习的模型在统计学和数据挖掘课程中均接触过,但没有站在统计【学习】的角度去体会【寻找】模型的过程。

- 最大熵模型的最优解求解和迭代算法(IIS、牛顿法、拟牛顿法)证明有点炸裂。

- 实际建模过程中哪些可以靠程序函数实现,哪些需要人工定义和计算?比如一个CART,需要自己定义gini系数计算公式后进行特征选取?还是选择规则后程序直接计算出最优特征?

- 统计学(计量经济学)中一个回归能整出一堆概念,为什么机器学习过程不关注?

笔记

Chap1 统计学习方法

统计学习方法三要素:模型、策略、算法

学习模型的集合:基于训练集确定包含所有可能的模型的假设空间

学习的策略:确定模型选择的准则

学习的算法:实现求解最优模型的算法病态问题:指输出结果对输入数据非常敏感的问题,如果输入数据有微小误差,则引起问题解的相对误差很大,那么也就可以称这个问题为病态问题。

经验风险最小化ERM与结构风险最小化SRM:

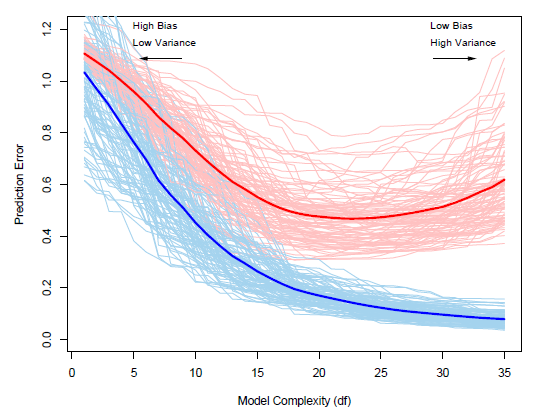

SRM通过在ERM中引入基于模型复杂度的正则化项来解决过拟合问题。

实际中模型复杂度用什么函数衡量?

生成模型与判别模型

生成方法由数据学习联合概率分布P(X,Y),然后求出条件概率分布P(X|Y)

判别方法由数据直接学习条件概率分布P(X|Y)

Chap2 感知机

- 感知机是一种线性分类模型,属于判别模型.

- 损失函数:误分类点到超平面的总距离

- 在例2.1中划分x1,x2与x3的超平面有无限多个,为什么根据迭代方法只找到两个?

感知机学习算法存在多解,这些解依赖于初值的选择、迭代过程中误分类点的选择顺序、迭代步长。是否与损失函数和函数优化的方法也有关? - 代码实现

Chap3 k近邻法

- 三要素:k值的选择、距离度量、分类决策规则

- k近邻法没有显示的学习过程。

- 在应用中,k值一般取一个较小的数值,采用交叉验证法来选取最优的k值。

- kd树

- 例3.2中采用中位数作为切分点,x1的中位数应该是(5+7)/2=6?

- 平衡kd树搜索时的效率未必是最优的,那依据什么来决定构造什么样的kd树?

- kd树搜索的平均计算复杂度是O(logN)。温习了一下大O表示法的原理,表示函数的渐进行为,无穷级数的极限,N理解为样本数,得到计算次数的级数f(N)后对N求极限,即为算法复杂度

Chap4 朴素贝叶斯法

- 朴素贝叶斯法属于生成模型。

- 朴素贝叶斯法对条件概率作了条件独立性的强假设。

- 朴素贝叶斯法的极大似然估计在样本量较少的情况下可能会出现所要估计的概率值为0的情况,引入拉普拉斯平滑(Laplace smoothing)

Chap5 决策树

- 决策树学习算法包含:特征选择、决策树生成、决策树剪枝

- 特征选择:

- ID3:信息增益g(D, A),选最大的特征

- C4.5:信息增益比gR(D,A),选最大的特征

- CART:基尼系数Gini(D),选最小的特征

- 决策树剪枝:构造决策树整体的损失函数,对每个叶节点进行计算和迭代,模型复杂度的表示方法可以是叶节点个数

- 实际应用中,要做到哪一步?信息增益需要自己写函数进行计算?是否有现成的函数调用?

Chap6 逻辑斯蒂回归与最大熵模型

- logistic regression和maximum entropy model都是对数线性模型

- sigmod curve

- 统计学课程中引入了logit变化的概念,令logit(pi)=ln(pi/1-pi),在本书中指事件的几率(odds),即将问题从寻找关于pi的logistic回归方程转变为寻找关于logit(pi)的线性回归方程。然后再做logit的逆变换,找到对应的logistic回归方程,相比此书更易于理解。

- 在回归问题中,统计学定义残差的概念(随机误差),以及基于此产生了:总平方和、解释平方和、残差平方和、R-square。为了保证最小二乘参数估计的无偏性和有效性还对残差进行了假设,如同方差性、零条件均值等。这些概念统计学习中是否完全不用考虑?为什么?因为基于独立同分布的前提?

- 最大熵模型

- 推导过程不太明白

- 特征函数定义:x与y满足某一事实?

- (6.21)求导时为什么第三项没了?都看成独立的?

- (6.22)w0哪儿去了?

- 凸优化的学习

- 拉格朗日对偶性中为什么要设定c(x)<=0,h(x)=0 这两类约束条件

- 模型的最优化算法:IIS、牛顿法、拟牛顿法,实际使用时如何计算对于的矩阵取值?

- 推导过程不太明白

问题

- 实际建模中模型的哪些部分需要人工定义和计算?具体到哪一层?

- 模型如何进行选择?

补充

- 空间任一点到超平面的距离公式的推导过程: