集群的搭建

第一步:准备工作

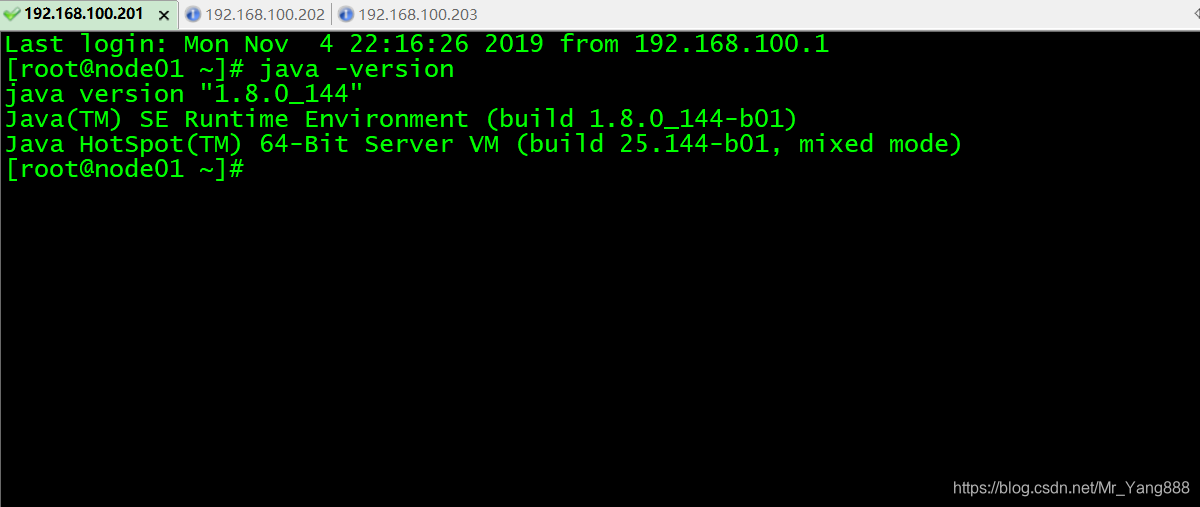

1.安装jdk

jdk的安装和环境变量配置的教程

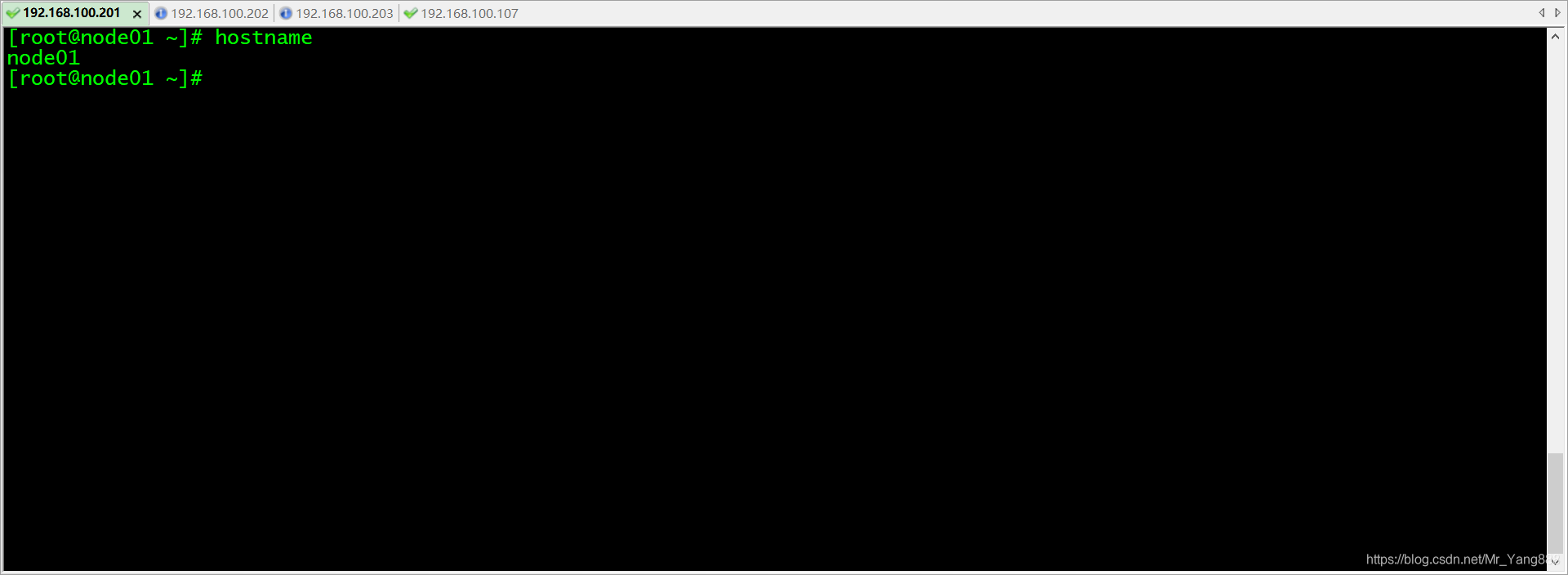

2.配置主机名

这里楼主的主机名是node01

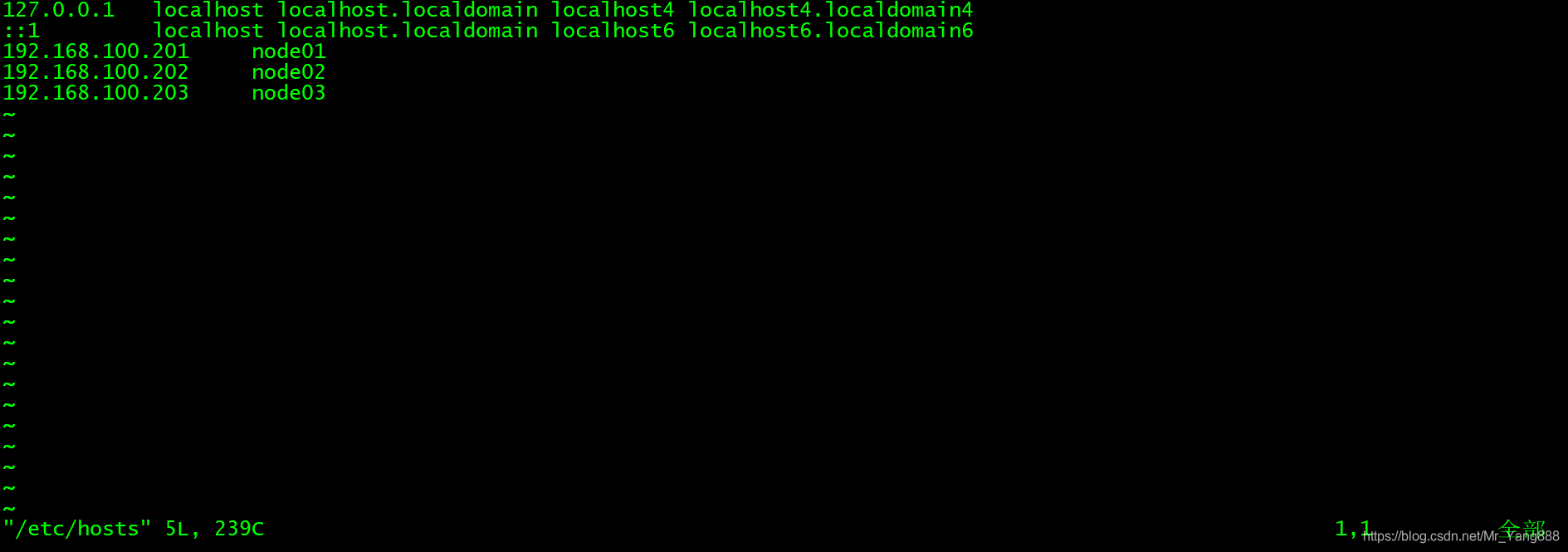

3.配置ip与对应关系

4.设置节点之间的免密登陆

第二步:上传压缩包并解压

将我们重新编译之后支持snappy压缩的Hadoop包上传到第一台服务器并解压

第一台机器执行以下命令

cd /export/softwares/

mv hadoop-2.6.0-cdh5.14.0-自己编译后的版本.tar.gz hadoop-2.6.0-cdh5.14.0.tar.gz

tar -zxvf hadoop-2.6.0-cdh5.14.0.tar.gz -C …/servers/

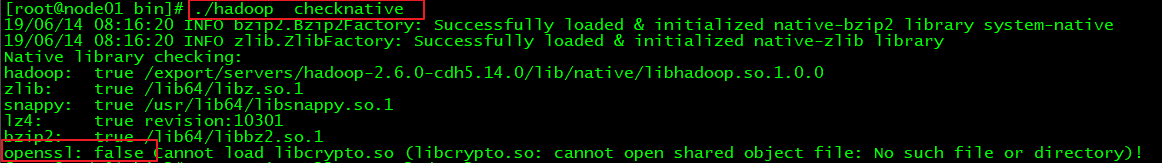

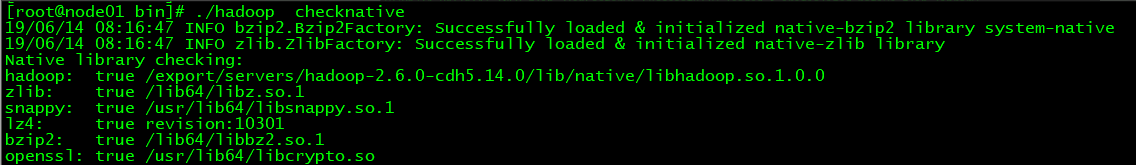

第三步:查看Hadoop支持的压缩方式以及本地库

cd /export/servers/hadoop-2.6.0-cdh5.14.0/bin

./hadoop checknative

如果出现openssl为false,那么所有机器在线安装openssl即可,执行以下命令,虚拟机联网之后就可以在线进行安装了

yum -y install openssl-devel

第四步:修改配置文件

修改core-site.xml

第一台机器执行以下命令

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

vim core-site.xml

<!-- 开启hdfs的垃圾桶机制,删除掉的数据可以从垃圾桶中回收,单位分钟 -->

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

修改hdfs-site.xml

第一台机器执行以下命令

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

vim hdfs-site.xml

修改mapred-site.xml

第一台机器执行以下命令

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

vim mapred-site.xml

mapreduce.framework.name

yarn

<property>

<name>mapreduce.job.ubertask.enable</name>

<value>true</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>node01:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node01:19888</value>

</property>

修改yarn-site.xml

第一台机器执行以下命令

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

vim yarn-site.xml

修改slaves文件

第一台机器执行以下命令

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

vim slaves

node01

node02

node03

第五步:创建文件存放目录

第一台机器执行以下命令

node01机器上面创建以下目录

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/tempDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/namenodeDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/datanodeDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/edits

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/snn/name

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/snn/edits

第六步:安装包的分发

第一台机器执行以下命令

cd /export/servers/

scp -r hadoop-2.6.0-cdh5.14.0/ node02:$PWD

scp -r hadoop-2.6.0-cdh5.14.0/ node03:$PWD

第七步:hadoop的环境变量

编辑配置文件

vim /etc/profile.d/hadoop.sh

export HADOOP_HOME=/export/servers/hadoop-2.6.0-cdh5.14.0

export PATH=:

HADOOP_HOME/sbin:$PATH

更新资源后生效

source /etc/profile

第八步:集群启动

要启动 Hadoop 集群,需要启动 HDFS 和 YARN 两个集群。

注意:首次启动HDFS时,必须对其进行格式化操作。本质上是一些清理和准备工作,因为此时的 HDFS 在物理上还是不存在的。

hadoop namenode –format

然后启动集群

脚本一键启动所有

sbin/start-all.sh

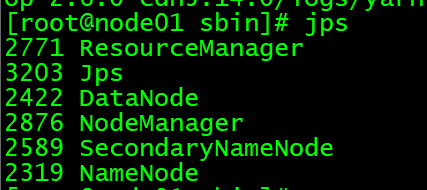

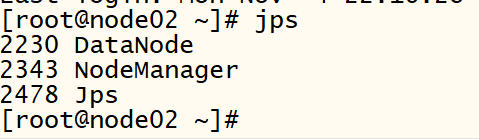

如果集群配置成功 使用jps测试

主节点

从节点

如果想关闭集群

sbin/stop-all.sh

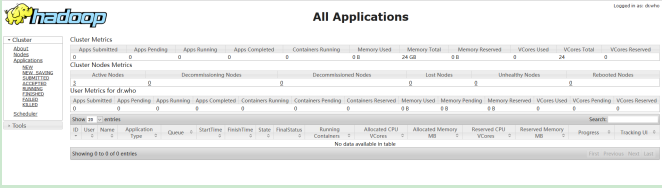

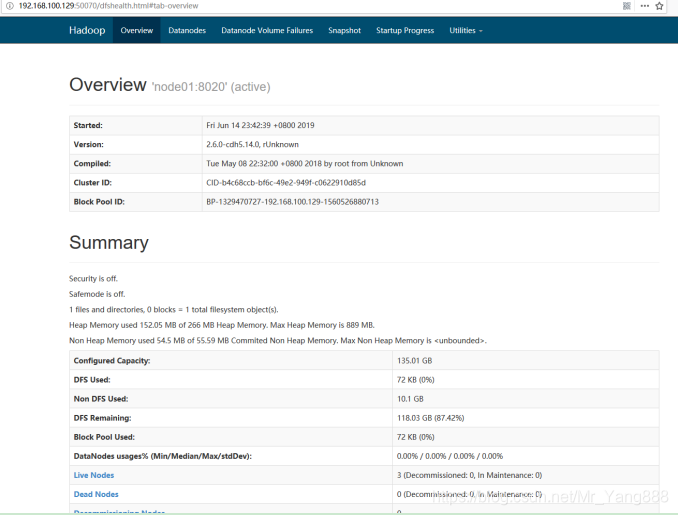

第九步:浏览器查看启动页面

hdfs集群访问地址: http://192.168.52.100:50070/dfshealth.html#tab-overview

yarn集群访问地址: