一.目的:

1.搭建hadoop集群,集群中有3台机器,让它们在一个环回网络中,分别是:

192.168.1.2 master

192.168.1.3 slave1

192.168.1.4 slave2

2.其中master是主机,slave1和slave2是活动节点,实现免密码互通。

3.在master中安装eclipse,在eclips中配置hadoop。

二.搭建步骤:

1.安装VM,这个网上有许多教程,就不在这里浪费时间了。

2.下载centos7的镜像,在官网上下载就行了。

3.安装centos7,注意在选择SOFTWARE(软件)时选择带图形化界面的推荐选择KDE版本。

4.在下图中只用设置管理员密码就行,当然如果你想设置普通用户就点USER就行,但是没有root权限,在安装hadoop时会很难受。

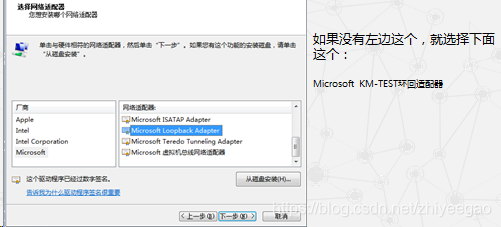

5.设置本机网络环回,这个环回适配器相当于一个虚拟的交换机,我们的master、slave1、slave2相当于连在这个虚拟交换机上的电脑。(注意:搭了环回后上不了网,需要在每个虚拟机中再添加一个网卡。)

上图配置完成后再网络适配器中可以看到多了一个本地连接,这个本地连接就是我们刚刚配置的环回适配器

修改这个新的本地连接的IPv4

5.在VM中的选项卡中选择“编辑”,选择“虚拟网络编辑器”,设置VM中的网络。

按照上图配置就行。

同时,我们还要修改的master、slave1、slave2的网络配置,都按照下图设置即可。

6.给master、slave1、slave2配置IP地址

在屏幕上右键,选择konsole进入命令行模式(KDE图形化界面)

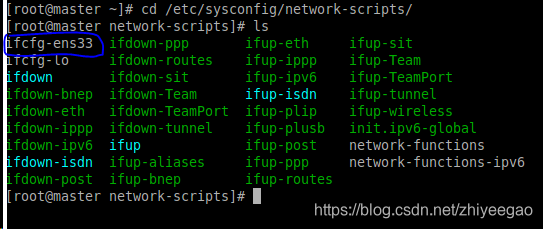

键入cd /etc/sysconfig/network-scripts/

键入ls,可以看到如下:

其中ifcfg-ens33就是修改IP的地方

键入vim ifcfg-ens33

上图圈起来的地方就是需要修改的地方。(注意:master中IPADDR=192.168.1.2,slave1中IPADDR=192.168.1.3,slave2中IPADDR=192.168.1.4,其他修改的地方都一样。)

修改完了后必须键入service network restart

![]()

显示OK则修改成功。

7.配置master、slave1、slave2的主机名,在这3个虚拟机中分别配置

master中键入hostnamectl set-hostname master

slave1中键入hostnamectl set-hostname slave1

slave2中键入hostnamectl set-hostname slave2

上述设置完后,分别配置hosts列表,注意都要配置。

键入vim /etc/hosts

8.配置免秘钥登录,注意,3个虚拟机都要配置

关闭防火墙systemctl stop firewalld

让防火墙不要开机自启systemctl disable firewalld

在3台机器中都键入ssh-keygen -t rsa

出现下图代表秘钥生成成功

键入cd .ssh

键入ls

可以看到.ssh文件夹下有两个文件,id_rsa与id_rsa.pub,分别是私有与公有秘钥,我们要把公有秘钥复制到一个authorized_keys文件内,这个文件的作用就是完成无密码访问。

在master键入cp id_rsa.pub authorized_keys和chmod 600 authorized_keys

在slave1键入scp -p id_rsa.pub root@master:/root/.ssh/authorized_keys_1

在slave2键入scp -p id_rsa.pub root@master:/root/.ssh/authorized_keys_2

在master中将authorized_keys_1和authorized_keys_1的手动内容复制粘贴到authorized_keys中

在master中键入scp -p id_rsa.pub root@slave1:/root/.ssh/authorized_keys

在master中键入scp -p id_rsa.pub root@slave2:/root/.ssh/authorized_keys

全部配置完了后按下图操作没问题就代表配置成功

9.安装Xshell6和Xftp6,这个网上有很多资源,这两个软件可以更加方便地操作虚拟机。

具体安装就不细说了,通过xftp将jdk1.8.0压缩包和hadoop2.5.2压缩包hadoop-eclipse-plugin-2.5.2.jar上传到虚拟机中。

直接解压缩就行,因为十分简单,并且可以参考的文章很多,我就不详细说了。

10.配置hadoop集群

配置slaves文件

11.jdk和hadoop的配置

键入vim .bash_profile

将JAVA_HOME和HADOOP_HAME和PATH按上图配置好。然后键入source .bash_profile保存配置即可。

12.hadoop启动

格式化文件系统,键入hdfs namenode –format

(记得3个集群都要打开)

按上图所示成功出现网页代表成功。

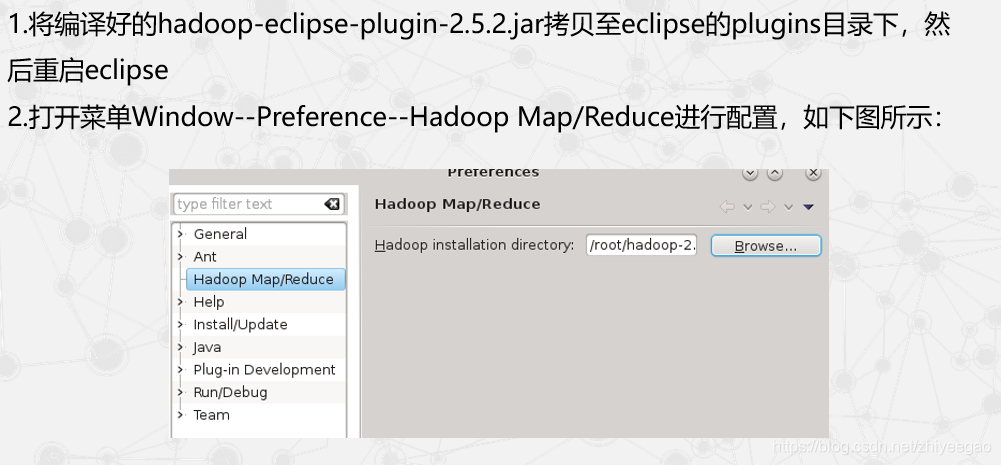

13.安装eclips和hadoop2.5.2-eclipse-plugin

14.在eclipse上进行配置

然后就完成了。