备注:所需镜像都会去外网拉取,所以镜像需要自己想办法!!!

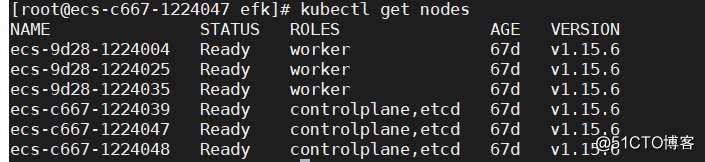

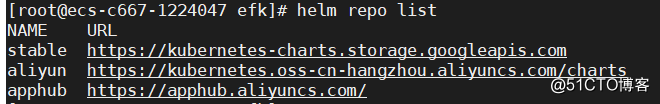

1、安装

helm pull stable/elasticsearch

tar xvf elasticsearch-1.32.4.tgz #可以根据自己需求修改elasticsearch/values.yaml文件

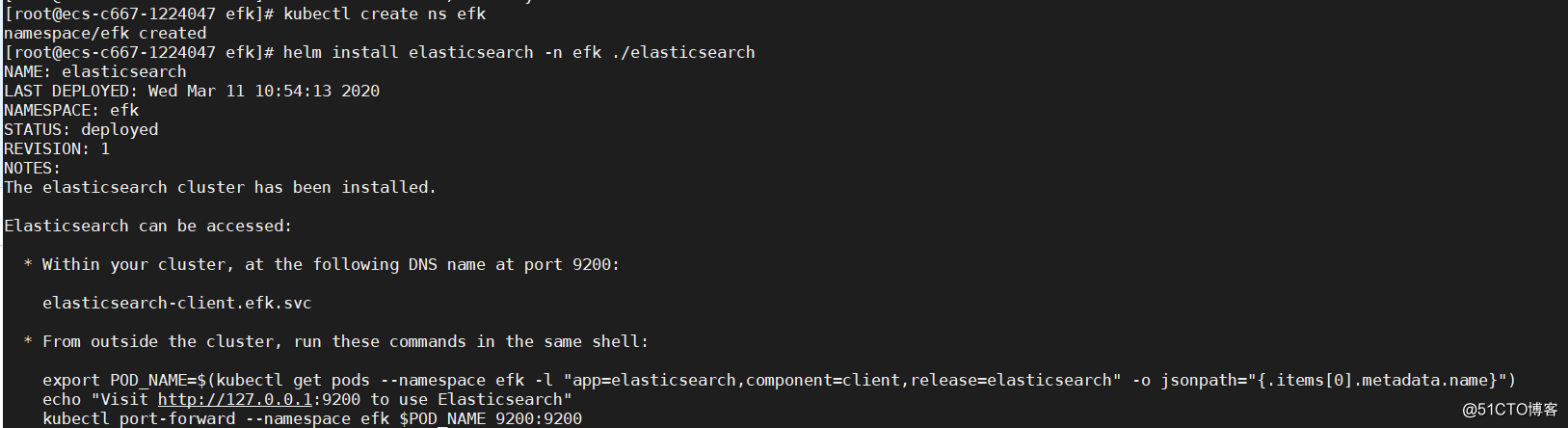

helm install elasticsearch -n efk ./elasticsearch

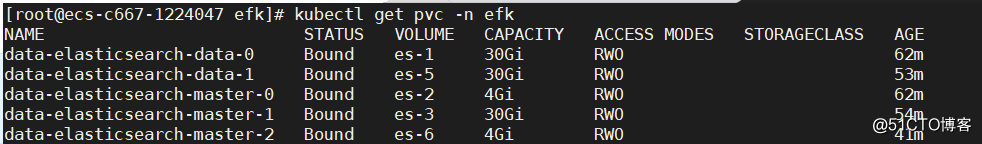

创建pv

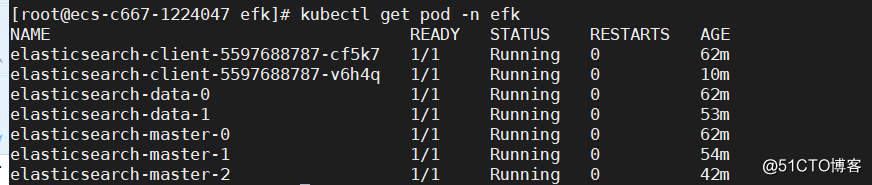

查看pod状态

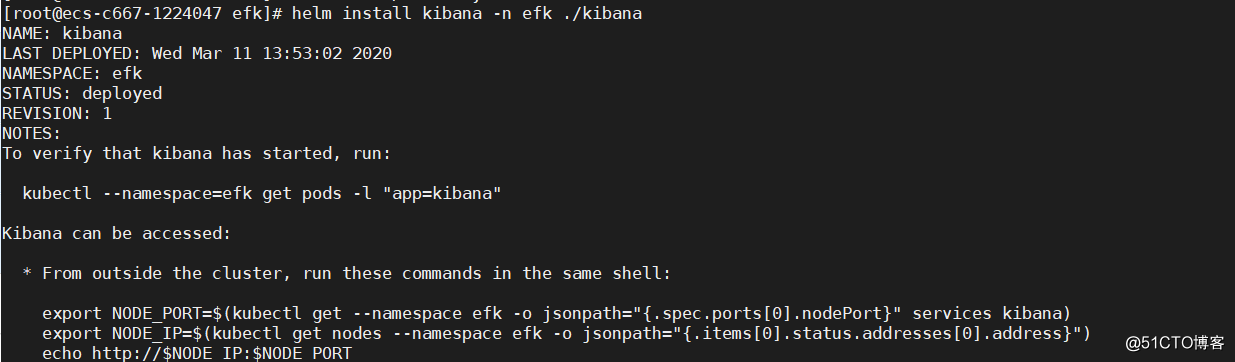

2、安装kibana

helm pull stable/kibana

tar xvf kibana-3.2.6.tgz

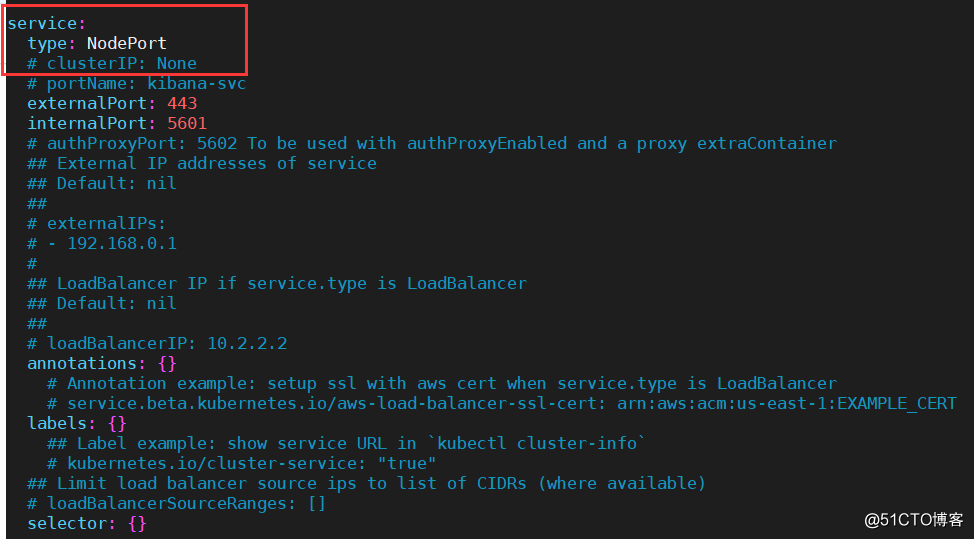

vim kibana/values.yaml #修改类型为NodePort

安装

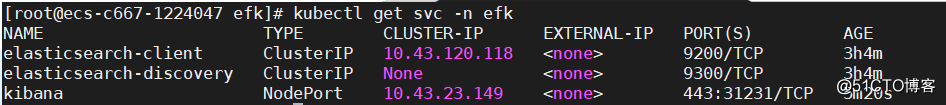

关联es

通过svc可以看到es的service名称为elasticsearch-client

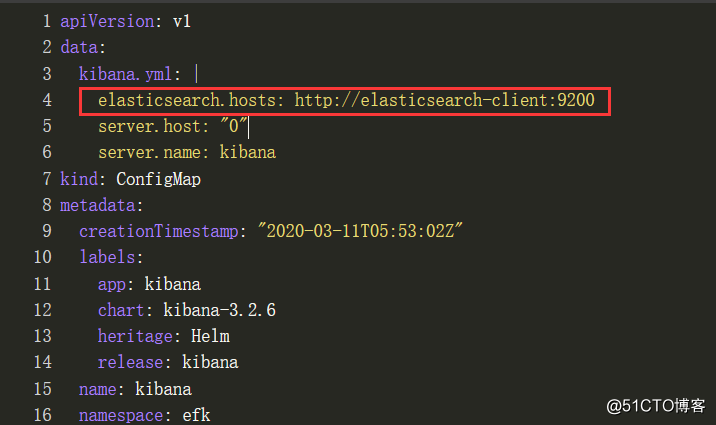

修改kibana的ConfigMap文件

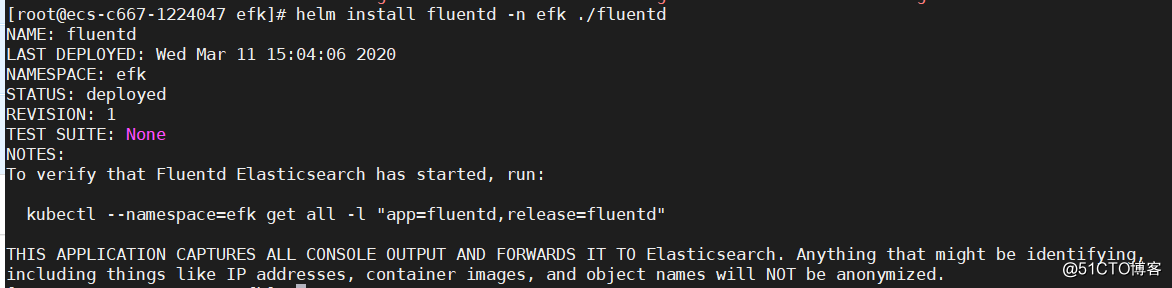

3、安装fluentd

helm pull stable/fluentd

tar xvf fluentd-2.4.0.tgz

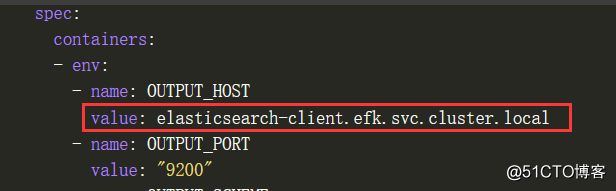

修改输出的es地址

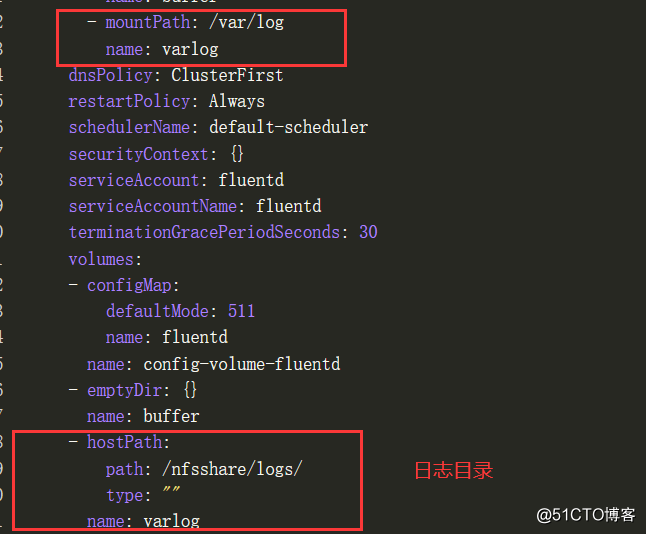

挂载日志目录

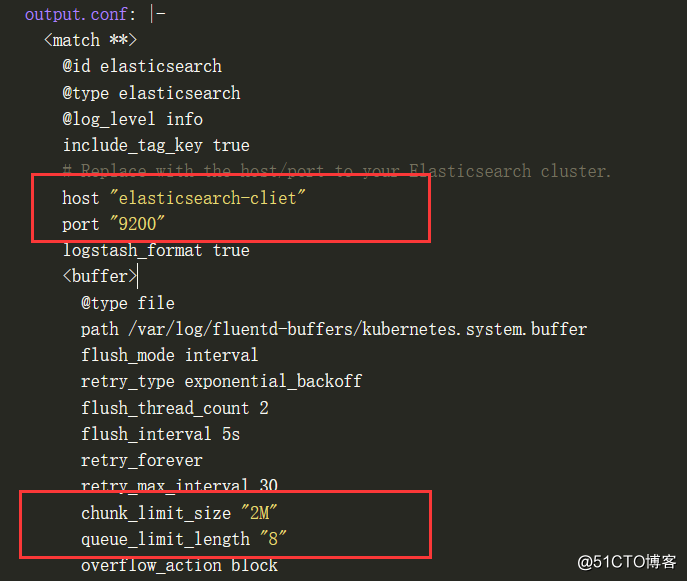

修改fluetd的configmap文件

添加以下

containers.input.conf: |- <source> @id fluentd-containers.log @type tail path /var/log/*/*.log #fluentd容器中所挂载的日志目录 pos_file /var/log/es-containers.log.pos tag raw.kubernetes.* read_from_head true <parse> @type multi_format <pattern> format json time_key time time_format %Y-%m-%dT%H:%M:%S.%NZ </pattern> <pattern> format /^(?<time>.+) (?<stream>stdout|stderr) [^ ]* (?<log>.*)$/ time_format %Y-%m-%dT%H:%M:%S.%N%:z </pattern> </parse> </source> # Detect exceptions in the log output and forward them as one log entry. <match raw.kubernetes.**> @id raw.kubernetes @type detect_exceptions remove_tag_prefix raw message log stream stream multiline_flush_interval 5 max_bytes 500000 max_lines 1000 </match>

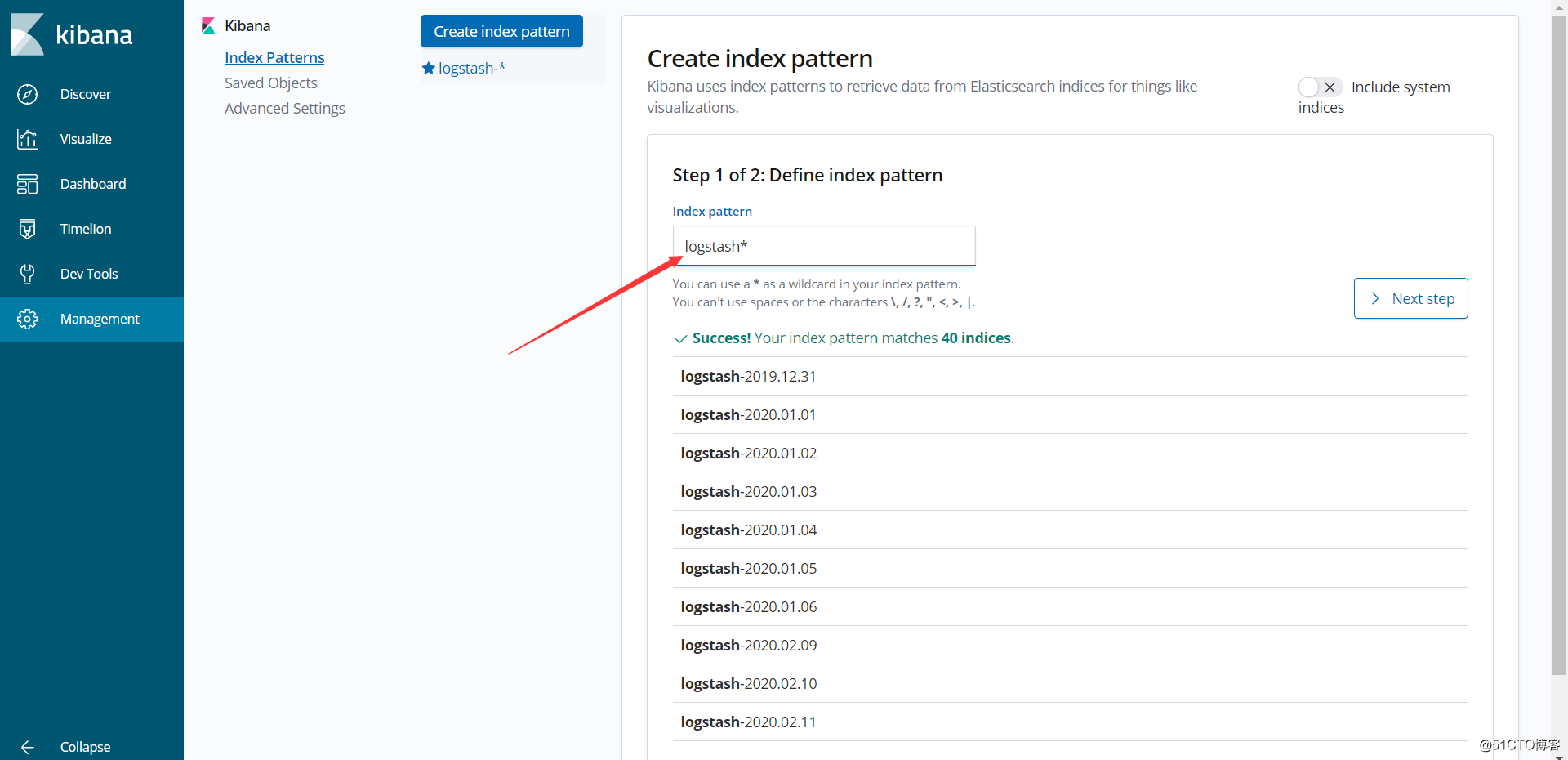

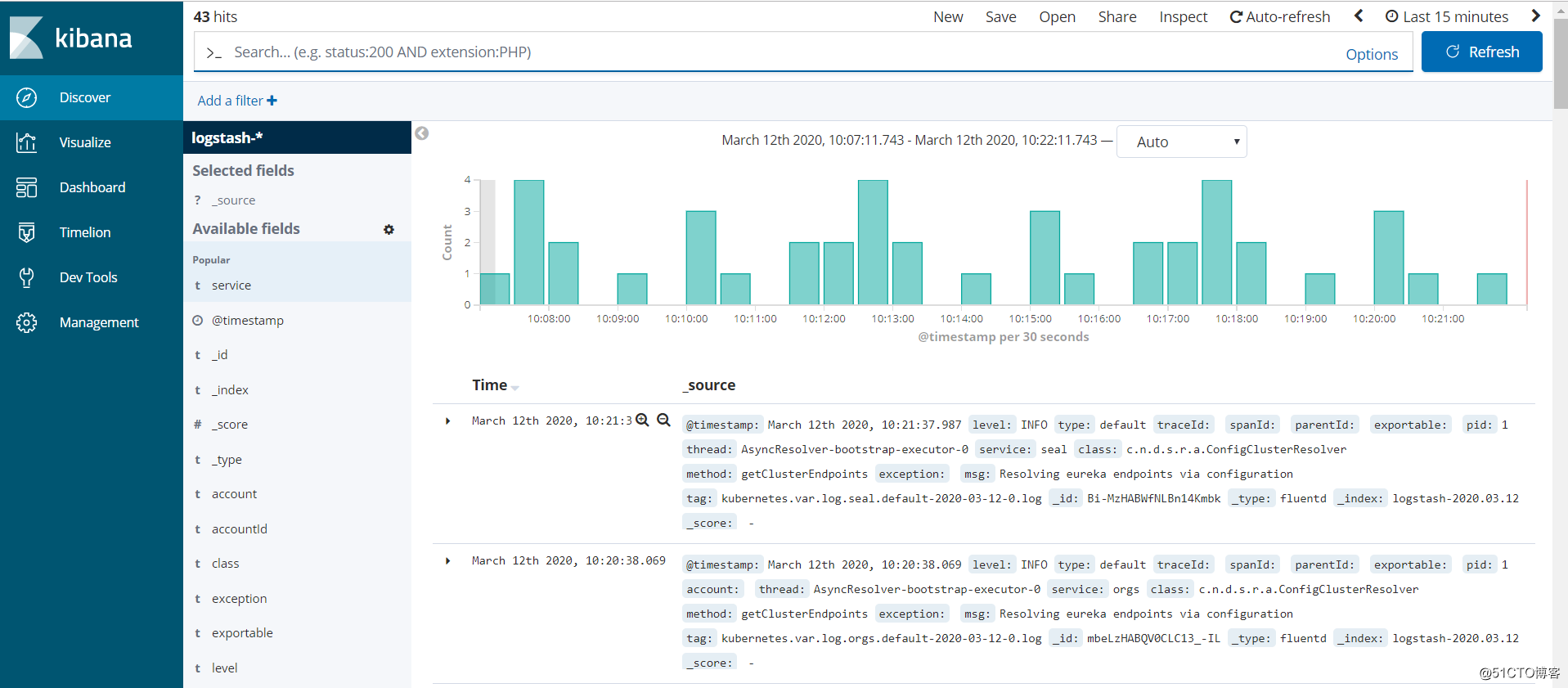

4、访问kibana